订阅专栏只能获取专栏内一份代码。

[火]使用了 TCN(Temporal Convolutional Network)、CNN 和自注意力机制,以捕捉时间相关性和特征信息。

提供了训练、评估和预测功能,轻松处理您的数据。

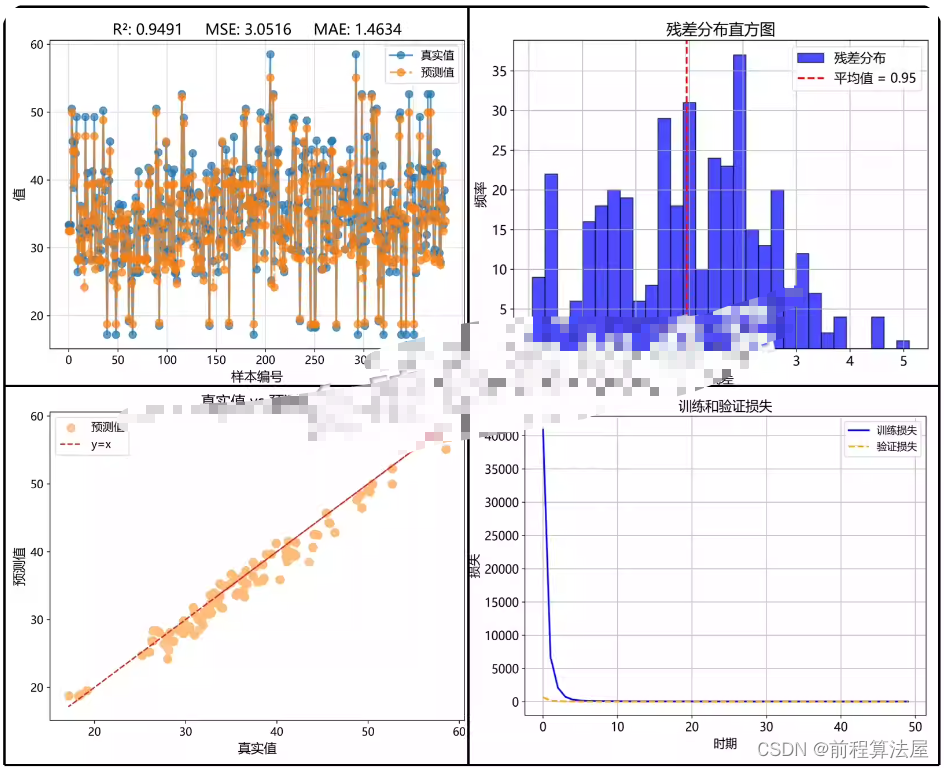

[五角星]可视化工具:生成比较图、散点图、残差图以及损失/MAE历史记录图,帮助您了解模型性能。

[五角星]适用场景:

预测时间序列数据回归问题,深入理解深度学习回归模型的实现。

完整的源代码,包括模型构建、训练和评估的示例。使用说明和注释,帮助您快速上手和自定义模型。

可视化工具,使您能够直观地评估模型性能。

[五角星]模型结构:

TCN层: 用于捕捉时间序列数据中的时间相关性,具有128个滤波器

卷积层: 进一步提取特征,具有128个滤波器和卷积核大小为3

最大池化层: 降低特征维度,减少模型复杂性

自注意力层: 捕捉序列数据中的重要关系,使用Sigmoid激活函数

Flatten层: 将输出展平,以连接到后续的全连接层

全连接层: 包含64个神经元,使用ReLU激活函数

输出层: 包含一个神经元,用于回归任务,使用线性激活函数

1224

1224

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?