flux 刚出来的时候画个图是真的慢,经过社区一轮一轮的优化,现在 4090 不使用加速 Lora 的情况下,生成 30 步 1024 * 1024 的图片只需要 16 秒。

这两天社区又来给 flux 加速了,这个技术就是 TeaCache,一种免训练的缓存方法,可估计和利用跨时间步的模型输出之间的波动差异,从而加速推理。在不损失图像质量的前提下,可以在原来的基础上实现 1.4 到 2 倍的加速。

试了下无损的参数配置基本只需要 10 秒就可以出图,如果可以接受损失一些质量,可以缩短到 8 秒出图。并且可以和 Lora 以及 ControlNet 一起使用。

好了,话不多说,我们直接开整!

上边的对于 TeaCache 的介绍,小伙伴们可能不是很理解,我们还是通俗一点再来简单介绍一下:

TeaCache 就好比一个聪明的“记事本”,它能够观察并记录下模型在不同时间点输出结果之间的变化情况。通过分析这些变化,TeaCache 可以预测出在某些时间点上,模型的输出结果可能与之前的结果非常相似,因此就可以直接使用之前的结果,而不需要再次进行复杂的计算。这样一来,模型在进行推理时就可以节省大量的计算资源和时间,从而提高整体的运行效率。

大致的原理就是这样,和编程里的缓存很像,可以帮我们加速获取结果。

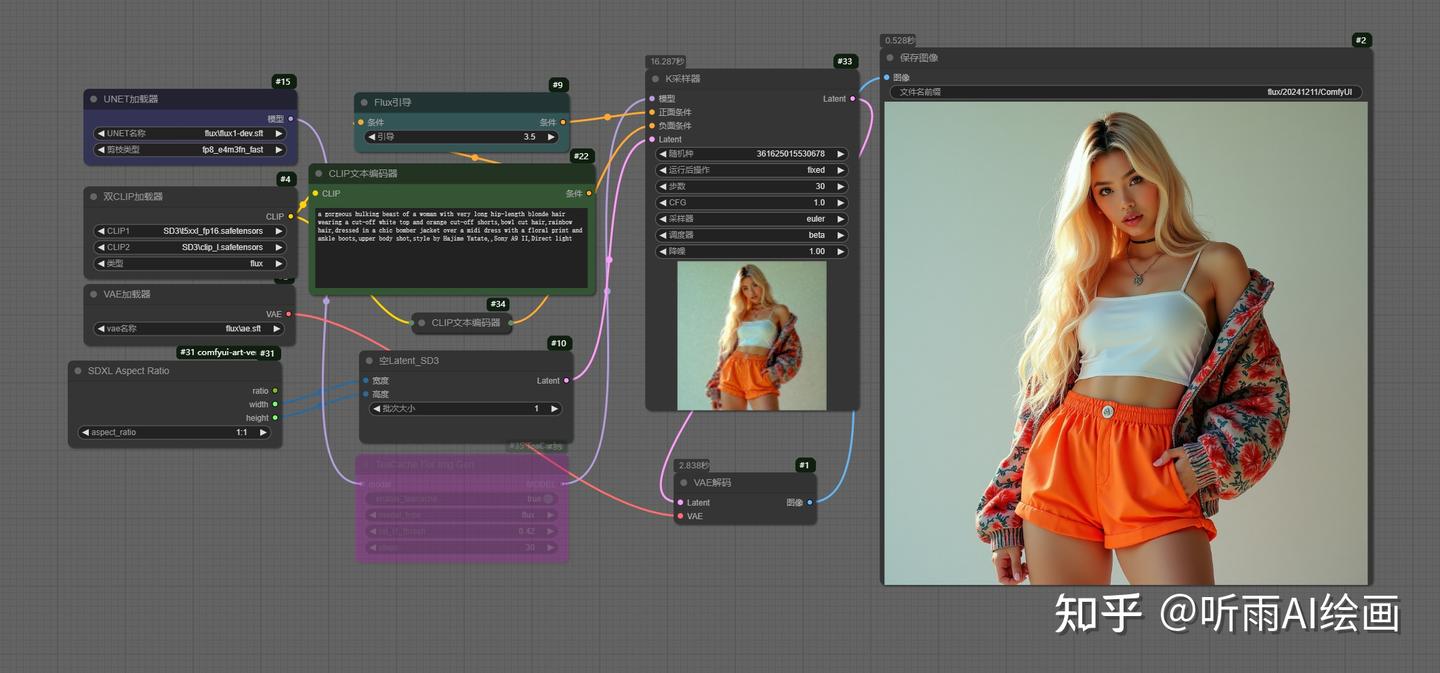

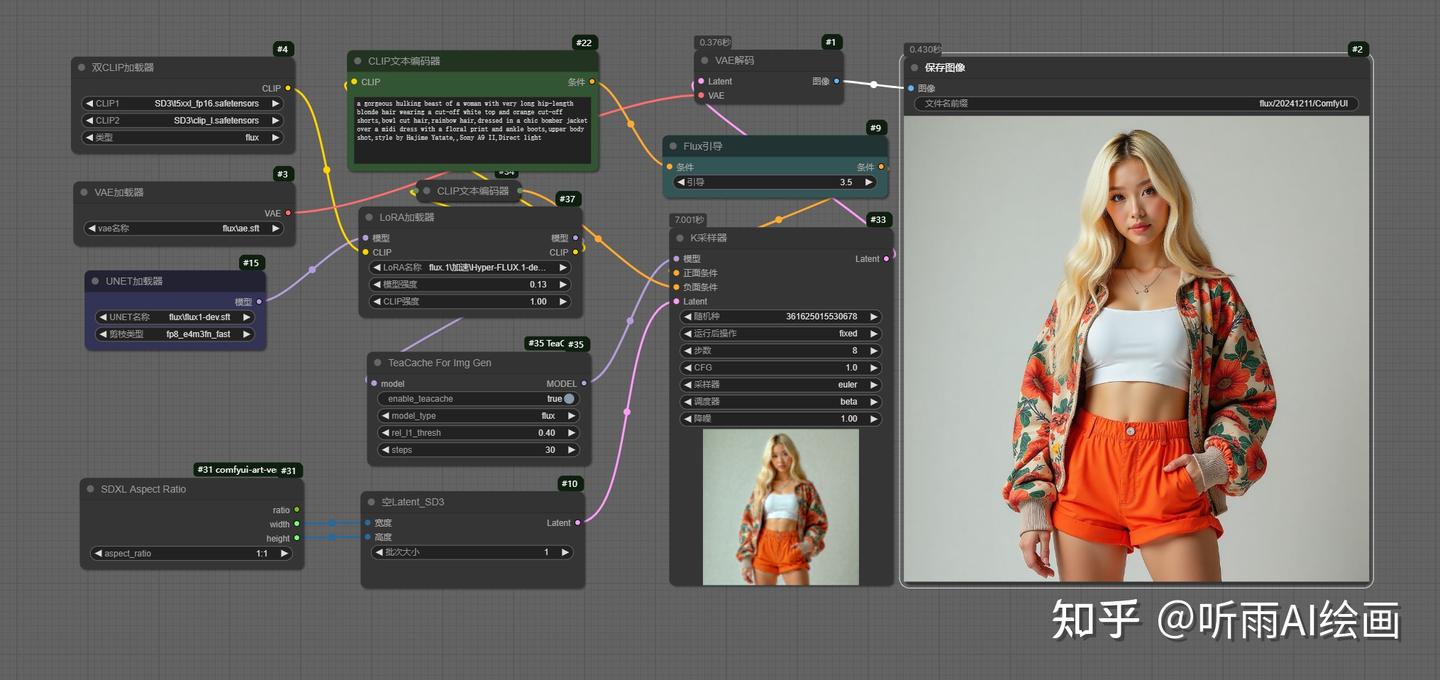

我们来看下具体的效果,这个是基础的 flux 工作流, 30 步 1024 * 1024 分辨率,可以看到采样器上耗时是 16 秒。

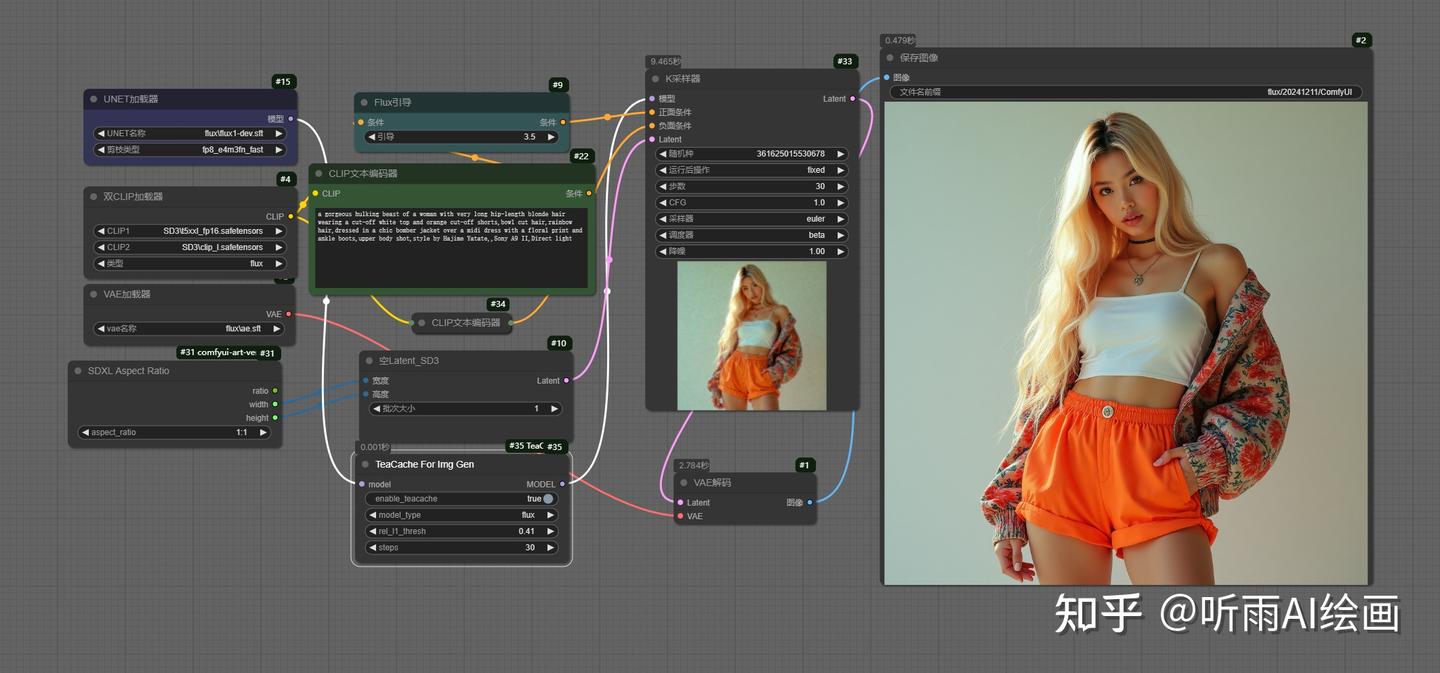

接下来我们加上 TeaCache 节点,可以看到生成的两张图完全一样,但是采样时间只需要 9 秒,差不多提速了一倍。

两张图片可以对比下,基本没有任何区别。

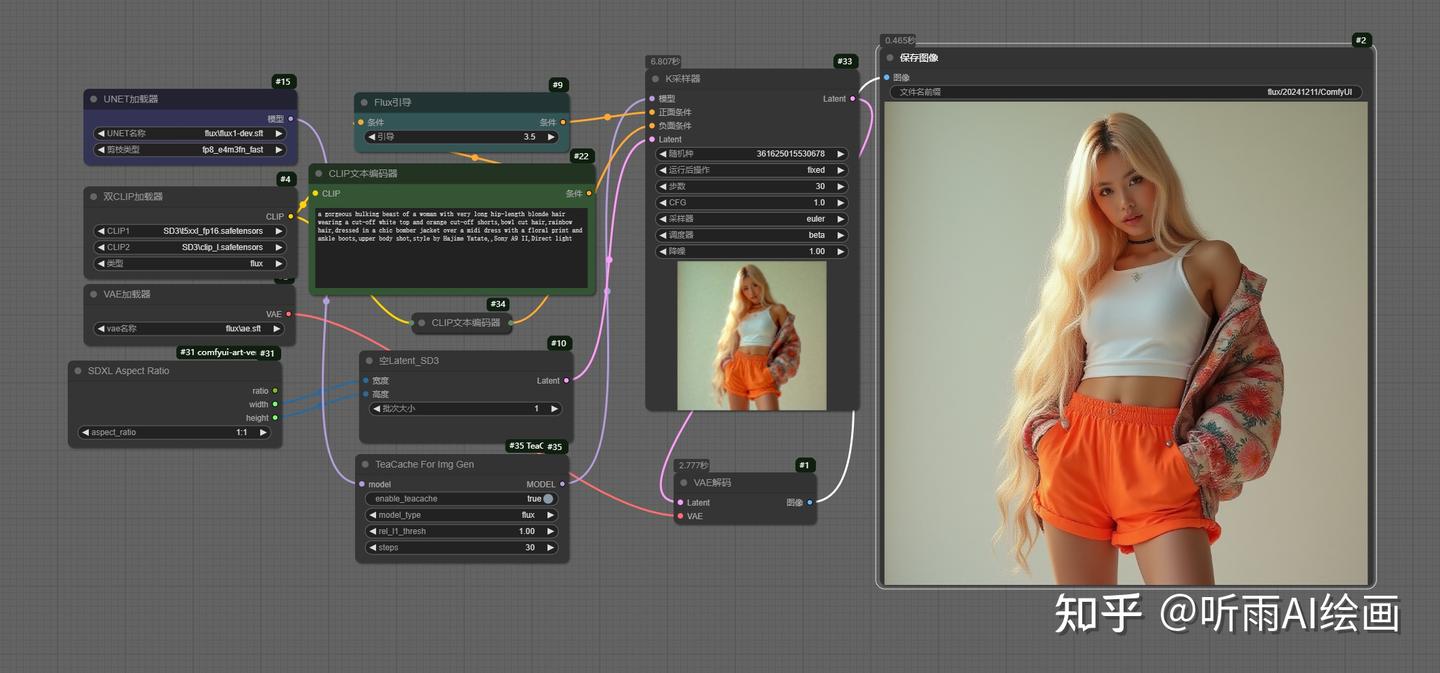

如果我们调大 TeaCache,这里把 TeaCache 节点中的「rel_l1_thresh」设置为 1,上边设置的是 0.4,出图速度可以达到惊人的 6 秒。

但是相应的也会丢失一些质量,左边的图可以看到是损失了一些精度的,看起来有些模糊,所以无损的话,我们设置 0.4 左右就可以了。

插件的安装也很简单,直接在 ComfyUI 管理器中搜索:ComfyUI-TeaCache,进行安装就可以了。

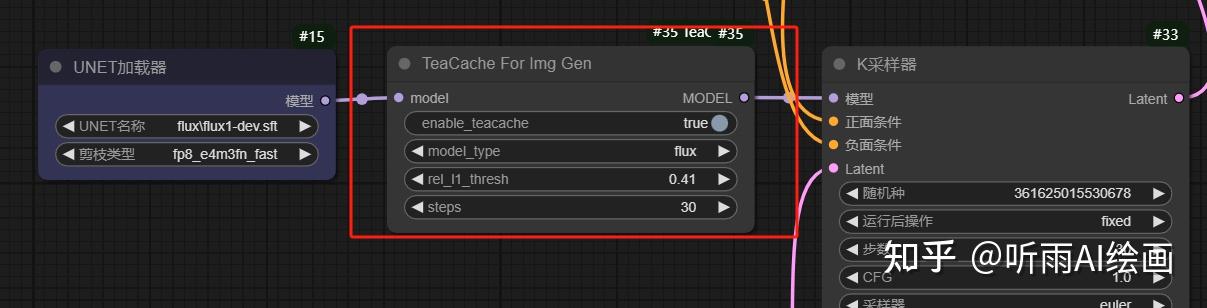

使用上也很简单,只需要链接在模型加载节点和采样器节点之间就可以了。

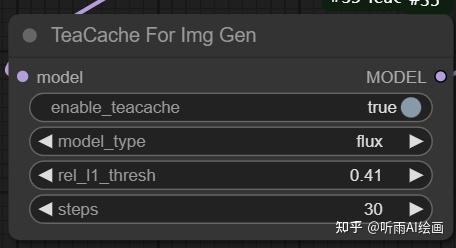

节点就一个,我们简单来讲下这些参数:

enable_teacache:是否开启缓存,关闭就相当于没有这个节点。

model_type:现在只有 flux,后续作者会支持混元以及 LTX-Video 视频模型。

rel_l1_thresh:这个参数值越大,生图速度越快,图片质量会下降,不同的模式和步数,rel_l1_thresh 的最优值都会有细微变化,可以在 0.4 左右调整。

steps:这个和采样节点里的步数保持一致即可。

基础的工作流讲完了,我们开头说它是支持 Lora 的,那我们还可以再加上字节的 8 步加速 Lora 模型,速度还可以继续提升,可以提升到 7 秒内,这速度相比于 flux 刚出来的时候,不知道快了多少倍了。

开源社区就是牛逼。

ControlNet 也是一样的操作,并且听雨也试过了,flux 的量化模型以及微调模型都是可以使用这个节点加速的哦!

而且 TeaCache 不仅可以加速 flux 这类生图大模型,还可以加速混元之类的视频大模型,雨露均沾,一起进入加速时代!

好了,今天的分享就到这里了,感兴趣的小伙伴快去试试吧!

AIGC技术的未来发展前景广阔,随着人工智能技术的不断发展,AIGC技术也将不断提高。未来,AIGC技术将在游戏和计算领域得到更广泛的应用,使游戏和计算系统具有更高效、更智能、更灵活的特性。同时,AIGC技术也将与人工智能技术紧密结合,在更多的领域得到广泛应用,对程序员来说影响至关重要。未来,AIGC技术将继续得到提高,同时也将与人工智能技术紧密结合,在更多的领域得到广泛应用。

这份完整版的AI绘画(SD、comfyui、AI视频)整合包已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

一、AIGC所有方向的学习路线

AIGC所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照下面的知识点去找对应的学习资源,保证自己学得较为全面。

二、AIGC必备工具

工具都帮大家整理好了,安装就可直接上手!

三、最新AIGC学习笔记

当我学到一定基础,有自己的理解能力的时候,会去阅读一些前辈整理的书籍或者手写的笔记资料,这些笔记详细记载了他们对一些技术点的理解,这些理解是比较独到,可以学到不一样的思路。

四、AIGC视频教程合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

五、实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

这份完整版的AI绘画(SD、comfyui、AI视频)整合包已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

1571

1571

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?