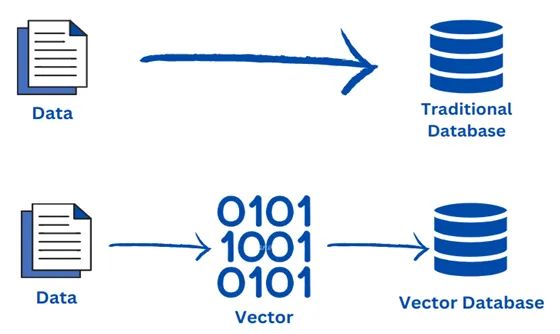

向量数据库(Vector Database)是专门为存储、索引和管理高维向量数据设计的数据库,广泛应用于人工智能(AI)、机器学习(ML)和大数据分析场景。随着非结构化数据(如图像、文本、音频等)的爆炸式增长,向量数据库通过将这些数据转化为向量嵌入(embeddings),并支持高效的相似性搜索,成为AI应用(如RAG、推荐系统、语义搜索等)的核心基础设施。本文将对比当前流行的向量数据库,包括嵌入式向量数据库(如ChromaDB、LanceDB),分析其优缺点、适用场景,并提供实际案例。

一、Pinecone

1、概述

Pinecone 是一个全托管的云原生向量数据库,专为高性能向量搜索设计,支持实时数据处理和低延迟查询。

2、优点

- 易用性:全托管服务,开发者无需管理底层基础设施,开箱即用,适合快速原型开发。

- 高性能:优化了低延迟和高吞吐量的向量搜索,适合实时应用。

- 扩展性:支持动态扩展,适应大规模数据集。

- 集成性:与主流AI框架和云平台(如AWS、GCP)无缝集成。

3、缺点

- 成本较高:作为全托管服务,费用可能高于自托管解决方案,尤其是高并发场景。

- 依赖云服务:无法本地部署,可能不适合对数据隐私要求极高的场景。

- 功能有限:专注于向量搜索,缺乏传统数据库的复杂查询功能。

4、适用场景

- 实时推荐系统:如电商平台的个性化推荐。

- 语义搜索:用于文本、图像等非结构化数据的语义检索。

- AI驱动的聊天机器人:结合大语言模型(LLM)进行知识库查询。

5、案例

- 电商推荐:某电商平台使用 Pinecone 为用户提供个性化商品推荐,通过实时分析用户行为向量,显著提升点击率。

- 知识管理:一家企业利用 Pinecone 构建语义搜索系统,快速检索内部文档,提高员工效率。

二、Milvus

1、概述

Milvus 是一个开源向量数据库,基于 FAISS、Annoy 和 HNSW 等算法构建,专为高维向量搜索优化,支持多种索引类型。

2、优点

- 开源免费:社区活跃,支持自托管,适合预算有限的团队。

- 高性能:支持多种索引算法(如HNSW、IVF),提供高精度和快速查询。

- 灵活性:支持多语言客户端(Python、Java、Go等),兼容多种数据格式。

- 可扩展性:分布式架构,适合处理超大规模数据集。

3、缺点

- 部署复杂:自托管需要较高的运维能力,配置和优化较为复杂。

- 学习曲线:新手可能需要时间熟悉其架构和索引配置。

- 资源占用:高性能查询可能需要大量计算资源。

4、适用场景

- 大规模图像搜索:如图像识别和相似图像检索。

- 自然语言处理(NLP):支持语义搜索、文本聚类等。

- 推荐系统:为大型平台提供高并发推荐服务。

5、案例

- 视频内容分析:某视频平台使用 Milvus 存储视频帧的向量嵌入,实现快速内容搜索和推荐。

- 生物信息学:一家研究机构利用 Milvus 管理基因序列向量,加速相似性分析。

三、Weaviate

1、概述

Weaviate 是一个开源向量数据库,支持混合搜索(向量搜索+传统关键字搜索),内置模块化架构,易于与AI模型集成。

2、优点

- 混合搜索:支持向量搜索与传统关键字搜索结合,提供更灵活的查询方式。

- 模块化设计:内置多种嵌入模型(如Transformers、OpenAI),便于快速开发。

- 开源与托管选项:提供自托管和云托管两种模式,灵活性高。

- GraphQL支持:通过GraphQL接口简化数据查询。

3、缺点

- 性能优化不足:在超大规模数据集上的性能可能不如 Pinecone 或 Milvus。

- 社区较小:相比 Milvus,社区支持和生态系统较弱。

- 配置复杂:模块化设计可能导致初学者配置困难。

4、适用场景

- 知识图谱:结合向量和图数据库功能,适合构建语义知识图谱。

- 混合搜索应用:如需要同时支持关键字和语义搜索的场景。

- 小型AI项目:适合快速原型开发和测试。

5、案例

- 企业搜索:一家咨询公司使用 Weaviate 构建内部知识库,支持语义和关键字混合搜索。

- 智能问答系统:某教育平台利用 Weaviate 的向量搜索功能,为学生提供精准的问题答案。

四、Elasticsearch(带向量搜索插件)

1、概述

Elasticsearch 是一个基于 Lucene 的分布式搜索和分析引擎,通过插件支持向量搜索,适合需要结合结构化和非结构化数据的场景。

2、优点

- 多功能性:支持全文搜索、向量搜索和结构化查询,功能全面。

- 成熟生态:拥有庞大的社区和丰富的插件支持,易于集成。

- 分布式架构:高可用性和可扩展性,适合企业级应用。

- 广泛采用:已在众多行业中广泛应用,文档和支持资源丰富。

3、缺点

- 向量搜索非核心:向量搜索功能需要额外插件,性能可能不如专用向量数据库。

- 复杂性:配置和优化需要专业知识,维护成本较高。

- 资源需求:高并发场景下对硬件要求较高。

4、适用场景

- 企业级搜索:需要结合全文搜索和向量搜索的复杂应用。

- 日志分析:处理大规模日志数据并进行语义分析。

- 混合数据管理:适合需要同时处理结构化和非结构化数据的场景。

5、案例

- 日志监控:一家科技公司使用 Elasticsearch 的向量搜索功能分析系统日志,检测异常行为。

- 电商搜索:某零售平台结合 Elasticsearch 的全文和向量搜索,提供更精准的商品推荐。

五、PgVector(PostgreSQL扩展)

1、概述

PgVector 是 PostgreSQL 的向量搜索扩展,允许在传统关系型数据库中存储和查询向量数据,适合已有 PostgreSQL 基础设施的团队。

2、优点

- 无缝集成:与 PostgreSQL 集成,无需额外部署新数据库。

- 开源免费:无额外成本,适合预算有限的团队。

- SQL支持:支持标准 SQL 查询,易于与现有系统集成。

- 社区支持:背靠 PostgreSQL 社区,文档和支持丰富。

3、缺点

- 性能有限:在超大规模数据集上的向量搜索性能不如专用数据库。

- 索引选项有限:仅支持 HNSW 和 IVF 等少数索引类型。

- 扩展性挑战:分布式部署需要额外的集群管理工具。

4、适用场景

- 中小规模AI应用:适合对性能要求不高的场景。

- 混合数据查询:需要结合关系型数据和向量数据的应用。

- 现有PostgreSQL用户:希望在现有数据库上添加向量搜索功能。

5、案例

- 旅游推荐:去哪儿网使用 PgVector 存储用户行为向量,为用户推荐个性化旅游产品。

- 内容管理系统:一家媒体公司利用 PgVector 实现文章的语义搜索功能。

六、Redis(带向量搜索模块)

1、概述

Redis 是一个高性能的内存数据库,通过 RedisSearch 和 RediSearch 模块支持向量搜索,适合低延迟场景。

2、缺点

- 内存成本高:内存数据库需要大量 RAM,成本较高。

- 功能有限:向量搜索功能较为基础,复杂查询支持不足。

- 扩展性限制:大规模分布式部署需要额外配置。

3、适用场景

- 实时推荐:需要超低延迟的推荐系统。

- 缓存与搜索结合:如电商平台的高速缓存和搜索。

- 小型向量应用:适合数据规模不大的场景。

4、案例

- 实时广告推荐:某广告平台使用 Redis 存储用户兴趣向量,实时推送个性化广告。

- 游戏排行榜:一家游戏公司结合 Redis 的向量搜索和键值存储,优化玩家匹配系统。

七、ChromaDB

1、概述

ChromaDB 是一个开源、嵌入式向量数据库,专为AI应用设计,支持快速存储和查询向量嵌入,强调简单性和易用性。

2、优点

- 嵌入式设计:无需单独的服务器,支持嵌入式运行,适合轻量级应用。

- 易用性:提供简单的 Python 和 JavaScript/TypeScript API,快速上手。

- 开源免费:无许可费用,社区支持活跃。

- 多模态支持:支持文本、图像等多种数据类型的向量存储和查询。

- 灵活存储:支持内存存储、持久化存储(如DuckDB+Parquet),以及未来的云托管。

3、缺点

- 性能限制:在超大规模数据集上的性能不如 Milvus 或 Pinecone。

- 功能较少:相比 Milvus,功能较为简单,缺乏高级数据库管理特性。

- 社区较新:生态系统和社区支持尚在发展中。

4、适用场景

- 轻量级AI应用:如本地开发、原型设计或小型项目。

- RAG系统:结合大语言模型(LLM)进行检索增强生成。

- 语义搜索:适合快速构建文本或图像的语义搜索功能。

5、案例

- 文档搜索:某初创公司使用 ChromaDB 构建内部文档搜索系统,支持语义查询,提高检索效率。

- 聊天机器人:一家企业利用 ChromaDB 存储知识库向量嵌入,为客户服务机器人提供快速答案。

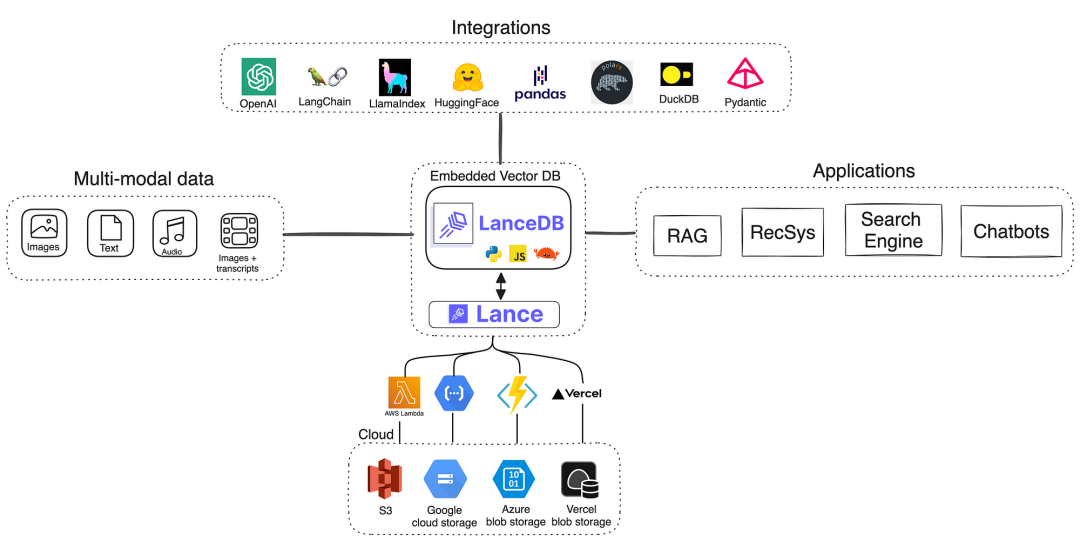

八、LanceDB

1、概述

LanceDB 是一个开源、嵌入式向量数据库,使用 Rust 构建,基于高效的 Lance 列式存储格式,专为高性能和低资源占用设计。

2、优点

- 嵌入式架构:无需服务器,嵌入应用中运行,简化部署。

- 高性能:基于 Rust 和 Lance 格式,查询速度快,资源占用低。

- 开源免费:无许可费用,适合预算有限的团队。

- 多模态支持:支持文本、图像、视频等多种数据类型的向量存储。

- 数据湖集成:可直接与数据湖集成,适合分布式环境。

3、缺点

- 年轻项目:功能仍在开发中,社区和生态系统较小。

- 功能有限:相比成熟数据库,高级功能(如分布式查询)支持不足。

- 学习曲线:Lance 格式和 Rust 生态对新手可能有一定门槛。

4、适用场景

- 边缘设备:适合资源受限的设备(如移动设备、IoT)上的AI应用。

- 数据湖分析:与数据湖结合,处理大规模非结构化数据。

- 快速原型:适合需要快速迭代的小型AI项目。

5、案例

- 图像分析:某初创公司使用 LanceDB 在边缘设备上运行图像相似性搜索,优化零售库存管理。

- 实时监控:一家物联网公司利用 LanceDB 存储传感器数据向量,检测异常模式。

九、总结与选择建议

| 数据库 | 开源/托管 | 性能 | 易用性 | 适用场景 |

|---|---|---|---|---|

| Pinecone | 托管 | 高 | 高 | 实时推荐、语义搜索 |

| Milvus | 开源 | 高 | 中 | 大规模图像/NLP处理 |

| Weaviate | 开源/托管 | 中 | 高 | 混合搜索、知识图谱 |

| Elasticsearch | 开源/托管 | 中 | 中 | 企业级搜索、日志分析 |

| PgVector | 开源 | 中 | 高 | 混合数据查询、中小规模AI应用 |

| Redis | 开源/托管 | 高 | 高 | 实时推荐、缓存与搜索结合 |

| ChromaDB | 开源 | 中 | 高 | 轻量级AI应用、RAG系统 |

| LanceDB | 开源 | 高 | 中 | 边缘设备、数据湖分析 |

1、选择建议

- 初创公司/快速开发:选择 Pinecone、ChromaDB 或 Weaviate,易于上手且支持快速原型。

- 预算有限/技术能力强:选择 Milvus、PgVector 或 LanceDB,充分利用开源优势。

- 企业级复杂需求:Elasticsearch 适合需要结合多种数据类型的场景。

- 超低延迟需求:Redis 和 Pinecone 是实时应用的理想选择。

- 嵌入式/边缘计算:ChromaDB 和 LanceDB 适合轻量级、资源受限的环境。

向量数据库的选择应根据项目规模、预算、技术栈和性能需求综合考虑。嵌入式数据库如 ChromaDB 和 LanceDB 为资源受限或本地化场景提供了灵活的解决方案,而托管或分布式数据库如 Pinecone 和 Milvus 更适合大规模、高并发的企业级应用。未来,随着AI应用的深入发展,向量数据库的功能和生态将继续扩展,为更多行业赋能。

十、如何系统学习掌握AI大模型?

AI大模型作为人工智能领域的重要技术突破,正成为推动各行各业创新和转型的关键力量。抓住AI大模型的风口,掌握AI大模型的知识和技能将变得越来越重要。

学习AI大模型是一个系统的过程,需要从基础开始,逐步深入到更高级的技术。

这里给大家精心整理了一份

全面的AI大模型学习资源,包括:AI大模型全套学习路线图(从入门到实战)、精品AI大模型学习书籍手册、视频教程、实战学习、面试题等,资料免费分享!

1. 成长路线图&学习规划

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

这里,我们为新手和想要进一步提升的专业人士准备了一份详细的学习成长路线图和规划。可以说是最科学最系统的学习成长路线。

2. 大模型经典PDF书籍

书籍和学习文档资料是学习大模型过程中必不可少的,我们精选了一系列深入探讨大模型技术的书籍和学习文档,它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。(书籍含电子版PDF)

3. 大模型视频教程

对于很多自学或者没有基础的同学来说,书籍这些纯文字类的学习教材会觉得比较晦涩难以理解,因此,我们提供了丰富的大模型视频教程,以动态、形象的方式展示技术概念,帮助你更快、更轻松地掌握核心知识。

4. 2024行业报告

行业分析主要包括对不同行业的现状、趋势、问题、机会等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

5. 大模型项目实战

学以致用 ,当你的理论知识积累到一定程度,就需要通过项目实战,在实际操作中检验和巩固你所学到的知识,同时为你找工作和职业发展打下坚实的基础。

6. 大模型面试题

面试不仅是技术的较量,更需要充分的准备。

在你已经掌握了大模型技术之后,就需要开始准备面试,我们将提供精心整理的大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以

微信扫描下方CSDN官方认证二维码,免费领取【保证100%免费】

[1] : https://github.com/chroma-core/chroma

[2] : https://dev523.medium.com/chromadb-vs-pgvector-the-epic-battle-of-vector-databases-a43216772b34

[3] : https://thedataquarry.com/blog/vector-db-1/

1997

1997

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?