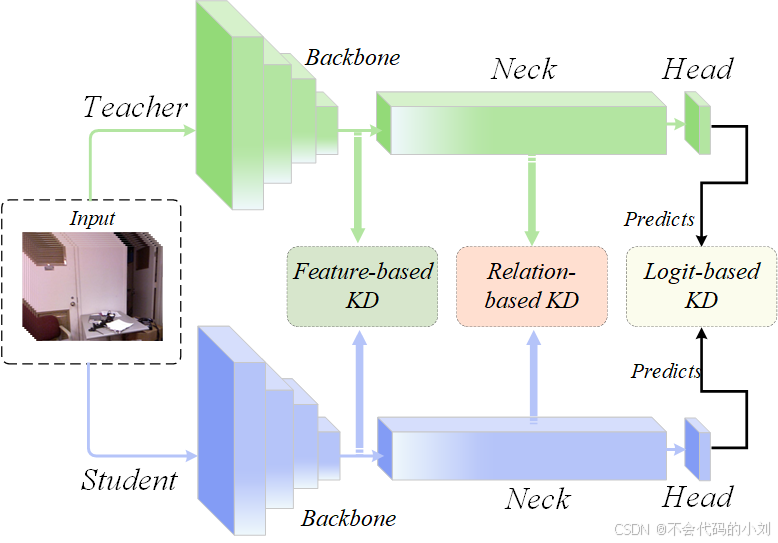

知识蒸馏(Knowledge Distillation)是一种模型压缩技术,主要通过训练一个较小的学生模型来模仿一个较大的教师模型的行为,从而在保持模型性能的同时降低计算和存储成本。在知识蒸馏中,根据蒸馏的具体机制,可以分为以下三种主要方法:基于逻辑的蒸馏、基于特征的蒸馏 和 基于关系的蒸馏。

1. 基于逻辑的蒸馏(Logit-based Distillation)

基于逻辑的蒸馏是知识蒸馏中最经典、最广泛使用的一种方法,最早由 Hinton 等人在论文《Distilling the Knowledge in a Neural Network》中提出。这种方法的核心思想是让学生模型学习教师模型的输出概率分布。人话:利用整个网络最后输出的预测图进行学习蒸馏的就是基于逻辑的蒸馏。

机制:

- 教师模型的输出通常是通过 softmax 函数转化为类别概率分布的逻辑值(logits)。

- 学生模型通过最小化与教师模型输出分布的差异(通常通过 KL 散度损失实现),来学习教师模型的知识。

- 为了更好地捕捉不同类别之间的相对关系,通常引入一个温度参数来平滑教师模型的输出分布。

损失函数:

基于逻辑的蒸馏包括两个部分:

- 蒸馏损失(KL 散度):

,

其中是温度平滑后的概率分布。

- 监督损失(Cross-Entropy):

,

其中是真实标签。

最终总损失是两部分的加权和:

优点:

- 简单有效,适用于分类任务。

- 不需要对教师模型进行额外的修改。

缺点:

- 如果教师模型的输出信息不足(例如过于自信),可能会影响蒸馏效果。

2. 基于特征的蒸馏(Feature-based Distillation)

基于特征的蒸馏通过让学生模型学习教师模型中间层的特征表示(feature representations)来传递知识。这种方法认为教师模型的中间层特征比最终输出包含更多的信息。人话:Backbone输出的特征图进行的蒸馏学习就是基于特征的知识蒸馏。

机制:

- 选择教师模型和学生模型的某些中间层特征映射(例如卷积层输出)。

- 学生模型通过一个映射函数(例如线性变换或非线性变换)将其特征调整到与教师模型特征对齐,从而学习更丰富的表示。

损失函数:

- 通常采用范数或其他距离度量来最小化教师特征和学生特征之间的差异:

.

优点:

- 提供比逻辑层更丰富的知识。

- 在复杂任务(如目标检测、语义分割等)中效果较好。

缺点:

- 需要选择合适的中间特征层,可能需要额外的调整。

- 对学生模型的架构有一定要求(需要与教师模型有类似的层次结构)。

3. 基于关系的蒸馏(Relation-based Distillation)

基于关系的蒸馏关注的是样本之间的关系信息,而不是单个样本本身的特征或逻辑值。这种方法的核心思想是学生模型应学习教师模型输出或特征之间的结构化关系。人话:网络中间层例如特征增强以及特征融合层中切片出来进行蒸馏学习的就叫基于关系的蒸馏。

机制:

- 教师模型不仅提供每个样本的特征或输出,还通过样本之间的关系(如相似度、距离)构建知识。

- 学生模型通过模仿这些关系来学习更高阶的知识。

常见方法:

- 样本对之间的关系:

- 比较样本之间的相似性(如余弦相似度、欧氏距离)。

- 学生模型通过最小化与教师模型中样本对关系的误差来学习。

- 全局关系:

- 通过图(Graph)建模,捕捉整个数据集的全局关系。

- 使用图嵌入或注意力机制等技术来表示和学习这些关系。

损失函数:

- 基于关系的蒸馏通常采用关系度量的最小化,例如:

,

其中表示样本之间的关系矩阵。

优点:

- 通过样本之间的关系引入了更高层次的语义信息。

- 对于需要捕捉上下文依赖或全局结构的任务(如自然语言处理)非常有效。

缺点:

- 计算关系矩阵可能带来额外的计算开销。

- 实现复杂,依赖于任务和数据的关系建模。

总结

| 蒸馏机制 | 核心思想 | 优点 | 缺点 |

|---|---|---|---|

| 基于逻辑的蒸馏 | 学习教师模型输出的概率分布 | 简单高效,适合分类任务 | 输出信息不足时效果可能受限 |

| 基于特征的蒸馏 | 学习教师模型的中间层特征表示 | 表达更丰富,适合复杂任务 | 对学生模型架构有要求,需选择合适的特征层 |

| 基于关系的蒸馏 | 学习样本之间的关系或全局结构 | 捕捉高阶语义信息,适合上下文依赖的任务 | 实现复杂,计算开销较大 |

1372

1372

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?