Efficient-AI-Backbones: 推动AI模型轻量化与高效化的前沿探索

在人工智能快速发展的今天,如何设计更加高效的神经网络模型成为了学术界和工业界共同关注的重要课题。华为诺亚方舟实验室(Huawei Noah's Ark Lab)开发的Efficient-AI-Backbones项目,正是在这一方向上的重要探索。该项目汇集了多个创新性的轻量级骨干网络设计,包括GhostNet、Transformer in Transformer (TNT)以及多层感知机(MLP)等,旨在推动AI模型向更加高效、轻量化的方向发展。

GhostNet: 幽灵模块的创新设计

GhostNet是Efficient-AI-Backbones项目中的一个重要组成部分。其核心创新在于引入了"幽灵"(Ghost)模块的概念。传统卷积神经网络中,每一层都需要大量的卷积运算,这导致了计算复杂度的急剧上升。GhostNet的设计者们提出,可以通过一些简单的线性变换来"生成"更多的特征图,而不是直接计算它们。这种方法大大减少了模型的参数量和计算量,同时保持了较高的性能。

如上图所示,GhostNet的核心思想是用少量的"intrinsic"特征图通过简单变换生成大量的"ghost"特征图。这种设计使得GhostNet在移动设备等计算资源受限的场景下表现出色,为轻量级CNN设计提供了新的思路。

Transformer in Transformer (TNT): 多尺度特征学习的新范式

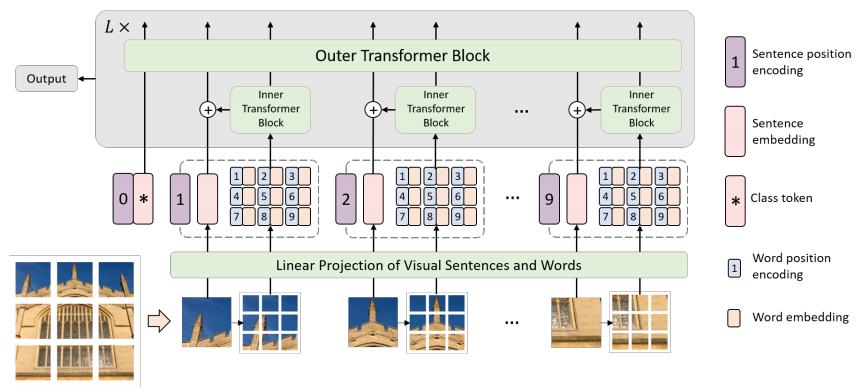

TNT (Transformer in Transformer) 是另一个值得关注的创新设计。随着Transformer结构在计算机视觉领域的广泛应用,如何更好地处理图像的多尺度信息成为了一个关键问题。TNT提出了一种嵌套的Transformer结构,能够同时处理图像的局部细节和全局语义信息。

TNT的核心思想是在每个patch内部再嵌入一个小型Transformer,用于捕获更细粒度的局部特征。这种设计使得模型能够更好地理解图像的层次结构,从而在各种视觉任务中取得了优异的性能。

PyramidTNT: TNT的进一步优化

在TNT的基础上,研究人员进一步提出了PyramidTNT。这个改进版本引入了金字塔结构,使得模型能够更有效地处理多尺度信息。PyramidTNT在保持TNT优势的同时,进一步提升了模型的性能和效率。

PyramidTNT的设计理念是将图像划分为不同大小的patch,并在不同层次上应用TNT结构。这种多尺度的处理方式使得模型能够更好地捕获图像的全局和局部信息,从而在图像分类等任务上取得了更好的结果。

MLP: 简单而强大的新选择

除了基于CNN和Transformer的设计,Efficient-AI-Backbones项目还探索了基于多层感知机(MLP)的网络结构。这些MLP-based模型展示了简单结构也能达到复杂模型性能的可能性,为深度学习模型设计提供了新的思路。

MLP-based模型的优势在于其结构简单,易于理解和实现。同时,通过精心的设计,这些模型也能在各种视觉任务中取得与复杂模型相当的性能。这为未来的模型设计提供了一个新的方向,即如何在保持模型简洁性的同时提高其性能。

实验结果与性能评估

Efficient-AI-Backbones项目中的各个模型都在ImageNet等标准数据集上进行了广泛的测试。以下是部分模型在ImageNet上的性能数据:

| 模型 | 参数量 (M) | FLOPs (B) | Top-1 准确率 (%) | Top-5 准确率 (%) |

|---|---|---|---|---|

| TNT-S | 23.8 | 5.2 | 81.5 | 95.7 |

| TNT-B | 65.6 | 14.1 | 82.9 | 96.3 |

| PyramidTNT-Ti | 10.6 | 0.6 | 75.2 | - |

| PyramidTNT-S | 32.0 | 3.3 | 82.0 | - |

| PyramidTNT-M | 85.0 | 8.2 | 83.5 | - |

| PyramidTNT-B | 157.0 | 16.0 | 84.1 | - |

这些数据显示,Efficient-AI-Backbones项目中的模型在保持较低参数量和计算量的同时,能够达到很高的分类准确率。这证明了这些创新设计在提高模型效率方面的巨大潜力。

开源贡献与社区影响

Efficient-AI-Backbones项目不仅在学术上取得了重要成果,还通过开源的方式为整个AI社区做出了重要贡献。项目在GitHub上公开了源代码,并提供了详细的使用说明和预训练模型,这大大促进了相关研究的发展和技术的传播。

多个知名的深度学习框架和库,如PyTorch的timm、MMClassification等,都集成了Efficient-AI-Backbones中的模型实现。这进一步扩大了项目的影响力,使得更多的研究者和开发者能够方便地使用和改进这些高效模型。

未来展望

随着AI技术的不断发展,对高效、轻量级AI模型的需求只会越来越大。Efficient-AI-Backbones项目为这一领域的研究提供了宝贵的经验和创新思路。未来,我们可以期待看到更多基于这些思想的改进和创新:

- 进一步优化模型结构,探索更高效的特征提取和信息处理方式。

- 将这些高效骨干网络应用到更广泛的视觉任务中,如目标检测、语义分割等。

- 探索这些模型在边缘计算、移动设备等资源受限场景下的应用。

- 结合神经网络架构搜索(NAS)技术,自动发现更优的网络结构。

- 研究如何将这些高效设计思想扩展到自然语言处理等其他AI领域。

结语

Efficient-AI-Backbones项目展示了华为诺亚方舟实验室在推动AI模型轻量化和高效化方面的卓越贡献。通过GhostNet、TNT、PyramidTNT等创新设计,项目为解决AI模型计算复杂度和资源消耗问题提供了新的思路。这些工作不仅在学术界产生了重要影响,也为AI技术在更多场景下的应用铺平了道路。随着研究的深入和技术的成熟,我们有理由相信,更加高效、智能的AI系统将在不久的将来成为现实,为人类社会带来更多便利和价值。

文章链接:www.dongaigc.com/a/efficient-ai-backbones-huawei

https://www.dongaigc.com/a/efficient-ai-backbones-huawei

295

295

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?