1. 总述

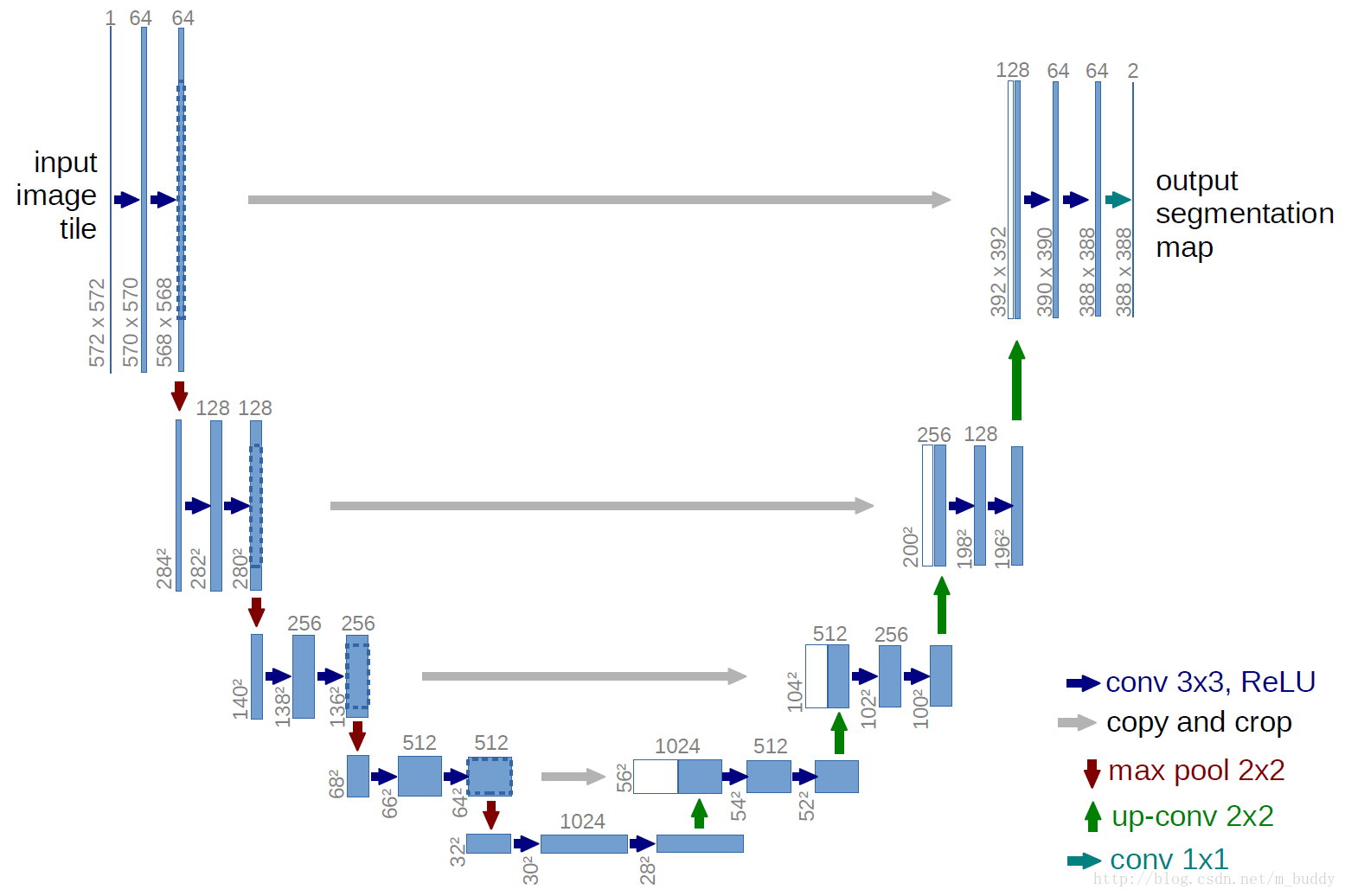

在15年的文章:《U-Net: Convolutional Networks for Biomedical Image Segmentation》中提出了一种基于少量数据进行训练的网络的模型,得到了不错的分割精度,并且网络的速度很快。对于分割一副512*512大小的图像只需要不到1s的时间。它的网络模型结构是这样的,看起来像是一个U型,故也叫U-net

从上面的U-net网络图结构可以看出下降的部分是采用conv+max-pool来实现的,并且在下采样过程中逐次增加feature channels;对于上升部分是使用左边的feature map拷贝和剪裁(是因为每次卷积过程中边缘像素的丢失)+up_convolution,这样的结构使得在上采样过程中网络可以传播到更高分辨率的层。

整个网络的思路跟FCN是差不多的,一个区别是它没有用VGG等CNN模型作为预训练模型,因为u-net做的是医学图像的二值分割,没必要用ImageNet的预训练模型,而且u-net这个结构我们是可以根据自己的数据集自由加深网络结构的,比如在处理具有更大的感受野的目标的时候;另一个区别是u-net在进行浅层特征融合的时候,采用的是叠加的做法,而不是FCN中的求和操作,也就是上图中的白色模块,是直接从左边的蓝色模块叠加过来的(如果是在Caffe中实现的,u-net是Concat层,而fcn是Eltwise层)。

本文介绍了U-Net网络模型,一种适用于小数据集的快速图像分割模型,尤其在生物医学图像领域表现出色。U-Net结构独特,采用下采样增加特征通道,上采样融合浅层特征,有效处理图像边缘信息。在训练过程中,通过像素级损失函数和形态学运算优化边界分割,并利用数据增强提升模型泛化能力。

本文介绍了U-Net网络模型,一种适用于小数据集的快速图像分割模型,尤其在生物医学图像领域表现出色。U-Net结构独特,采用下采样增加特征通道,上采样融合浅层特征,有效处理图像边缘信息。在训练过程中,通过像素级损失函数和形态学运算优化边界分割,并利用数据增强提升模型泛化能力。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

639

639

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?