✅作者简介:热爱科研的Matlab仿真开发者,修心和技术同步精进,

代码获取、论文复现及科研仿真合作可私信。

🍎个人主页:Matlab科研工作室

🍊个人信条:格物致知。

更多Matlab完整代码及仿真定制内容点击👇

🔥 内容介绍

在当今信息爆炸的时代,数据处理和分析已经成为了各行各业中不可或缺的一部分。随着数据量的不断增加,如何有效地处理和分析这些海量数据成为了一个亟待解决的问题。在数据处理和分析领域,数据分类预测是一个非常重要的任务,它可以帮助我们更好地理解数据的特征和规律,从而为我们的决策提供有力的支持。

在数据分类预测任务中,自编码器是一种常用的神经网络模型。自编码器通过学习数据的特征表示,可以实现对数据的降维和特征提取,从而为后续的分类预测任务提供更好的输入。然而,传统的自编码器在处理噪声和提取高阶特征方面存在一定的局限性。为了解决这一问题,研究者们提出了堆叠去噪自编码器(Stacked Denoising Autoencoder, SDAE)模型。

堆叠去噪自编码器是一种多层的神经网络模型,它通过堆叠多个去噪自编码器来逐层地学习数据的特征表示。在每一层中,去噪自编码器可以有效地去除输入数据中的噪声,并学习数据的高阶特征。通过多层的堆叠,SDAE可以学习到更加抽象和复杂的数据特征表示,从而为数据分类预测任务提供更加丰富和有用的信息。

在实际的数据分类预测任务中,SDAE模型已经取得了一系列令人瞩目的成果。例如,在图像分类任务中,研究者们利用SDAE模型可以实现对图像特征的学习和提取,从而大大提高了图像分类的准确性和效率。在文本分类任务中,SDAE模型也可以帮助我们更好地理解文本数据的语义和结构,从而实现更加精准的文本分类和预测。

总的来说,基于堆叠去噪自编码器SDAE的数据分类预测具有非常广阔的应用前景和研究价值。随着深度学习和神经网络技术的不断发展,相信SDAE模型在数据分类预测领域中将会发挥越来越重要的作用,为我们的数据分析和决策提供更加有力的支持。希望未来能够有更多的研究者和工程师投入到SDAE模型的研究和应用中,共同推动这一领域的发展和进步。

📣 部分代码

%% 清空环境变量warning off % 关闭报警信息close all % 关闭开启的图窗clear % 清空变量clc % 清空命令行%% 导入数据res = xlsread('数据集.xlsx');%% 划分训练集和测试集temp = randperm(357);P_train = res(temp(1: 240), 1: 12)';T_train = res(temp(1: 240), 13)';M = size(P_train, 2);P_test = res(temp(241: end), 1: 12)';T_test = res(temp(241: end), 13)';N = size(P_test, 2);%% 数据归一化[p_train, ps_input] = mapminmax(P_train, 0, 1);p_test = mapminmax('apply', P_test, ps_input);t_train = ind2vec(T_train);t_test = ind2vec(T_test );

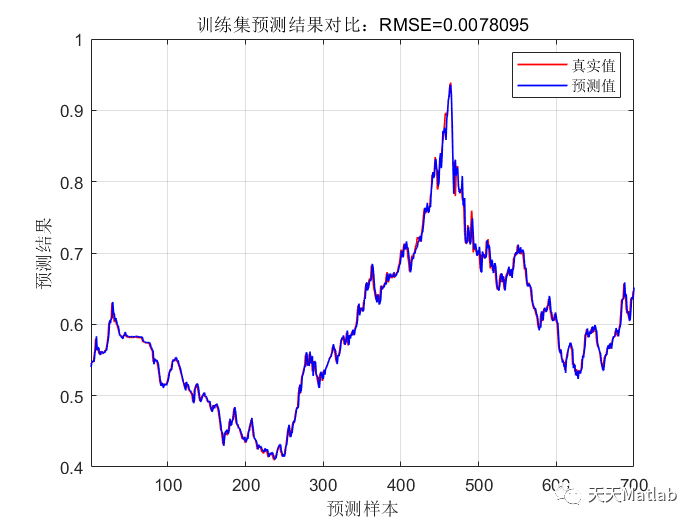

⛳️ 运行结果

🔗 参考文献

本程序参考以下中文EI期刊,程序注释清晰,干货满满。

147

147

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?