文章目录

前言

这次看见沐神讲的权重衰退,

权重衰退就是为了处理过拟合的现象,但是一下抛出来这个公式就是不是很理解,还和拉格朗日有关,作为高数早忘的我就查了一下,在b站这个大神讲的还不错,我就整理了一下,从三个角度去理解,我暂时就整理了第一个。

L1和L2正则化”直观理解(之一),从拉格朗日乘数法角度进行理解

一.什么是正则化(regularization)

在动手深度学习的英文版里面解释了凡是减少过拟合就是正则化

1. 为什么要用l1和l2 范数

在机器学习中,我们最喜欢解决的就是凸优化问题,而l1和l2范数正是利用了l1和l2的凸集特性

二.神经网络为什么会产生过拟合(原因之一)

1.W和b参数值不唯一?

假如有下面一个神经网络

假如现在我们计算出了最终结果W1,b1,这时候我们将隐藏层的W和b都增加两倍(a^(l-1)变小两倍),这时候的计算出的结果并不会变的,只是我们原来的W1会变成W1/2。

假如现在我们计算出了最终结果W1,b1,这时候我们将隐藏层的W和b都增加两倍(a^(l-1)变小两倍),这时候的计算出的结果并不会变的,只是我们原来的W1会变成W1/2。

这就造成了我们设置的w初始值如果较小的话,最后的W就会较大。反之亦然。

所以在我们结果相同下,W得出的结果很很取决与初始值

w初始值如果较小,我们W1很大,测试集中的误差和噪声也会放大,从而产生过拟合。

三.拉格朗日的’介入’

上面既然说到了W参数可能会存在过大,所以我们就要人为的去限制以这个参数。而这正是拉格朗日擅长的。

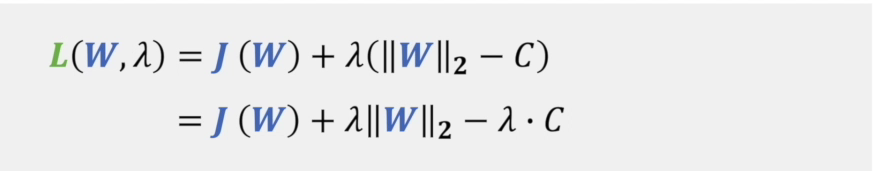

所以有了公式

上面的两个蓝点就是极值点,而λ就是控制两方梯度相等,从而求出极值点。相当于λ控制的长度。

两图对应l1范数和l2范数,考虑一下为什么不用l0.5正则呢?

下面我们把l2范数拆开

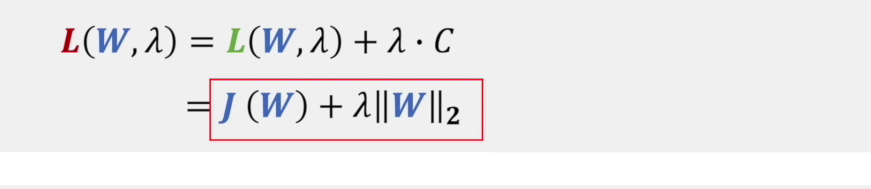

而我们一般见到的是这个

两者有什么关系呢?

他们两取得最值虽然不同,但是取得的最值的W确实一样的。公式中的c指的是半径。

可以看到第二个公式少了c,这真是要我们去确定的

红色的梯度是损失函数的梯度,而绿色的梯度是λ来确定。当两个梯度方向相反,大小相等是,C就确定了。

传统的拉格朗日,是在已知λ的条件下求C,而机器学习里是通过λ去求C

l1 范数和l2范数的特点

l1 可以把特征值剥离出来,l1正则化可以带来稀疏性。

视频结尾还有讲为什么正则化不会带来较大偏差

语言并不好说,推荐大家去看看

2101

2101

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?