1 引言

该论文是旷视科技收录于CVPR2021的一篇理论性的文章,作者提出了一个简单、有效的激活函数 ,该激活函数可以决定是否要激活神经元,在此基础上作者进一步提出了 激活函数,它通过引入开关因子去学习非线性(激活)和线性(非激活)之间的参数切换。实验结果表明,在图像分类,目标检测以及语义分割的任务上,该激活函数都可以使得深度模型有显著的提升效果。

论文链接:https://arxiv.org/abs/2009.04759

代码链接:https://github.com/nmaac/acon

2 ACON

2.1 光滑最大值函数

考虑标准最大函数 的 个值,它的光滑性的和可微的性近似为:

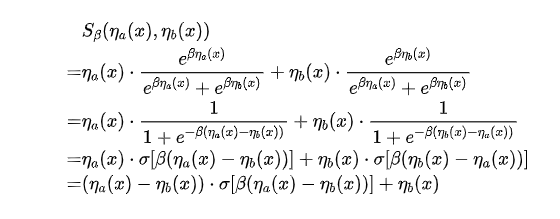

其中 表示连接系数。当 时,则有 ;当 时,则有 。在神经网络中,许多常见的激活函数是 函数的形式,其中 和 表示线性函数。作者的目标是用这个公式来近似激活函数。考虑 时的情况,将 表示为Sigmoid函数,近似值为:

2.2 ACON-A

当 , 时,则有:

以上公式即是 激活函数,也是 激活函数。 函数是最近被提出的一个新的激活函数。尽管它最近被广泛使用,但对于它为什么提高性能缺乏合理的解释。作者给我们提供了一个新的解释即 是

本文介绍了旷视科技在CVPR2021发表的ACON激活函数,这是一种新的神经网络激活方法,旨在通过开关因子学习非线性和线性之间的切换。ACON包括ACON-A、ACON-B和ACON-C,具有可学习的一阶导数上界和下界,能够适应性地激活或不激活神经元,从而提高深度模型在图像分类、目标检测和语义分割任务上的性能。实验结果表明,ACON在各种网络结构中均表现出显著的准确性提升。

本文介绍了旷视科技在CVPR2021发表的ACON激活函数,这是一种新的神经网络激活方法,旨在通过开关因子学习非线性和线性之间的切换。ACON包括ACON-A、ACON-B和ACON-C,具有可学习的一阶导数上界和下界,能够适应性地激活或不激活神经元,从而提高深度模型在图像分类、目标检测和语义分割任务上的性能。实验结果表明,ACON在各种网络结构中均表现出显著的准确性提升。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

7387

7387

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?