本文分享一篇 CVPR 2021 Oral 论文,由北科大&中山大学&微软提出端到端视觉语言表征学习的预训练方法。『Seeing Out of the Box: End-to-End Pre-Training for Vision-Language Representation Learning』。

详细信息如下:

论文链接:https://openaccess.thecvf.com/content/CVPR2021/html/Huang_Seeing_Out_of_the_Box_End-to-End_Pre-Training_for_Vision-Language_Representation_CVPR_2021_paper.html

项目链接:https://github.com/researchmm/soho

导言:

目前视觉语言跨模态预训练方法,大多都是提取图片中显著region,然后将region与语言模态的单词进行对齐,通过这样的方式达到预训练的效果。然而,基于region的视觉特征通常代表图像的部分信息,因此现有的视觉语言模型很难完全理解成对自然语言的语义。

本文作者研究了卷积神经网络(CNN)和视觉语言预训练(vision-language pre-training,VLPT)Transformer的联合学习,目的是从数以百万计的图像-文本对中学习跨模态对齐。基于这个思想,作者提出SOHO“See Out of tHe bOx”,以整体图像作为输入,以端到端方式学习视觉语言表征。SOHO不需要边界框标注,这使得推理速度比基于区域的方法快10倍。SOHO通过视觉字典(visual dictionary,VD)提取全面而紧凑的图像特征。

最终,作者按照标准的VLPT设置,在四个视觉语言任务上进行实验。在MSCOCO text retrieval 5k test split上达到了2.0% R@1的绝对性能提升;在NLVR2 test-P split达到了1.5%的绝对性能提升;在SNLI-VE test split上达到了 6.7%的绝对性能提升。

01

Motivation

随着Transformer和自监督学习的成功,最近出现了大量关于跨模式学习的研究工作,特别是视觉语言预训练(VLPT)。VLPT模型通过学习大规模的图像-文本对,学习更好的跨模态表示。这个跨模态表示,可以被用到各种多模态的下游任务中。最近的VLPT工作大多是基于region特征,这些特征是由在Visual Genome数据集上预先训练的目标探测器提取的。

然而,直接使用目标检测器提取的region特征会有三个问题 :

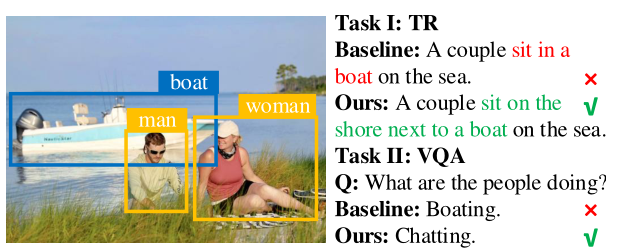

首先,region特征关注的是框内的对象,而忽略了框外的上下文信息 ,这些上下文信息对于理解和推理关系非常重要的。(如下图所示,我们可以很容易地在图像中发现“男人”、“女人”和“船”。然而,如果没有这些框外的上下文信息,模型将误解这种关系为“人划船”,导致模型在文本检索或VQA任务中给出错误的答案。)

第二,对图像的视觉信息理解将会被局限在目标检测器预定义的区域类别 。

第三,大部分region特征是通过检测模型提取的,存在质量低、噪声大、过采样 等问题,依赖于大规模的box标注数据 。

除了解决上述的问题,也有一些工作提出了采用弱监督的目标检测、或者采用grid特征,但是这样方法存在性能不高、只针对单个任务设计等问题。

为了克服基于区域的图像特征的局限性,更好地利用图像-文本对进行跨模态理解,作者提出了SOHO,一个端到端视觉语言预训练框架,可以直接从图像-文本对学习图像embedding、语言embedding及其语义对齐。

与现有的VLPT模型相比,SOHO采用了一个简单的pipeline,不需要复杂的视觉backbone进行预训练。相比于现有的基于region特征的方法,SOHO不需要标注类别或框,可以通过更广泛的图像-文本数据直接优化视觉表示来丰富视觉语义。

另外,作者在本文中提出,像素级的视觉表示比语言embedding更加多样化和密集。而缺乏对像素级语言的监督,增加了视觉语言对齐的难度。因此,为了解决上述问题,作者引入了一种视觉词典(VD),在视觉领域中表达了更全面、更紧凑的语义。

在预训练过程中,作者采用了 Masked Vision Modeling (MVM) ,Masked Language Modeling(MLM),Image-Text Matching (ITM)三个任务来优化模型。

02

方法

SOHO的框架图如上图所示,SOHO包括一个CNN-based的视觉encoder、视觉字典VD模块、多层的Transformer。

CNN用于提取视觉特征,VD模块利用视觉字典将不同的视觉语义信息 (这里指的是visual feature)聚合成视觉token (这里指的是比较高的视觉语义信息)。(个人觉得这里应该是做了一个压缩特征表示的工作,因为图像的特征通常是非常细粒度的,即使两张非常相似的图片,他们的视觉特征也差别很大。

因此作者就将这些视觉特征进行了分类,属于每一个类的视觉特征,用这个类的聚类中心来表示就可以了,这样就可以大大降低视觉特征的多样性,形成高级的视觉特征 )预训练的时候,作者采用MVM,MLM和ITM三个任务进行预训练,然后通过finetune可以被迁移到Image-Text Retrieval, VQA, NLVR,Visual Entailment等下游任务。

2.1. Trainable Visual Encoder

目前大多数视觉语言的研究都基于BUTD Attention用提取region特征(用的是在Visual Genome 数据集上预训练的Faster R-CNN模型)。这些提取的region特征将受限于预定义的对象和属性类别(即1600个对象和400个属性)的限制)。

为了保留所有的视觉信息,作者提出使用一个可训练的CNN视觉编码器,以整个图像作为输入,产生图像级的视觉特征而不是区域级的特征。由于不受bounding box的限制,视觉编码器可以从预训练的损失函数或下游特定任务的损失函数中进行端到端更新,进而进一步优化跨模态学习。

给定一张图片,提取视觉特征的过程可以表示为:

其中E就是一个ResNet-based网络。

2.2. Visual Dictionary

视觉特征编码器提取的视觉特征V比语言单词符号更加多样化和密集,这将给跨模态理解的学习带来困难。为了弥补其表征与语言token之间的差距,作者提出了一种视觉字典(VD),通过将相似的视觉语义聚合到相同的图像特征中来标记视觉特征。

Visual Dictionary Embedding

这里的视觉词典VD其实就是一个矩阵

本文介绍了北科大、中山大学和微软合作的CVPR2021 Oral论文,提出了一种名为SOHO的端到端视觉语言表征预训练方法。SOHO不依赖region特征,而是通过视觉字典学习全面的图像特征,解决了基于region方法的局限性。实验结果显示,SOHO在多个视觉语言任务上表现优越,提升了模型的跨模态理解能力。

本文介绍了北科大、中山大学和微软合作的CVPR2021 Oral论文,提出了一种名为SOHO的端到端视觉语言表征预训练方法。SOHO不依赖region特征,而是通过视觉字典学习全面的图像特征,解决了基于region方法的局限性。实验结果显示,SOHO在多个视觉语言任务上表现优越,提升了模型的跨模态理解能力。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

302

302

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?