▼最近直播超级多,预约保你有收获

今晚直播:《大模型微调企业级专有大模型》

—1—

为什么要微调 LLM 大模型?

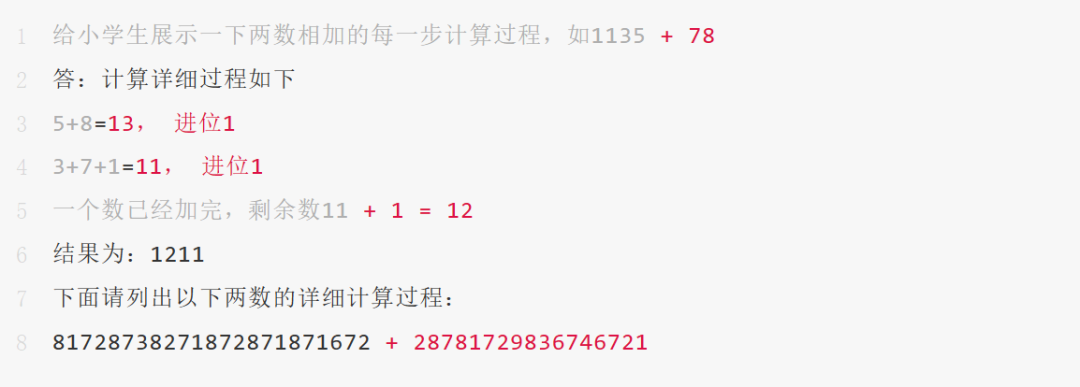

GPT 是“大力出奇迹”的典型代表,通过千亿级训练参数带来惊人的智能,但大模型并不完美,甚至一些在我们看来很简单的任务都完成不了,比如我们构建一个简单计算任务(如下):

GPT-4 回答错误如下:

尽管 AI 在一定程度上模仿了人脑的工作方式,但实际上,机器人和人脑在处理信息时采用的策略有很大的不同。因此,即使在未来,我们也需要继续改进 AI 框架,以解决这种差距。比如一个百万位数的加法任务,GPT-4 囿于 token 数的限制是不可能完成这个任务的,但人类却可以,这恰是人类和 AI 需要弥补的 GAP。

这就是为什么 LLM 大模型已经很强大了,我们还需要继续微调它的其中一个原因,除了这个原因外,还有4点需要微调的原因。

第二、缺乏专有数据,比如:企业内部的私有数据。

第三、缺乏最新数据,比如:GPT-4 的训练数据截止到2021年9月。

第四、预训练成本高,比如:GPT-3 预训练成本为140万美金。

第五、提升数据安全性,比如:企业私有数据是不能传递给第三方大模型的,基于开源大模型的微调才能满足业务的需求。

—2—

如何微调 LLM 大模型?

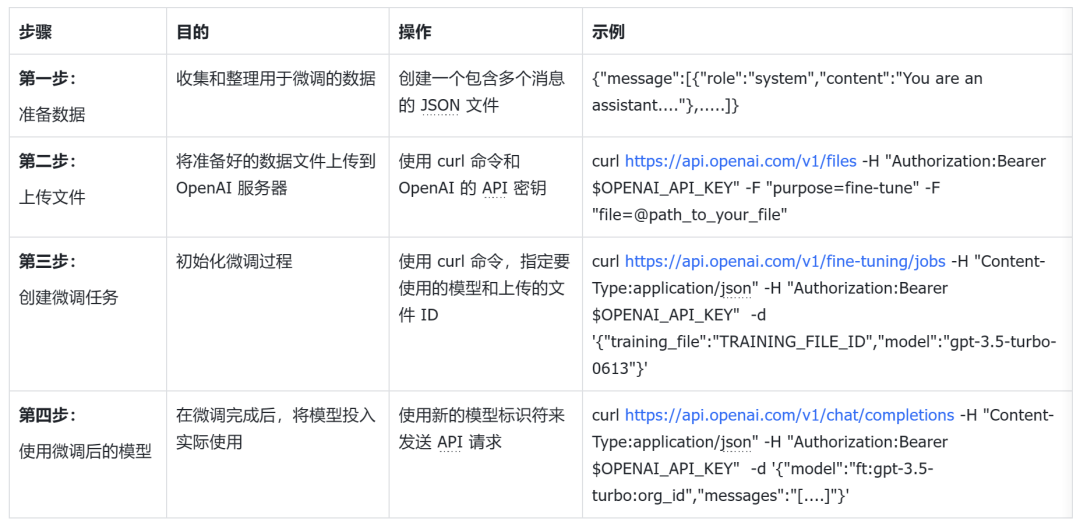

微调(Fine-tuning)分为全参数量微调和局部参数量微调,或者叫 PEFT 高效参数微调,PEFT 微调步骤如下:

第一步:数据工程,选择整理本次微调所需要的知识即任务数据集,以(Q,A)的问答对整理好,微调的数据量最好在 10K~100K 量级。

第二步:加载预训练大模型(比如:ChatGLM3-6B):选择一个与所需任务相关的预训练大模型,并加载其权重。

第三步:对大模型进行微调:将第一步任务数据集作为输入,以最小化大模型在此数据集上的损失函数。在这个过程中,通常需要在训练集和验证集上进行多次迭代,以避免过拟合问题。

基于以上步骤,详细总结如下:

除此之外,微调企业级专有大模型这些技术到底是怎么落地的?在企业级的真实案例中如何实践?

今晚20点直播我会详细剖析,直播精彩看点:

1、大模型关键特性和架构设计剖析

2、基于大模型构建企业级专有大模型技术剖析

3、基于 ChatGLM3/Llama 2 电商和金融专有大模型案例实践

请同学点击下方按钮预约直播,咱们今晚20点直播见!

END

803

803

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?