本文介绍了开源AI开发工具LangFlow的快速入门方法。LangFlow作为可视化框架,支持通过拖拽组件构建多智能体及RAG应用,兼容主流大语言模型与向量数据库。文章从环境搭建、核心功能到实战案例逐步讲解,演示如何利用其可视化界面创建智能聊天机器人,为开发者提供低门槛实现AI应用的完整路径。

Langflow 简介

Langflow 是一个用于构建多智能体和 RAG 应用程序的新颖可视化框架。它是开源的,基于 Python,完全可定制,并且与大型语言模型和向量存储无关。

其直观的界面使得对 AI 构建模块的轻松操作成为可能,使开发人员能够快速制作原型,并将他们的想法转化为强大的、现实世界的解决方案。

Langflow 凭借其用户友好的界面和强大的功能,使开发人员能够快速制作原型并构建 AI 应用程序。无论您是经验丰富的 AI 开发人员还是刚刚起步,Langflow 都提供了将您的 AI 想法变为现实所需的工具。

可视化构建器

Langflow 是一个直观的可视化流程构建器。这种拖放式界面让开发人员无需编写大量代码即可创建复杂的 AI 工作流。您可以轻松连接不同的组件,例如提示、语言模型和数据源,以构建复杂的 AI 应用程序。

典型应用场景

Langflow可用于广泛的人工智能应用,包括:

- 制作智能聊天机器人

- 建立文档分析系统

- 生成引人注目的内容

- 编排多代理应用程序

环境准备与安装

安装uv

uv是一个非常快的Python包和项目管理器,用Rust编写。uv提供了一个独立的安装程序来下载和安装Uv:

macOs 或 linux

curl -LsSf https://astral.sh/uv/install.sh | sh

使用wget:

wget -qO- https://astral.sh/uv/install.sh | sh

创建虚拟环境

新建目录,进入目录,如langflow。不指定虚拟环境名称,则创建.venv虚拟环境:

uv venv

也可以指定名称或python版本:

uv venv my-name

uv venv --python 3.11

安装LangFlow

官方推荐使用uv在本地安装Langflow。

uv pip install langflow

启动LangFlow

uv run langflow run

在浏览器中访问http://127.0.0.1:7860,确认启动了本地Langflow实例。现在,Langflow正在运行,按照快速入门创建第一个示例应用。

入门AI应用示例

通过构建基于openai的聊天机器人应用程序来了解Langflow。在构造了聊天机器人之后,添加检索增强生成(Retrieval Augmented Generation, RAG)来与您自己的数据进行聊天。当然要先准备Deepseek API key。

打开Langflow并启动一个新项目

- 在Langflow仪表板中单击New Flow,然后选择Blank Flow。将打开一个空白工作区,您可以在其中构建流。

- 选择“基本提示”。

- 基本提示流创建完成。

构建基本提示词流程

要构建基本提示流程,请按照以下步骤操作:

- 点击“输入”,选择“聊天输入”组件,然后将其拖到画布上。聊天输入组件用于接收用户在聊天中的输入。

- 点击“提示”,选择“提示”组件,然后将其拖到画布上。“提示”组件将用户输入与用户定义的提示相结合。

- 点击“输出”,选择“聊天输出”组件,然后将其拖到画布上。聊天输出组件会将流程的输出打印到聊天中。

- 点击“模型”,选择“Deepseek”组件,然后将其拖到画布上。Deepseek 模型组件会将用户输入和提示发送到 DeepseekAPI,并接收响应。

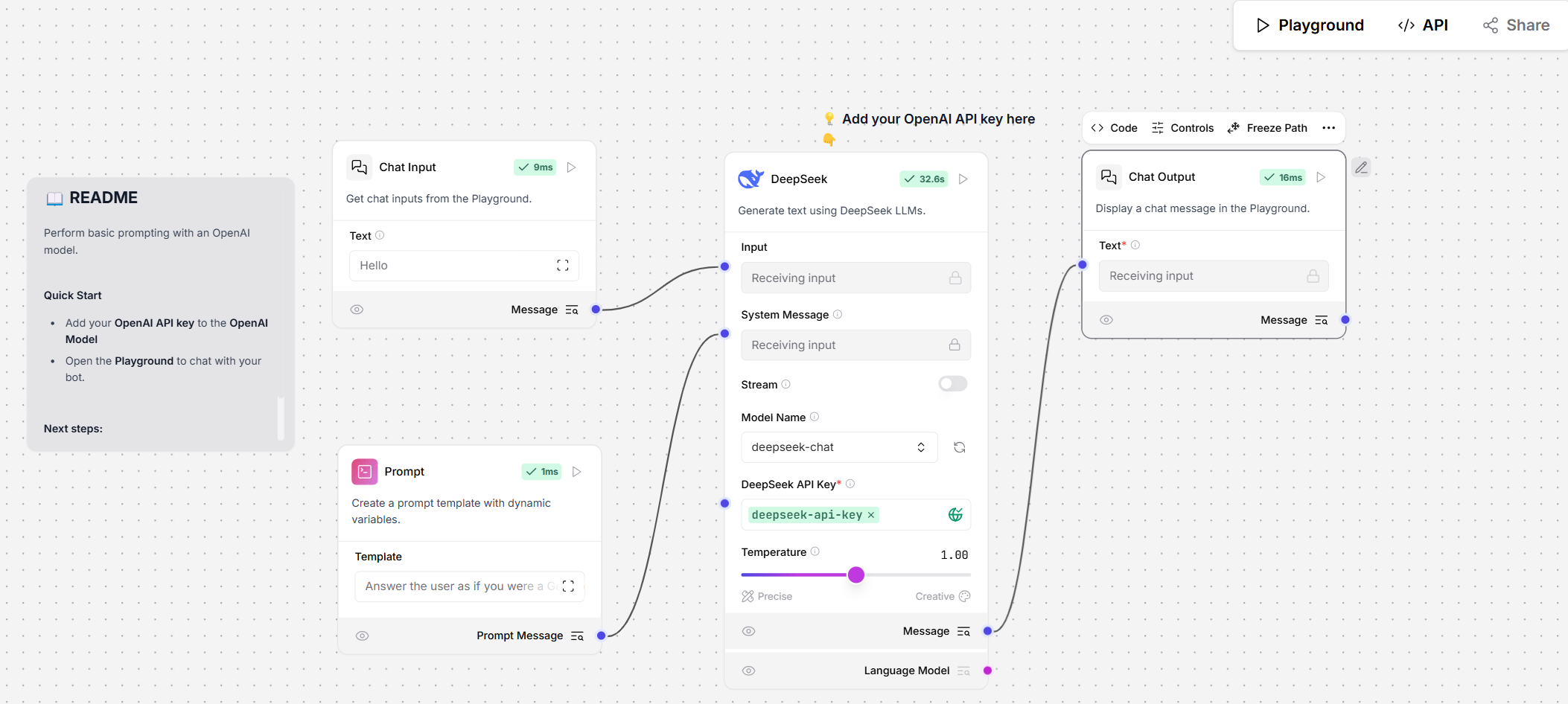

您现在应该有一个如下所示的流程:

由于这些组件之间没有连接,它们之间不会相互作用。您希望数据从聊天输入端口流向聊天输出端口,通过组件之间的连接实现这种流动。每个组件在其左侧接受输入,在右侧发送输出。鼠标悬停在连接端口上可查看该组件所接受的数据类型。有关组件输入和输出的更多信息,请参阅“组件概述”。

- 要将 Chat Input 组件与 OpenAI 模型组件相连接,请点击并拖动一条线,从蓝色的 Message 端口拖到 OpenAI 模型组件的 Input 端口。

- 要将 Prompt 组件与 Deepseek 模型组件相连接,请点击并拖动一条线,从蓝色的 Prompt Message 端口拖到 Deepseek模型组件的 System Message 端口。

- 要将 Deepseek 模型组件与聊天输出组件相连接,请点击并拖动一条线,从蓝色的“文本”端口拖到聊天输出组件的“文本”端口。

您的基本提示流程完成后的样子应该是这样的:

运行基本提示流程

将您的 Deepseek API 密钥添加到 Deepseek 模型组件中,并在提示组件中添加提示,以指示模型如何做出回应。

- 将您的凭证添加至 Deepseek 组件中。完成这些字段内容的最快方法是使用 Langflow 的全局变量。

- 在 Deepseek 组件的 Deepseek API 密钥字段中,点击地球按钮,然后点击添加新变量。或者,点击右上角的您的用户名,然后点击设置、全局变量,最后点击添加新变量。

- 为您的变量命名。将您的 Deepseek API 密钥(sk-…)粘贴到“值”字段中。

- 在“应用到字段”字段中,选择“OpenAI API 密钥”字段,以便将此变量应用于所有 OpenAI 嵌入组件。

-

若要在 Prompt 组件中添加提示信息,请点击模板字段,然后输入您的提示内容。该提示会引导机器人对输入做出回应。如果您不确定该如何操作,可以这样回答:回答用户时就好像您是精通生成式人工智能的专家一样,满怀热情地帮助他们开始构建全新的事物。

-

点击“Playground”以开启聊天会话。

-

输入查询内容,然后确保机器人根据您在“提示”组件中设置的提示做出回应。

您已成功在 Langflow 工作区中使用 OpenAI 创建了一个聊天机器人应用程序。

最后总结

- LangFlow核心特性

- 可视化编程:通过拖放组件(如提示、模型、数据源)构建AI工作流,无需大量编码。

- 灵活性与扩展性:支持多种大语言模型(如Deepseek)、自定义数据源,适配不同业务需求。

- 多场景适用:适用于聊天机器人、文档分析、内容生成及多智能体协作等任务。

- 环境配置与安装

- 依赖工具

uv(Rust编写的Python管理器),通过脚本一键安装。 - 使用命令行创建虚拟环境并安装LangFlow,启动后可通过浏览器访问本地实例(

http://127.0.0.1:7860)。

- 依赖工具

- 实战示例:构建AI聊天机器人

- 流程设计:依次添加“聊天输入”“提示”“Deepseek模型”“聊天输出”组件,通过连线定义数据流向。

- 配置关键参数:

- 设置Deepseek API密钥(通过全局变量管理,便于复用)。

- 自定义提示模板,规范模型回复风格(如以专家身份提供帮助)。

- 运行与测试:在Playground中输入查询,验证模型基于提示词流程的响应。

- 价值体现

- 降低AI开发门槛,加速从概念到原型的转化。

- 提供统一平台整合复杂AI模块,提升开发效率与可维护性。

结论:LangFlow凭借其可视化能力和灵活性,成为开发者探索AI应用的理想工具,尤其适合快速验证创意或部署轻量级解决方案。

850

850

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?