摘要:在本文中,我们提出了自注意生成对抗网络(SAGAN),它允许对图像生成任务进行注意力驱动的长期依赖关系建模。在低分辨率feature map中,传统的卷积GANs只根据空间局部点来生成高分辨率细节。在SAGAN中,可以使用来自所有特征位置的线索生成细节。此外,鉴别器还可以检查图像中较远部分的细节特征是否一致。此外,最近的工作表明,生成器影响GAN的表现,我们对G使用频谱归一化。达到了state of the art。

问题:有一些类别难以通过建模进行合成。GAN擅长于合成结构约束少的类别,难以捕捉几何和结构模式。

一个可能的解释是,以前的模型严重依赖卷积来对不同图像区域之间的依赖关系进行建模。

卷积操作主要处理邻近区域的信息,对图片中的远距离依赖难以进行有效建模。

本文提出Self-attention GAN使得g和d均可以对空间上间隔很远的区域进行关系建模。

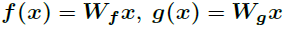

首先,隐含层特征分别映射到不同的特征空间f,g

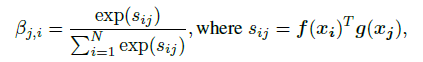

计算权重(模型在合成j区域的时候对i区域的关注程度)

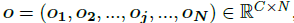

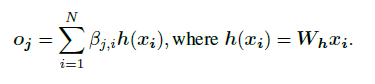

进一步,注意力层的输出为

其中:

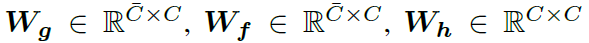

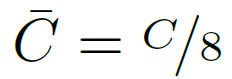

权重Wf,Wg,Wh进行卷积核大小为1*1的卷积操作

其中:

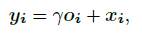

feature map每一块加上注意力map乘以尺度系数。

开始的y设置为0,这样网络可以更多关注邻近的区域,然后进一步将权重分配给非邻近的线索。

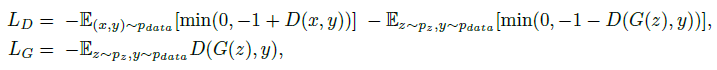

逐步的增加任务的复杂度。将注意力机制用在G和D上,通过对抗所示交替训练。

稳定GAN训练的方法

1.使用频谱归一化作用在G和D

2.双时间尺度更新规则,可以解决正则化D是训练缓慢的问题

1中,这样做通过限制每一层的频谱范数来约束鉴别器的Lipschitz常数,不需要额外训练超参数(实际中所有层的频谱范数设置为1)

2中,传统对于D的正则需要对D进行多次更新。在相同时间下得到更好的结果。

1866

1866

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?