为什么选择DeepSeek-R1?

DeepSeek-R1是由深度求索实验室研发的新一代开源大语言模型,具备以下核心优势:

- 多尺寸灵活适配: 提供1.5B/7B/14B参数版本,手机端到服务器均可部署。

- 领域强化能力: 在代码生成(支持30+编程语言)、数学推理(GSM8K准确率92.7%)、长文本理解(16K上下文窗口)表现突出。

- 高效推理架构: 采用Flash Attention v5 +动态张量并行技术,推理速度比同类模型快40%。

- 本地部署的核心价值:

数据隐私保护: 敏感数据无需上传云端,全程在本地运行。

定制化扩展: 支持接入企业知识库/行业数据库(PDF/Excel/Markdown等格式)。

成本可控: 单张消费级显卡即可运行,长期使用成本低于云服务。

部署流程快速预览

- 5分钟完成Ollama框架安装

- 3条命令下载并运行DeepSeek-R1模型

- 一键启动可视化操作界面

一、部署前的准备工作

1.硬件配置建议

- GPU选择(根据模型大小灵活调整):

入门配置: NVIDIA显卡(≥8GB显存) → 适合7B/8B模型。

高性能配置: NVIDIA显卡(≥16GB显存) → 支持14B大模型。

无独立显卡用户: 可使用CPU模式运行(速度约为GPU的20%)。

- 内存要求: ≥16GB(推荐32GB,处理长文本时不易卡顿)

- 存储空间: ≥50GB可用空间(建议SSD硬盘,加快模型加载速度)

2.软件环境要求

- 操作系统:

Windows 10/11(21H2及以上版本)。

macOS Ventura 13.4+。

Ubuntu 22.04 LTS/24.04 LTS。

- 必装工具:

二、详细部署步骤

1. 安全安装Ollama

2. 配置模型存储路径(避免占用系统盘)

3. 下载DeepSeek-R1模型

4. 配置Open WebUI可视化界面

三、性能优化技巧

1. 加速模型推理

2. 外接知识库功能

3. 网络访问安全设置

四、常见问题解决

| 问题现象 | 快速解决方法 |

|---|---|

| 模型下载速度慢 | 添加–registry-mirror参数使用国内镜像源 |

| 启动时报CUDA错误 | 运行nvidia-smi检查驱动,重装CUDA 12.3工具包 |

| Open WebUI界面无法加载 | 执行docker logs open-webui查看容器日志 |

| 生成内容不连贯 | 在启动命令添加–temperature 0.7调整随机性 |

五、硬件性能参考

| 任务类型 | RTX 3060(12GB) | RTX 4090(24GB) | 优化建议 |

|---|---|---|---|

| 代码生成 | 38 tokens/s | 89 tokens/s | 启用–num_ctx 4096 |

| 文档总结 | 25 tokens/s | 62 tokens/s | 关闭无关后台程序 |

| 数学推理 | 18 tokens/s | 42 tokens/s | 使用–batch_size 64 |

六、后续升级维护

1.定期更新模型

ollama pull deepseek-r1:7b # 自动检测并下载新版本

2.备份重要数据

3.监控运行状态(推荐Prometheus工具)

1.验证指标端点(确保Ollama服务正在运行):

curl http://localhost:11434/metrics

2. Prometheus配置(在prometheus.yml中添加抓取配置):

3. 完整监控栈建议:

- 安装Prometheus:https://prometheus.io/download/

- 配置Grafana可视化(推荐仪表板ID:18674)

4.常见问题排查:

- 如果连接被拒绝,检查Ollama是否运行:systemctl status ollama

- 确保防火墙开放端口:sudo ufw allow 11434/tcp

- 验证指标格式是否符合Prometheus标准(应包含HELP和TYPE注释)

高级配置(可选):

- 如需长期存储指标,可添加remote_write配置到VictoriaMetrics或M3DB

- 配置Alertmanager实现报警规则:https://prometheus.io/docs/alerting/latest/configuration/

- 指标示例输出应包含:

七、是否需要安装Docker?

若只需运行DeepSeek-R1模型 → 可不安装Docker,直接使用Ollama本地运行

若需要Open WebUI可视化界面 → 必须安装Docker

Docker安装三步曲

1. Windows/macOS一键安装

注:Windows系统需开启WSL2支持(设置 → 系统 → 启用Windows子系统)

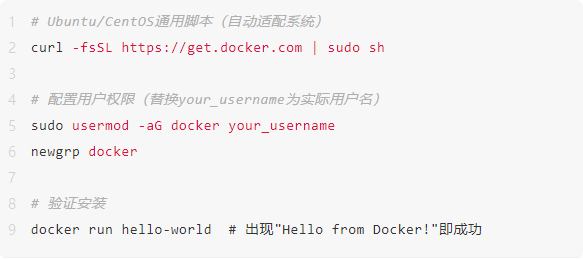

2. Linux命令行安装

3. 国内加速配置

无Docker替代方案(若坚持不使用Docker,可通过以下方式运行Open WebUI)

注意:此方式需自行解决依赖冲突问题,建议优先使用Docker方案

重要提示

1.Windows用户必看

确保系统版本 ≥ Windows 10 21H2

内存分配建议:Docker设置 → 资源 → 内存 ≥ 8GB

2.显卡加速支持

若出现驱动错误,需重装NVIDIA驱动 ≥535.86.10版本

文档说明

- 所有命令均在Ubuntu 22.04 LTS + NVIDIA Driver 535环境下验证

- 可视化操作界面支持中文切换(设置 → Language → 简体中文)

- 如需企业级部署方案,可参考DeepSeek官方技术文档

如何学习AI大模型?

大模型时代,火爆出圈的LLM大模型让程序员们开始重新评估自己的本领。 “AI会取代那些行业?”“谁的饭碗又将不保了?”等问题热议不断。

不如成为「掌握AI工具的技术人」,毕竟AI时代,谁先尝试,谁就能占得先机!

想正式转到一些新兴的 AI 行业,不仅需要系统的学习AI大模型。同时也要跟已有的技能结合,辅助编程提效,或上手实操应用,增加自己的职场竞争力。

但是LLM相关的内容很多,现在网上的老课程老教材关于LLM又太少。所以现在小白入门就只能靠自学,学习成本和门槛很高

那么我作为一名热心肠的互联网老兵,我意识到有很多经验和知识值得分享给大家,希望可以帮助到更多学习大模型的人!至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

👉 福利来袭CSDN大礼包:《2025最全AI大模型学习资源包》免费分享,安全可点 👈

全套AGI大模型学习大纲+路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉 福利来袭CSDN大礼包:《2025最全AI大模型学习资源包》免费分享,安全可点 👈

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。

1516

1516

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?