概要

《Self-supervised Equivariant Attention Mechanism for Weakly Supervised Semantic Segmentation》论文阅读

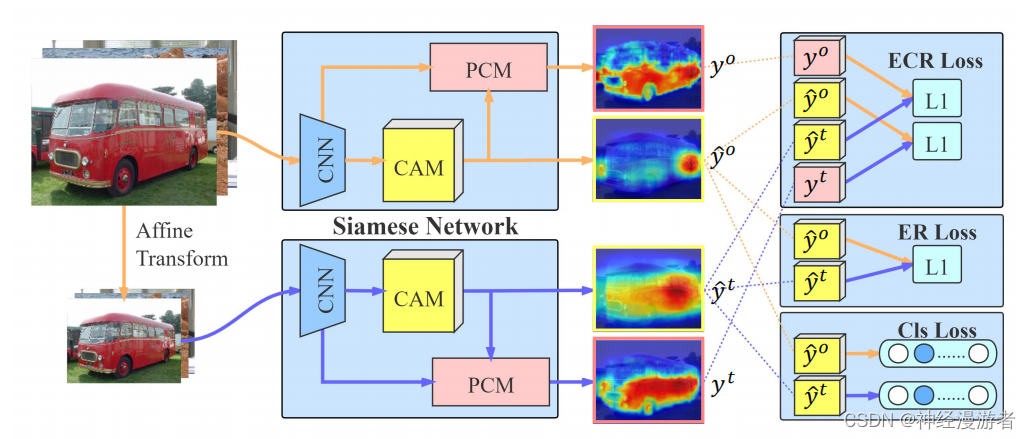

整体架构流程

在基于弱监督的语义分割任务中,CAM常常作为初始的分割标签使用。但由于CAM是通过分类网络训练得到的,只关注那些易于分类的区域,而不是全部的分割区域,因此CAM难以作为精确的分割标签。

一、解决问题

对应强监督分割任务来说,如果输入图像经过仿射变换,那么分割标签页应该进行相同的放射变换。而对于弱监督分割任务来说,需要依赖分类模型产生CAM分割标签,因此这种性质也应该被保持。

二、主要贡献

1、提出了一个孪生网络网络,分别接受原始图像和仿射变换后的图像,两个子网络共享权重。

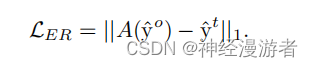

2、将原始图像生成的CAM进行放射变换与经过仿射变换生成的CAM之间计算损失,通过这个损失函数来约束网络保持上述性质

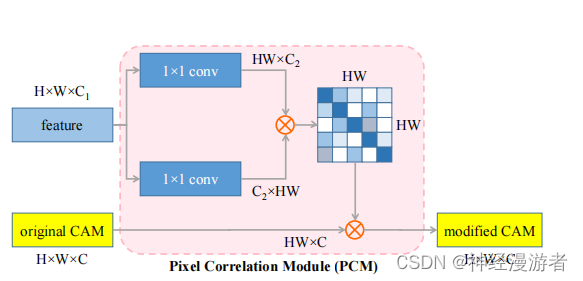

3、在子网络中提出了一个PCM模块,该模块通过注意力机制融合了CAM和CNN浅层特征,增强了CAM

三、解决方法

#

#

四、知识补充

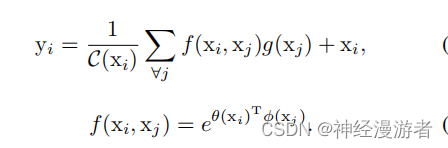

1、注意力机制的使用

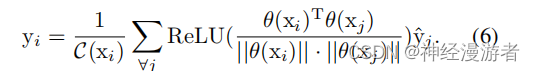

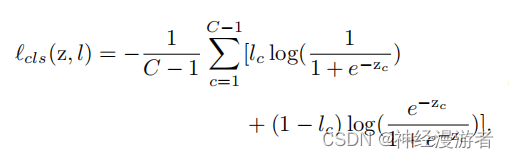

2、损失函数的设计

五、总结和启发

1、为了使得网络保持某种性质或约束,可以设计对应的损失函数

2、让网络保持某种性质或约束,实际上给模型提供先验知识,让模型更容易优化到合适的参数。

3、注意力机制,可以融合不同的特征

4519

4519

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?