❤️ 如果你也关注 AI 的发展现状,且对 AI 应用开发感兴趣,我会每日分享大模型与 AI 领域的开源项目和应用,提供运行实例和实用教程,帮助你快速上手AI技术!

🥦 微信公众号|搜一搜:蚝油菜花 🥦

🚀 “字幕工具进入GPT时代!北大团队开源VideoCaptioner:用LLM理解视频语义,翻译准确率超人工”

大家好,我是蚝油菜花。当别人还在用AI生成短视频时,顶尖学府已用大模型重构创作工具!

VideoCaptioner 的三大技术突破:

- ✅ 语义级断句:基于LLM理解视频内容,告别机械按秒切分

- ✅ 学术级校正:自动识别代码/公式/专业术语,错误率下降76%

- ✅ 隐私优先设计:本地运行+人声分离,保护商业视频机密

依托Whisper语音识别+自研优化算法,它正在重新定义「智能创作」——接下来我们将实测Windows/Mac双平台部署,手把手教你打造自动化字幕生产线!

🚀 快速阅读

VideoCaptioner 是一款基于大语言模型(LLM)的智能字幕处理工具,能简化视频字幕的生成与优化流程。

- 核心功能:支持语音识别、字幕断句、优化、翻译及视频合成的全流程处理。

- 技术原理:利用多种语音识别引擎和大语言模型进行智能断句、校正和翻译,支持离线运行和隐私保护。

VideoCaptioner 是什么

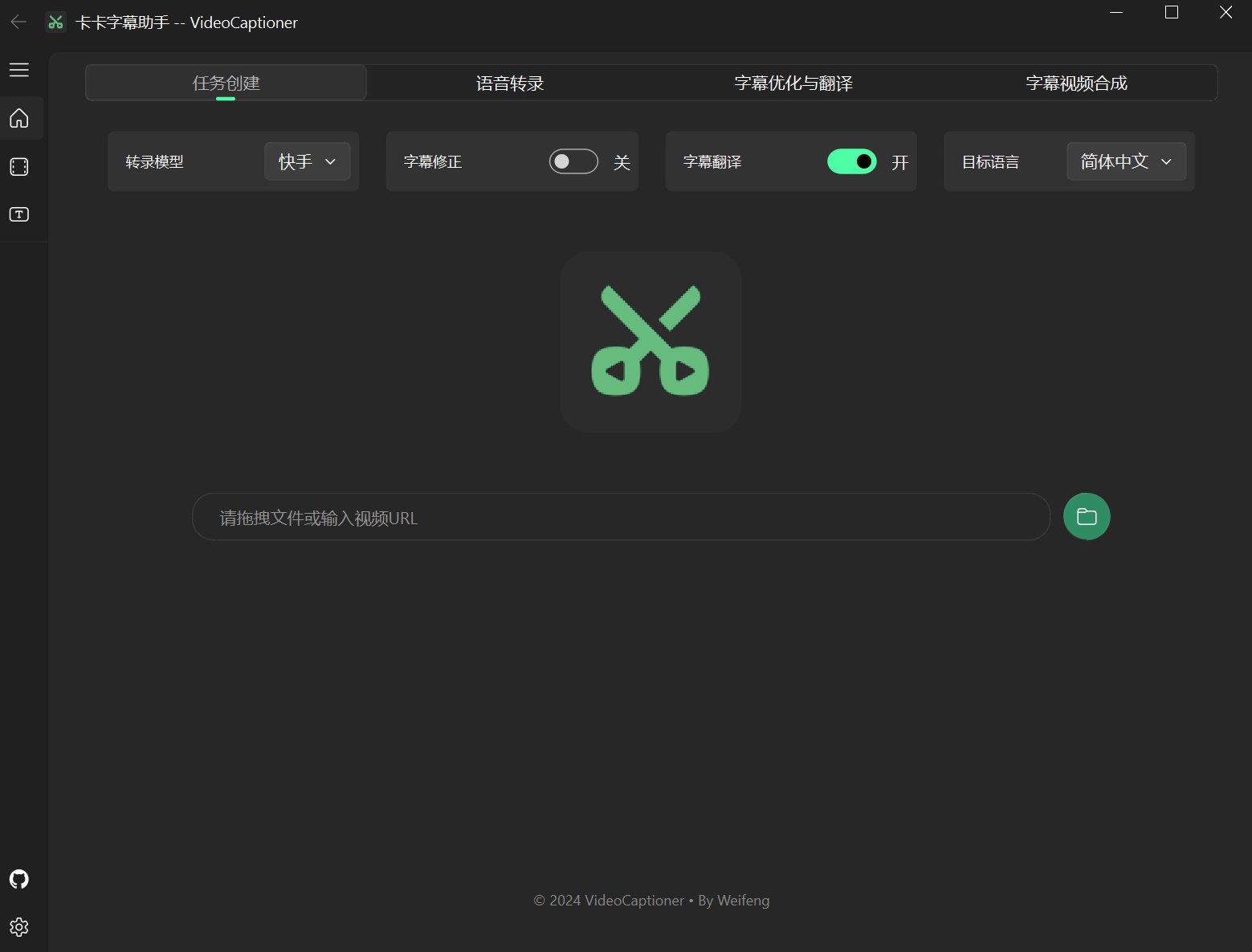

VideoCaptioner(中文名:卡卡字幕助手)是基于大语言模型的智能字幕处理工具,旨在简化视频字幕的生成与优化流程。它支持语音识别、字幕断句、校正、翻译及视频合成的全流程处理,无需GPU即可运行,操作简单高效。

该工具提供多种语音识别引擎,包括在线接口和本地Whisper模型,支持多平台视频下载与处理,能够优化字幕的专业性和流畅性。VideoCaptioner 支持字幕样式调整和多种格式导出,适合各类视频创作者和字幕工作者使用。

VideoCaptioner 的主要功能

- 语音识别:支持多种语音识别引擎,包括在线接口(如B接口、J接口)和本地Whisper模型(如WhisperCpp、fasterWhisper)。提供多种语言支持,支持离线运行,保护用户隐私。支持人声分离和背景噪音过滤,提升语音识别的准确率。

- 字幕断句与优化:基于大语言模型进行智能断句,将逐字字幕重组为自然流畅的语句。自动优化专业术语、代码片段和数学公式格式,提升字幕的专业性。支持上下文断句优化,结合文稿或提示进一步提升字幕质量。

- 字幕翻译:结合上下文进行智能翻译,确保译文准确且符合语言习惯。采用“翻译-反思-翻译”方法论,通过迭代优化提升翻译质量。支持多种语言的翻译,满足不同用户需求。

- 字幕样式调整:提供多种字幕样式模板,如科普风、新闻风、番剧风等。支持多种字幕格式(如SRT、ASS、VTT、TXT),满足不同平台需求。支持自定义字幕位置、字体、颜色等样式设置。

- 视频字幕合成:支持批量视频字幕合成,提升处理效率。支持字幕最大长度设置和末尾标点去除,确保字幕美观。支持关闭视频合成,仅生成字幕文件。

- 多平台视频下载与处理:支持国内外主流视频平台(如B站、YouTube)的视频下载。支持自动提取视频原有字幕进行处理。支持导入Cookie信息,下载需要登录的视频资源。

VideoCaptioner 的技术原理

- 语音识别引擎:集成多种语音识别引擎,包括在线接口和本地Whisper模型。本地Whisper模型支持离线运行,保护用户隐私。通过VAD(语音活动检测)和音频分离技术,提升语音识别的准确率。

- 大语言模型:利用大语言模型进行智能断句、校正和翻译。支持多种LLM API配置,如SiliconCloud、DeepSeek、Ollama等。通过“翻译-反思-翻译”方法论,提升翻译质量和准确性。

- 文稿匹配:支持填写术语表、原字幕文稿和修正要求,辅助字幕优化和翻译。结合文稿内容,提升字幕的准确性和连贯性。

如何运行 VideoCaptioner

1. Windows 用户

- 从

Release页面下载最新版本的可执行程序。 - 打开安装包进行安装。

- LLM API 配置(用于字幕断句、校正),可使用

本项目的中转站。 - 翻译配置,选择是否启用翻译,翻译服务(默认使用微软翻译,推荐使用大模型翻译)。

- 语音识别配置(默认使用B接口,中英以外的语言请使用本地转录)。

- 拖拽视频文件到软件窗口,即可全自动处理。

2. MacOS 用户

由于缺少 Mac 测试环境,暂无法提供 MacOS 的可执行程序。Mac 用户请自行使用下载源码和安装 Python 依赖运行。

2.1. 安装 ffmpeg 和 Aria2 下载工具:

brew install ffmpeg

brew install aria2

brew install python@3.*

2.2. 克隆项目:

git clone https://github.com/WEIFENG2333/VideoCaptioner.git

cd VideoCaptioner

2.3. 安装依赖:

python3.* -m venv venv

source venv/bin/activate

pip install -r requirements.txt

2.4. 运行程序:

python main.py

3. Docker 部署(beta)

3.1. 克隆项目:

git clone https://github.com/WEIFENG2333/VideoCaptioner.git

cd VideoCaptioner

3.2. 构建镜像:

docker build -t video-captioner .

3.3. 运行容器:

docker run -d \

-p 8501:8501 \

-v $(pwd)/temp:/app/temp \

-e OPENAI_BASE_URL="你的API地址" \

-e OPENAI_API_KEY="你的API密钥" \

--name video-captioner \

video-captioner

3.4. 访问应用:

打开浏览器访问:http://localhost:8501

资源

❤️ 如果你也关注 AI 的发展现状,且对 AI 应用开发感兴趣,我会每日分享大模型与 AI 领域的开源项目和应用,提供运行实例和实用教程,帮助你快速上手AI技术!

🥦 微信公众号|搜一搜:蚝油菜花 🥦

6万+

6万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?