机器学习中常用的优化方法.................MARK.....................持续更新

写在最前面:这篇文章是所有常见优化方法的一个总结,因此你看起来可能会很乱,我已经把一些比较好的文章都在每部分提出(红色链接),读者可以先参考一下这些文章再来看本文。参考文章写的都很清晰。

梯度下降法:

1.随机梯度下降法(每次只选取一个样本来代替当前的梯度值)

2.批量梯度下降法(每次选取m个样本来代替当前梯度值)

3.梯度下降法(选取所有样本值来计算梯度值)

总结:利用梯度下降法进行优化时,梯度值的计算是和样本有关的,因此,原始的梯度下降法需要计算所有样本的值才能够得出梯度,计算量大,所以后面才有会一系列的改进。

参考文章:http://blog.sina.com.cn/s/blog_6bb07f8301017bot.html

牛顿法:

牛顿法其实原理很简单,利用的是:求函数f的极大极小问题,可以转化为求解函数f的导数f'=0的问题,这样求可以把优化问题看成方程求解问题(f'=0)。

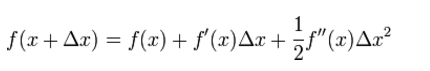

所以考虑f(x)的泰勒展开:

取后面两项,然后令它们为0。

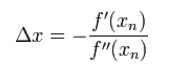

化简之后可以得到

本文总结了机器学习中常见的优化算法,包括梯度下降法(GD)、随机梯度下降法(SGD)、随机平均梯度(SAG)、SVRG(Stochastic Variance Reduced Gradient)和BFGS(Broyden-Fletcher-Goldfarb-Shanno)算法。内容涵盖了这些方法的基本原理、优缺点以及改进思路,并提供了相关参考资料链接。

本文总结了机器学习中常见的优化算法,包括梯度下降法(GD)、随机梯度下降法(SGD)、随机平均梯度(SAG)、SVRG(Stochastic Variance Reduced Gradient)和BFGS(Broyden-Fletcher-Goldfarb-Shanno)算法。内容涵盖了这些方法的基本原理、优缺点以及改进思路,并提供了相关参考资料链接。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

9793

9793

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?