知乎:Beyond Hsueh

链接:https://www.zhihu.com/question/665735775/answer/3611972970

推荐一篇 ICLR 2023 的文章:Semantic Uncertainty: Linguistic Invariances for Uncertainty Estimation in Natural Language Generation 。虽然这篇完成投稿时还没到大模型的爆发点,但我第一次读到这篇文章时就该研究意义不凡,当时就在好几个论文分享上推荐了这篇文章,果不其然今年看到相关研究成果发表在Nature上了 Detecting hallucinations in large language models using semantic entropy | Nature,也是引起了不小的轰动。如果未来语言学、信息论和深度学习实现大融合的话,那么这篇文章当为开山之作。

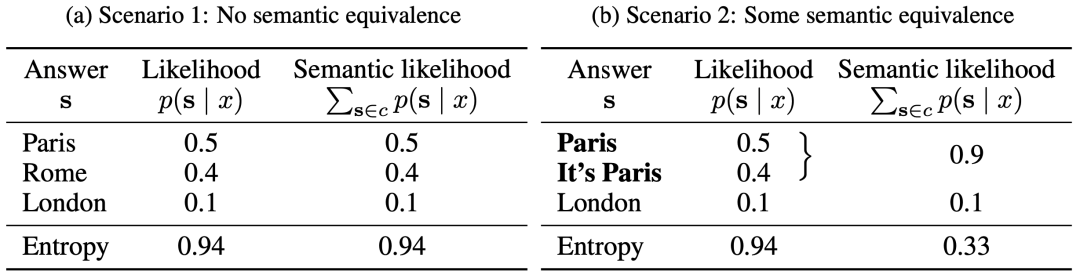

简单介绍一下,这篇文章提出一个很新颖的概念:语义熵(semantic entropy)。现在很多研究都认为大模型的幻觉或事实错误,均来自于最大似然概率的训练方式,即这种训练范式只是在学习拟合给定文本的下一个最可能出现的词,即最大化的预测概率,本质上是在做词预测,很难说是否学习到真正的语义信息,比如对同一个输入语句“法国的首都在哪?”,模型无论回答“巴黎”还是“法国的首都是巴黎”,都会认为是正确的,但对于模型来说,在输出空间这就是两个不同的序列,这也就引出下面模型不确定性度量的问题。大模型的不确定性对于衡量模型输出是否可靠很重要,此前工作在度量大模型不确定性时,会针对一个输入序列采样 k 个输出,把其中相同的输出序列聚类后,再计算所有输出的熵值。然而,对于上面的情况,我们应该把“巴黎”还是“法国的首都是巴黎”都聚为同类,因为针对同一个问题这两个回答的语义是等价的,因此这篇文章提出语义熵的概念。

文章先是阐述了生成模型的不确定性度量可能遇到的困难,首先就是模型输出有很多语义相同的序列,这往往需要进一步的判断,与分类模型单个输出不同,生成模型的输出空间几乎无法衡量,假设词表为,那么长度为 n 的序列输出空间为,随长度 n 呈指数级增长,并且这个 n 还不是一个定值,即输出序列长度是可变的,进一步增加了度量的难度。

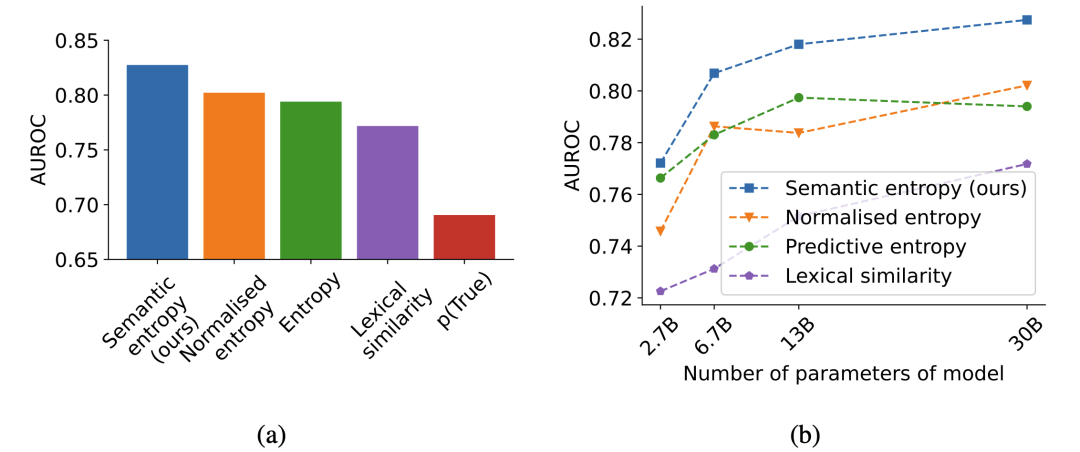

因此,文章提出了语义熵的概念,只关注语义信息,在计算不确定性时,把语义相同的句子分为一类,比如对问题“法国的首都在哪?”采样十次,有五次生成“巴黎”,四次生成“这是巴黎”,一次生成“伦敦”,传统方法会分别计算这三个序列的概率再计算熵值,而语义熵则会把“巴黎”和“这是把巴黎”聚为同一类,然后计算熵值,这样得到的熵值将会比传统方法可靠很多。聚类的时候引入了一个自然语言推断(NLI)模型来判断两个语句是否为语义等价。使用可靠性指标 AUROC衡量,语义熵比其他方法都更加可靠。

由于初次完成并非在大模型时代,文章并未在 ChatGPT、LLaMA 等模型上做实验,而这种语义等价以及不等价的二分类判断显然也太过简单,以及这种更可靠的熵值能否有更多实际应用,本文均未作探究。不过我觉得这篇文章最大的亮点在于从语义角度考虑生成模型的输出问题,也是首个尝试在语义空间给大模型输出建模的工作,提出的“语义熵”概念更是在语言学、信息论和深度学习之间搭了一座桥梁,并且文章方法并不复杂,很容易理解。很快便有一批更细粒度的度量语义相似性,在语义空间建模的工作相继问世,简单列几篇我看过的

Kernel Language Entropy: Fine-grained Uncertainty Quantification for LLMs from Semantic Similarities

Generating with Confidence: Uncertainty Quantification for Black-box Large Language Models

Kernel Language Entropy: Fine-grained Uncertainty Quantification for LLMs from Semantic Similarities

INSIDE: LLMs' Internal States Retain the Power of Hallucination Detection

现在利用大模型不确定性或置信度检测幻觉逐渐成为主流,这篇文章提出的“语义熵“概念也一定会产生更深远影响。

备注:昵称-学校/公司-方向/会议(eg.ACL),进入技术/投稿群

id:DLNLPer,记得备注呦

279

279

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?