在人的感知系统所获得的信息中,视觉信息大约占到80%~85%。行人重识别(person re-identification)是近几年智能视频分析领域兴起的一项新技术,属于在复杂视频环境下的图像处理和分析范畴,是许多监控和安防应用中的主要任务,并且在计算机视觉领域获得了越来越多的关注。下面我们就仔细来聊聊行人重识别(ReID)。

1.什么是行人重识别

2.行人重识别研究的背景、意义及现状

3.行人重识别的应用和目前存在的问题

4.行人重识别目前所采用的方法

5.行人重识别数据集

6.行人重识别的评价指标

7.行人重识别测试

1.什么是行人重识别

行人重识别(Person Re-identification也称行人再识别,简称为ReID,是利用计算机视觉技术判断图像或者视频序列中是否存在特定行人的技术;或者说,行人重识别是指在已有的可能来源与非重叠摄像机视域的视频序列中识别出目标行人。广泛被认为是一个图像检索的子问题。给定一个监控行人图像,检索跨设备下的该行人图像。在监控视频中,由于相机分辨率和拍摄角度的缘故,通常无法得到质量非常高的人脸图片。当人脸识别失效的情况下,ReID就成为了一个非常重要的替代品技术。ReID有一个非常重要的特性就是跨摄像头,所以学术论文里评价性能的时候,是要检索出不同摄像头下的相同行人图片。ReID已经在学术界研究多年,但直到最近几年随着深度学习的发展,才取得了非常巨大的突破。2.行人重识别研究的背景、意义及现状

我们先以一个小故事来说明一下:荷马史诗 (Odyssey iv:412),Mennelaus 被告知,如果想要众神息怒并平安回家,就要在特洛伊战争的回家路上抓到 Proteus,让他告诉自己躲避的方法。虽然Proteus变成了狮子,巨蛇,豹,甚至水和大树,Mennelaus最终还是在海边的海豹群中抓住了他,并知晓了自己平安回家的方法。这大概是最早的重识别的成功案例。相对于行人检测来说,行人重识别的研究还不算成熟,但早在1996年,就有学者关注行人重识别问题,在2006年,行人重识别的概念第一次在CVPR上提出后,相关的研究不断涌现。2007年Gray提出一个对于行人重识别的研究具有重大意义的数据库VIPeR。此后越来越多的学者开始关注行人重识别的研究。图1是ReID从1997年到2016年间几个里程碑的发展事件。

3.行人重识别的应用和目前存在的问题

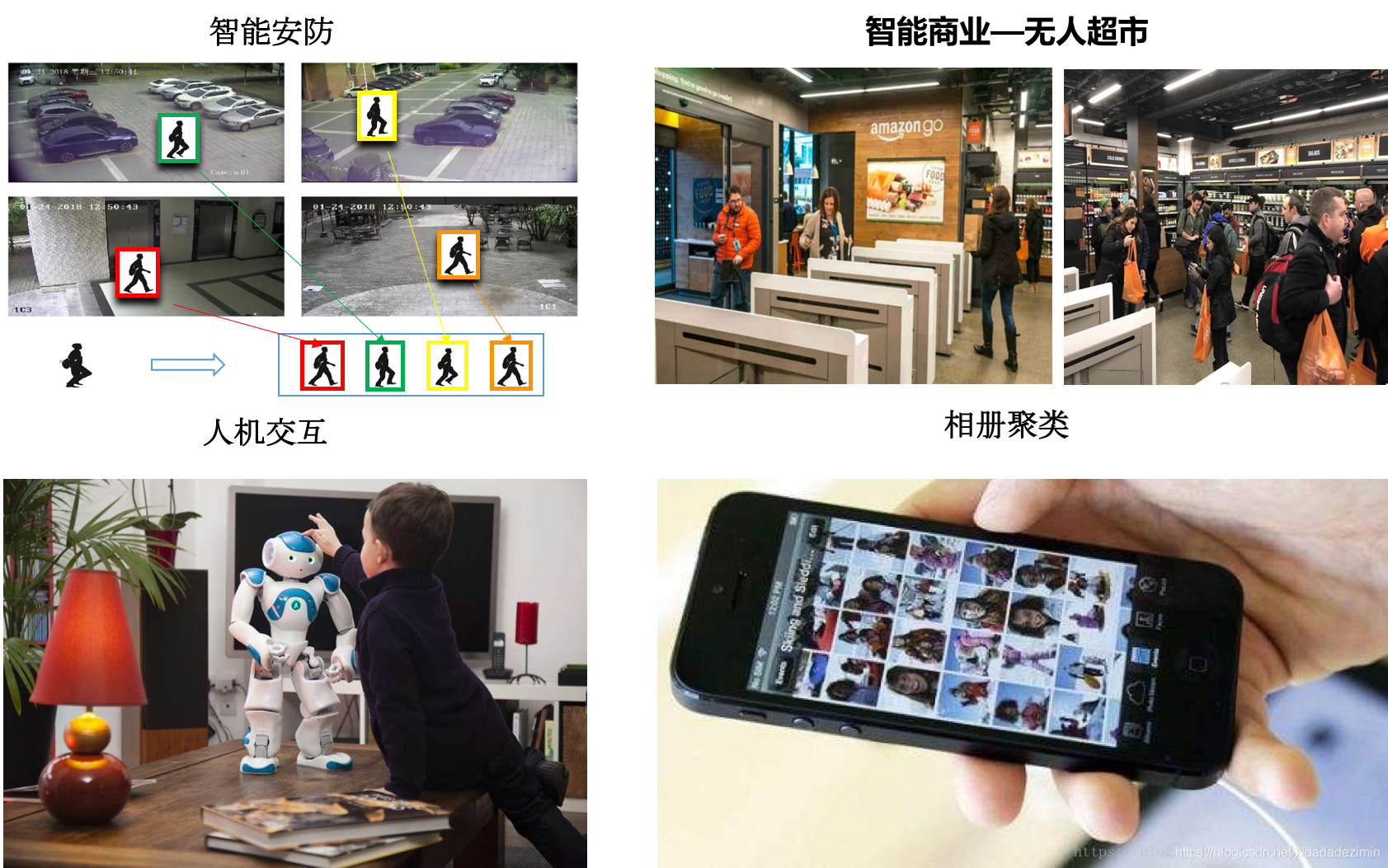

3.1 图3是ReID在显示场景中的几个例子。

3.2 由于存在这上述的问题那么我们是否可以考虑从其他方向来ReID

1. 能不能用人脸识别做重识别? 理论上是可以的。但是有两个原因导致人脸识别较难应用:首先,广泛存在后脑勺和侧脸的情况,做正脸的人脸识别难。其次,摄像头拍摄的像素可能不高,尤其是远景摄像头里面人脸截出来很可能都没有32x32的像素。所以人脸识别在实际的重识别应用中很可能有限。

2. 有些人靠衣服的颜色就可以判断出来了,还需要行人重识别么? 衣服颜色确实是行人重识别 做出判断一个重要因素,但光靠颜色是不足的。首先,摄像头之间是有色差,并且会有光照的影响。其次,有撞衫(颜色相似)的人怎么办,要找细节,但比如颜色直方图这种统计的特征就把细节给忽略了。在多个数据集上的测试表明,光用颜色特征是难以达到50%的top1正确率的。

3. 使用图像检索的指标来衡量行人重识别的结果是否合适? 在早期,行人重识别数据集是由两个摄像头采集的比如viper,每个query只有一个正确的retrieval目标。所以往往使用top1比较。但在近期,随着大数据集的提出,数据集中往往包含多个摄像头的多个正确目标。光使用top1的话,不能反应模型的真实能力。所以类似图像检索,重识别加入了mAP作为衡量标准,将top2,top3...topn都考虑进去。

4.行人重识别目前所采用的方法

行人重识别算法我们将从以下五各方面来叙述:①基于表征学习的ReID方法: 基于表征学习(Representation learning)的方法是一类非常常用的行人重识别方法。这主要得益于深度学习,尤其是卷积神经网络(Convolutional neural network, CNN)的快速发展。由于CNN可以自动从原始的图像数据中根据任务需求自动提取出表征特征(Representation),所以有些研究者把行人重识别问题看做分类(Classification/Identification)问题或者验证(Verification)问题:

(1)分类问题是指利用行人的ID或者属性等作为训练标签来训练模型;(2)验证问题是指输入一对(两张)行人图片,让网络来学习这两张图片是否属于同一个行人。

利用Classification/Identification loss和verification loss来训练网络,其网络示意图如下图5所示。网络输入为若干对行人图片,包括分类子网络(Classification Subnet)和验证子网络(Verification Subnet)。分类子网络对图片进行ID预测,根据预测的ID来计算分类误差损失。验证子网络融合两张图片的特征,判断这两张图片是否属于同一个行人,该子网络实质上等于一个二分类网络。经过足够数据的训练,再次输入一张测试图片,网络将自动提取出一个特征,这个特征用于行人重识别任务。

基于特征表示的方法重点在于设计鲁棒可靠的行人图像特征表示模型,即能够区分不同行人,同时能够不受光照和视角变化的影响,将其主要分为以下几类进行介绍, 典型特征总结见表1。

1)底层视觉特征:这种方法基本上都是将图像划分成多个区域,对每个区域提取多种不同的底层视觉特征,组合后得到鲁棒性更好的特征表示形式。最常用的就是颜色直方图,多数情况下行人的衣服颜色结构简单,因此颜色表示是有效的特征,通常用RGB、HSV直方图表示。把RGB空间的图像转化成HSL和YCbCr颜色空间,观察对数颜色空间中目标像素值的分布,颜色特征在不同光照或角度等行人识别的不适环境中具有一定的不变性。以及局部特征,如局部不变特征–尺度不变特征变换(scale-invariant feature transform,SIFT),SURF和Covariance描述子ELF(ensemble of localized features)方法中,结合RGB、YCbCr、HS颜色空间的颜色直方图,具有旋转不变性的Schmid和Gabor滤波器计算纹理直方图。还有纹理特征、Haar-like Represention、局部二值模式(LBP)、Gabor滤波器、共生矩阵(Co-occurrence Matrics)。

1)底层视觉特征:这种方法基本上都是将图像划分成多个区域,对每个区域提取多种不同的底层视觉特征,组合后得到鲁棒性更好的特征表示形式。最常用的就是颜色直方图,多数情况下行人的衣服颜色结构简单,因此颜色表示是有效的特征,通常用RGB、HSV直方图表示。把RGB空间的图像转化成HSL和YCbCr颜色空间,观察对数颜色空间中目标像素值的分布,颜色特征在不同光照或角度等行人识别的不适环境中具有一定的不变性。以及局部特征,如局部不变特征–尺度不变特征变换(scale-invariant feature transform,SIFT),SURF和Covariance描述子ELF(ensemble of localized features)方法中,结合RGB、YCbCr、HS颜色空间的颜色直方图,具有旋转不变性的Schmid和Gabor滤波器计算纹理直方图。还有纹理特征、Haar-like Represention、局部二值模式(LBP)、Gabor滤波器、共生矩阵(Co-occurrence Matrics)。

2)中层语义属性:可以通过语义信息来判断两张图像中是否属于同一行人,比如颜色、衣服以及携带的包等信息。相同的行人在不同视频拍摄下,语义属性很少变化。有的采用15种语义来描述行人,包括鞋子、头发颜色长短、是否携带物品等,分类器用SVM定义每幅行人图像的以上语义属性。结合语义属性重要性加权以及与底层特征融合,最终描述行人图像。对图像超像素划分,最近分割算法对图像块定义多种特征属性,颜色、位置和SIFT特征,效果有提高。

3)高级视觉特征:特征的选择技术对行人再识别的识别率的性能进行提升,如Fisher向量[编码;提取颜色或纹理直方图,预先定义块或条纹形状的图像区域;或者编码区域特征描述符来建立高级视觉特征。用某种描述符对密集轨迹、纹理、直方图进行编码,突出重要信息。受到多视角行为识别研究和Fisher向量编码的影响,一种捕获软矩阵的方法,即DynFV(dynamic fisher vector)特征和捕获步态和移动轨迹的Fisher向量编码的密集短轨迹时间金字塔特征被提出。Fisher向量编码方法是首先用来解决大尺度图像分类的方法,也能改善行为识别的性能。有的对行人的每个图像分成6个水平条带,在每个条带上计算纹理和颜色直方图。在YCbCr、HSV、白化的RGB颜色空间计算直方图建立颜色描述符,并用local fisher disrciminant analysis(LFDA)降维。学习出的矩阵把特征转换到新的空间,LFDA能在嵌入过程中使特征的局部结构适用于图像遮挡,背景变化和光照变化的情况,最后把计算变换空间中的特征向量的均值作为这个行人最终的特征向量表示。T. Matsukawa提出GOG(Gaussian Of Gaussian),把一幅图像分成水平条带和局部块,每个条带用一个高斯分布建模。每个条带看作一系列这样的高斯分布,然后用一个单一的高斯分布总体表示。GOG特征提取的方法好表现在用像素级特征的一个局部高斯分布来描述全局颜色和纹理分布,并且GOG是局部颜色和纹理结构的分层模型,可以从一个人的衣服的某些部分得到。此外,深度学习也被应用于行人重识别的特征提取中,在AlexNet-Finetune中,开始在ImageNet数据集上预训练的基于AlexNet结构的CNN,并用这个数据集对数据进行微调。在微调过程中,不修改卷积层的权重,训练后两个全连接层。McLaughlin等采用了类似的方法,对图像提取颜色和光流特征,采用卷积神经网络(CNN)处理得到高层表征,然后用循环神经网络(RNN)捕捉时间信息,然后池化得到序列特征。T对来自各个领域的数据训练出同一个卷积神经网络(CNN),有些神经元学习各个领域共享的表征,而其他的神经元对特定的某个区域有效,得到鲁棒的CNN特征表示。

②基于度量学习的ReID方法:度量学习(Metric learning)是广泛用于图像检索领域的一种方法。不同于特征学习,度量学习旨在通过网络学习出两张图片的相似度。在行人重识别问题上,具体为同一行人的不同图片相似度大于不同行人的不同图片。最后网络的损失函数使得相同行人图片(正样本对)的距离尽可能小,不同行人图片(负样本对)的距离尽可能大。常用的度量学习损失方法有 对比损失(Contrastive loss)、 三元组损失(Triplet loss)、 四元组损失(Quadruplet loss)、 难样本采样三元组损失(Triplet hard loss with batch hard mining, TriHard loss)。

首先,假如有两张输入图片

I

1

{I_1}

I1和

I

2

{I_2}

I2,通过网络我们可以得到他们的特征

f

I

1

{f_{{I_1}}}

fI1和

f

I

2

{f_{{I_2}}}

fI2。我们定义这两张图片特征向量的欧式距离为:

d

I

1

,

I

2

=

∥

f

I

1

−

f

I

1

∥

2

{d_{{I_1},{I_2}}} = {\left\| {{f_{{I_1}}} - {f_{{I_1}}}} \right\|_2}

dI1,I2=∥fI1−fI1∥2

1)对比损失(Contrastive loss)

对比损失用于训练孪生网络(Siamese network),其结构图如上图6所示。孪生网络的输入为一对(两张)图片

x

1

{x_1}

x1和

x

2

{x_2}

x2,这两张图片可以为同一行人,也可以为不同行人。每一对训练图片都有一个标签

y

y

y,其中

y

=

1

y = 1

y=1,表示两张图片属于同一个行人(正样本对),反之

y

=

0

y = 0

y=0表示它们属于不同行人(负样本对)。之后,对比损失函数写作:

L

c

=

y

E

w

2

+

(

1

−

y

)

(

α

−

E

w

)

+

2

{L_c} = yE_w^2 + (1 - y)(\alpha - {E_w})_ + ^2

Lc=yEw2+(1−y)(α−Ew)+2,其中

E

w

=

∥

G

w

(

x

1

)

−

G

w

(

x

2

)

∥

{E_w} = \left\| {{G_w}({x_1}) - {G_w}({x_2})} \right\|

Ew=∥Gw(x1)−Gw(x2)∥

其中

(

z

)

+

{(z)_ + }

(z)+表示

max

(

z

,

0

)

\max (z,0)

max(z,0),

α

\alpha

α是根据实际需求设计的阈值参数。为了最小化损失函数,当网络输入一对正样本对,

E

w

{E_w}

Ew会逐渐变小,即相同ID的行人图片会逐渐在特征空间形成聚类。反之,当网络输入一对负样本对时,

E

w

{E_w}

Ew 会逐渐变大直到超过设定的

α

\alpha

α,通过最小化

L

c

{L_c}

Lc,最后可以使得正样本对之间的距离逐渐变小,负样本对之间的距离逐渐变大,从而满足行人重识别任务的需要。

(2)三元组损失(Triplet loss):三元组损失是一种被广泛应用的度量学习损失,之后的大量度量学习方法也是基于三元组损失演变而来。顾名思义,三元组损失需要三张输入图片。和对比损失不同,一个输入的三元组(Triplet)包括一对正样本对和一对负样本对。三张图片分别命名为固定图片(Anchor)

a

a

a,正样本图片(Positive)

p

p

p和负样本图片(Negative)

n

n

n。图片

a

a

a 和图片

p

p

p 为一对正样本对,图片

a

a

a 和图片

n

n

n 为一对负样本对。则三元组损失表示为:

L

t

=

(

d

a

,

p

−

d

a

,

n

+

α

)

+

{L_t}{\rm{ = (}}{{\rm{d}}_{a,p}}{\rm{ - }}{{\rm{d}}_{a,n}}{\rm{ + }}\alpha {{\rm{)}}_ + }

Lt=(da,p−da,n+α)+如下图7所示,三元组可以拉近正样本对之间的距离,推开负样本对之间的距离,最后使得相同ID的行人图片在特征空间里形成聚类,达到行人重识别的目的。

L

t

t

=

d

a

,

p

+

(

d

a

,

p

−

d

a

,

n

+

α

)

+

{L_t}{\rm{t = }}{{\rm{d}}_{a,p}} + {{\rm{(}}{{\rm{d}}_{a,p}}{\rm{ - }}{{\rm{d}}_{a,n}}{\rm{ + }}\alpha {\rm{)}}_ + }

Ltt=da,p+(da,p−da,n+α)+公式添加

d

a

,

p

{{\rm{d}}_{a,p}}

da,p$项,保证网络不仅能够在特征空间把正负样本推开,也能保证正样本对之间的距离很近。

(3) 四元组损失(Quadruplet loss):四元组损失是三元组损失的另一个改进版本。顾名思义,四元组(Quadruplet)需要四张输入图片,和三元组不同的是多了一张负样本图片。即四张图片为固定图片(Anchor)

a

a

a,正样本图片(Positive)

p

p

p ,负样本图片1(Negative1)

n

1

n1

n1 和负样本图片2(Negative2)

n

2

n2

n2 。其中

n

1

n1

n1和

n

2

n2

n2 是两张不同行人ID的图片,其结构则四元组损失表示为:

q

=

(

d

a

,

p

−

d

a

,

n

1

+

α

)

+

+

(

d

a

,

p

−

d

a

,

n

2

+

β

)

+

q{\rm{ = (}}{{\rm{d}}_{a,p}} - {{\rm{d}}_{a,{n_1}}}{\rm{ + }}\alpha {{\rm{)}}_ + } + {{\rm{(}}{{\rm{d}}_{a,p}} - {{\rm{d}}_{a,{n_2}}}{\rm{ + }}\beta {\rm{)}}_ + }

q=(da,p−da,n1+α)++(da,p−da,n2+β)+其中

α

\alpha

α 和

β

\beta

β 是手动设置的正常数,通常设置

β

\beta

β 小于$ \alpha$ ,前一项称为强推动,后一项称为弱推动。相比于三元组损失只考虑正负样本间的相对距离,四元组添加的第二项不共享ID,所以考虑的是正负样本间的绝对距离。因此,四元组损失通常能让模型学习到更好的表征。

(4)难样本采样三元组损失(Triplet loss with batch hard mining, TriHard loss):难样采样三元组损失(本文之后用TriHard损失表示)是三元组损失的改进版。传统的三元组随机从训练数据中抽样三张图片,这样的做法虽然比较简单,但是抽样出来的大部分都是简单易区分的样本对。如果大量训练的样本对都是简单的样本对,那么这是不利于网络学习到更好的表征。大量论文发现用更难的样本去训练网络能够提高网络的泛化能力,而采样难样本对的方法很多。之前提出了一种基于训练批量(Batch)的在线难样本采样方法——TriHard Loss。TriHard损失的核心思想是:对于每一个训练batch,随机挑选

P

P

P 个ID的行人,每个行人随机挑选

K

K

K 张不同的图片,即一个batch含有

P

×

K

P \times K

P×K 张图片。之后对于batch中的每一张图片

a

a

a ,我们可以挑选一个最难的正样本和一个最难的负样本和

a

a

a 组成一个三元组。首先我们定义和

a

a

a 为相同ID的图片集为

A

A

A ,剩下不同ID的图片图片集为

B

B

B,则TriHard损失表示为:

L

t

h

=

1

P

×

K

∑

a

∈

b

a

t

c

h

(

max

p

∈

A

d

a

,

p

−

min

n

∈

B

d

a

,

n

+

α

)

+

{L_{th}} = {1 \over {P \times K}}{\sum\limits_{a \in batch} {(\mathop {\max }\limits_{p \in A} {d_{a,p}} - \mathop {\min }\limits_{n \in B} {d_{a,n}} + \alpha )} _ + }

Lth=P×K1a∈batch∑(p∈Amaxda,p−n∈Bminda,n+α)+其中

α

\alpha

α 是人为设定的阈值参数。TriHard损失会计算

a

a

a 和batch中的每一张图片在特征空间的欧式距离,然后选出与

a

a

a 距离最远(最不像)的正样本

p

p

p 和距离最近(最像)的负样本

n

n

n 来计算三元组损失。通常TriHard损失效果比传统的三元组损失要好。

③基于局部特征的ReID方法:早期的ReID研究大家还主要关注点在全局的global feature上,就是用整图得到一个特征向量进行图像检索。但是后来大家逐渐发现全局特征遇到了瓶颈,于是开始渐渐研究起局部的local feature。常用的提取局部特征的思路主要有图像切块、利用骨架关键点定位以及姿态矫正等等。(1)图片8切块是一种很常见的提取局部特征方式。如下图所示,图片被垂直等分为若干份,因为垂直切割更符合我们对人体识别的直观感受,所以行人重识别领域很少用到水平切割。

④基于视频序列的ReID方法:目前单帧的ReID研究还是主流,因为相对来说数据集比较小,哪怕一个单GPU的PC做一次实验也不会花太长时间。但是通常单帧图像的信息是有限的,因此有很多工作集中在利用视频序列来进行行人重识别方法的研究。基于视频序列的方法最主要的不同点就是这类方法不仅考虑了图像的内容信息,还考虑了帧与帧之间的运动信息等。

基于单帧图像的方法主要思想是利用CNN来提取图像的空间特征,而基于视频序列的方法主要思想是利用CNN 来提取空间特征的同时利用递归循环网络(Recurrent neural networks, RNN)来提取时序特征。13图是非常典型的思路,网络输入为图像序列。每张图像都经过一个共享的CNN提取出图像空间内容特征,之后这些特征向量被输入到一个RNN网络去提取最终的特征。最终的特征融合了单帧图像的内容特征和帧与帧之间的运动特征。而这个特征用于代替前面单帧方法的图像特征来训练网络。

AMOC的核心思想在于网络除了要提取序列图像的特征,还要提取运动光流的运动特征。AMOC拥有空间信息网络(Spatial network, Spat Nets)和运动信息网络两个子网络。图像序列的每一帧图像都被输入到Spat Nets来提取图像的全局内容特征。而相邻的两帧将会送到Moti Nets来提取光流图特征。之后空间特征和光流特征融合后输入到一个RNN来提取时序特征。通过AMOC网络,每个图像序列都能被提取出一个融合了内容信息、运动信息的特征。网络采用了分类损失和对比损失来训练模型。融合了运动信息的序列图像特征能够提高行人重识别的准确度。

论文从另外一个角度展示了多帧序列弥补单帧信息不足的作用,目前大部分video based ReID方法还是不管三七二十一的把序列信息输给网络,让网络去自己学有用的信息,并没有直观的去解释为什么多帧信息有用。则很明确地指出当单帧图像遇到遮挡等情况的时候,可以用多帧的其他信息来弥补,直接诱导网络去对图片进行一个质量判断,降低质量差的帧的重要度。如图15,文章认为在遮挡较严重的情况下,如果用一般的pooling会造成attention map变差,遮挡区域的特征会丢失很多。而利用论文的方法每帧进行一个质量判断,就可以着重考虑那些比较完整的几帧,使得attention map比较完整。而关键的实现就是利用一个pose estimation的网络,论文叫做landmark detector。当landmark不完整的时候就证明存在遮挡,则图片质量就会变差。之后pose feature map和global feature map都同时输入到网络,让网络对每帧进行一个权重判断,给高质量帧打上高权重,然后对feature map进行一个线性叠加。思路比较简单但是还是比较让人信服的。

论文是第一篇用GAN做ReID的文章,发表在ICCV17会议,虽然论文比较简单,但是作为挖坑鼻祖引出一系列很好的工作。如下图16,这篇论文生成的图像质量还不是很高,甚至可以用很惨来形容。另外一个问题就是由于图像是随机生成的,也就是说是没有可以标注label可以用。为了解决这个问题,论文提出一个标签平滑的方法。实际操作也很简单,就是把label vector每一个元素的值都取一样,满足加起来为1。反正也看不出属于哪个人,那就一碗水端平。生成的图像作为训练数据加入到训练之中,由于当时的baseline还不像现在这么高,所以效果还挺明显的,至少数据量多了过拟合能避免很多。

ReID的其中一个难点就是姿态的不同,为了克服这个问题论文使用GAN造出了一系列标准的姿态图片。论文总共提取了8个pose,这个8个pose基本涵盖了各个角度。每一张图片都生成这样标准的8个pose,那么pose不同的问题就解决。最终用这些图片的feature进行一个average pooling得到最终的feature,这个feature融合了各个pose的信息,很好地解决的pose bias问题。无论从生成图还是从实验的结果来看,这个工作都是很不错的。这个工作把single query做成了multi query,但是你没法反驳,因为所有的图都是GAN生成的。除了生成这些图需要额外的时间开销以外,并没有利用额外的数据信息。当然这个工作也需要一个预训练的pose estimation网络来进行pose提取。

5.行人重识别数据集

在行人重识别中所使用到的数据集可以参考 Person re-indentification datasets6.行人重识别的评价指标

Reid论文中常用的评测指标有mAP、CMC、ROC等,下面一一分析。1.ROC

ROC曲线是检测、分类、识别任务中很常用的一项评价指标。曲线上每个点反映着对同一信号刺激的感受性。具体到识别任务中就是,ROC曲线上的每一点反映的是不同的阈值对应的FP(false positive)和TP(true positive)之间的关系,如图17所示。

2.CMC

CMC曲线是算一种top-k的击中概率,主要用来评估闭集中rank的正确率。举个很简单的例子,假如在人脸识别中,底库中有100个人,现在来了1个待识别的人脸(假如label为m1),与底库中的人脸比对后将底库中的人脸按照得分从高到低进行排序,我们发现:

2.1.如果识别结果是m1、m2、m3、m4、m5……,则此时rank-1的正确率为100%;rank-2的正确率也为100%;rank-5的正确率也为100%;

2.2.如果识别结果是m2、m1、m3、m4、m5……,则此时rank-1的正确率为0%;rank-2的正确率为100%;rank-5的正确率也为100%;

2.3.如果识别结果是m2、m3、m4、m5、m1……,则此时rank-1的正确率为0%;rank-2的正确率为0%;rank-5的正确率为100%;

同理,当待识别的人脸集合有很多时,则采取取平均值的做法。例如待识别人脸有3个(假如label为m1,m2,m3),同样对每一个人脸都有一个从高到低的得分,

2-1.比如人脸1结果为m1、m2、m3、m4、m5……,人脸2结果为m2、m1、m3、m4、m5……,人脸3结果m3、m1、m2、m4、m5……,则此时rank-1的正确率为(1+1+1)/3=100%;rank-2的正确率也为(1+1+1)/3=100%;rank-5的正确率也为(1+1+1)/3=100%;

2-2.比如人脸1结果为m4、m2、m3、m5、m6……,人脸2结果为m1、m2、m3、m4、m5……,人脸3结果m3、m1、m2、m4、m5……,则此时rank-1的正确率为(0+0+1)/3=33.33%;rank-2的正确率为(0+1+1)/3=66.66%;rank-5的正确率也为(0+1+1)/3=66.66%;

3.Precision & Recall & mAP

一般来说,Precision就是检索出来的条目(比如:文档、网页等)有多少是准确的,Recall就是所有准确的条目有多少被检索出来了。

召回率 = 提取出的正确信息条数 / 样本中的信息条数

3.1.第一次检索到m1,提取出的正确信息条数=1,提取出的信息条数=1,样本中的信息条数=3,正确率=1/1=100%,召回率=1/3=33.33%;

3.2.第二次检索到m1,提取出的正确信息条数=2,提取出的信息条数=3,样本中的信息条数=3,正确率=2/3=66.66%,召回率=2/3=66.66%;

3.3.第三次检索到m1,提取出的正确信息条数=3,提取出的信息条数=6,样本中的信息条数=3,正确率=3/6=50%,召回率=3/3=100%;

平均正确率AP=(100%+66.66%+50%)/3=72.22%

而当需要检索的不止一个人时,此时正确率则取所有人的平均mAP。

4.F-Score

从上面准确率和召回率之间的关系可以看出,一般情况下,

P

r

e

c

i

s

i

o

n

Precision

Precision高,

R

e

c

a

l

l

Recall

Recall就低,

R

e

c

a

l

l

Recall

Recall高,

P

r

e

c

i

s

i

o

n

Precision

Precision就低。所以在实际中常常需要根据具体情况做出取舍,例如一般的搜索情况,在保证召回率的条件下,尽量提升精确率。很多时候我们需要综合权衡这2个指标,这就引出了一个新的指标

F

−

s

c

o

r

F-scor

F−score。这是综合考虑

P

r

e

c

i

s

i

o

n

Precision

Precision和

R

e

c

a

l

l

Recall

Recall的调和值。

F

−

S

c

o

r

e

=

(

1

+

β

2

)

Pr

e

c

i

s

i

o

n

R

e

c

a

l

l

β

2

Pr

e

c

i

s

i

o

n

+

R

e

c

a

l

l

F - Score = (1 + {\beta ^2}){{\Pr ecision{\mathop{\rm Re}\nolimits} call} \over {{\beta ^2}\Pr ecision + {\mathop{\rm Re}\nolimits} call}}

F−Score=(1+β2)β2Precision+RecallPrecisionRecall

当

β

=

1

β=1

β=1时,称为

F

1

−

s

c

o

r

e

F1-score

F1−score,这时,精确率和召回率都很重要,权重相同。当有些情况下,我们认为精确率更重要些,那就调整β的值小于1,如果我们认为召回率更重要些,那就调整β的值大于1。

比如在上面的例子中,在第三次检索到m1时的争取率为50%,召回率为100%,则F1-score=(20.51)/(0.5+1)=66.66%,而F0.5-score=(1.250.51)/(0.25*0.5+1)=55.56%

7.行人重识别测试

主要有两种方案:a.测试的输入是一对行人,输出为这对行人的相似度,然后再按相似度排序;

b.输入单个人,提取特征,再计算与其他人的欧式距离,然后再按距离排序。

第一种方案的优点是,判断两个人是不是一个人,简单的二分类(是/否)。但缺点是如果我们搜索库中有m张图片,那么与目标图片组成m对图片对。每一对都要进一次模型,估算相似度,这极大的增加了测试的时间。如果我们有n个query,那么我们要计算nm次相似度(而m往往很大)。另一种方案是,预先提取行人的特征,我们只要预先提好n+m次特征。之后只要比较就好了,比较特征可以简单的用矩阵乘法实现。 目前两种方案都有在用,但是后一种更接近实际中图像搜索的要求,用特征来快速检索。

参考自:

http://html.rhhz.net/tis/html/201706084.htm

https://blog.csdn.net/weixin_41427758/article/details/81188164

https://blog.csdn.net/Gavinmiaoc/article/details/80774199>

https://blog.csdn.net/baidu_18891025/article/details/79202249

https://zhuanlan.zhihu.com/p/26168232

2231

2231

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?