参考链接1:GMM

运动物体检测的问题主要分为两类,摄像机固定和摄像机运动。

对于摄像机运动的运动物体检测问题,比较著名的解决方案是光流法 ,通过求解偏微分方程,求的图像序列的光流场 ,从而预测摄像机的运动状态。对于摄像机固定的情形,当然也可以用光流法,但是由于光流法的复杂性,往往难以实时的计算,所以可以采用背景模型法。因为,在摄像机固定的情况下,背景的变化是缓慢的,而且大都是光照,风等等的影响,通过对背景建模,对一幅给定图像分离前景和背景,一般来说,混合高斯建模是最常用。

找到研究方向以后,就是了解对应的算法。

1、单高斯模型和混合高斯模型

参考链接2:高斯模型

高斯模型有单高斯模型(SGM)和高斯混合模型(GMM)两种。

1.1单高斯模型

单高斯模型也就是我们平时说所的高斯分布(正态分布),概率密度函数服从上面的正态分布的模型叫做单高斯模型,具体形式如下:

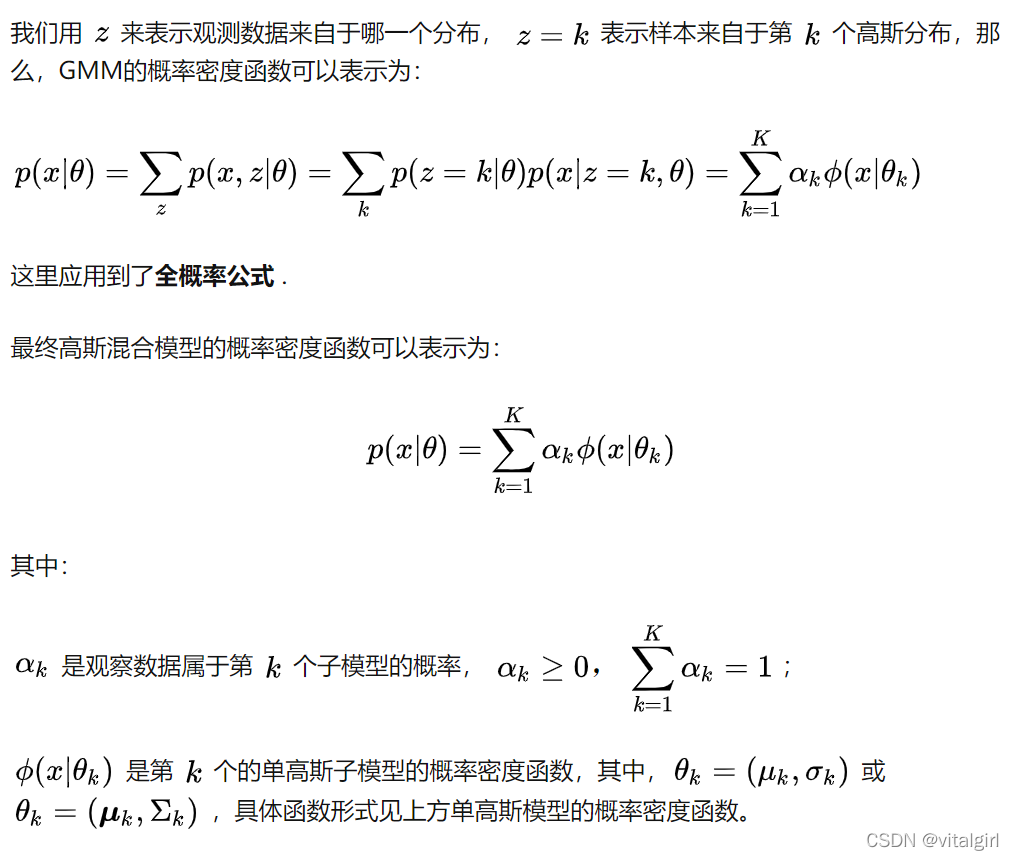

1.2 高斯混合模型(GMM)

高斯混合模型(GMM)是单高斯模型(SGM)的延伸,就是用多个高斯概率密度函数(正态分布曲线)精确地量化变量分布,是将变量分布分解为若干基于高斯概率密度函数(正态分布曲线)分布的统计模型。它可以平滑的近似任何形状的分布。反过来解释就是, K 个单高斯模型混合在一起,生成的模型,就是高斯混合模型。

GMM是工业界使用最多的一种聚类算法,每个单高斯模型可以看做是一个类别,通过计算样本属于各单高斯模型的概率来判断其最终的类别。它本身是一种概率式的聚类方法,假定所有的样本数据X由K 个混合多元高斯分布组合成的混合分布生成。

一般来说,一个混合模型可以使用任何概率分布,这里使用高斯混合模型是因为高斯分布具备很好的数学性质以及良好的计算性能。

2、混合高斯背景建模理论和流程

参考链接:原理

参考链接3:理论

2.1 混合高斯背景建模理论

混合高斯背景建模是基于像素样本统计信息的背景表示方法,利用像素在较长时间内大量样本值的概率密度等统计信息(如模式数量、每个模式的均值和标准差)表示背景,然后使用统计差分(如3σ原则)进行目标像素判断,可以对复杂动态背景进行建模,计算量较大。

在混合高斯背景模型中,认为像素之间的颜色信息互不相关,对各像素点的处理都是相互独立的。对于视频图像中的每一个像素点,其值在序列图像中的变化可看作是不断产生像素值的随机过程,即用高斯分布来描述每个像素点的颜色呈现规律{单模态(单峰),多模态(多峰)}。

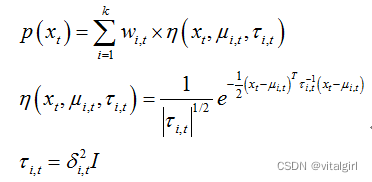

对于多峰高斯分布模型,图像的每一个像素点按不同权值的多个高斯分布的叠加来建模,每种高斯分布对应一个可能产生像素点所呈现颜色的状态,各个高斯分布的权值和分布参数随时间更新。当处理彩色图像时,假定图像像素点R、G、B三色通道相互独立并具有相同的方差。对于随机变量X的观测数据集{x1,x2,…,xN},xt=(rt,gt,bt)为t时刻像素的样本,则单个采样点xt其服从的混合高斯分布概率密度函数:

其中k为分布模式总数,η(xt,μi,t,τi,t)为t时刻第i个高斯分布,μi,t为其均值,τi,t为其协方差矩阵,δi,t为方差,I为三维单位矩阵,ωi,t为t时刻第i个高斯分布的权重。

2.2 混合高斯背景建模流程

1.每个新像素值Xt同当前K个模型按下式进行比较,直接找到匹配新像素值的分布模型,即同该模型的均值偏差在2.5σ内:

2.如果所匹配的模式符合背景要求,则该像素属于背景,否则属于前景。

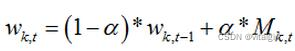

3.各个模式权值按如下方式进行更新,其中a是学习速率,对于匹配的模式Mk,t=1,否则Mk,t=0,然后各模式的权重进行归一化:

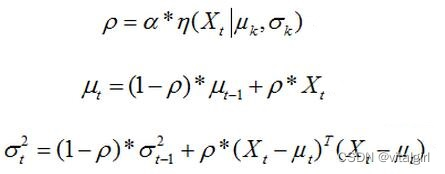

4.未匹配模式的均值μ和标准差σ不变,匹配模式的参数按照如下更新:

5.如果,第一步中没有任何模式匹配,则权重最小的模式被替换,即该模式的均值为当前像素值,标准差为初始较大值,权重为较小值。

6.各模式根据w/a^2按降序排列,权重大、标准差小的模式排列在前。

7.选前B个模式作为背景,B满足下式,参数T表示背景所占的比例:

// 功能:代码 9-5 高斯混合背景建模

// 作者:朱伟 zhu1988wei@163.com

// 来源:《OpenCV图像处理编程实例》

// 博客:http://blog.csdn.net/zhuwei1988

// 更新:2016-8-1

// 说明:版权所有,引用或摘录请联系作者,并按照上面格式注明出处,谢谢。//

#include "opencv2/imgcodecs.hpp"

#include "opencv2/imgproc.hpp"

#include "opencv2/videoio.hpp"

#include <opencv2/highgui.hpp>

#include <opencv2/video.hpp>

#include <iostream>

#include <sstream>

using namespace cv;

using namespace std;

Mat frame;

Mat fgMaskMOG2;

Ptr<BackgroundSubtractor> pMOG2;

int keyboard;

void processVideo(string videoFilename)

{

// 视频获取

VideoCapture capture(videoFilename);

if(!capture.isOpened())

{

// 输出视频文件打开错误信息

cerr << "Unable to open video file: " << videoFilename << endl;

exit(EXIT_FAILURE);

}

// 按下q键和esc退出

while( (char)keyboard != 'q' && (char)keyboard != 27 )

{

// 读取当前帧

if(!capture.read(frame))

{

cerr << "Unable to read next frame." << endl;

cerr << "Exiting..." << endl;

exit(EXIT_FAILURE);

}

// 图像尺寸缩小

cv::resize(frame, frame,cv::Size(), 0.25,0.25);

// 背景模型生成

pMOG2->apply(frame, fgMaskMOG2);

// 输出当前帧号

stringstream ss;

rectangle(frame, cv::Point(10, 2), cv::Point(100,20),

cv::Scalar(255,255,255), -1);

ss << capture.get(CAP_PROP_POS_FRAMES);

string frameNumberString = ss.str();

// 左上角显示帧号

putText(frame, frameNumberString.c_str(), cv::Point(15, 15),

FONT_HERSHEY_SIMPLEX, 0.5 , cv::Scalar(0,0,0));

// 输出结果

imshow("Frame", frame);

imshow("FG Mask MOG 2", fgMaskMOG2);

keyboard = waitKey(30);

}

capture.release();

}

int main(int argc, char* argv[])

{

// 创建背景建模类

pMOG2 = createBackgroundSubtractorMOG2();

string inputPath = "F:\\毕业论文相关\\机场视频\\机场.avi";

processVideo(inputPath);

return 0;

}

4、代码中GMM算法实现的解释

参考链接6:opencv源码讲解

混合高斯分布(GMM)是背景建模中的经典算法,自提出至今已经有了很多围绕它改进和应用的论文。opencv中(2.4.13版本)也引入了该算法及其改进版本。

首先是基本版本的GMM,opencv将其封装为BackgroundSubtractorMOG。

之后是改进版GMM,opencv把它封装为BackgroundSubtractorMOG2算法类,源代码位于opencv\sources\modules\video\src\bgfg_gaussmix2.cpp中。

背景提取效果如下图所示,左左边为BackgroundSubtractorMOG2算法效果,右边为BackgroundSubtractorMOG效果。先忽略左边图像中的一些噪点,我们可以看到两者的最大不同在于左边图像中存在灰色填充的一些区域,这些正是BackgroundSubtractorMOG2算法的一个改进点-阴影检测,那些灰色区域就是算法计算得到的“阴影”区域。另外一处不同在于算法的运行时间,根据控制台输出结果,BackgroundSubtractorMOG2每帧检测大概0.03s,BackgroundSubtractorMOG每帧检测大概0.06s,BackgroundSubtractorMOG2算法在运行时间上有较大提升(不全是算法本身原因,实际上BackgroundSubtractorMOG2在执行时通过多线程并行执行)。

所以目前看来改进后的GMM算法,即BackgroundSubtractorMOG2算法主要有两点改进点:(1)增加阴影检测功能(2)算法效率有较大提升。后者意义不言而喻,前者的意义在于如果不使用一些方法检测得到阴影,那么它有可能被识别为前景物体,导致前景物体得到了错误的形状,从而对后续处理(譬如跟踪)产生不好的影响。

支撑论文只需要看《Improved adaptive Gausian mixture model for background subtraction》,翻译好的链接是《Improved adaptive Gausian mixture model for background subtraction》

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?