这部分个人已经复现完成:https://github.com/gmt710/AlphaPose_yolovx。大致做个简单的环境记录以及微小的总结吧。

使用yolov5s的速度非常快。但是检测可能会精度上比yolov3-spp差一些。由于自上而下的多人人体姿态估计与跟踪,检测问题会影响最后的送到进行姿态估计的输入,最终影响其性能。

根据分析,基本可以知道Alphapose跟踪用的是目标跟踪与姿态估计。

1.环境

ubuntu16.04

cuda10.1

cudnn7

python3.6

torch==1.7.0

torchvision==0.8.1

opencv-python==4.1.0.25

tqdm

natsort

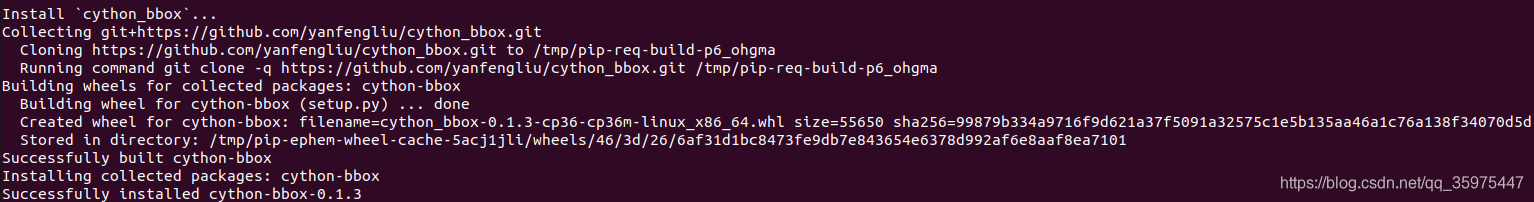

Cython

pycocotools

scipy

terminaltables

wf-pycocotools==2.0.1.1

scikit-image>=0.16.2

googledrivedownloader

protobuf>=3.8.0

websocket-clientpython setup.py build develop --user

apt-get update

apt-get -y install python3.6-tk2.demo运行

python scripts/demo_inference.py --cfg configs/coco/resnet/256x192_res50_lr1e-3_2x-dcn.yaml --checkpoint pretrained_models/fast_dcn_res50_256x192.pth --indir examples/demo/ --vis --showbox --save_img --pose_track --sp --vis_fast --detector yolov5

本文介绍了一个基于YOLOv5s优化的人体姿态估计与跟踪系统AlphaPose_YOLOv5的实现过程。该系统在Ubuntu 16.04环境下搭建,并详细记录了所需的依赖库版本及安装配置步骤。文中还分享了如何运行demo示例,展示了快速检测与准确的人体姿态估计效果。

本文介绍了一个基于YOLOv5s优化的人体姿态估计与跟踪系统AlphaPose_YOLOv5的实现过程。该系统在Ubuntu 16.04环境下搭建,并详细记录了所需的依赖库版本及安装配置步骤。文中还分享了如何运行demo示例,展示了快速检测与准确的人体姿态估计效果。

8094

8094

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?