>- **🍨 本文为[🔗365天深度学习训练营](https://mp.weixin.qq.com/s/0dvHCaOoFnW8SCp3JpzKxg) 中的学习记录博客**

>- **🍖 原作者:[K同学啊](https://mtyjkh.blog.csdn.net/)**

一、创建环境

我们先使用conda创建一个虚拟python环境,并激活:

conda create -n dlpytorch

conda activate dlpytorch我的电脑是Windows平台下的nvida GPU,接下来配置pytorch,分为两步:

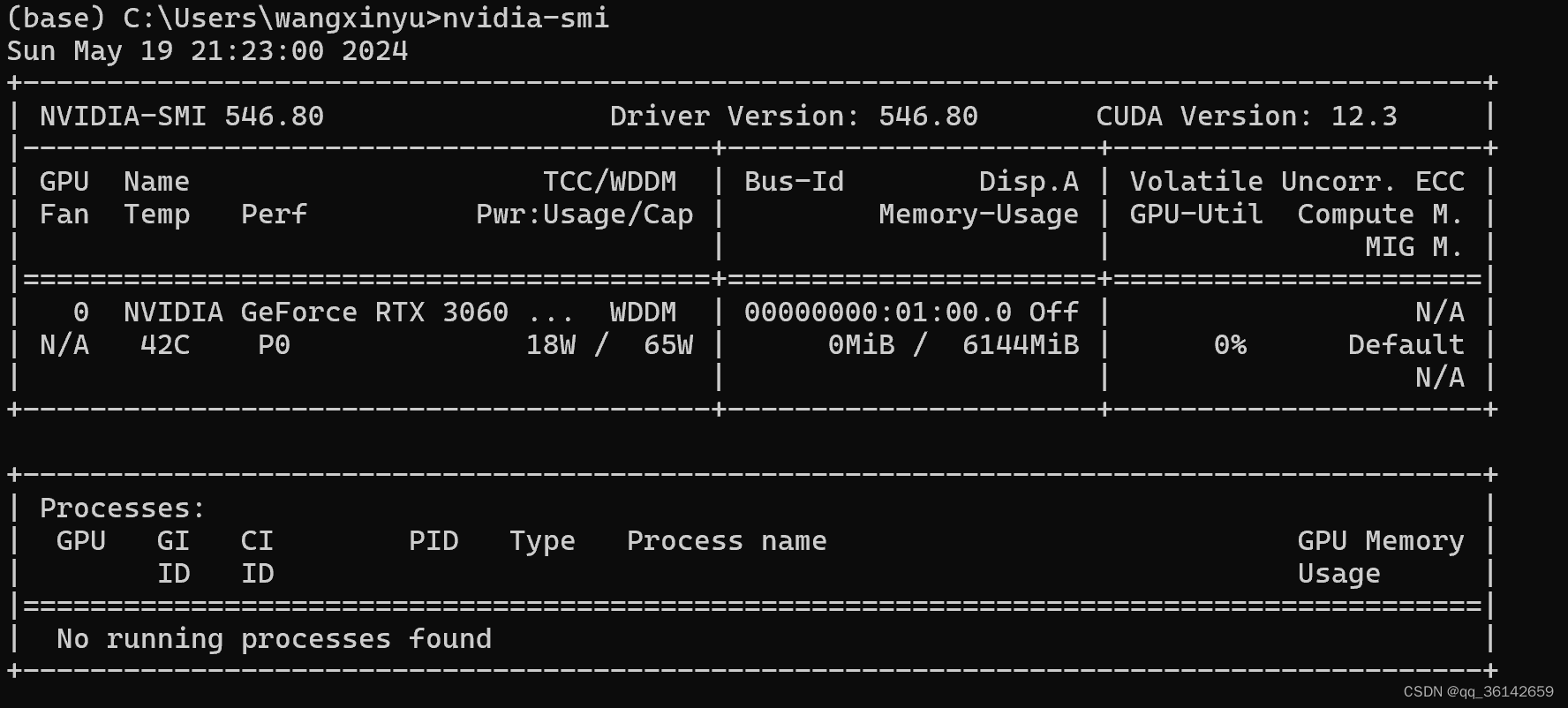

首先确认自己的显卡和cuda版本;在终端输入nvidia-smi查看

nvidia-smi 我的cuda版本是12.3

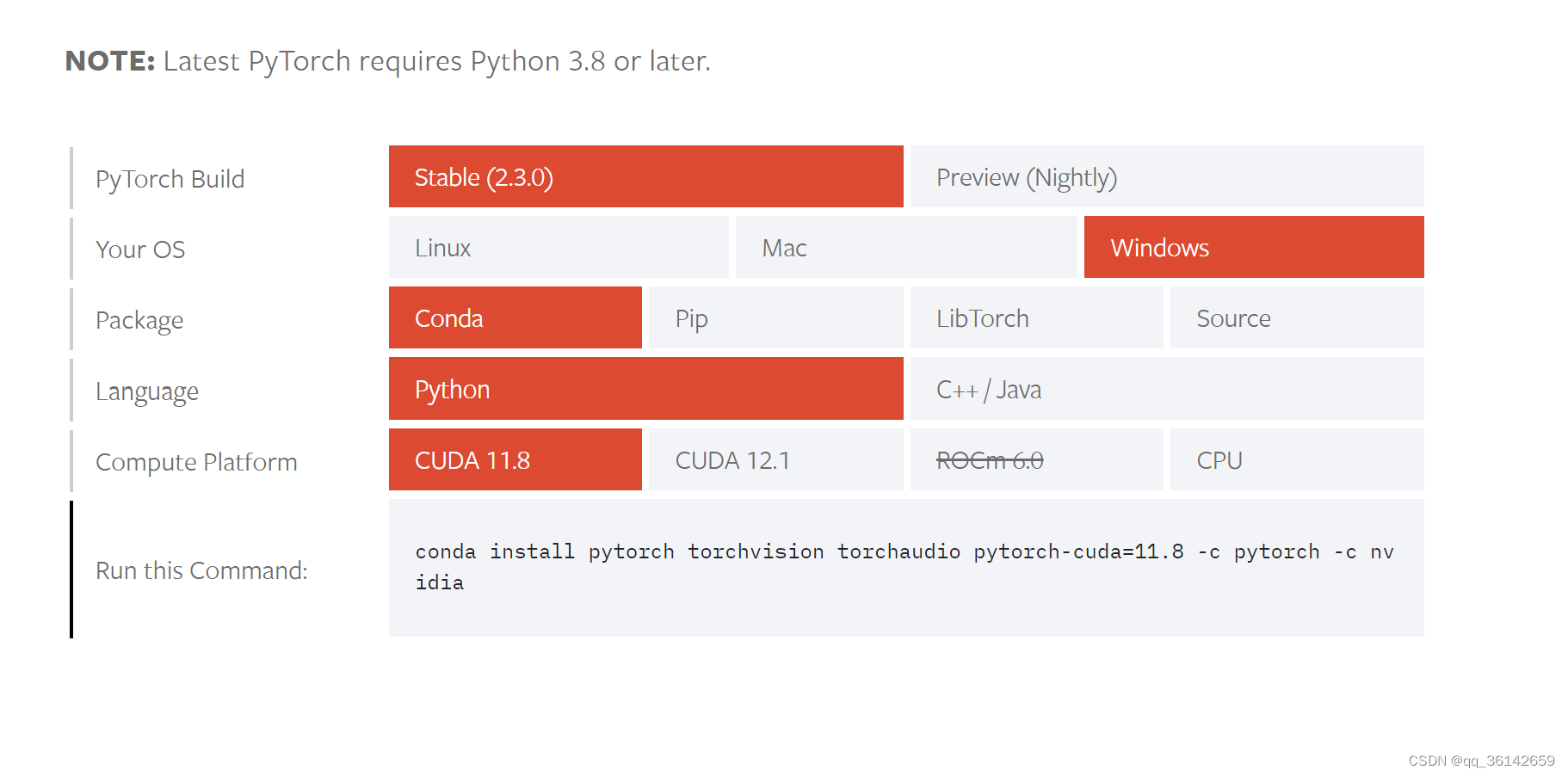

第二步安装pytorch:打开pytorch安装指导网站,选择合适的系统平台,关键是在compute platform选择一个不高于你电脑上的CUDA Version,复制命令安装。

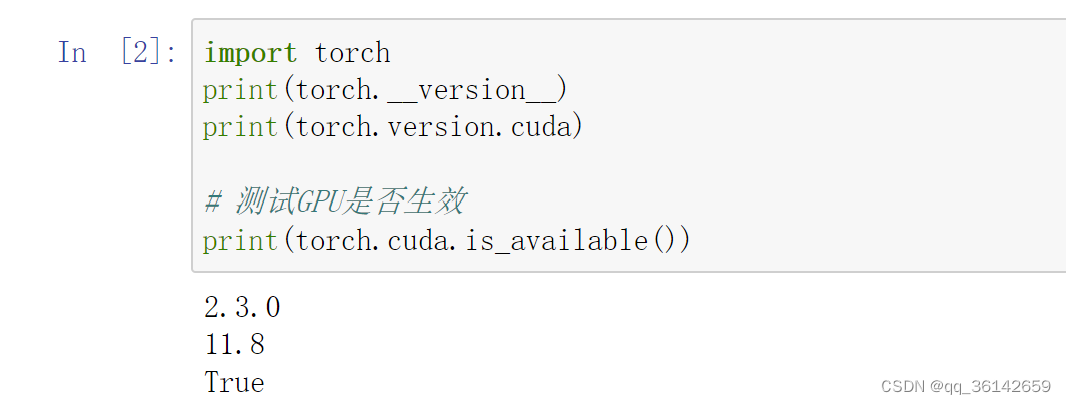

安装完成之后进入jupyternotebook,运行如下命令检查:

import torch

# 打印出正在使用的PyTorch和CUDA版本。

print(torch.__version__)

print(torch.version.cuda)

# 测试GPU是否生效

print(torch.cuda.is_available())

二、前期准备

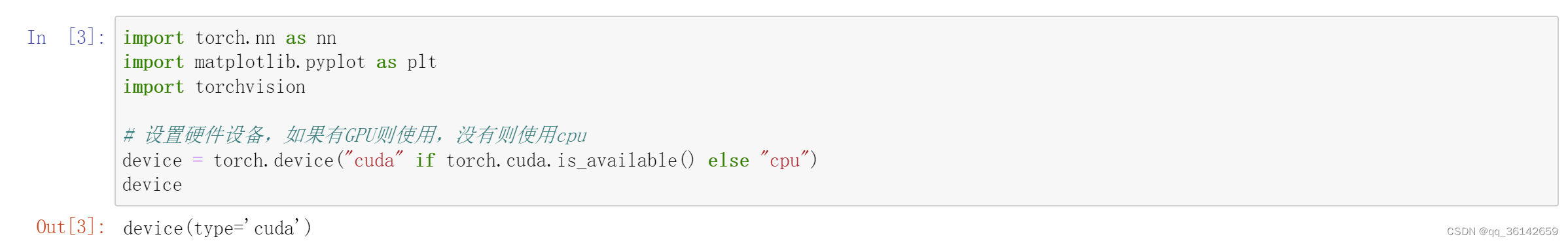

2.1 设置GPU

import torch

import torch.nn as nn

import matplotlib.pyplot as plt

import torchvision

# 设置硬件设备,如果有GPU则使用,没有则使用cpu

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

print(device)结果输出为cuda,表示使用的是GPU

2.2 导入数据

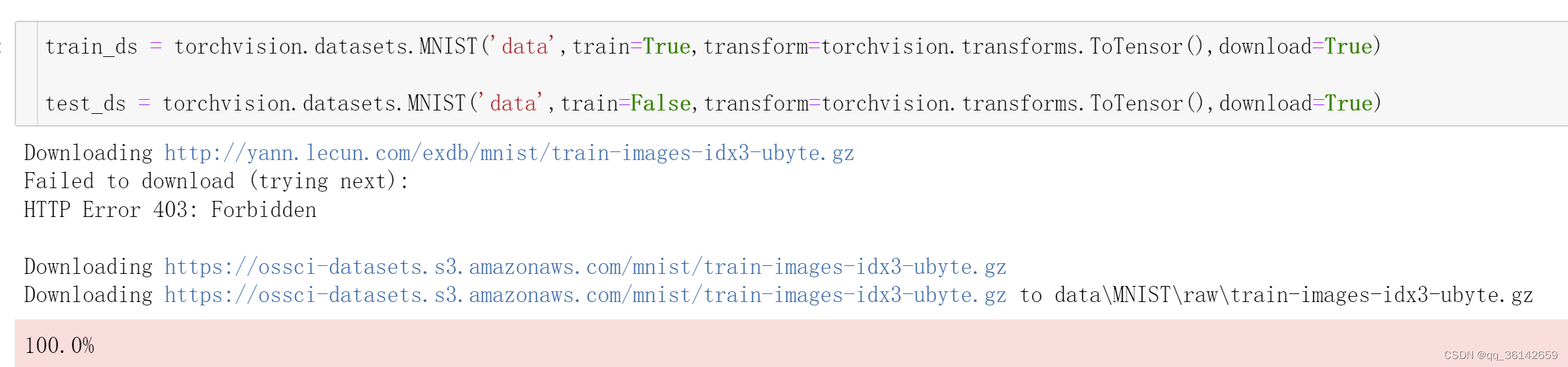

2.2.1 下载数据并划分训练集和测试集

# 使用dataset下载MNIST数据集,并划分好训练集与测试集

train_ds = torchvision.datasets.MNIST('data',

train=True,

transform=torchvision.transforms.ToTensor(), # 将数据类型转化为Tensor

download=True)

test_ds = torchvision.datasets.MNIST('data',

train=False,

transform=torchvision.transforms.ToTensor(), # 将数据类型转化为Tensor

download=True)

# 设置好基本的batch_size,也就是批次的大小

batch_size = 32

train_dl = torch.utils.data.DataLoader(train_ds,

batch_size=batch_size,

shuffle=True)

test_dl = torch.utils.data.DataLoader(test_ds,

batch_size=batch_size)

⭐ torchvision.datasets.MNIST详解:

torchvision.datasets是Pytorch自带的一个数据库,我们可以通过代码在线下载数据,这里使用的是torchvision.datasets中的MNIST数据集。

函数原型:

torchvision.datasets.MNIST(root, train=True, transform=None, target_transform=None, download=False)

参数说明:

● root (string) :数据地址

● train (string) :True-训练集,False-测试集

● download (bool,optional) : 如果为True,从互联网上下载数据集,并把数据集放在root目录下。

● transform (callable, optional ):这里的参数选择一个你想要的数据转化函数,直接完成数据转化

● target_transform (callable,optional) :接受目标并对其进行转换的函数/转换。

⭐ torch.utils.data.DataLoader详解

torch.utils.data.DataLoader是Pytorch自带的一个数据加载器,结合了数据集和取样器,并且可以提供多个线程处理数据集。

函数原型:

torch.utils.data.DataLoader(dataset, batch_size=1, shuffle=None, sampler=None, batch_sampler=None, num_workers=0, collate_fn=None, pin_memory=False, drop_last=False, timeout=0, worker_init_fn=None, multiprocessing_context=None, generator=None, *, prefetch_factor=2, persistent_workers=False, pin_memory_device=‘’)

参数说明:

● dataset (string) :加载的数据集

● batch_size (int,optional) :每批加载的样本大小(默认值:1)

● shuffle (bool,optional) : 如果为True,每个epoch重新排列数据。

2.2.2 查看数据

# 取一个批次查看数据格式

# 数据的shape为:[batch_size, channel, height, weight]

# 其中batch_size为自己设定,channel,height和weight分别是图片的通道数,高度和宽度。

imgs, labels = next(iter(train_dl))

imgs.shape

train_dl:train_dl 是一个 PyTorch 数据加载器(DataLoader),用于加载训练数据集。通常情况下,数据加载器会将数据集分成小批量(batches)进行处理。

iter(train_dl):这个调用将train_dl转换为一个迭代器。在Python中,iter()函数用于从可迭代对象获取一个迭代器。在这里,train_dl是一个可迭代对象,因此iter(train_dl)将返回一个迭代器,可以用来遍历数据加载器中的批次数据。

next(iter(train_dl)):这个调用从train_dl迭代器中获取下一个元素。在PyTorch的DataLoader中,每个元素都是一个元组,通常包含数据和标签。数据(imgs)和标签(labels)是构成训练数据集的图像和对应的类别标签。

imgs, labels = …:这是一个元组解包操作,它将next(iter(train_dl))返回的元组中的两个元素分别赋值给imgs和labels变量。这样,imgs变量将包含一个批次的图像数据,而labels变量将包含与这些图像相对应的标签。

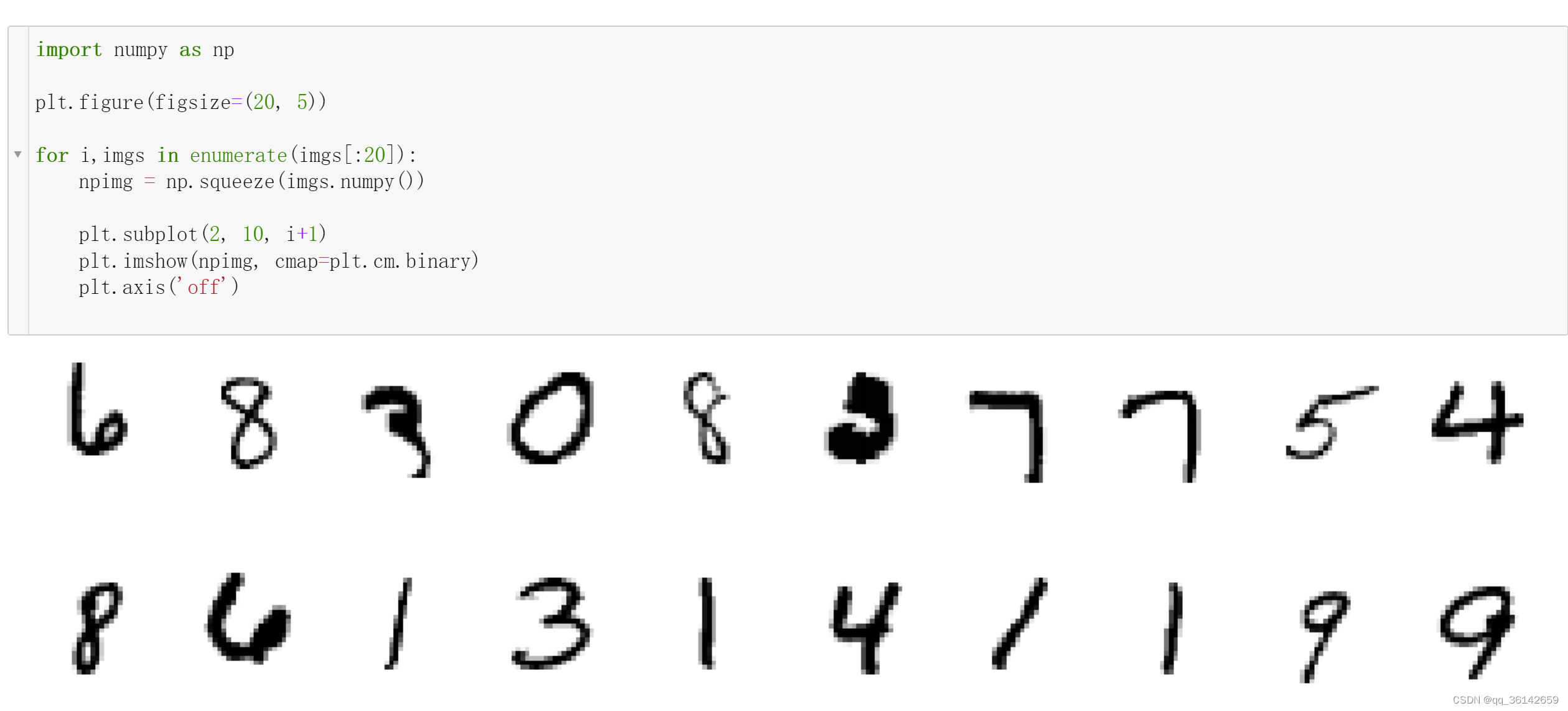

2.3数据可视化

# 数据可视化

import numpy as np

# 指定图片大小,图像大小为30宽、5高的绘图(单位为英寸inch)

plt.figure(figsize=(30, 5))

for i, imgs in enumerate(imgs[:30]):

# 维度缩减

npimg = np.squeeze(imgs.numpy())

# 将整个figure分成2行10列,绘制第i+1个子图。

plt.subplot(3, 10, i + 1)

plt.imshow(npimg, cmap=plt.cm.binary)

plt.axis('off')

plt.show()

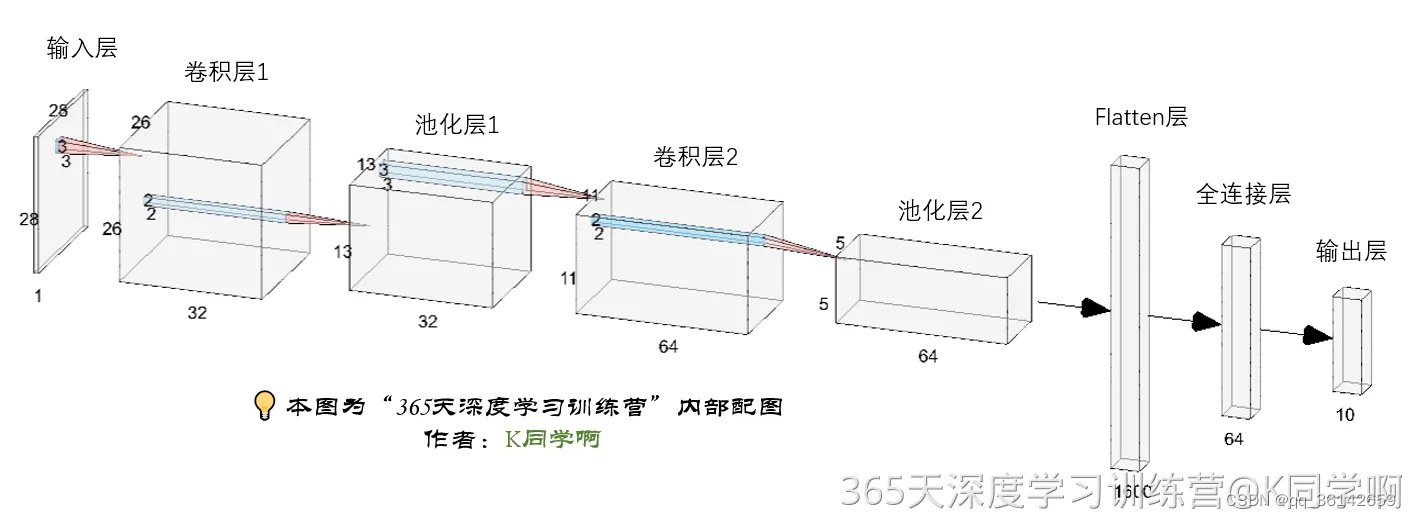

三、构建简单的CNN网络(卷积神经网络)

代码参照为以下网络结构:

这段代码定义了一个简单的卷积神经网络模型,用于图像分类任务。这个模型是一个PyTorch中的nn.Module子类,它包含了特征提取网络和分类网络两个部分。

import torch.nn.functional as F

num_classes = 10 # 图片的类别数

class Model(nn.Module):

def __init__(self):

super().__init__()

# 特征提取网络

self.conv1 = nn.Conv2d(1, 32, kernel_size=3) # 第一层卷积,卷积核大小为3*3

self.pool1 = nn.MaxPool2d(2) # 设置池化层,池化核大小为2*2

self.conv2 = nn.Conv2d(32, 64, kernel_size=3) # 第二层卷积,卷积核大小为3*3

self.pool2 = nn.MaxPool2d(2)

# 分类网络

self.fc1 = nn.Linear(1600, 64)

self.fc2 = nn.Linear(64, num_classes)

# 前向传播

def forward(self, x):

x = self.pool1(F.relu(self.conv1(x)))

x = self.pool2(F.relu(self.conv2(x)))

x = torch.flatten(x, start_dim=1)

x = F.relu(self.fc1(x))

x = self.fc2(x)

return x

# 加载并打印模型

from torchinfo import summary

# 将模型转移到GPU中(我们模型运行均在GPU中进行)

model = Model().to(device)

summary(model)

特征提取网络

self.conv1 = nn.Conv2d(1, 32, kernel_size=3): 这是第一层卷积层,它接受一个通道(例如灰度图像)的输入,并输出32个通道。卷积核的大小是3x3,这意味着每个卷积核在输入图像上滑动时,查看的是一个3x3的区域。

self.pool1 = nn.MaxPool2d(2): 这是一个最大池化层,它的池化核大小是2x2。池化操作会减少数据的维度,同时保留最重要的特征。

self.conv2 = nn.Conv2d(32, 64, kernel_size=3): 这是第二层卷积层,它接受32个通道的输入(来自第一层卷积层的输出),并输出64个通道。

self.pool2 = nn.MaxPool2d(2): 第二个最大池化层,同样使用2x2的池化核。

分类网络

self.fc1 = nn.Linear(1600, 64): 这是一个全连接层,它接受1600个输入(这是之前卷积和池化操作后的特征数量),并输出64个节点。

self.fc2 = nn.Linear(64, num_classes): 第二个全连接层,它接受64个输入,并输出最终的分类结果。

def forward(self, x): 这个方法定义了数据通过网络的前向传播过程。

x = self.pool1(F.relu(self.conv1(x))): 输入数据首先通过第一层卷积层,然后通过ReLU激活函数(用于引入非线性),最后通过第一个池化层。

x = self.pool2(F.relu(self.conv2(x))): 数据接着通过第二层卷积层、ReLU激活函数和第二个池化层。

x = torch.flatten(x, start_dim=1): 这一步将多维度的特征张量展平成一个一维的张量,这样就可以输入到全连接层中。

x = F.relu(self.fc1(x)): 数据通过第一个全连接层和ReLU激活函数。

x = self.fc2(x): 最后,数据通过第二个全连接层,输出最终的分类结果。

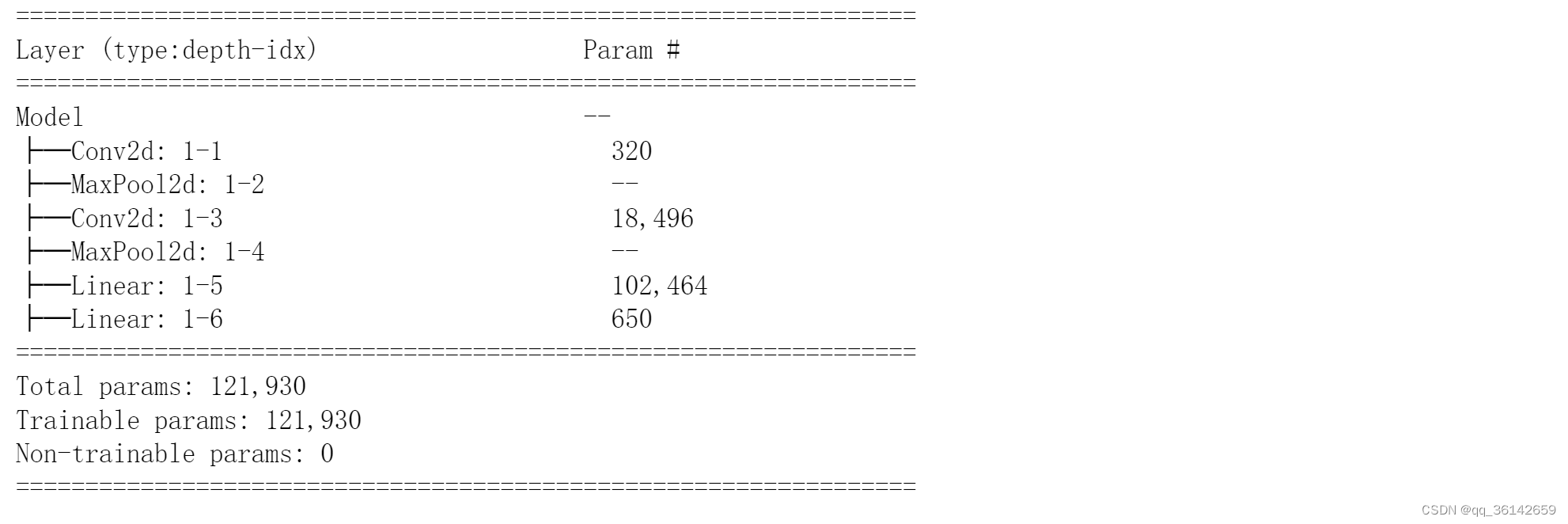

结果如图:

Layer (type:depth-idx): 这一行标题表示模型的层类型和位置。type表示层的类型,如Conv2d表示二维卷积层,MaxPool2d表示二维最大池化层,Linear表示全连接层。depth-idx表示层在模型中的深度和索引位置。

Param #: 这一行标题表示该层的参数数量。对于卷积层和全连接层,参数数量包括权重和偏置。对于没有参数的层(如池化层),这一列会显示–。

例如:

● Conv2d: 1-1: 第一层卷积层,有320个参数。

● MaxPool2d: 1-2: 第一层最大池化层,没有参数。

● Conv2d: 1-3: 第二层卷积层,有18,496个参数。

● MaxPool2d: 1-4: 第二层最大池化层,没有参数。

● Linear: 1-5: 第一层全连接层,有102,464个参数。

● Linear: 1-6: 第二层全连接层,有650个参数。

最后一部分总结了整个模型的参数数量:

● Total params: 121,930: 模型的总参数数量,这是所有可训练参数的总和。

● Trainable params: 121,930: 模型中可训练的参数数量,即可以在训练过程中通过梯度下降更新的参数。

● Non-trainable params: 0: 模型中不可训练的参数数量,这些参数在训练过程中保持不变。在这个模型中没有不可训练的参数。

四、训练模型

4.1 设置超参数

# 设置超参数

loss_fn = nn.CrossEntropyLoss() # 创建损失函数

learn_rate = 1e-2 # 学习率

opt = torch.optim.SGD(model.parameters(),lr=learn_rate)

loss_fn = nn.CrossEntropyLoss(): 这行代码创建了一个交叉熵损失函数。在分类问题中,特别是多分类问题,交叉熵损失函数是常用的损失函数之一。它衡量的是模型输出的概率分布与真实标签的分布之间的差异。在PyTorch中,nn.CrossEntropyLoss()函数已经集成了对输入进行softmax运算和计算交叉熵损失的功能,因此模型输出层不需要额外的softmax函数。

learn_rate = 1e-2: 这行代码定义了学习率,其值为0.01(即1乘以10的-2次方)。学习率决定了在优化过程中参数更新的幅度。选择合适的学习率非常重要,因为学习率过大可能导致训练不稳定,而学习率过小则可能导致训练过程过慢。

opt = torch.optim.SGD(model.parameters(), lr=learn_rate): 这行代码创建了一个随机梯度下降(Stochastic Gradient Descent, SGD)优化器的实例。model.parameters()获取了模型中所有可训练参数的迭代器,lr=learn_rate指定了学习率。SGD是一种常用的优化算法,它通过迭代地更新参数来最小化损失函数。在每次迭代中,SGD使用小批量数据(mini-batches)计算损失函数的梯度,并沿着梯度的反方向更新参数。

4.2 编写训练函数

通过遍历训练数据集的所有批量,计算每个批量的损失和准确率,并更新模型参数。最后返回整个训练过程的平均损失和平均准确率。

这段代码定义了一个训练函数train,用于训练神经网络模型。这个函数接受四个参数:dataloader、model、loss_fn和optimizer。

dataloader: 这是一个PyTorch的DataLoader对象,它提供了批量数据以及相关的标签,用于训练模型。

model: 这是需要训练的神经网络模型。

loss_fn: 这是损失函数,用于计算模型预测值和真实值之间的差异。

optimizer: 这是优化器,用于更新模型的参数以最小化损失函数。

# 训练循环

def train(dataloader, model, loss_fn, optimizer):

size = len(dataloader.dataset) # 训练集的大小,一共60000张图片

num_batches = len(dataloader) # 批次数目,1875(60000/32)

train_loss, train_acc = 0, 0 # 初始化训练损失和正确率

for X, y in dataloader: # 循环遍历dataloader中的每个批量,每个批量包含一批图片X和对应的标签y。

X, y = X.to(device), y.to(device)

# 计算预测误差

pred = model(X) # 通过模型对当前批量的图片进行预测

loss = loss_fn(pred, y) # 计算预测结果pred和真实标签y之间的损失

# 反向传播

optimizer.zero_grad() # grad属性归零

loss.backward() # 反向传播,计算损失关于模型参数的梯度

optimizer.step() # 每一步自动更新,根据计算出的梯度更新模型的参数

# 记录acc与loss

train_acc += (pred.argmax(1) == y).type(torch.float).sum().item() #更新训练准确率。pred.argmax(1)返回每个预测向量的最大值索引,即最可能的类别。然后比较预测的类别和真实的类别y,计算正确预测的图片数量。

train_loss += loss.item() #累加当前批量的损失

train_acc /= size # 计算平均训练准确率,通过将累加的正确预测数量除以训练集的总大小.

train_loss /= num_batches #计算平均训练损失,通过将累加的损失除以批次数目。

return train_acc, train_loss #函数返回平均训练准确率和平均训练损失

4.3 编写测试函数

测试函数和训练函数大致相同,但是由于不进行梯度下降对网络权重进行更新,所以不需要传入优化器。

def test(dataloader, model, loss_fn):

size = len(dataloader.dataset) # 测试集的大小,一共10000张图片

num_batches = len(dataloader) # 批次数目,313(10000/32=312.5,向上取整)

test_loss, test_acc = 0, 0

# 当不进行训练时,停止梯度更新,节省计算内存消耗

with torch.no_grad():

for imgs, target in dataloader:

imgs, target = imgs.to(device), target.to(device)

# 计算loss

target_pred = model(imgs)

loss = loss_fn(target_pred, target)

test_loss += loss.item()

test_acc += (target_pred.argmax(1) == target).type(torch.float).sum().item()

test_acc /= size

test_loss /= num_batches

return test_acc, test_loss

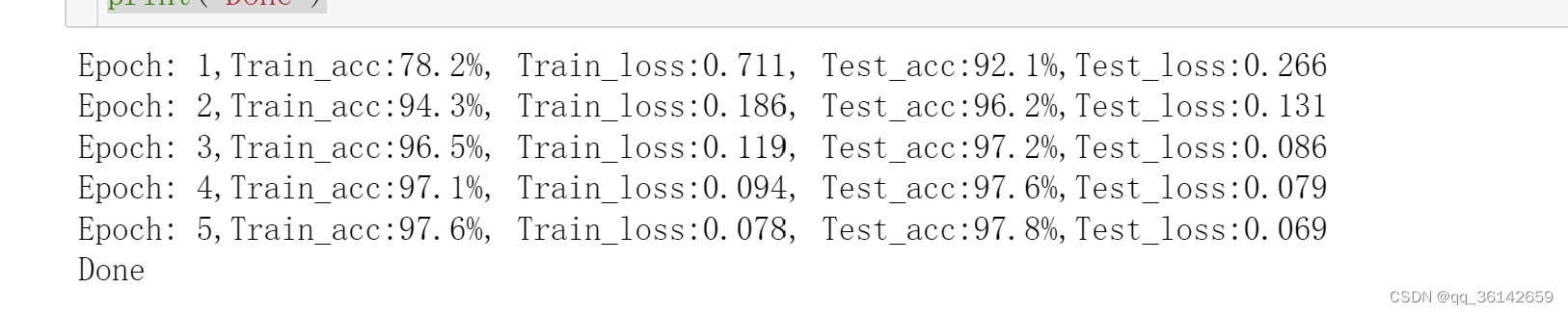

4.4 开始训练

在每次epoch中,模型首先被设置为训练模式,然后使用训练数据集进行训练;训练完成后,模型被设置为评估模式,然后使用测试数据集进行评估。

epochs = 5 # 定义了训练循环的次数,即进行了5次epoch

train_loss = []

train_acc = []

test_loss = []

test_acc = []

for epoch in range(epochs):

# 训练模式

model.train() #启用训练模式,在该模式下,模型会启用所有可训练的层,并禁用BN(Batch Normalization)层在测试时的行为。

epoch_train_acc, epoch_train_loss = train(train_dl, model, loss_fn, opt) #train函数计算并返回当前epoch的训练准确率和训练损失

# 评估模式

model.eval() #在评估模式下,模型会禁用所有可训练的层,并启用BN层在测试时的行为。

epoch_test_acc, epoch_test_loss = test(test_dl, model, loss_fn) #test函数计算并返回当前epoch的测试准确率和测试损失

train_acc.append(epoch_train_acc)

train_loss.append(epoch_train_loss)

test_acc.append(epoch_test_acc)

test_loss.append(epoch_test_loss)

template = ('Epoch:{:2d}, Train_acc:{:.1f}%, Train_loss:{:.3f}, Test_acc:{:.1f}%,Test_loss:{:.3f}')

print(template.format(epoch + 1, epoch_train_acc * 100, epoch_train_loss, epoch_test_acc * 100, epoch_test_loss))

print('Done')

整个代码的原理是通过循环重复训练和评估过程,使用训练数据集训练模型,并使用测试数据集评估模型的性能。在每个epoch中,模型会根据损失函数的梯度更新其参数,以最小化训练损失。训练完成后,模型会根据测试数据集的损失评估其性能,以便了解模型在未知数据上的表现。

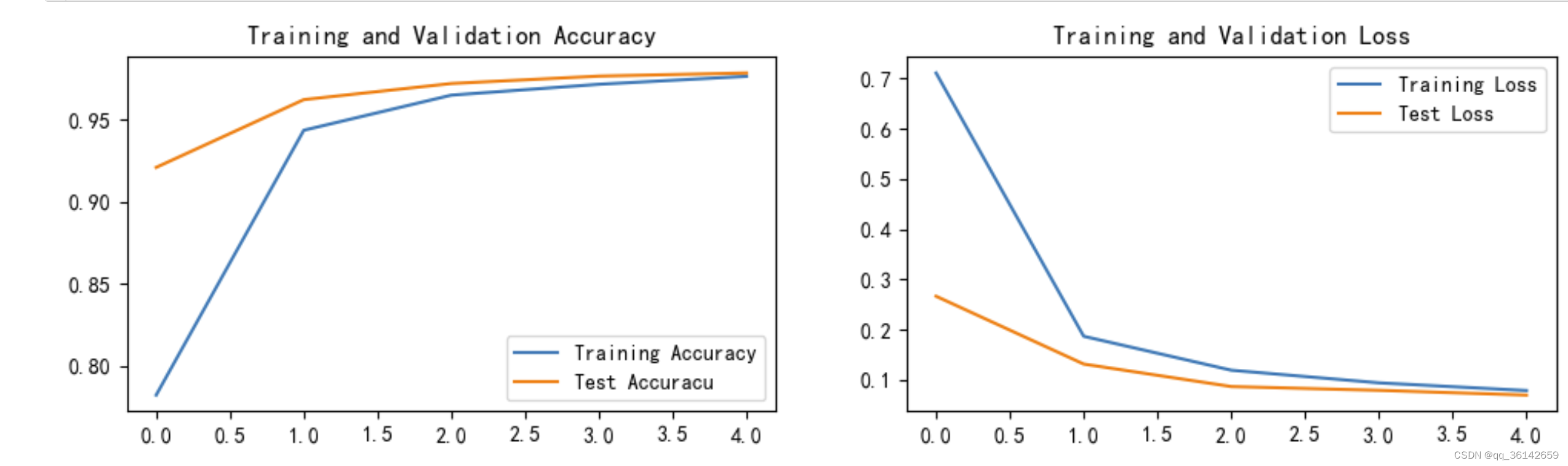

4.5 结果可视化

4.5 结果可视化

import matplotlib.pyplot as plt

#隐藏警告

import warnings

warnings.filterwarnings("ignore") #忽略警告信息

plt.rcParams['font.sans-serif'] = ['SimHei'] # 用来正常显示中文标签

plt.rcParams['axes.unicode_minus'] = False # 用来正常显示负号

plt.rcParams['figure.dpi'] = 100 #分辨率

epochs_range = range(epochs)

plt.figure(figsize=(12, 3))

plt.subplot(1, 2, 1)

plt.plot(epochs_range, train_acc, label='Training Accuracy')

plt.plot(epochs_range, test_acc, label='Test Accuracy')

plt.legend(loc='lower right')

plt.title('Training and Validation Accuracy')

plt.subplot(1, 2, 2)

plt.plot(epochs_range, train_loss, label='Training Loss')

plt.plot(epochs_range, test_loss, label='Test Loss')

plt.legend(loc='upper right')

plt.title('Training and Validation Loss')

plt.show()

结果如下:

五、总结

这个项目使我初步了解了pytorch的使用,和初步应用了cnn进行图片分类,初步了解了cnn的原理。

4851

4851

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?