PointNet++: Deep Hierarchical Feature Learning on Point Sets in a Metric Space PointNet++:深度分层特征学习度量空间中的点集

Charles R. Qi Li Yi Hao Su Leonidas J. Guibas

Stanford University

Abstract

之前很少有研究研究点集深度学习的作品。 PointNet [20] 是这个方向的先驱。然而,根据设计,PointNet 无法捕获由所在度量空间点引起的局部结构,从而限制了其识别细粒度模式的能力以及对复杂场景的泛化能力。在这项工作中,我们引入了一种分层神经网络,它将 PointNet 递归地应用于输入点集的嵌套分区。通过利用度量空间距离,我们的网络能够随着上下文尺度的增加来学习局部特征。通过进一步观察,点集通常以不同的密度进行采样,这导致在均匀密度上训练的网络的性能大大降低,我们提出了新颖的集合学习层来自适应地组合多个尺度的特征。实验表明,我们的网络 PointNet++ 能够高效、鲁棒地学习深度点集特征。特别是,在具有挑战性的 3D 点云基准上获得了明显优于现有技术的结果。

1 Introduction

我们感兴趣的是分析几何点集,这些几何点集是欧几里德空间中的点的集合。一种特别重要的几何点集类型是 3D 扫描仪捕获的点云,例如从适当装备的自动驾驶车辆捕获的点云。作为一个集合,此类数据必须对其成员的排列保持不变。此外,距离度量定义了可能表现出不同属性的局部邻域。例如,不同位置的点的密度和其他属性可能不一致 - 在 3D 扫描中,密度变化可能来自透视效应、径向密度变化、运动等。之前很少有研究研究点集深度学习的工作。 PointNet [20] 是直接处理点集的开创性成果。 PointNet 的基本思想是学习每个点的空间编码,然后将所有单个点特征聚合为全局点云签名。根据其设计,PointNet 不会捕获由度量引起的局部结构。然而,事实证明,利用局部结构对于卷积架构的成功非常重要。 CNN 将规则网格上定义的数据作为输入,并且能够沿着多分辨率层次结构逐步捕获越来越大的尺度的特征。在较低水平上,神经元具有较小的感受野,而在较高水平上,它们具有较大的感受野。沿着层次结构抽象局部模式的能力可以更好地推广到未见过的情况。我们引入了一种名为 PointNet++ 的分层神经网络,以分层方式处理度量空间中采样的一组点。 PointNet++ 的总体思想很简单。我们首先根据底层空间的距离度量将点集划分为重叠的局部区域。与 CNN 类似,我们提取局部特征,捕捉小邻域的精细几何结构;这些局部特征被进一步分组为更大的单元并被处理以产生更高级别的特征。重复这个过程,直到我们获得整个点集的特征。 PointNet++的设计必须解决两个问题:如何生成点集的划分,以及如何通过局部特征学习器抽象点集或局部特征。 arXiv:1706.02413v1 [cs.CV] 7 Jun 2017 这两个问题是相关的,因为点集的分区必须在分区之间产生公共结构,以便可以共享局部特征学习器的权重,就像在卷积设置中一样。我们选择本地特征学习器为 PointNet。正如该工作所证明的,PointNet 是一种处理无序点集以进行语义特征提取的有效架构。此外,该架构对于输入数据损坏具有鲁棒性。作为基本构建块,PointNet 将局部点或特征集抽象为更高级别的表示。在此视图中,PointNet++ 将 PointNet 递归地应用于输入集的嵌套分区。

仍然存在的一个问题是如何生成点集的重叠划分。每个分区被定义为底层欧几里得空间中的邻域球,其参数包括质心位置和尺度。为了均匀地覆盖整个集合,通过最远点采样(FPS)算法在输入点集中选择质心。与以固定步幅扫描空间的体积 CNN 相比,我们的局部感受野依赖于输入数据和度量,因此更加高效和有效。

图 1:从结构传感器捕获的扫描的可视化(左:RGB;右:点云)。

然而,由于特征尺度的纠缠和输入点集的不均匀性,确定局部邻域球的适当尺度是一个更具挑战性但又有趣的问题。我们假设输入点集在不同区域可能具有可变的密度,这在结构传感器扫描等实际数据中很常见[18](见图1)。因此,我们的输入点集与 CNN 输入非常不同,CNN 输入可以被视为在具有均匀恒定密度的规则网格上定义的数据。在 CNN 中,与局部分区规模相对应的是内核的大小。 [25]表明使用较小的内核有助于提高 CNN 的能力。然而,我们对点集数据的实验为这一规则提供了反证。由于采样不足,小邻域可能包含太少的点,这可能不足以让 PointNet 稳健地捕获模式。我们论文的一个重要贡献是 PointNet++ 利用多个尺度的邻域来实现鲁棒性和细节捕获。在训练期间的随机输入 dropout 的帮助下,网络学习自适应地对在不同尺度检测到的模式进行加权,并根据输入数据组合多尺度特征。实验表明,我们的 PointNet++ 能够高效、鲁棒地处理点集。特别是,在具有挑战性的 3D 点云基准上获得了明显优于现有技术的结果。

2 Problem Statement问题陈述

假设 X = (M, d) 是一个离散度量空间,其度量继承自欧几里得空间 Rn,其中 M ⊆ Rn 是点集,d 是距离度量。此外,环境欧几里得空间中 M 的密度可能并非处处均匀。我们感兴趣的是学习集合函数 f ,该函数将 X 作为输入(以及每个点的附加特征)并产生对 X 进行语义兴趣的信息。实际上,这样的 f 可以是为 X 分配标签的分类函数,也可以是为 M 的每个成员分配每个点标签的分割函数

3 Method

我们的工作可以被视为 PointNet [20] 的扩展,增加了层次结构。我们首先回顾 PointNet(第 3.1 节),然后介绍具有层次结构的 PointNet 的基本扩展(第 3.2 节)。最后,我们提出了 PointNet++,即使在非均匀采样的点集中也能够稳健地学习特征(第 3.3 节)

3.1 Review of PointNet [20]: A Universal Continuous Set Function Approximator回顾:通用连续集函数逼近器

给定一个无序点集 {x1, x2, …, xn} 且 xi ∈ Rd,我们可以定义一个集合函数 f : X → R 将一组点映射到一个向量

KaTeX parse error: Undefined control sequence: \mbox at position 63: …set{i=1,...,n}{\̲m̲b̲o̲x̲{MAX}}\left\{h(…

图 2:以 2D 欧几里德空间中的点为例,说明了我们的分层特征学习架构及其在集合分割和分类中的应用。此处可视化单尺度点分组。有关密度自适应分组的详细信息,请参见图 3,

其中 γ 和 h 通常是多层感知器 (MLP) 网络。方程中的集合函数f。 1 对于输入点排列是不变的,并且可以任意逼近任何连续集函数[20]。请注意,h 的响应可以解释为点的空间编码(详细信息请参阅[20])。 PointNet 在一些基准测试中取得了令人印象深刻的性能。然而,它缺乏捕捉不同尺度的当地背景的能力。我们将在下一节中引入分层特征学习框架来解决该限制

3.2 Hierarchical Point Set Feature Learning3.2 分层点集特征学习

虽然 PointNet 使用单个最大池化操作来聚合整个点集,但我们的新架构构建了点的分层分组,并沿着层次结构逐步抽象出越来越大的局部区域。我们的层次结构由许多抽象级别集合组成(图 2)。在每个级别,都会对一组点进行处理和抽象,以生成包含更少元素的新集合。集合抽象层由三个关键层组成:采样层、分组层和PointNet层。采样层从输入点中选择一组点,定义局部区域的质心。然后,分组层通过查找质心周围的“相邻”点来构造局部区域集。 PointNet 层使用迷你 PointNet 将局部区域模式编码为特征向量。一组抽象级别采用 N × (d + C) 矩阵作为输入,该矩阵来自具有 d 维坐标和 C 维点特征的 N 个点。它输出 N ′ × (d + C′) 矩阵,其中包含 N ′ 次采样点,具有 d-dim 坐标和总结局部上下文的新 C′-dim 特征向量。我们在下面的段落中介绍了一组抽象级别的层

Sampling layer.采样层

给定输入点 {x1, x2, …, xn},我们使用迭代最远点采样 (FPS) 来选择点的子集 {xi1 , xi2 , …, xim },使得 xij 是最远点(以公制距离表示)从集合 {xi1 , xi2 , …, xij−1 } 到其余点。与随机采样相比,在质心数量相同的情况下,它可以更好地覆盖整个点集。与扫描与数据分布无关的向量空间的 CNN 相比,我们的采样策略以数据相关的方式生成感受野。

Grouping layer分组层

该层的输入是大小为 N × (d + C) 的点集和大小为 N ’ × d 的质心集的坐标。输出是大小为 N ′ × K × (d + C) 的点集组,其中每个组对应于一个局部区域,K 是质心点邻域中的点数。请注意,K 因组而异,但后续的 PointNet 层能够将灵活数量的点转换为固定长度的局部区域特征向量。在卷积神经网络中,像素的局部区域由具有在像素的特定曼哈顿距离(内核大小)内的阵列索引的像素组成。在从度量空间采样的点集中,点的邻域由度量距离定义。 Ball查询查找查询点半径范围内的所有点(实现中设置了K的上限)。另一种范围查询是 K 最近邻 (kNN) 搜索,它会找到固定的 3 个相邻点。与 kNN 相比,ball 查询的局部邻域保证了固定的区域尺度,从而使局部区域特征在空间上更具泛化性,这对于需要局部模式识别(例如语义点标记)的任务来说是首选

PointNet layer.

在该层中,输入是数据大小为 N ’ ×K ×(d+C) 的 N ’ 个点的局部区域。输出中的每个局部区域都是由其质心和对质心邻域进行编码的局部特征进行抽象的。输出数据大小为 N ′ × (d + C′)。局部区域中的点的坐标首先被转换为相对于质心点的局部坐标系: x(j) i = x(j) i − ˆx(j) for i = 1, 2, …, K 且j = 1, 2, …, d 其中 ˆx 是质心的坐标。我们使用 PointNet [20],如第 2 节所述。 3.1 作为局部模式学习的基本构建块。通过使用相对坐标和点特征,我们可以捕获局部区域中的点对点关系。

3.3 Robust Feature Learning under Non-Uniform Sampling Densit 3.3 非均匀采样密度下的鲁棒特征学习

如前所述,点集在不同区域的密度不均匀是很常见的。这种不均匀性给点集特征学习带来了重大挑战。在密集数据中学习的特征可能无法推广到稀疏采样区域。因此,针对稀疏点云训练的模型可能无法识别细粒度的局部结构。理想情况下,我们希望尽可能仔细地检查点集,以捕获密集采样区域中的最精细细节。然而,在低密度区域禁止进行这种近距离检查,因为局部模式可能会因采样不足而被破坏。在这种情况下,我们应该在更邻近的地方寻找更大尺度的模式。为了实现这一目标,我们提出了密度自适应 PointNet 层(图 3),当输入采样密度发生变化时,该层学习组合不同尺度区域的特征。我们将具有密度自适应 PointNet 层的分层网络称为 PointNet++。以前在中学。 3.2、每个抽象级别包含单个尺度的分组和特征提取。在PointNet++中,每个抽象级别都会提取多个尺度的局部模式,并根据局部点密度将它们智能地组合起来。在对局部区域进行分组并结合不同尺度的特征方面,我们提出了两种类型的密度自适应层,如下所示。

图3:(a)多尺度分组(MSG); (b) 多分辨率分组(MRG)

多尺度分组(MSG)。

如图 3(a)所示,捕获多尺度模式的一种简单但有效的方法是应用不同尺度的分组层,然后根据 PointNet 提取每个尺度的特征。不同尺度的特征连接起来形成多尺度特征。我们训练网络学习结合多尺度特征的优化策略。这是通过对每个实例以随机概率随机丢弃输入点来完成的,我们称之为随机输入丢弃。具体来说,对于每个训练点集,我们选择从 [0, p] 中均匀采样的丢弃率 θ,其中 p ≤ 1。对于每个点,我们以概率 θ 随机丢弃一个点。在实践中,我们设置 p = 0.95 以避免生成空点集。在此过程中,我们向网络提供了各种稀疏性(由 θ 引起)和不同均匀性(由 dropout 的随机性引起)的训练集。在测试过程中,我们保留所有可用点。

多分辨率分组(MRG)。

上面的 MSG 方法的计算成本很高,因为它在每个质心点的大规模邻域中运行本地 PointNet。特别是,由于最低级别的质心点数量通常非常大,因此时间成本非常高。在这里,我们提出了一种替代方法,可以避免如此昂贵的计算,但仍然保留根据点的分布属性自适应聚合信息的能力。在图 3 (b) 中,某个级别 Li 的区域特征是两个向量的串联。通过使用设定的抽象级别从较低级别 Li−1 总结每个子区域的特征,获得一个向量(图中左侧)。另一个向量(右)是使用单个PointNet直接处理局部区域中的所有原始点获得的特征。当局部区域的密度较低时,第一个向量可能不如第二个向量可靠,因为计算第一个向量的子区域包含更稀疏的点,并且更容易受到采样不足的影响。在这种情况下,第二个向量的权重应该更高。另一方面

当局部区域的密度较高时,第一个向量提供更精细的细节信息,因为它具有在较低级别递归地以更高分辨率进行检查的能力。与 MSG 相比,该方法在计算上更加高效,因为我们避免了在最低级别的大规模邻域中进行特征提取

3.4 Point Feature Propagation for Set Segmentation用于集合分割的点特征传播

在集合抽象层中,对原始点集进行二次采样。然而,在语义点标记等集合分割任务中,我们希望获得所有原始点的点特征。一种解决方案是始终将所有点采样为所有设置的抽象级别中的质心,但这会导致较高的计算成本。另一种方法是将特征从子采样点传播到原始点。我们采用基于距离的插值和跨级跳跃链接的分层传播策略(如图2所示)。在特征传播级别中,我们将点特征从 Nl × (d + C) 点传播到 Nl−1 点,其中 Nl−1 和 Nl(其中 Nl ≤ Nl−1)是集合抽象级别的输入和输出的点集大小湖我们通过在 Nl−1 点的坐标处插值 Nl 点的特征值 f 来实现特征传播。在插值的众多选择中,我们使用基于 k 个最近邻的反距离加权平均值(如方程 2 中,默认情况下我们使用 p = 2,k = 3)。然后,将 Nl−1 点上的插值特征与来自设置抽象级别的跳跃链接点特征连接起来。然后连接的特征通过“单位点网”,这类似于 CNN 中的一对一卷积。应用一些共享的全连接层和 ReLU 层来更新每个点的特征向量。重复该过程,直到我们将特征传播到原始点集

KaTeX parse error: Undefined control sequence: \label at position 155: … j=1,...,C \̲l̲a̲b̲e̲l̲{eq:idw}

4 Experiments

数据集 我们对四个数据集进行评估,范围从 2D 对象(MNIST [11])、3D 对象(Model-Net40 [31] 刚性对象、SHREC15 [12] 非刚性对象)到真实 3D 场景(ScanNet [5])。对象分类通过准确性来评估。语义场景标记通过平均体素分类精度进行评估,如下[5]。我们在下面列出了每个数据集的实验设置:

MNIST:具有 60k 训练样本和 10k 测试样本的手写数字图像。

• ModelNet40:40 个类别的 CAD 模型(大部分是人造的)。我们使用官方划分的 9,843 个形状进行训练,2,468 个形状进行测试。

• SHREC15:50 个类别的 1200 个形状。每个类别包含 24 个形状,其中大部分是具有各种姿势的有机形状,例如马、猫等。我们使用五折交叉验证来获得该数据集的分类准确性。

• ScanNet:1513 个扫描和重建的室内场景。我们按照[5]中的实验设置,使用1201个场景进行训练,312个场景进行测试

4.1 Point Set Classification in Euclidean Metric Space4.1 欧氏度量空间中的点集分类

我们评估我们的网络对从 2D (MNIST) 和 3D (ModleNet40) 欧几里德空间采样的点云进行分类。 MNIST 图像转换为数字像素位置的 2D 点云。 3D 点云是从 ModelNet40 形状的网格表面采样的。默认情况下,我们对 MNIST 使用 512 个点,对 ModelNet40 使用 1024 个点。在表 2 的最后一行(我们的法线)中,我们使用面部法线作为附加点特征,其中我们还使用更多点 (N = 5000) 来进一步提高性能。所有点集均归一化为零均值且位于单位球内。我们使用具有三个完全连接层的三级分层网络 1 结果。在表 1 和表 2 中,我们将我们的方法与一组具有代表性的先前技术水平进行了比较。请注意,表 2 中的 PointNet (vanilla) 是 [20] 中不使用变换网络的版本,这相当于我们只有一层的分层网络。首先,我们的分层学习架构比非分层 PointNet [20] 取得了明显更好的性能。在 MNIST 中,我们看到错误率相对降低了 60.8% 和 34.6%

表 1:MNIST 数字分类。

表 2:ModelNet40 形状分类

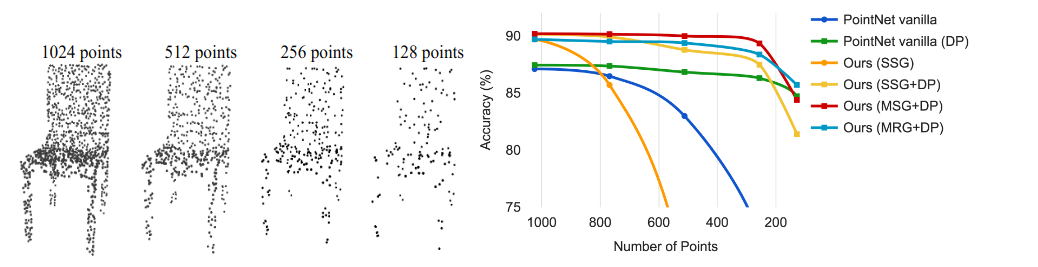

图 4:左:带有随机点丢失的点云。右:曲线显示我们的密度自适应策略在处理非均匀密度方面的优势。 DP表示训练时随机输入dropout;否则训练是在均匀密集的点上进行的。详细信息请参见第 3.3 节。

从 PointNet (vanilla) 和 PointNet 到我们的方法。在 ModelNet40 分类中,我们还看到,使用相同的输入数据大小(1024 个点)和特征(仅坐标),我们的分类明显强于 PointNet。其次,我们观察到基于点集的方法甚至可以实现与成熟图像 CNN 更好或相似的性能。在 MNIST 中,我们的方法(基于 2D 点集)达到了接近网络 CNN 中的网络的精度。在 ModelNet40 中,我们的正常信息显着优于之前最先进的方法 MVCNN [26]

对采样密度变化的鲁棒性。

直接从现实世界捕获的传感器数据通常会遇到严重的不规则采样问题(图 1)。我们的方法选择多个尺度的点邻域,并学习通过适当加权来平衡描述性和鲁棒性。我们在测试期间随机丢弃点(见图 4 左),以验证我们的网络对非均匀和稀疏数据的鲁棒性。在图 4 右侧,我们看到 MSG+DP(训练期间具有随机输入丢失的多尺度分组)和 MRG+DP(训练期间具有随机输入丢失的多分辨率分组)对于采样密度变化非常鲁棒。 MSG+DP 性能从 1024 个测试点下降到 256 个测试点,下降了不到 1%。此外,与替代方案相比,它在几乎所有采样密度上都实现了最佳性能。 PointNet vanilla [20] 在密度变化下相当稳健,因为它关注全局抽象而不是精细细节。然而,与我们的方法相比,细节的丢失也使其功能减弱。 SSG(在每个级别中采用单尺度分组的消融 PointNet++)无法推广到稀疏采样密度,而 SSG+DP 通过在训练时间内随机丢弃点来修正该问题。

4.2 Point Set Segmentation for Semantic Scene Labeling 用于语义场景标记的点集分割

为了验证我们的方法是否适合大规模点云分析,我们还评估了语义场景标记任务。目标是预测室内扫描中点的语义对象标签。 [5]提供了在体素化扫描上使用全卷积神经网络的基线。它们完全依赖于扫描几何图形而不是 RGB 信息,并以每个体素为基础报告准确性。为了进行公平的比较,我们在所有实验中删除了 RGB 信息,并将点云标签预测转换为体素标签,如下 [5]。我们还与[20]进行比较。图 5(蓝色条)中以每个体素为基础报告了准确性。我们的方法大大优于所有基线方法。与在体素化扫描上学习的[5]相比,我们直接在点云上学习以避免额外的量化误差,并进行数据相关抽样,以实现更有效的学习。与[20]相比,我们的方法引入了分层特征学习并捕获不同尺度的几何特征。这对于理解多个级别的场景以及标记不同尺寸的对象非常重要。我们在图 6 中可视化示例场景标记结果。

图 5:Scannet 标记准确度

图 6:Scannet 标记结果。 [20]正确地捕捉了房间的整体布局,但未能发现家具。相比之下,我们的方法在分割房间布局之外的对象方面要好得多。

4.3 Point Set Classification in Non-Euclidean Metric Space4.3 非欧度量空间中的点集分类

在本节中,我们将展示我们的非欧几里得空间方法的普遍性。在非刚性形状分类中(图7),一个好的分类器应该能够将图7中的(a)和(c)正确地分类为同一类别,即使它们的姿态存在差异,这需要内在结构的知识。 SHREC15 中的形状是嵌入 3D 空间中的 2D 表面。沿表面的测地距离自然地产生度量空间。我们通过实验表明,在这个度量空间中采用 PointNet++ 是捕获底层点集内在结构的有效方法。

对于[12]中的每个形状,我们首先构建由成对测地距离导出的度量空间。我们按照[23]获得模拟测地距离的嵌入度量。接下来,我们提取该度量空间中的内在点特征,包括 WKS [1]、HKS [27] 和多尺度高斯曲率 [16]。我们使用这些特征作为输入,然后根据底层度量空间对点进行采样和分组。通过这种方式,我们的网络学习捕获不受形状特定姿势影响的多尺度内在结构。替代设计选择包括使用 XY Z 坐标作为点特征或使用欧几里得空间 R3 作为基础度量空间。我们在下面展示这些都不是最佳选择。

结果。我们将我们的方法与表 3 中先前最先进的方法 [14] 进行比较。[14] 提取测地矩作为形状特征,并使用堆叠稀疏自动编码器来消化这些特征以预测形状类别。我们使用非欧几里得度量空间和内在特征的方法在所有设置中都实现了最佳性能,并且大大优于[14]。比较我们方法的第一和第二设置,我们发现内在特征对于非刚性形状分类非常重要。 XY Z 特征无法揭示内在结构,并且受姿态变化的影响很大。比较我们方法的第二个和第三个设置,我们发现与欧几里得邻域相比,使用测地线邻域是有益的。欧几里得邻域可能包括表面上远离的点,并且当形状提供非刚性变形时,该邻域可能会发生巨大变化。这给有效的权重共享带来了困难,因为局部结构可能变得组合复杂。另一方面,曲面上的测地邻域消除了这个问题并提高了学习效率。

表 3:SHREC15 非刚性形状分类

4.4 Feature Visualization特征可视化

在图 8 中,我们可视化了分层网络的第一级内核所学到的内容。我们在空间中创建了一个体素网格,并聚合了在网格单元中最能激活某些神经元的局部点集(使用最多 100 个示例)。得票高的网格单元被保留并转换回 3D 点云,代表神经元识别的模式。由于模型是在主要由家具组成的 ModelNet40 上训练的,因此我们在可视化中看到平面、双平面、线条、角等结构。

图 8:从第一层内核学习的 3D 点云模式。该模型针对 ModelNet40 形状分类进行训练(从 128 个内核中随机选择 20 个)。颜色表示点深度(红色为近,蓝色为远)

5 Related Work

分层特征学习的想法非常成功。在所有学习模型中,卷积神经网络[10,25,8]是最突出的模型之一。然而,卷积不适用于具有距离度量的无序点集,这是我们工作的重点。最近的一些著作 [20, 28] 研究了如何将深度学习应用于无序集合。即使点集确实拥有一个距离度量,它们也会忽略底层距离度量。因此,它们无法捕获点的局部上下文,并且对全局集转换和标准化敏感。在这项工作中,我们以从度量空间采样的点为目标,并通过在设计中明确考虑基础距离度量来解决这些问题。从度量空间采样的点通常是有噪声的并且采样密度不均匀。这会影响有效的点特征提取并导致学习困难。关键问题之一是为点特征设计选择合适的尺度。此前,在几何处理社区或摄影测量和遥感社区中,已经开发了几种与此相关的方法[19,17,2,6,7,30]。与所有这些工作相比,我们的方法学习提取点特征并以端到端的方式平衡多个特征尺度。在3D度量空间中,除了点集之外,深度学习还有几种流行的表示形式,包括体积网格[21,22,29]和几何图[3,15,33]。然而,这些工作都没有明确考虑采样密度不均匀的问题

6 Conclusion

在这项工作中,我们提出了 PointNet++,一种强大的神经网络架构,用于处理度量空间中采样的点集。 PointNet++ 在输入点集的嵌套分区上递归地运行,并且可以有效地学习关于距离度量的分层特征。为了处理非均匀点采样问题,我们提出了两个新颖的集合抽象层,它们根据局部点密度智能聚合多尺度信息。这些贡献使我们能够在具有挑战性的 3D 点云基准上实现最先进的性能。未来,值得思考如何通过在每个局部区域共享更多计算来加快我们提出的网络的推理速度,特别是对于 MSG 和 MRG 层。在高维度量空间中找到应用也很有趣,其中基于 CNN 的方法在计算上不可行,而我们的方法可以很好地扩展。 8

7 References

[1] M. Aubry, U. Schlickewei, and D. Cremers. The wave kernel signature: A quantum mechanical approach

to shape analysis. In Computer Vision Workshops (ICCV Workshops), 2011 IEEE International Conference

on, pages 1626–1633. IEEE, 2011.

[2] D. Belton and D. D. Lichti. Classification and segmentation of terrestrial laser scanner point clouds using

local variance information. Iaprs, Xxxvi, 5:44–49, 2006.

[3] J. Bruna, W. Zaremba, A. Szlam, and Y. LeCun. Spectral networks and locally connected networks on

graphs. arXiv preprint arXiv:1312.6203, 2013.

[4] A. X. Chang, T. Funkhouser, L. Guibas, P. Hanrahan, Q. Huang, Z. Li, S. Savarese, M. Savva, S. Song,

H. Su, J. Xiao, L. Yi, and F. Yu. ShapeNet: An Information-Rich 3D Model Repository. Technical Report

arXiv:1512.03012 [cs.GR], 2015.

[5] A. Dai, A. X. Chang, M. Savva, M. Halber, T. Funkhouser, and M. Nießner. Scannet: Richly-annotated 3d

reconstructions of indoor scenes. arXiv preprint arXiv:1702.04405, 2017.

[6] J. Demantké, C. Mallet, N. David, and B. Vallet. Dimensionality based scale selection in 3d lidar point

clouds. The International Archives of the Photogrammetry, Remote Sensing and Spatial Information

Sciences, 38(Part 5):W12, 2011.

[7] A. Gressin, C. Mallet, J. Demantké, and N. David. Towards 3d lidar point cloud registration improvement

using optimal neighborhood knowledge. ISPRS journal of photogrammetry and remote sensing, 79:240–

251, 2013.

[8] K. He, X. Zhang, S. Ren, and J. Sun. Deep residual learning for image recognition. In Proceedings of the

IEEE Conference on Computer Vision and Pattern Recognition, pages 770–778, 2016.

[9] D. Kingma and J. Ba. Adam: A method for stochastic optimization. arXiv preprint arXiv:1412.6980.

[10] A. Krizhevsky, I. Sutskever, and G. E. Hinton. Imagenet classification with deep convolutional neural

networks. In Advances in neural information processing systems, pages 1097–1105, 2012.

[11] Y. LeCun, L. Bottou, Y. Bengio, and P. Haffner. Gradient-based learning applied to document recognition.

Proceedings of the IEEE, 86(11):2278–2324, 1998.

[12] Z. Lian, J. Zhang, S. Choi, H. ElNaghy, J. El-Sana, T. Furuya, A. Giachetti, R. A. Guler, L. Lai, C. Li,

H. Li, F. A. Limberger, R. Martin, R. U. Nakanishi, A. P. Neto, L. G. Nonato, R. Ohbuchi, K. Pevzner,

D. Pickup, P. Rosin, A. Sharf, L. Sun, X. Sun, S. Tari, G. Unal, and R. C. Wilson. Non-rigid 3D Shape

Retrieval. In I. Pratikakis, M. Spagnuolo, T. Theoharis, L. V. Gool, and R. Veltkamp, editors, Eurographics

Workshop on 3D Object Retrieval. The Eurographics Association, 2015.

[13] M. Lin, Q. Chen, and S. Yan. Network in network. arXiv preprint arXiv:1312.4400, 2013.

[14] L. Luciano and A. B. Hamza. Deep learning with geodesic moments for 3d shape classification. Pattern

Recognition Letters, 2017.

[15] J. Masci, D. Boscaini, M. Bronstein, and P. Vandergheynst. Geodesic convolutional neural networks

on riemannian manifolds. In Proceedings of the IEEE International Conference on Computer Vision

Workshops, pages 37–45, 2015.

[16] M. Meyer, M. Desbrun, P. Schröder, A. H. Barr, et al. Discrete differential-geometry operators for

triangulated 2-manifolds. Visualization and mathematics, 3(2):52–58, 2002.

[17] N. J. MITRA, A. NGUYEN, and L. GUIBAS. Estimating surface normals in noisy point cloud data.

International Journal of Computational Geometry & Applications, 14(04n05):261–276, 2004.

[18] I. Occipital. Structure sensor-3d scanning, augmented reality, and more for mobile devices, 2016.

[19] M. Pauly, L. P. Kobbelt, and M. Gross. Point-based multiscale surface representation. ACM Transactions

on Graphics (TOG), 25(2):177–193, 2006.

[20] C. R. Qi, H. Su, K. Mo, and L. J. Guibas. Pointnet: Deep learning on point sets for 3d classification and

segmentation. arXiv preprint arXiv:1612.00593, 2016.

[21] C. R. Qi, H. Su, M. Nießner, A. Dai, M. Yan, and L. Guibas. Volumetric and multi-view cnns for object

classification on 3d data. In Proc. Computer Vision and Pattern Recognition (CVPR), IEEE, 2016.

[22] G. Riegler, A. O. Ulusoys, and A. Geiger. Octnet: Learning deep 3d representations at high resolutions.

arXiv preprint arXiv:1611.05009, 2016.

[23] R. M. Rustamov, Y. Lipman, and T. Funkhouser. Interior distance using barycentric coordinates. In

Computer Graphics Forum, volume 28, pages 1279–1288. Wiley Online Library, 2009.

[24] P. Y. Simard, D. Steinkraus, and J. C. Platt. Best practices for convolutional neural networks applied to

visual document analysis. In ICDAR, volume 3, pages 958–962, 2003.

[25] K. Simonyan and A. Zisserman. Very deep convolutional networks for large-scale image recognition.

arXiv preprint arXiv:1409.1556, 2014.

[26] H. Su, S. Maji, E. Kalogerakis, and E. G. Learned-Miller. Multi-view convolutional neural networks for 3d

shape recognition. In Proc. ICCV, to appear, 2015.

[27] J. Sun, M. Ovsjanikov, and L. Guibas. A concise and provably informative multi-scale signature based on

heat diffusion. In Computer graphics forum, volume 28, pages 1383–1392. Wiley Online Library, 2009.

[28] O. Vinyals, S. Bengio, and M. Kudlur. Order matters: Sequence to sequence for sets. arXiv preprint

arXiv:1511.06391, 2015.

9

[29] P.-S. WANG, Y. LIU, Y.-X. GUO, C.-Y. SUN, and X. TONG. O-cnn: Octree-based convolutional neural

networks for 3d shape analysis. 2017.

[30] M. Weinmann, B. Jutzi, S. Hinz, and C. Mallet. Semantic point cloud interpretation based on optimal

neighborhoods, relevant features and efficient classifiers. ISPRS Journal of Photogrammetry and Remote

Sensing, 105:286–304, 2015.

[31] Z. Wu, S. Song, A. Khosla, F. Yu, L. Zhang, X. Tang, and J. Xiao. 3d shapenets: A deep representation for

volumetric shapes. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,

pages 1912–1920, 2015.

[32] L. Yi, V. G. Kim, D. Ceylan, I.-C. Shen, M. Yan, H. Su, C. Lu, Q. Huang, A. Sheffer, and L. Guibas. A

scalable active framework for region annotation in 3d shape collections. SIGGRAPH Asia, 2016.

[33] L. Yi, H. Su, X. Guo, and L. Guibas. Syncspeccnn: Synchronized spectral cnn for 3d shape segmentation.

arXiv preprint arXiv:1612.00606, 2016.

10

本文介绍PointNet++,它是对PointNet的扩展,引入分层神经网络。PointNet无法捕获局部结构,而PointNet++递归应用PointNet到输入点集的嵌套分区,利用度量空间距离学习局部特征。还提出新颖集合学习层,能自适应组合多尺度特征,在3D点云基准上表现优于现有技术。

本文介绍PointNet++,它是对PointNet的扩展,引入分层神经网络。PointNet无法捕获局部结构,而PointNet++递归应用PointNet到输入点集的嵌套分区,利用度量空间距离学习局部特征。还提出新颖集合学习层,能自适应组合多尺度特征,在3D点云基准上表现优于现有技术。

1777

1777

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?