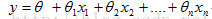

1.方程式表示:

数学形式:

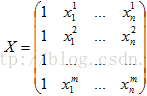

矩阵形式:

其中,X矩阵是m行(n+1)列的,每一行是一个样本,每一列是样本的某一个特征

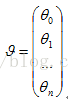

矩阵(n+1)行1列的,它是X的权重,也是线性回归要学习的参数.

矩阵(n+1)行1列的,它是X的权重,也是线性回归要学习的参数.

2.损失函数(Loss function)

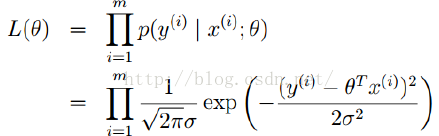

对数极大似然和最小二乘的联系:

由线性函数的假设知道,噪音项满足高斯分布,其中一个样本的正态分布的数学表达为:

那么,通过极大估计求得似然函数为所有样本的乘积,如下:

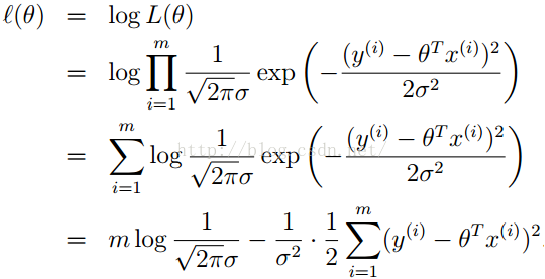

经过数学运算和推导,求极大似然的最大值可以转化为求其log函数的最大值,推导过程如下:

要使得极大似然取得极大值,上式中的后一项就要最小,也可以将求线性回归的极大似然转化为求最小二乘的最小值,也就是常见到的线性函数的最小二乘求损失函数的数学形式:

由此就得到了线性函数的loss function

3.线性函数算法:求解参数

机器算法的目的就是通过建立模型并通过选择合适的算法来求出参数

下的y和实际的Y之间的差值尽量的小,也就是预测的准确率在训练集和测试集足够高

下的y和实际的Y之间的差值尽量的小,也就是预测的准确率在训练集和测试集足够高

3.1 当矩阵

可逆(满秩)时,通过normal equation可以直接求解

可逆(满秩)时,通过normal equation可以直接求解

可逆(满秩)时,通过normal equation可以直接求解

可逆(满秩)时,通过normal equation可以直接求解

目标函数转化为矩阵形式:

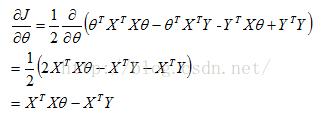

对其求导并求驻点

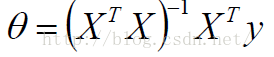

另上式为0,可求得

此算法的缺点是:当矩阵很大是,计算非常耗时且占用资源

3.2 当矩阵

不可逆(非满秩)时,通过梯度下降求解

不可逆(非满秩)时,通过梯度下降求解

不可逆(非满秩)时,通过梯度下降求解

不可逆(非满秩)时,通过梯度下降求解

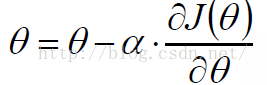

初始化

,沿着负梯度方向进行迭代,知道

,沿着负梯度方向进行迭代,知道

变化很小或者不变化

变化很小或者不变化

,沿着负梯度方向进行迭代,知道

,沿着负梯度方向进行迭代,知道

梯度下降中设计到的参数是,步长alpha,迭代次数t,这些对于计算最终的

都会影响,所以需要调参优化。

都会影响,所以需要调参优化。

常用的梯度下降算法有SGD,BGD,mBGD,实际中以mBGD使用最多

4.线性回归防止overfitting

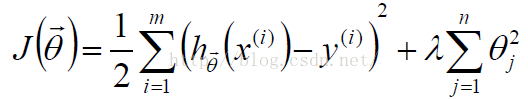

机器学习最忌讳的是死记硬背,像考试一样平时学习只记得死答案了,在考试的时候就不会做题目了,为了灵活变通,overfitting的方法就出现了,线性回归中最常用的是引入正则化项,也就惩罚项,给损失函数的参数

赋予一个约束项,使其不能任意的无限大或者无限小,加入正则化损失函数变为:

赋予一个约束项,使其不能任意的无限大或者无限小,加入正则化损失函数变为:

赋予一个约束项,使其不能任意的无限大或者无限小,加入正则化损失函数变为:

赋予一个约束项,使其不能任意的无限大或者无限小,加入正则化损失函数变为:

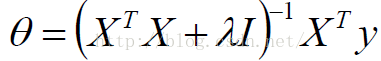

4.1当矩阵满秩时,引入正则项后的

变为:

变为:

变为:

变为:

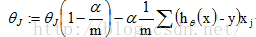

4.2当矩阵不满秩时,引入正则项后的

变为:

变为:

变为:

变为:

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?