使用TensorBoard进行数据可视化

除了python的matplotlib这个数据图像化的包,我们还可以使用Tensorflow自带的TensorBoard来将数据进行可视化,实现的代码如下

import tensorflow as tf

import numpy as np

def add_layer(inputs, in_size, out_size, n_layer, activation_function=None):

layer_name = 'layer%s' % n_layer

with tf.name_scope("layer"):

with tf.name_scope("weight"):

Weights = tf.Variable(tf.random_normal([in_size,out_size]),name="W")

tf.summary.histogram(layer_name+'/Weights',Weights)

with tf.name_scope("biases"):

biases = tf.Variable(tf.zeros([1, out_size])+0.1,name="b")

tf.summary.histogram(layer_name+'/biases',biases)

with tf.name_scope("Wx_plus_b"):

Wx_plus_b = tf.matmul(inputs, Weights)+biases

if activation_function == None:

outputs = Wx_plus_b

else:

outputs = activation_function(Wx_plus_b)

tf.summary.histogram(layer_name+'/outputs',outputs)

return outputs

x_data = np.linspace(-1,1,300)[:,np.newaxis]

noise = np.random.normal(0,0.05,x_data.shape)

y_data = np.square(x_data) - 0.5 + noise

with tf.name_scope("inputs"):

xs = tf.placeholder(tf.float32,[None,1],name="x_input")

ys = tf.placeholder(tf.float32,[None,1],name="y_input")

l1 = add_layer(xs, 1, 10, n_layer=1, activation_function=tf.nn.relu)

prediction = add_layer(l1, 10, 1, n_layer=2, activation_function=None)

with tf.name_scope("loss"):

loss = tf.reduce_mean(tf.reduce_sum(tf.square(ys-prediction),reduction_indices=[1]),name="loss")

tf.summary.scalar('loss',loss)

with tf.name_scope("train"):

train_step = tf.train.GradientDescentOptimizer(0.1).minimize(loss)

init = tf.global_variables_initializer()

sess = tf.Session()

merged = tf.summary.merge_all()

writer = tf.summary.FileWriter("logs/",sess.graph)

sess.run(init)

for i in range(1000):

sess.run(train_step,feed_dict={xs:x_data,ys:y_data})

if i%50==0:

result = sess.run(merged,feed_dict={xs:x_data,ys:y_data})

writer.add_summary(result,i)

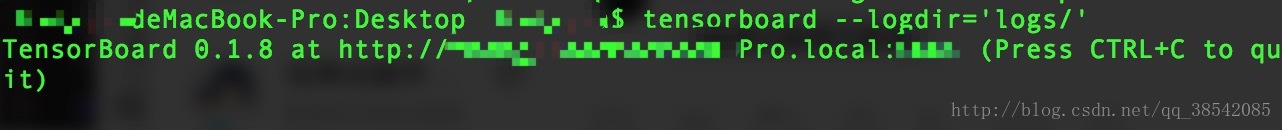

代码进行保存以及运行之后,将会在指定文件夹中看到保存的文件,这是我们需要在终端中运行下面的命令,然后将网址复制到浏览器即可打开

$ tensorboard --logdir='logs/'

注:

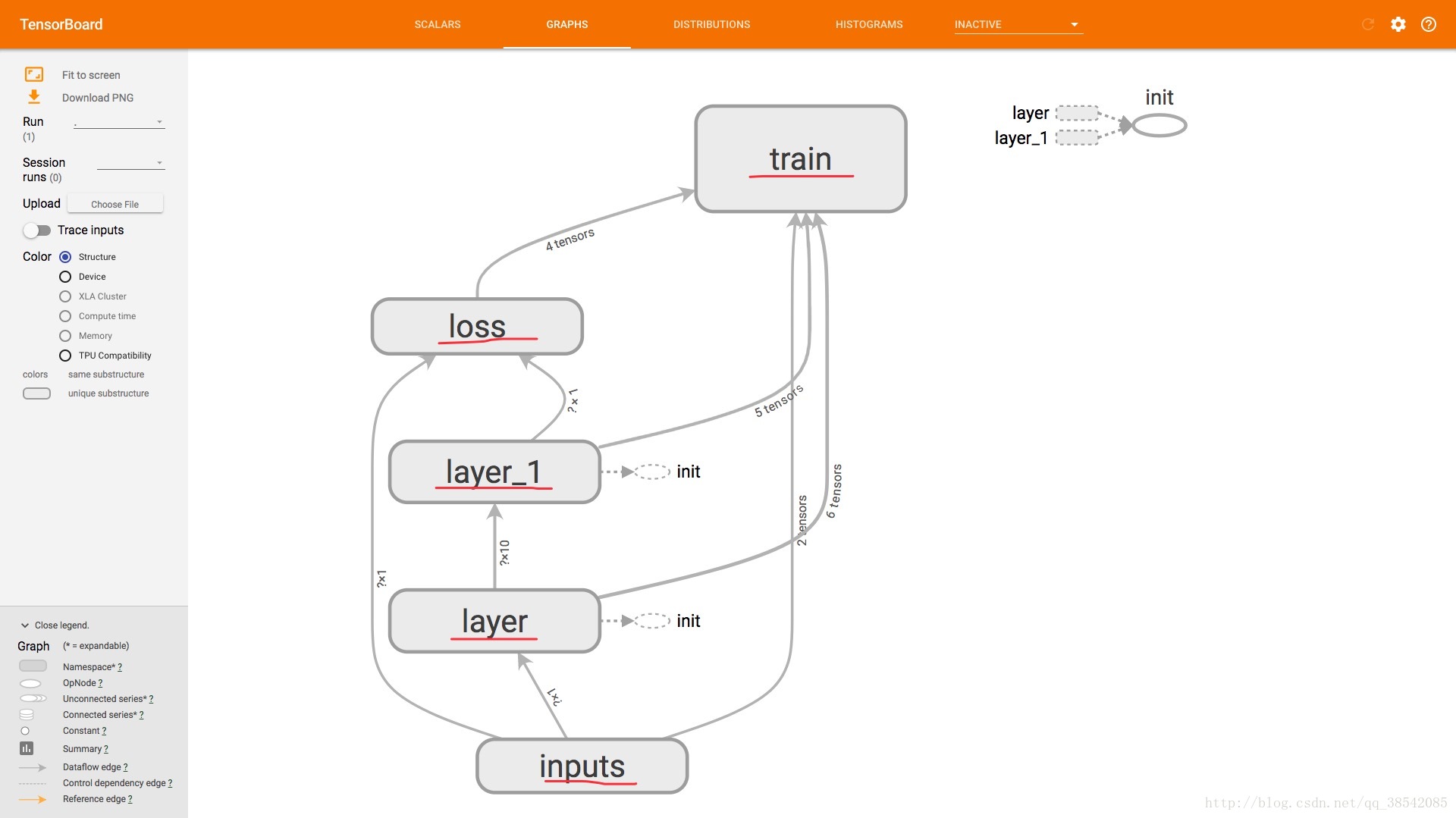

1.

tf.name_scope("name")

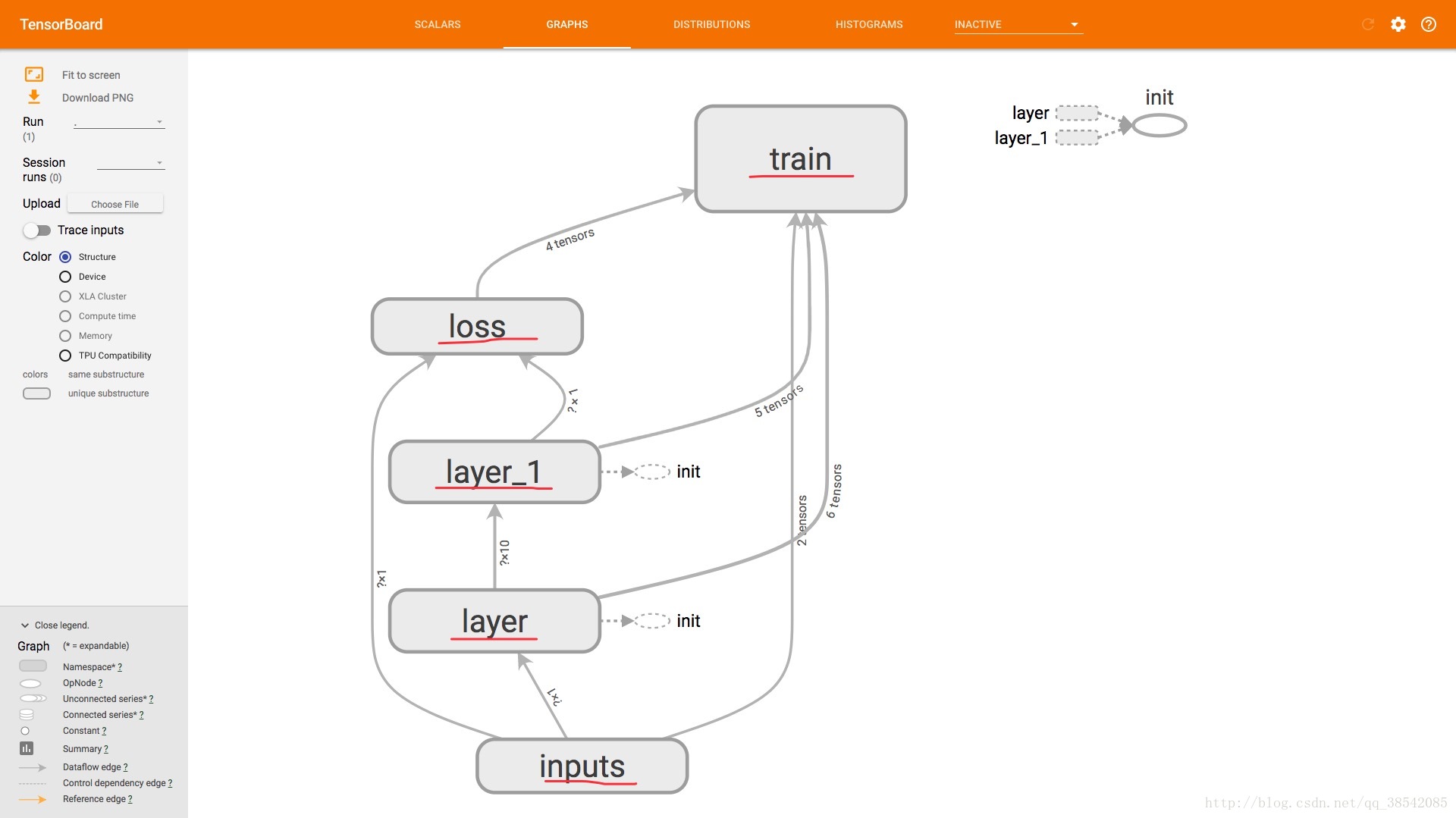

该函数中的name是指GRAPHS中的

以及每个神经网络的节点打开后里面的各种量的名字

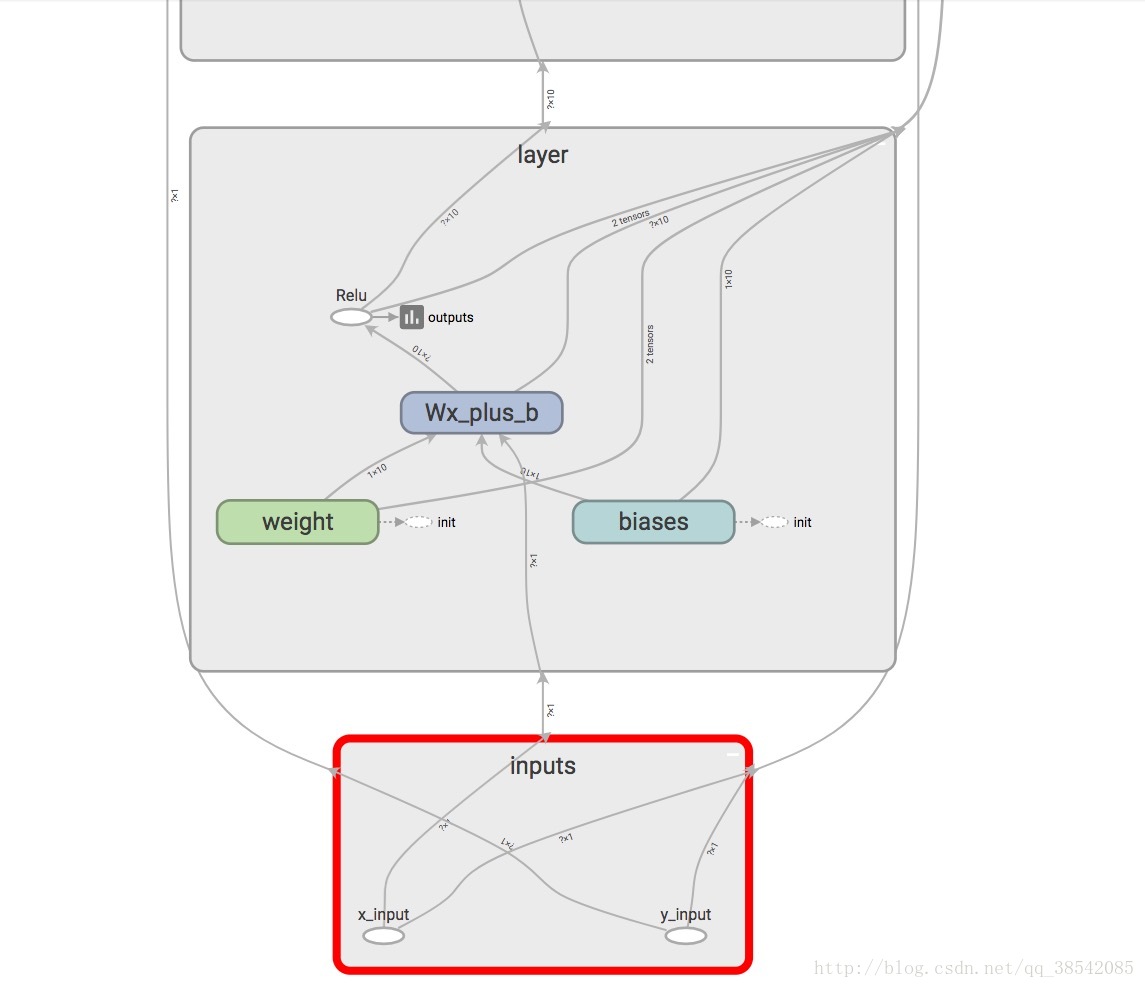

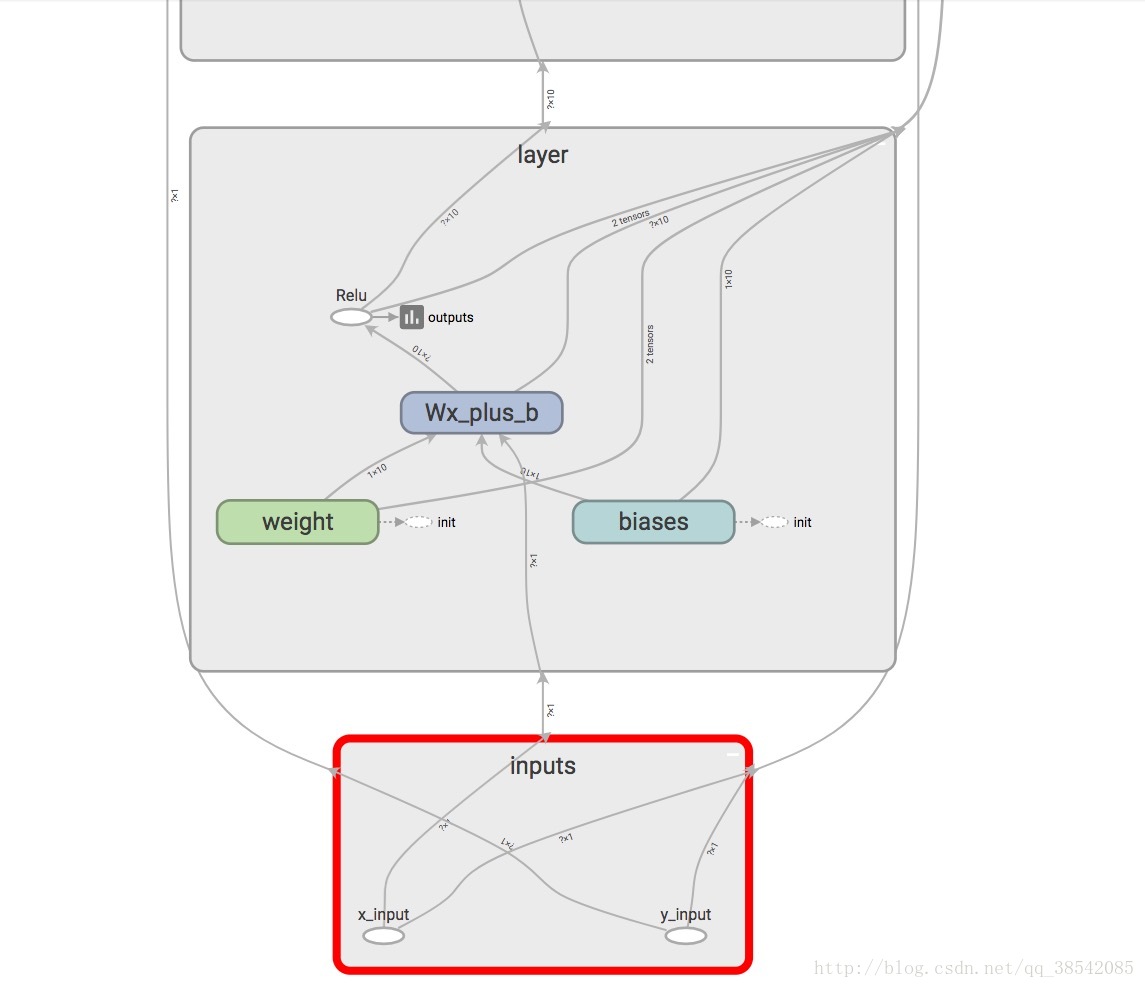

这是部分节点点开后的样子

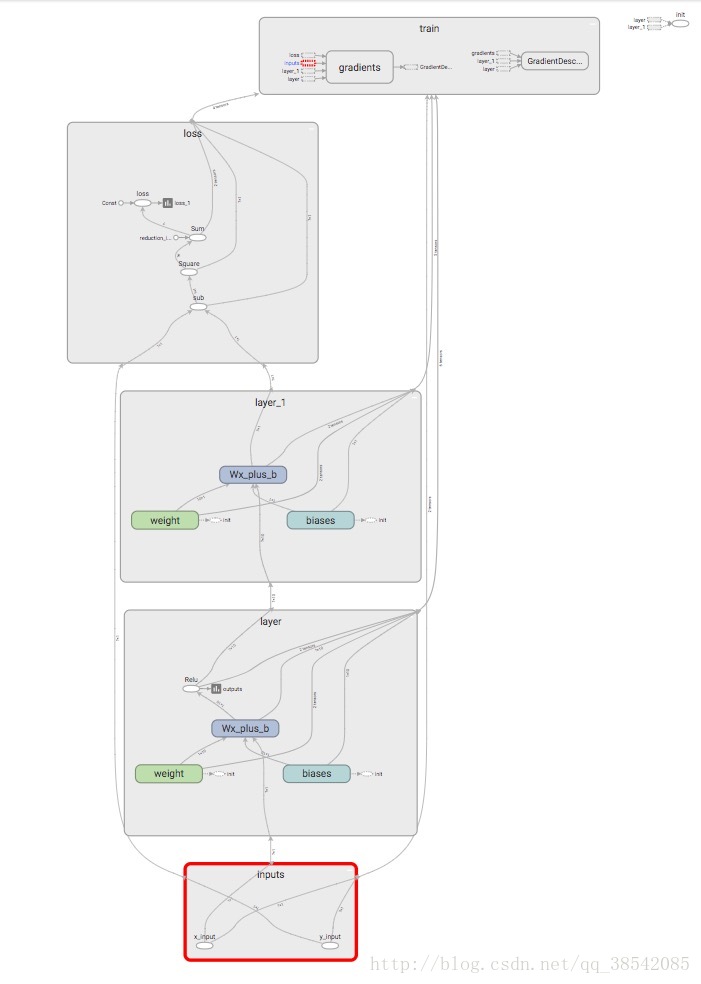

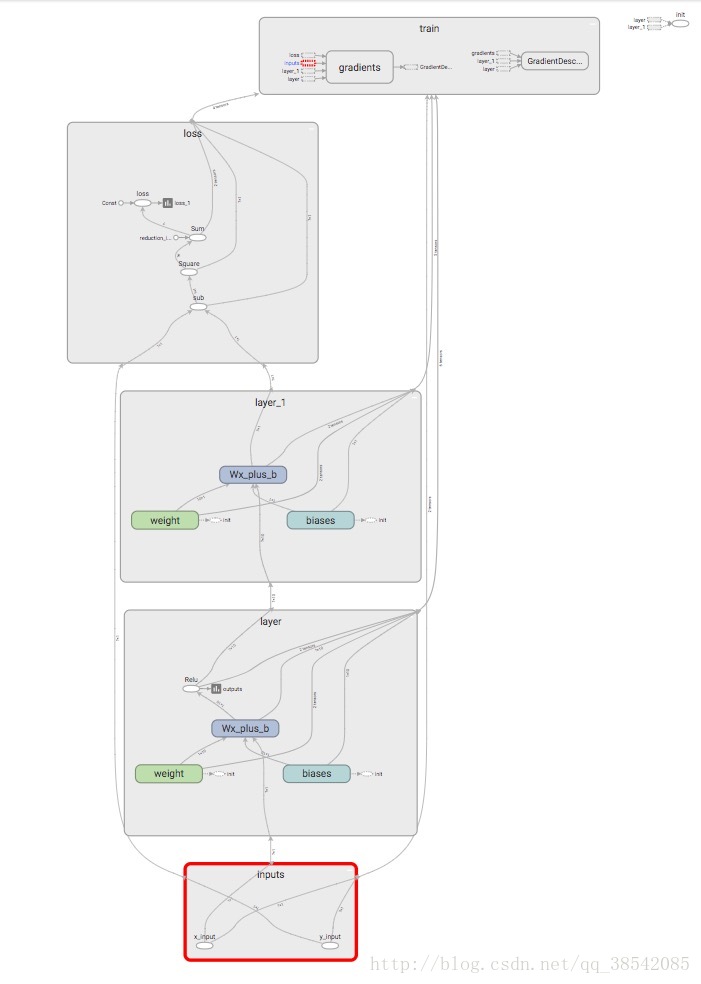

这是所有节点点开后的样子

2.

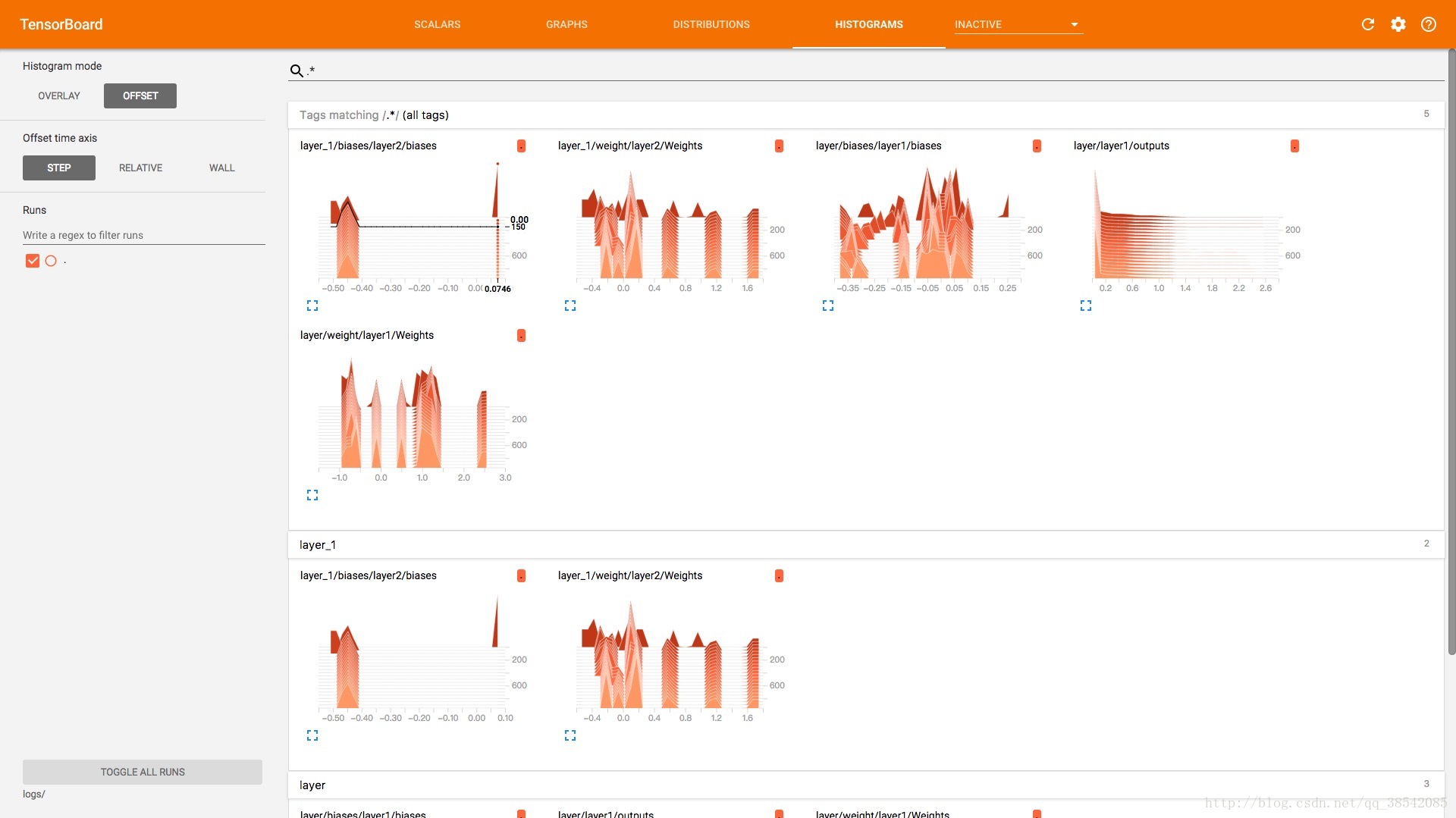

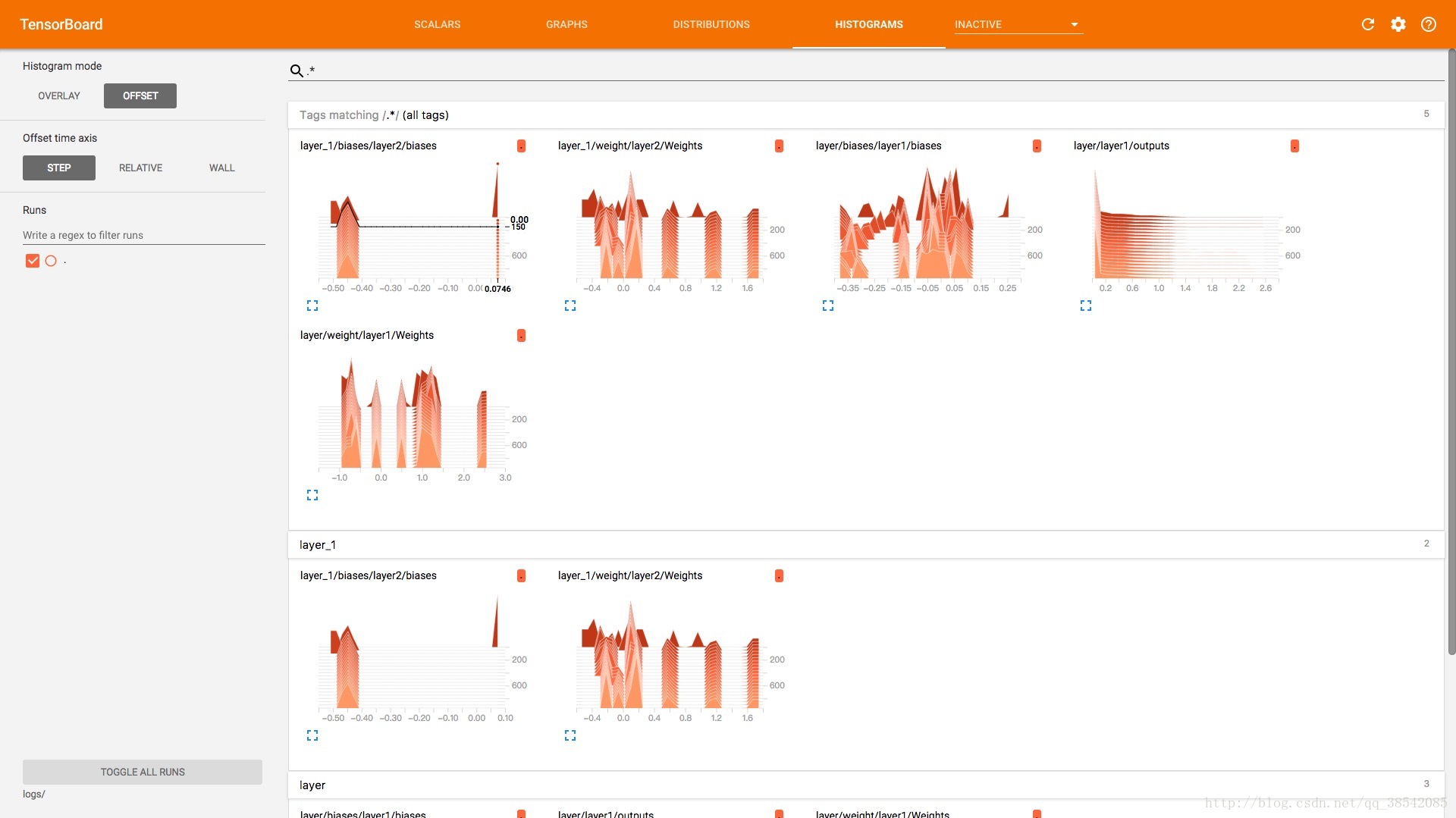

tf.summary.histogram(layer_name+'name',name)

该函数是用来绘制histogram中图可视化绘图

3.

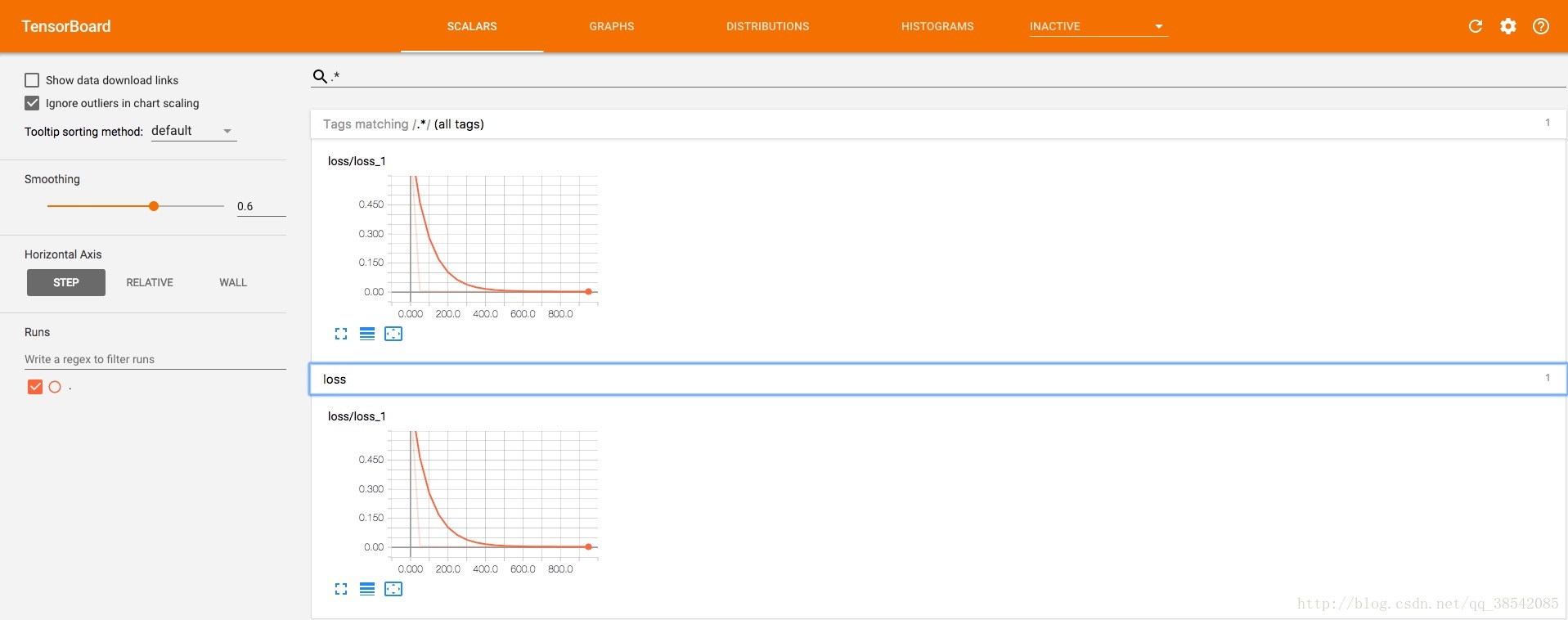

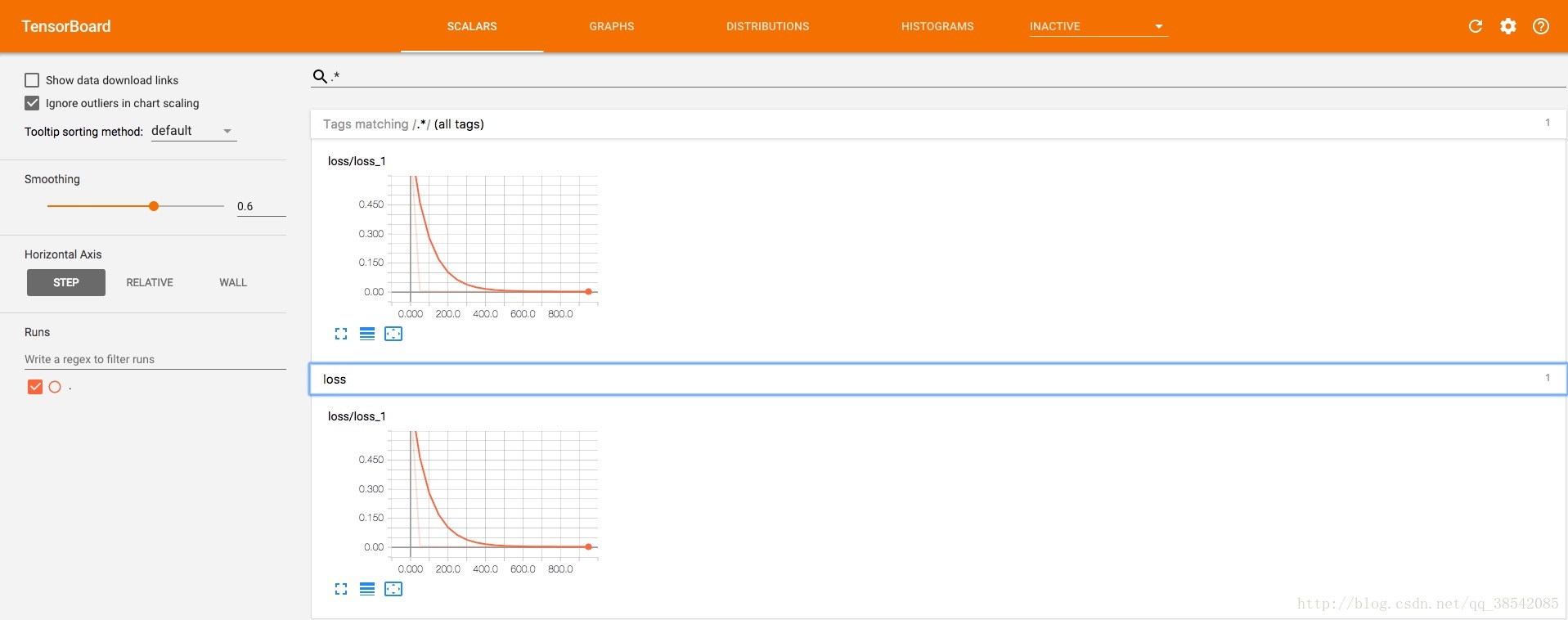

tf.summary.scalar('name',name)

该函数主要适用于损失函数在scalar的可视化绘图

4.

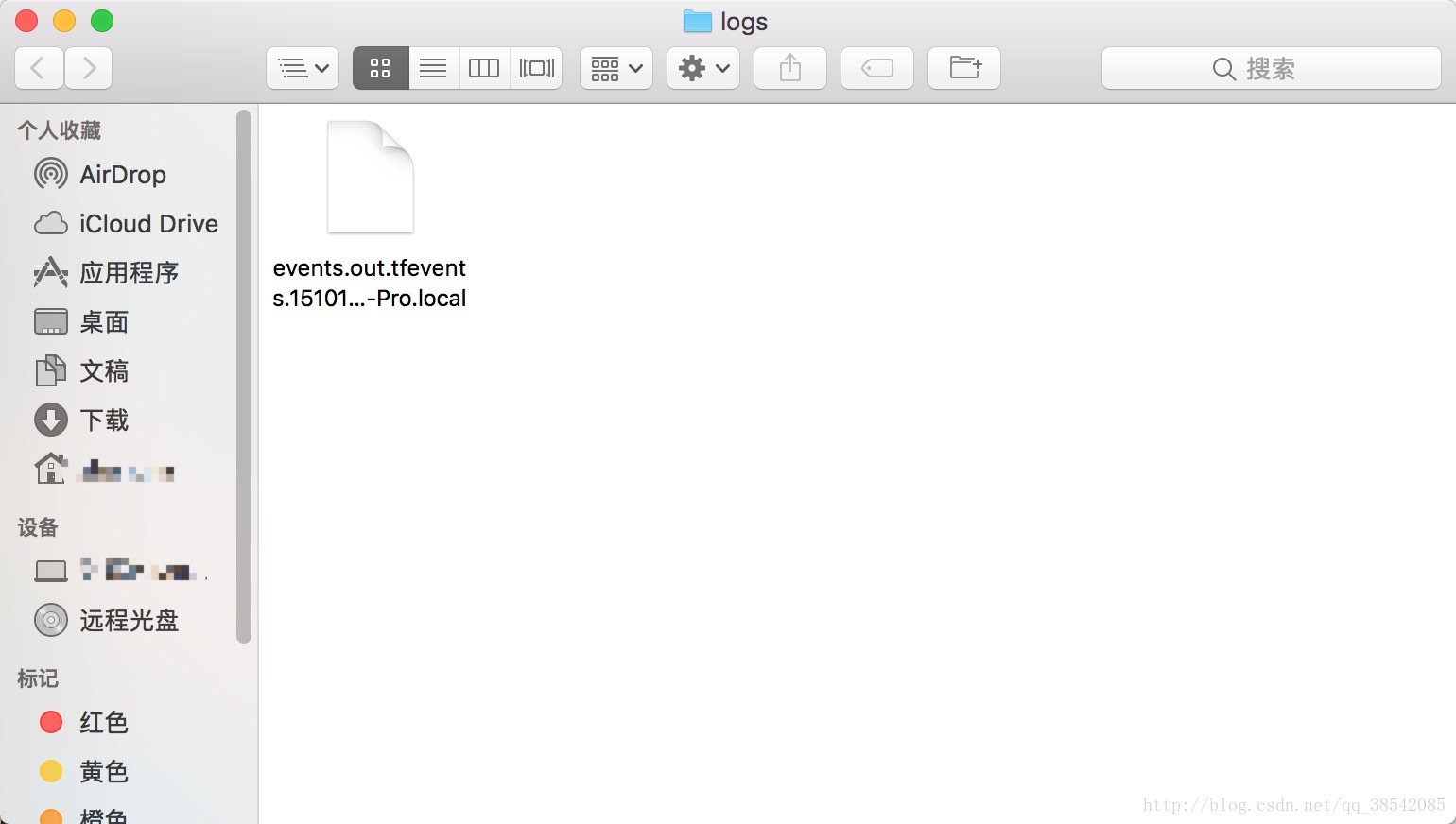

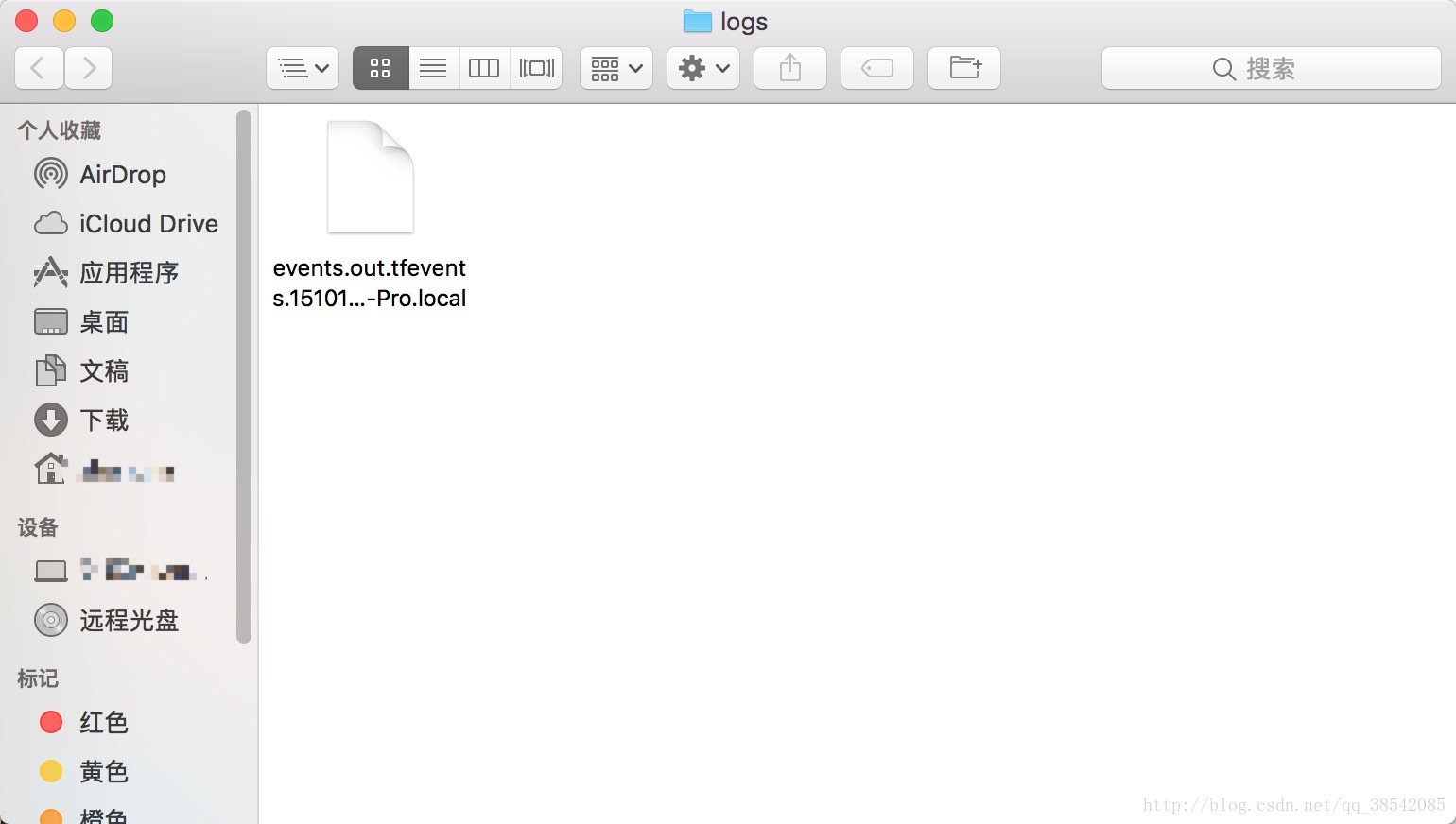

tf.summary.FileWriter("logs/",sess.graph)

该函数是将TensorBoard文件保存到指定路径,例如”logs/”即是指路径,正常运行后将会在logs文件夹下产生一个文件

5.

tf.summary.merge_all()

该函数是将所有summary文件合并到同一个文件里并在下一步的tf.summary.FileWriter(“logs/”,sess.graph)进行保存

6.

add_summary(result,i)

该函数是将result这个数据加入到writer = tf.summary.FileWriter(“logs/”,sess.graph)这个函数的write中去,其中i是指步数,例如本函数中就是50布记录一个点

7.运行应该在ipython中运行,如果在jupyter中运行可能会产生报错

290

290

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?