1 LSTM复习

机器学习笔记 RNN初探 & LSTM_UQI-LIUWJ的博客-CSDN博客 中,我们使用的是这样的一张图来说明LSTM:

这里为了和GRU有一个比较,使用如下的图表示LSTM,意思是一样的,绿色和紫色的部分是二者的对照关系:

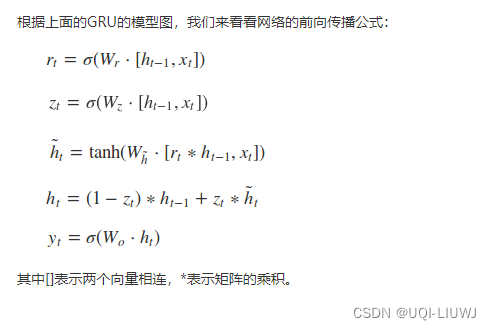

2 GRU 原理

在GRU模型中只有两个门:分别是更新门zt和重置门rt

更新门用于控制前一时刻的状态信息被带入到当前状态中的程度,更新门的值越大说明前一时刻的状态信息带入越多

重置门控制前一状态有多少信息被写入到当前的候选集上,重置门越小,前一状态的信息被写入的越少。

——>我们使用了同一个门控 就同时可以进行遗忘和选择记忆(LSTM则要使用两个门控)。

——>与LSTM相比,GRU内部少了一个”门控“,参数比LSTM少,但是却也能够达到与LSTM相当的功能。考虑到硬件的计算能力和时间成本,因而很多时候我们也就会选择更加”实用“的GRU。

——>在GRU中 输入h就是记忆c,所以没有输出门。(把LSTM里面的两个传递量减少成了一个)

本文深入探讨了LSTM(长短期记忆网络)和GRU(门控循环单元)两种循环神经网络的区别。LSTM通过输入门、遗忘门和输出门控制信息流动,而GRU则使用更新门和重置门实现类似功能,但结构更简洁,参数更少。尽管GRU缺少一个门控,但在许多任务中仍能与LSTM相媲美,常因其高效计算而被选用。

本文深入探讨了LSTM(长短期记忆网络)和GRU(门控循环单元)两种循环神经网络的区别。LSTM通过输入门、遗忘门和输出门控制信息流动,而GRU则使用更新门和重置门实现类似功能,但结构更简洁,参数更少。尽管GRU缺少一个门控,但在许多任务中仍能与LSTM相媲美,常因其高效计算而被选用。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?