AAAI 2025

1 INTRO

- 对于多目标学习(multi-task learning),多个loss之间权重如何选取,是一个很复杂很费事的过程

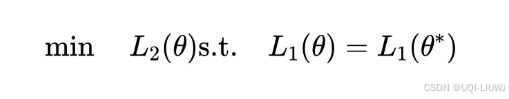

- 与此同时,如果多个loss存在优先级的高低,那么如何在保证高优先级目标的情况下,考虑低优先级的loss呢?

- ——>论文提出了NMT,不需要调整参数,就可以实现在高优先级目标不受破坏的前提下,最大化低优先级目标

2 方法

2.1 两个目标的情况

- 假设T1是高优先级目标,T2是低优先级目标(加入T2目标的时候,模型在目标T1上的表现不能被减弱)

是

的极小值点,可以通过优化

得到(梯度下降)

- ——>对应的拉格朗日函数为

- KKT条件为

- 论文理论分析了,只需要在正常神经网络参数θ做梯度下降的同时,对拉格朗日函数中的λ做梯度上升,即可达到优化目标

- 也即λ的更新公式为

- 也即λ的更新公式为

- 当然,当λ较大的时候,损失函数的约束项

变得非常大,从而导致在梯度下降中参数θ发生大幅度的更新

- ——>使用了重缩放,对θ梯度下降时,loss变为:

- ——>使用了重缩放,对θ梯度下降时,loss变为:

2.2 多目标的情况

- 逐步优化次要目标

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?