A Rapid Scene Depth Estimation Model Based on Underwater Light Attenuation Prior for Underwater Image Restoration

https://doi.org/10.1007/978-3-030-00776-8_62

R. Hong et al. (Eds.): PCM 2018, LNCS 11164, pp. 678–688, 2018.

文章目录

Abstract

水下图像由于光在水介质中的吸收和散射而出现模糊和色差。在利用图像形成模型(image formation model, IFM)恢复水下图像时,场景深度图对于透射图和背景光强度的估计非常重要。本文针对水下图像提出了一种快速有效的基于水下光衰减先验(ULAP)的场景深度估计模型,并利用基于学习的监督线性回归对模型系数进行训练。有了正确的深度图,估计R-G-B光的背景光(BL)和透射图(TMs)去恢复水下真实场景的亮度是很简单的。为了评价使用估计深度图进行水下图像恢复的优越性,三个评价指标表明,与现有的四种图像恢复方法相比,本文提出的方法可以在较短的运行时间内增强感知效果。

一、Introduction

由于水下环境复杂,图像受水体浑浊度和光衰减[1]的影响而退化,水下图像恢复具有挑战性。与绿色(G)和蓝色(B)光相比,波长较长的红色®光受影响最大,因此水下图像呈现蓝绿色色调。在我们的前期工作中,详细介绍了水下图像的光学成像模型和光的选择衰减。

一种图像复原方法是考虑光在水介质中传播的基本物理原理来恢复水下图像。恢复的目的是推导物理模型的参数,然后通过预留补偿处理恢复水下图像。一种简化的图像形成模型(IFM)常用于近似水下大气散射的传播方程,可表示为:

入和场景-摄像机距离d(x)的函数,可以表示为:

归一化剩余能量比 取决于一个通道的波长和水的类型

在基于IFM的图像恢复方法中,合适的场景深度图是估计背景光和透射图的关键。因为光线散射和颜色变化引起的水下图像的雾状效应类似于空气中的雾状效应,使用暗通道先验(DCP)及其变体进行深度估计和恢复。Li等通过最大强度先验(MIP)图对背景光进行估计,以去霾G-B通道,并使用GrayWorld (G-W)理论对R通道进行校正。但是Peng等发现之前的背景光估计方法对于各种水下图像都不具有鲁棒性,他们提出了一种基于图像模糊和光吸收的方法来估计更精确的背景光和场景深度,从而精确恢复水下彩色图像。

近年来,基于学习的水下图像增强方法受到了广泛的关注。Liu等提出了深度稀疏非负矩阵分解(deep sparse non-negative matrix factorization, DSNMF)估计图像光照以实现图像颜色恒定。Ding等基于自适应色彩校正生成的平衡图像,使用卷积神经网络(CNN)估计深度图。虽然上述方法可以获得场景深度图,对水下图像进行增强,但深度学习耗时较长。Zhu等人提出了一种基于颜色衰减先验的模糊图像场景深度线性预测模型,该模型采用监督学习方法进行训练,其表达式为:

该模型能够成功地恢复室外雾霾图像的场景深度图。不幸的是,它不适用于水下图像。图1显示了一个错误深度图和无效恢复图像的示例图像。

在本文中,我们揭示了水下光衰减先验(ULAP),场景深度随着G和B光最大值与R光值的差值的增大而增大。在ULAP和带注释的场景深度数据的基础上,训练了一个场景深度估计的线性模型。利用精确的场景深度图,可以很容易地估计出BL和TM,从而很好地恢复水下图像。

二、Scene Depth Model Based on ULAP

2.1 Underwater Light Attenuation Prior

由于水下场景信息较少,模糊水下图像的恢复是计算机视觉的一个难点。但是,人类可以在没有任何辅助信息的情况下快速识别水下图像的场景深度。当我们进行鲁棒背景光估计时,深度图中与原始水下图像相对应的最远点通常被认为是背景光候选点。由于光在水下的衰减,根据红光能量比绿光和蓝光吸收更多的波长,利用R光和G-B光的强度差来估计背景光。这一规则促使我们对不同的水下图像进行实验,以发现一个有效的水下图像恢复的先验。

检查大量的水下图像后,我们发现水下光衰减(ULAP)之前,这就是G-B强度的最大值之间的差异(简化为MVGB)和R的值强度(简化为VR)的水下图像的一个像素非常场景深度的变化紧密相关。图2以一个典型的水下场景为例,展示了MVGB、VR以及在不同深度内随着场景的变化而变化的差异。如图2(a)所示,我们从近景到远景选取三个区域作为测试数据,并在右侧显示对应的特写。

在图2(b)的左侧直方图中,在接近区域,MVGB和VR相对适中,差异接近于零;在图2(b)的中间直方图中,中等接近区域的MVGB增大,而随着场景深度的增加,VR同时减小,产生了更高的差值。此外,在极值场景中,由于衰减明显红光分量并不多,MVGB得到了显著的改善,并且在图2(b)的右侧直方图中,这种差异明显高于其他斑块。综上所述,当场景走向较远区域时,MVGB增大,VR减小,使得场景深度与MVGB与VR的差值呈正相关。

2.2 Scene Depth Estimation

基于ULAP,我们定义了一个MVGB和VR的线性模型,用于深度图估计:

-

The Training Data. 为了准确地学习系数u0, u1和u2,我们需要相对正确的训练数据。参考Peng提出的深度图估计,我们基于光吸收和图像模糊计算不同水下图像的深度图。跟踪得到500张水下图像深度图,丢弃了一些存在明显估计误差(如深度中有一条近距离鱼为白色)的深度图。因此,100个完全合适的深度地图是精心选择的最终手动选择。训练样本的生成过程如图3所示。首先,对于500幅水下图像,采用深度图估计方法获得相同尺寸的对应深度图,然后从中确定100幅精确的深度图作为最终的训练数据。其次,本文使用导向滤波器[14]对粗糙深度图进行细化,并将导向滤波器的半径设为15。最后,根据对场景深度的感知,通过手动选择,得到100张精确的深度图。准备好的数据集共有2400万个深度信息点,称为参考深度图(rdm)。

-

Coefficients Learning. 在参考深度图(rdm)的基础上,首先对MVGB和VR进行Pearson相关分析。皮尔逊校正系数(Pearson correction coefficient, PCC)的取值范围为[−1,1],当PCC接近1或−1时,表明二者是完全线性关系;当PCC接近0时,表明两者没有关系。MVGB和VR的PCC分别为0.41257和−0.67181 (a <=0.001)。我们可以很容易地看到,在rdm和MVGB之间,以及在rdm和VR之间存在着紧密的相关性。因此,(4)中提出的模型是合理的。训练模型时,训练数据集与测试数据集的比例为7:3,采用10次交叉验证。最佳学习效果为:u0=0.53214829,u1=0.51309827,u2=-0.91066194。一旦确定了系数的值,该模型将用于生成不同场景下单个水下图像的场景深度。

-

Estimation of the Depth Map由于场景深度图d(x)之间的关系,并且已经学习了系数,任何水下图像的深度图都可以通过公式(4)得到。为了检验该假设的有效性,我们从几个著名的图片网站,如Google Images、Filck.com,收集了大量的水下图片数据库,并计算了每张测试图片的水下场景深度图。一些结果显示在图4中。对于不同类型的输入水下图像,相应的估计粗略深度图和细化深度图分别显示在图4(a)-©中。可以看出,估计的深度图在较远的深度内的区域颜色较亮,而在较近的区域颜色较浅,这是预期的。在获得正确的深度图后,背景光的估计和RGB的透射图就相当简单和迅速。

三、Underwater Image Restoration

3.1 Background Light Estimation

公式(1)中的背景光BL通常被估计为水下图像中最亮的像素。然而,这个假设在某些情况下是不正确的,例如,前景物体比背景光更亮。背景光是从输入的水下图像中最远的地方选择的,也就是说,在细化的深度图中的最大值的位置。即输入水下图像对应的精细化深度图中的最大值的位置为背景光的候选值。但直接选择最远的点作为最终的背景光,一些悬浮颗粒会干扰有效的估计结果。在生成准确的深度图后,我们首先通过选择0.1%的最远点来消除悬浮颗粒的影响。通过选择0.1%的最远点,然后选择原始水下图像中强度最高的像素。然后选择原始水下图像中强度最高的像素。说明了背景光估计方法的例子显示在图5。

3.2 Transmission Map Estimation for Respective R-G-B Channel

相对深度图不能直接用于估计R-G-B通道的最终TM。为了测量从摄像机到每个场景点的距离,实际场景深度图da定义如下:

其中D无穷是一个比例常数,用于将相对距离转换为实际距离,在本文中,D无穷被设定为10。有了估计的da,我们可以计算出 R-G-B信道的TM为

在世界约98%的清澈海洋或沿海水域(海洋类型I)。 红光、绿光和红光中Nrer (入)的认可范围分别为80%-85%、93%-97%。 和95%-99%[7]。在本文中,我们设定R-G-B光的Nrer(入)为0.83,0.95和0.97,图6©-(e)给出了基于公式(5)-(6)蓝绿色水下通道的TMs的例子。图6©-(e) 给出了基于公式的一个蓝绿色水下图像的RGB通道的TMs的例子 。

现在我们有了R-G-B通道的BL入和t入(x),我们可以用公式(7)恢复水下场景亮度Jk。用公式(7)恢复水下场景亮度Jk。根据经验,t入(x)的下限和上限分别为0.1和0.9。

图6(f)和图7(f)显示了通过我们提出的方法恢复的一些最终结果。

四、Results and Discussion

对比试验:

- the typical image dehazing method by He et al.(He, K.M., Sun, J., Tang, X.O.: Single image haze removal using dark channel prior. IEEE

Trans. Pattern Anal. Mach. Intell. 33(12), 2341–2353 (2011)) - the variant of the DCP (UDCP) by Drew et al.(Drews, P., Nascimento, E., Moraes, F., Botelho, S., Campos, M.: Transmission Estimation in

Underwater Single Images. In: Proceedings of IEEE ICCVW 2013, pp. 825–830 (2013)) - the image restoration based on the dehazing of G-B channel and the

correction of R channel(Li, C.Y., Quo, J.C., Pang, Y.W., Chen, S.J., Wang, J.: Single underwater image restoration

by blue-green channels dehazing and red channel correction. In: ICASSP 2016, pp. 1731–

1735 (2016)) - Peng et al.’s methodbased on both the image blurriness and light

absorption(Peng, Y.T., Cosman, P.C.: Underwater image restoration based on image blurriness and light

absorption. IEEE Trans. Image Process. 26(4), 1579–1594 (2017))

图7(a)显示了来自我们水下图像数据集的四幅原始水下图像,它们在色调和场景方面具有不同的水下特征。在图7(b)中,由于深度图估计错误,DCP对测试图像没有或很少工作。这说明直接应用户外图像去雾的方法不适用于水下图像恢复。从图7©可以看出,UDCP不能恢复水下图像的场景,甚至会带来颜色失真和误差恢复。如图7(d) - (f)所示,虽然所有的方法都可以去除输入图像的雾霾,但由于在估计透射图或背景光时忽略了水下光选择衰减,所以图7(d - e)的颜色和对比度不如图7(f)。如图7(f)所示,我们的图像恢复方法可以有效地对不同的水下图像进行散点去雾,改善输入图像的细节和色彩,最终生成自然的水下图像。

4.1 Quantitative Assessment

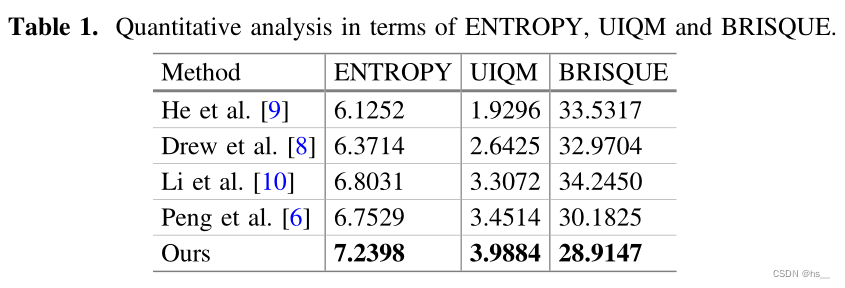

quantitative metrics: ENTROPY, UIQM and BRISQUE

表1列出了3个指标对回收的100幅低质量水下图像的平均得分

ENTROPY代表信息的丰富度。图像的熵值越高,信息越多

UIQM是色彩度、清晰度和对比度的线性组合,数值越大,图像质量越好。

BRISQUE量化了图像中由于扭曲的存在而可能造成的自然度损失,图像质量从0(最好)到100(最差)。

该方法的熵值和UIQM值均最高,表明该方法能够恢复高质量的水下图像,并保留大量的图像信息。该方法得到的BRISQUE值最小,表明恢复后的水下图像达到了自然状态。

4.2 Complexity Comparison

Windows 7 PC with Intel® Core™ i7-4790U CPU@3.60 GHz, 8.00 GB Memory

Python3.6.5.

当一个大小为m x n由半径为r的引导滤波器进行细化,提出的水下图像恢复方法的复杂度为O(m x n x r),然后用线性模型来估计深度图。

在图8中,运行时间(RT)是50幅不同大小(/像素)的水下图像的平均时间(/s)。

即使水下图像的大小是1200 x 1800像素时,RT小于2s。在我们的方法中,大部分时间用于分别获得三个RGB的transmission maps。

五、Conclusion

本文探索了一种基于水下光衰减先验快速有效的水下图像的深度图估计模型。线性模型建立后,对R-G-B光的BL和TMs进行平滑估计,简单地恢复场景亮度。本文提出的方法能够获得更好的水下图像恢复质量,同时由于采用基于ULAP的线性模型进行深度图估计,节省了大量的消耗时间,进一步简化了R-G-B通道背景光和传输图的推导。实验结果表明,该方法能够很好地适用于不同场景下的水下图像恢复,按照最佳的客观评价和最低的运行时间,更快、更有效地提高水下图像的质量。

本文提出了一种利用水下光衰减先验(ULAP)的快速场景深度估计模型,用于水下图像恢复。通过训练线性模型,准确估计背景光和透射图,有效去除水下图像的模糊和色差。实验表明,该方法在保持较高恢复质量和较低运行时间的同时,优于现有水下图像恢复技术。

本文提出了一种利用水下光衰减先验(ULAP)的快速场景深度估计模型,用于水下图像恢复。通过训练线性模型,准确估计背景光和透射图,有效去除水下图像的模糊和色差。实验表明,该方法在保持较高恢复质量和较低运行时间的同时,优于现有水下图像恢复技术。

2372

2372

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?