目录

1 熵

1. 熵是一个物理概念,表示一个系统的不确定性程度,或系统的混乱程度;

2 信息熵

1. 美国的一个数学家将熵引入信息论中,命名为“香农熵”,或“信息熵”。

熵与信息熵实际上是同一种概念,只是不同领域有不同叫法;

2. 信息熵公式:

n表示随机变量可能的取值数;x表示随机变量;p(x)表示随机变量x的概率函数;

上述结果,无论log是以几为底,对结果没有影响;

3 相对熵

1. 相对熵就是KL散度

KL散度:是两个概率分布间差异的非对称性度量;

KL散度用来衡量同一个随机变量的两个不同分布之间的距离。

KL散度公式:

特性: 非对称性:,除非概率分布完全一样才想等;

非负性:用于大于零,除非两个概率相等;

KL散度与信息熵是两种不同的信息。

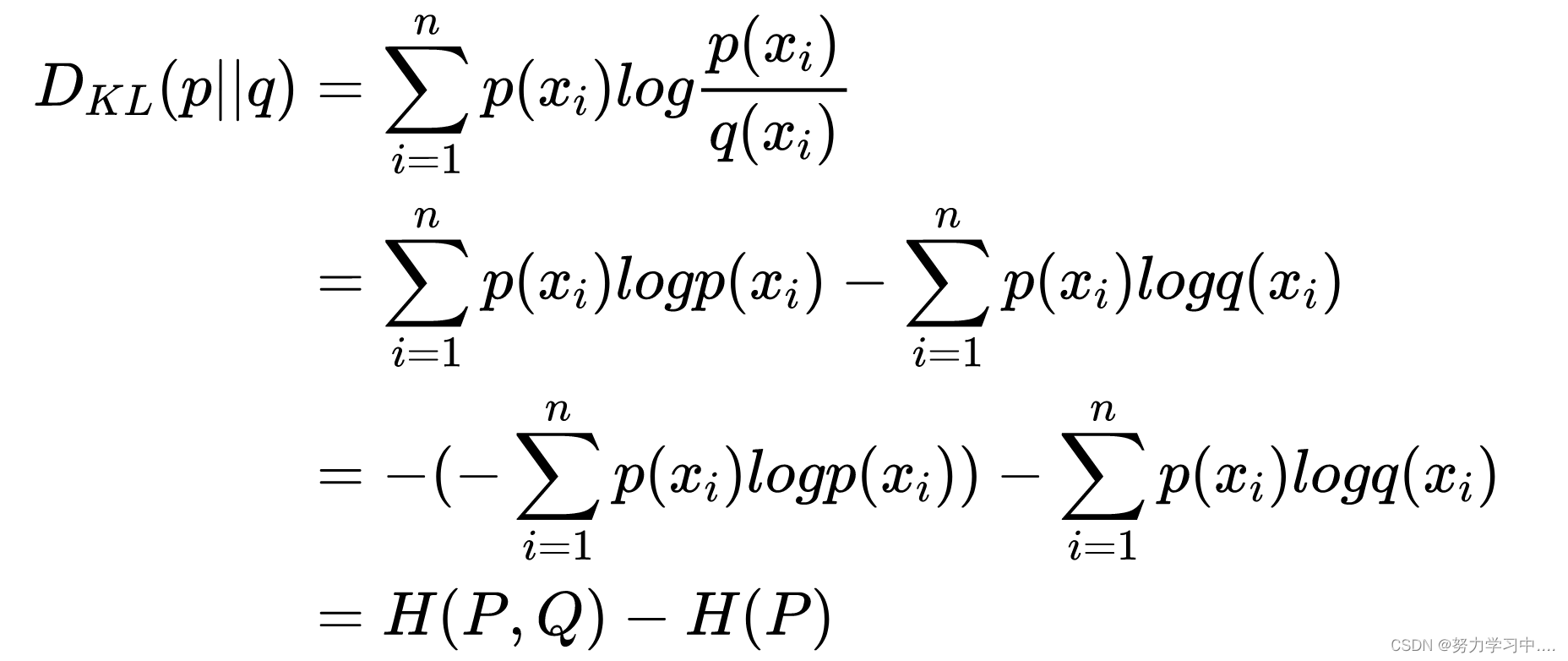

2. KL散度公式变形:

KL散度 = 交叉熵-信息熵;

4 交叉熵

1. 交叉熵:主要用于度量统一个随机变量X的预测分布Q与真实分布P之间的差距;

公式:

预测越准确,交叉熵越小;

交叉熵只与真实标签的预测概率值有关;

2. 交叉熵最简化公式

3. 交叉熵二分类公式

p(x)是真实标签的概率分布,q(x)是预测的概率分布;

4. 如果有真实分布,使用交叉熵作为损失函数;如果没有真实分布,使用KL散度作为损失函数。

程序计算交叉熵

entroy =nn.crossEntropy();

input = torch.Tensor([[-0.7715,-0.6205,-0.2562]])

target = torch.Tensor([0])

output = entropy(input,ouput)上述程序的计算,也就是用softmax计算三个输入占的概率值,然后标签是(1,0,0),所以再利用交叉熵最简公式就可以计算出来。

5 Softmax

1. softMax是将数字转化成概率的工具

softmax公式:

6 Sigmoid

1. sigmoid也叫logistic函数,取值范围为(0,1),常用作激活函数,常被用于二分类。

sigmoid公式:

参考:一个视频彻底搞懂交叉熵、信息熵、相对熵、KL散度、交叉熵损失、交叉熵损失函数、softmax函数、softmax求概率、各种熵的公式_哔哩哔哩_bilibili

486

486

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?