一、环境选择

Window10: 目前测试用

Linux: (注意是否安装 GPU版本)

(Linux后续更新,以下都是 Window下部署步骤)

二、配置选择

部署RAGFlow内存 大于 32g最好,小了不建议。这里我准备了两台电脑,一台装 ollama ,一台装 RAGFlow。测试用,这次配置不关键,后续实际部署再来更新。(最好 科学上网一直挂着)

三、Deepseek R1 和 RAGFlow 模型大致流程

当然,RAGFlow肯定不止这一点功能

四、Ollama下载与安装

1、下载网址

2、配 环境变量

记得重启一下最好。目的是为了 更改模型下载位置以及可以局域网内可以访问,记得检查 11434 端口是否放开。

3、双击安装

4、验证安装

cmd 运行 命令

Ollama --version

5、再次进入ollama 官网

点击 model

找到需要的deepseek r1

点击deepseek r1

打开cmd窗口,运行这个命令,就可以安装 对应模型,这里我选择 1.5版本,纯测试。

6、简单测试r1(我这是已经下载完毕了)

7、对Ollama 进行 Postman API测试

curl --location 'http://192.168.xx.xx:11434/v1/chat/completions' \

--header 'Content-Type: application/json' \

--header 'Authorization: Bearer ollama' \

--data '{

"model": "deepseek-r1:1.5b",

"messages": [

{

"role": "system",

"content": "直接给出最终答案,无需解释过程"

},

{

"role": "user", "content": "中国四大名著"

}

],

"show_reasoning": false,

"temperature": 0.1

}'五、RAGFlow下载与安装(部署这个 内存一定要大)

1、环境准备 Window docker

( 如果是window 最好开启hyper -v ,然后更新一下系统,要不然可能无法安装 docker 桌面环境。)

下载网址:https://docs.docker.com/desktop/setup/install/windows-install/

双击安装,然后cmd 输入

docker --version

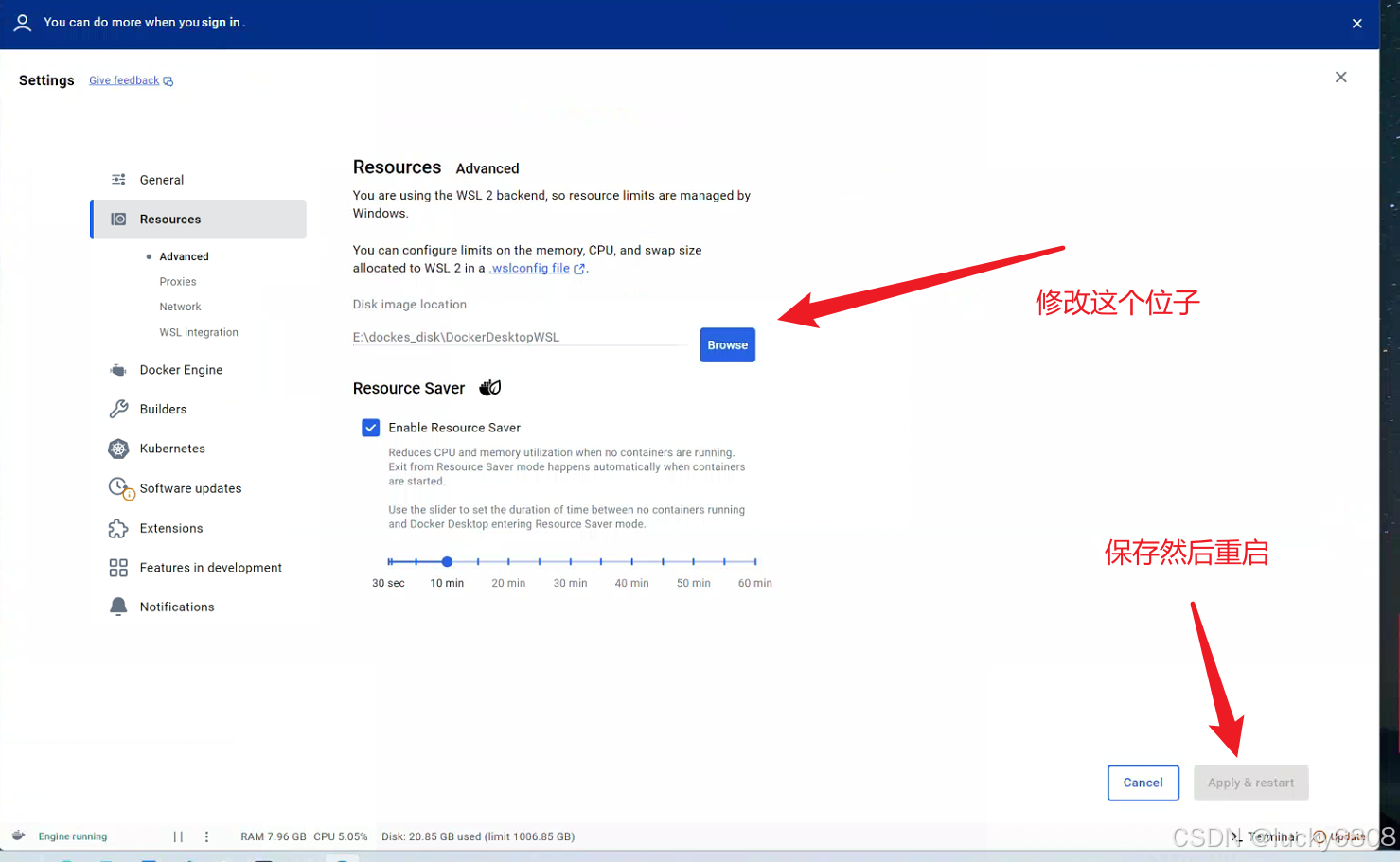

验证是否安装成功,然后修改目录(一定要做)

2、怎么下载以及运行

进入github官网 : https://github.com/ (科学上网you know)

然后,你就可以得到一个压缩包,解压就好了

接下来,进入解压后的文件中,找到

用记事本打开也行,最好vscode 打开 .env 文件,看 84 和 87 行,如图修改就好。(涉及GPU的调用,注意 CUDA版本 显卡驱动和 cuda 版本 12.6, 最后是 GPU.yml 启动)

3、运行正常的效果

进入 下载RAGFlow 的docker 目录,记住是docker 下面

在当前目录下,cmd 运行命令。接下来就是一直等待 资源下完,就OK了。

docker compose -f docker-compose.yml up -d 正常情况,容器都是正常启动。如果没有启动,说明有问题,那些没有启动,那些启动了,我们可以明显注意到。 中间的Port,就是 电脑和 docker 端口映射。比如,mysql 在docker端口为3306,现在他映射到window电脑端口为 5455。我们可以在Navicat 通过 5455 连接 ,mysql 用户名 root,密码在 RAGFlow 配置文件中。也就是 docker 目录下有相关配置文件,大家可以自行查看。

4、相关错误

问题:容器启动不健康、 注册失败。

查询方法:

查看日志(例如下面就是查看mysql的日志):

docker logs ragflow-mysql可能原因,端口被占用。 然后,不健康可能原因,注意观察,内存情况。如果接近占满,可能是内存不足。

怎么修改端口,还是在docker目录下,找到 docker-compose文件,vscode打开:

聊天报被拒绝,这个一般不会出现。但是由于我切换了网络,导致ip变了,就无法连接上ollama,聊天就一直拒绝连接。最后,重新添加 RAGFlow 的模型就好。如何添加,下面分解。

六、搭建个人知识库

如果您前期一切正常,浏览器输入: http://localhost:81/login 默认是:80,但是我端口冲突,我修改为 81, 修改完成后,重新运行 docker 下载资源的命令就好。

首先注册,然后登陆

首先会添加模型(这里我已经添加过了,你要找到 Ollama ,如果没有请刷新当前网页) , Url 就是 你装 Ollama 的ip地址

例如:http://127.0.0.1:11434, 最大token 给个 3000 就好,因为是测试嘛。

Ollama list

成功后的页面如下:

接下来,新建招聘

接下来会进入配置页面:

不同的资料,对应不同解析方法,默认General 就可以。然后,其它方法大家可以去 这个网址查看:Configure knowledge base | RAGFlow 这个网站里面还有更多内容。

如图配置好后,点击下面保存。然后,点击新增加文件。这里我上传了一份测试pdf。

没有解析是无法使用的

点击开始解析,等待解析完毕。

这就是解析成功后的样子。

接下来点击 聊天

新建助理

就可以聊天了,但是 1.5b 和 7b 好像有点呆呆的。(所以我下面使用的Deepseek商用,目前服务器还没有到,前面说了嘛,是为了验证可行性)

七、怎么简单微调模型

1、关键词

可以添加关键词,RAGFlow 会快速检索出你想要的块。

2、问题

这个还没有学会怎么使用

3、描述

再聊天助理的配置中,这个提示引擎-系统 配置也非常关键

4、测试 (前面说了,现在是基于商用Deespeek API, 不是本地哦)

1875

1875

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?