一、论文信息

论文题目:Transformers without Normalization

中文题目:无归一化的Transformer

论文链接:https://arxiv.org/pdf/2503.10622

所属机构:Meta FAIR (原属Facebook公司),纽约大学,麻省理工学院,普林斯顿大学

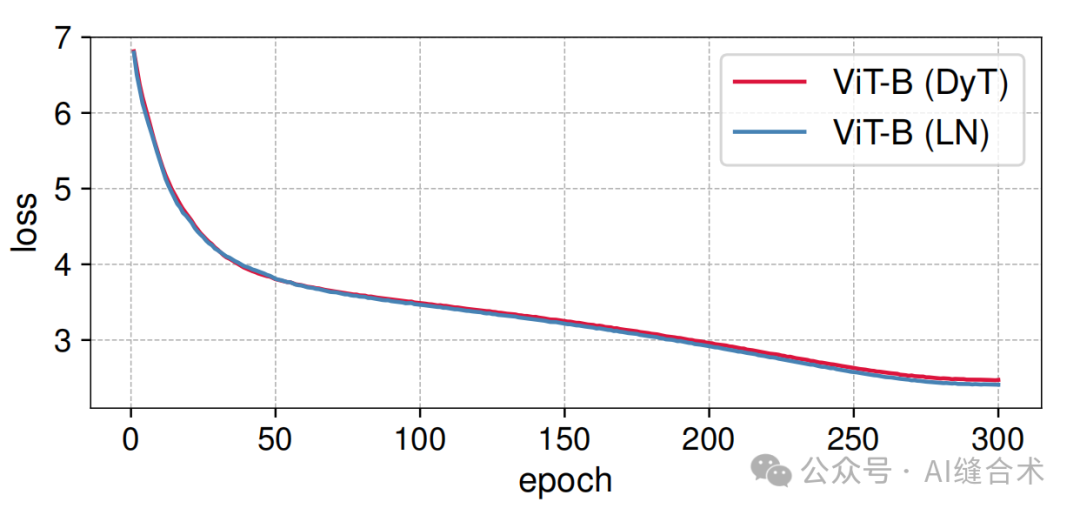

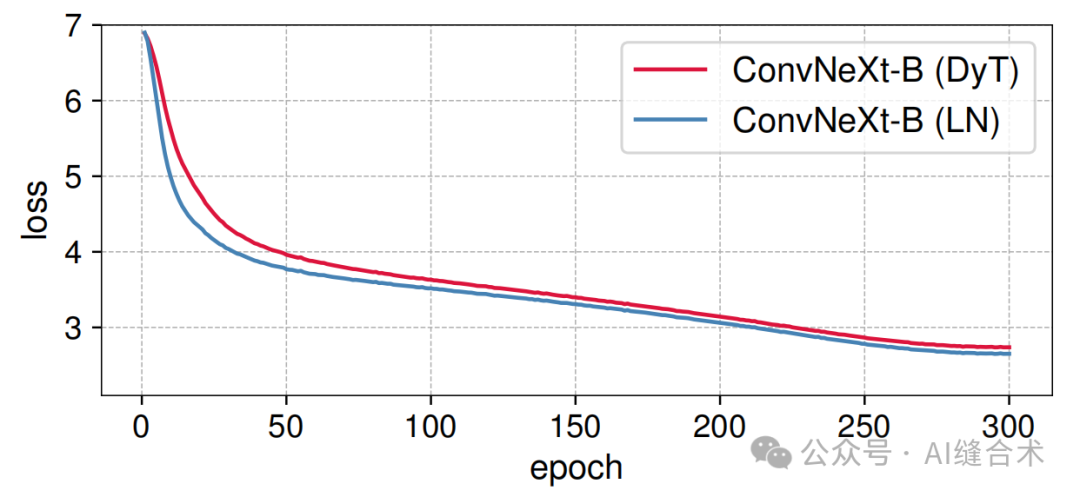

核心速览:本文提出了一种名为Dynamic Tanh (DyT)的简单技术,用以替代Transformer中的归一化层,展示了不使用归一化层的Transformer同样可以达到甚至超越使用归一化层的性能。

二、论文概要

Highlight

图5 ViT-B和ConvNeXt-B模型的训练损失曲线

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1161

1161

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?