挑战赛复现-SCIT-MCMT-Tracking

[CVPRW2023] “Leveraging Future Trajectory Prediction for Multi-Camera People Tracking”

NVIDIA城市应用挑战赛

原始地址:https://github.com/yuntaeJ/SCIT-MCMT-Tracking#cvprw2023-leveraging-future-trajectory-prediction-for-multi-camera-people-tracking

本地只做验证,由于数据集不够,故训练略:

第一步:克隆对应库

git clone https://github.com/yuntaeJ/SCIT-MCMT-Tracking.git

第二步:按照教程所示:

以原始的ervironment.yaml为根,用conda创建虚拟环境和对应的依赖

conda env create --file environment.yaml

conda activate scit

执行 sh setup.sh

sh setup.sh

这里有几个点需要注意:

- setup.sh中使用到了

pip3 install 'git+https://github.com/cocodataset/cocoapi.git#subdirectory=PythonAPI'

但是在国内网中发现这个文件访问失败,疑似是国内网的原因。因此,我们将它通过其它手段克隆下来

git clone https://github.com/cocodataset/cocoapi.git

随后cd 到cocoapi/PythonAPI中

pip install .

执行安装,这样就能成功安装

- 安装mmcv-full

pip3 install mmcv-full==1.7.1

无法直接安装,会提示报错

应该按照这样的方式安装

pip install -U openmim

mim install mmcv-full==1.7.0

这样就成功安装了

第三步:下载对应的权重文件

分别是pretrained-YOLOX-X.pth,yolov7-pose-estimation、pretrained-social-implicit.pth和 homography_list.pkl

如果需要用自己的数据训练的话:

则根据目标检测训练pretrained-YOLOX-X.pth

根据姿态估计训练yolov7-pose-estimation

根据Social-Implicit上提供的轨迹姿态训练进行训练

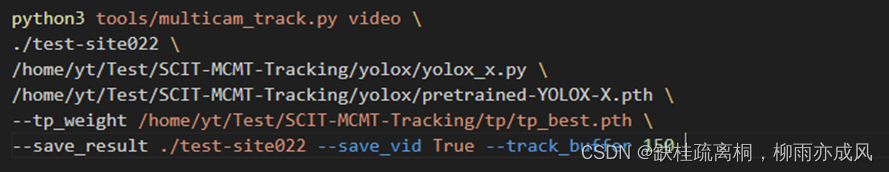

第四步:执行单摄像头跟踪

sh run_scmt.sh

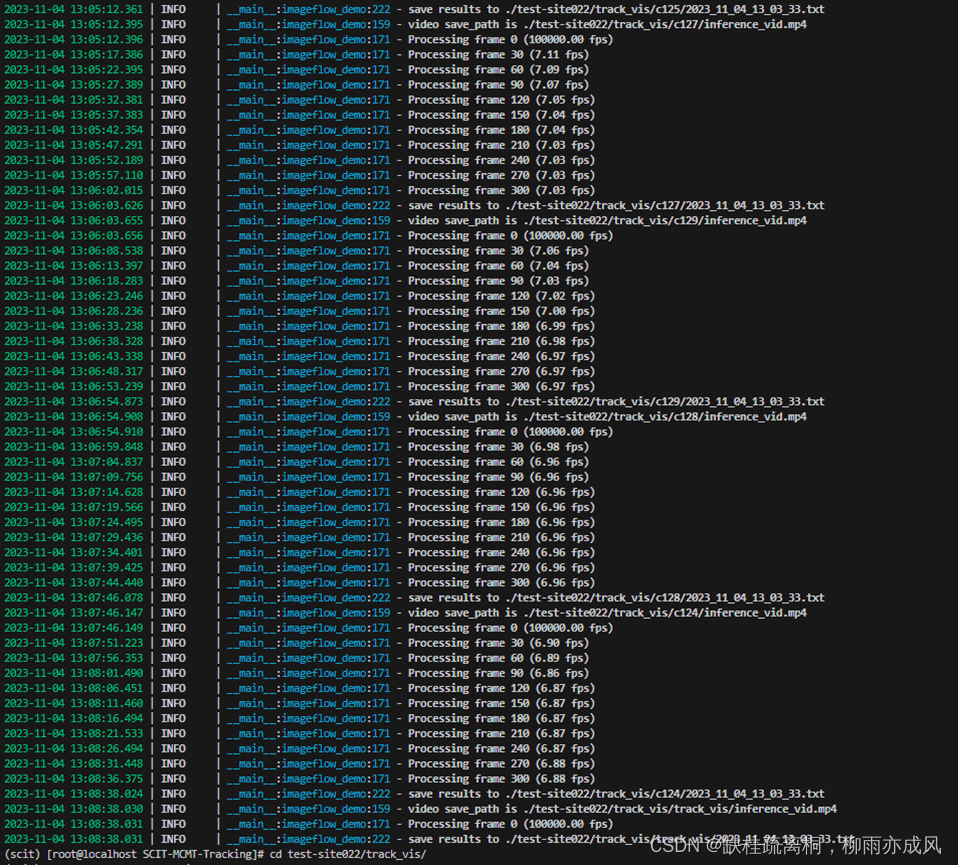

执行后命令行:

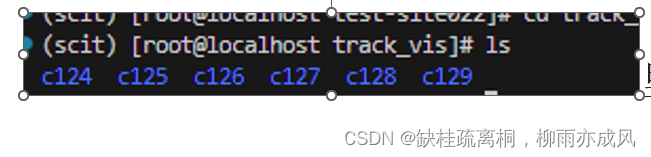

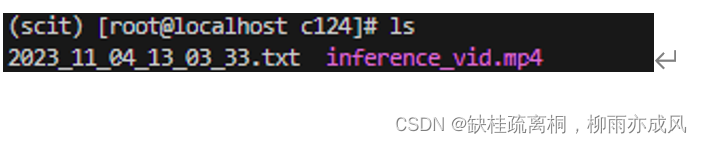

原始文本下出现了track_vis文件夹,这是处理后的文件夹

里面存放标签文本和预测后的视频文件

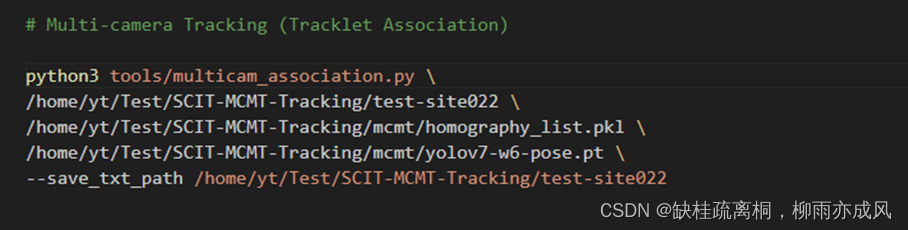

第五步:执行多摄像机跟踪

sh run_mcmt.sh

将第一步得到的标签文件改成label.txt

这里需要下载 https://github.com/RizwanMunawar/yolov7-pose-estimation 并将其文件合并到项目主路径下

需要将权重文件复制到 tools文件夹下

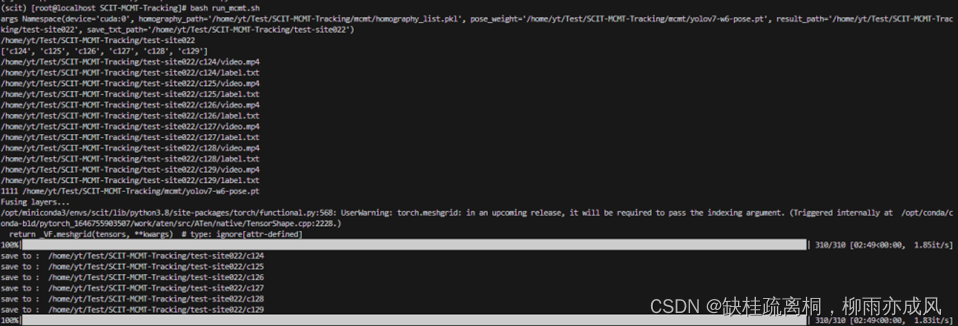

执行后

最后得到了sorted_associated.txt

后续 得到的这个sorted_associated.txt

可以得到多个摄像机的关联目标写一个cv脚本,将这个数据关联起来,就可以得到切换的数据了

849

849

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?