On the Opportunities and Risks of Foundation Models- TECHNOLOGY

TECHNOLOGY

基础模型的技术基础产生了决定其潜力的能力(2:能力)。为了理解在开发中使用的技术,我们考虑了用于训练(4.2:训练)的数据(4.6:数据)、模型架构(4.1:建模)和系统(4.5:系统),并进一步适应(4.3:适应)这些模型以及理论(4.10:理论)来理解这个范式。为了理解所得到的模型,我们讨论了如何评估(4.4:评估)和解释(4.11:可解释性),以及鲁棒性(4.8:鲁棒性)、安全性和隐私性(4.7:安全),以及长期人工智能安全(4.9:人工智能安全)的重要性,以确保这些模型在社会(5:社会)部署时的可靠性。

Modeling

图17。基础模型的五个关键特性:表达性——灵活地捕获和表示丰富的信息;可扩展性——有效地消耗大量数据;多模态——将各种模式和领域连接在一起;内存容量——存储大量积累的知识;以及组合性——概括到新的环境、任务和环境。

图17。基础模型的五个关键特性:表达性——灵活地捕获和表示丰富的信息;可扩展性——有效地消耗大量数据;多模态——将各种模式和领域连接在一起;内存容量——存储大量积累的知识;以及组合性——概括到新的环境、任务和环境。

基础模型的新兴范式在人工智能在过去的几年里取得了令人印象深刻的成就,模型如伯特[Devlin等人。2019]闪耀在广泛的语言理解任务:从文本分类和隐含的问题回答和阅读理解,而GPT-3组成丰富和流利的关于独角兽的故事[布朗等人。2020]和DALL-E显示视觉创造力的迹象,从头开始产生惊人的逼真的鳄梨椅子[拉梅什等人,2021]。

这些和近期基础模型的其他实例不仅在众多不同的下游任务和应用中取得了显著的性能[Rajpurkar等人2018;王等人2019a],而且还表现出值得注意的可解释性行为[卡拉斯等人2020]、鲁棒性[德夫林等人2019]、可控性[帕塔什尼克等人2021]和泛化[布朗等人2020]。一个模型需要什么来证明这些品质?哪些架构能够消耗大量潜在的多模态信息,并将其转化为丰富的世界知识?总的来说,一个网络应该拥有什么理想的属性来产生一个基础模型呢?

在这里,我们识别和讨论五个这样的属性,跨越表达性,可伸缩性,多模态,内存容量,和组合,我们认为是必要的基础模型为了: (1)提取和积累知识从各种来源和领域,(2)组织在一个有效的和可伸缩的表示,和(3)灵活概括小说的上下文。对于这些属性,我们都激发了它们的必要性,提供了包含它们的当代模型的例子,并探索了未来研究和开发的关键挑战和有希望的途径。一个概述图见图17。

Expressivity

表达性涉及到网络的理论和实践能力,以建模的数据分布,并以灵活的方式表示它。先前的研究提出了形式的表达度量来描述网络可以计算或更准确地说近似函数的复杂性,这本质上受其深度、宽度、连通性和结构模式的影响[Raghu et al. 2017]。

没有免费午餐定理表明,没有单一的模型或算法最适合所有情况下[沃尔伯特和麦克雷迪1997],因此,对于我们的目的,我们特别感兴趣的是识别哪些模型可以有效地捕捉自然信息的方面,如人类语言或现实世界的图像[古德费尔et al. 2016]。这些模式要么是连续的(如在视觉中),要么是离散的(如在语言中),是明显的分层和高维的,并在它们的组成元素之间呈现出一组复杂的关系和相互作用,无论它们是像素、单词还是物理对象。

事实上,最近在生成建模方面的突破为神经网络的高表达性提供了强有力的证据,因为它们成功地表达了文本的分布[布朗等2020;德夫林等2019;Lieber等2021;王和小崎2021],听觉[范登奥德等2016]和视觉[卡拉斯等2020;布洛克等2018]领域,并生成高保真、多样性和现实的样本。

诱导性偏见。神经网络的成功在过去的十年建模自然数据归功于网络的高深度,可以大致衡量堆叠的非线性层的数量,或他们的计算步骤的推理链。巨大的深度在增强网络的表达能力方面起着至关重要的作用,使它们能够形成强大的分层和分布式表示,可以从训练数据推广到新的看不见的例子[He等人,2016b;Levine等人,2020]。

普遍近似定理[卢et al. 2019b]确实指出,即使是简单的多层感知器(MLPs)可以代表一个广泛的功能,而不同的归纳偏见,如实现在递归神经网络(RNNs)或卷积神经网络(CNNs)[Goodfelletal.2016],可以提高学习效率和提高给定网络的能力建模不同形式的信息:顺序数据,语言、语音和时间序列,前者,或空间不变的信息,如图像或视频,后者。

变压器网络和关注。与此同时,最近引入的变压器网络[Vaswani et al. 2017]证明了捕获元素之间的远程依赖关系和成对或高阶相互作用的重要性。它们建立在自我注意机制的基础上[瓦斯wani等人2017;Bahdanau等人2014],提供更短的计算路径,并提供直接的方法来比较跨输入数据的元素(如句子中的代词及其前词,或引用同一主题的两个句子)。

从另一个角度来看,乘法交互体现在注意力和门结构(如lstm[主持人和施米德胡伯1997]或混合专家[Shazeer et al. 2017])提供了一个更灵活的替代刚性固定权重计算mlp和cnn,动态适应计算的输入。这证明对语言建模特别有用,例如,给定一个句子“她吃冰淇淋X”,而前馈网络总是以同样的方式处理它,一个基于注意力的模型可以调整其计算输入-更新“吃”这个词的上下文表示如果介词短语(PP)附件X是“勺子”,或者如果X链接到“冰淇淋”,指如“草莓”[Zavrel等人,1997]。

通用计算。最后一个显著优势的关注之前的架构源于其更强的普遍性,它不是强烈绑定到一个特定的任务或域,如当地接受域卷积或循环网络的顺序假设,分别反映固有属性特定于视觉和语言模式。我们假设,注意力和变压器的通用性质有助于其广泛适用于广泛的研究问题和应用。

这种对比捕捉了任务专门化和表达性之间更普遍的权衡:具有更强结构先验的模型可以利用它们来提高受益于这些假设的特定任务的样本效率;相反,整合较弱的归纳偏差的模型学习更慢,但反过来可以扩展到更高的数据量并适应不同的领域,因为它们不依赖于限制性或特定任务的假设。随着数据和计算变得更容易获得,我们观察到,探索具有最小归纳偏差集、可以“让数据自己说话”的模型,似乎是该领域未来研究的一种更有前途的方法。

挑战与未来方向。尽管神经网络在总体上取得了卓越的进步和成就,特别是基础模型,在表达能力方面,但仍然存在显著的挑战。领先的方法[乔罗曼斯基等人,2020;一直挣扎于极长期依赖关系的建模,如那些发生在书籍,电影,甚至DNA序列,这可能归因于当代基于变压器的方法的二次计算。

这一挑战本质上反映了效率和表达性之间的权衡:通过短期和直接计算路径明确建模远程交互可以提高表达性一方面,但以牺牲可伸缩性为代价[儿童等人2019;Kitaev等人2020;乔罗曼斯基等人2020]。模型如GANfromer[Hudson和Zitnick 2021]和感知器[Jaegle等人,2021b,a]探索了平衡这两种特性的方法,并提出了依赖于二部分或瓶颈关注的线性复杂性的变压器,从而在保持高表达的同时提高计算效率。我们相信,确定这两个目标之间的有效平衡,为未来的研究提供了一个有趣的途径。

另一个重要的研究方向与基础模型的扩展有关,到目前为止,主要集中在语言领域[彼得斯等2018;德夫林等2019;布朗等2020],到不同的模式,如结构[斯卡塞利等2008;维利科维奇等2017]和感知[托尔斯蒂金等2021;Jaegle等2021b;Tan和Le 2021],每一个都涉及一系列独特的相关挑战。同样,我们认为,探索推理架构(2.4:推理),这需要迭代计算链和与符号信息的交互,是未来基础模型研究的一个有价值的目标。

Scalability

与模型的表达性密切相关的是可伸缩性的概念。随着来自不同来源的丰富数据变得更容易获得,以及计算资源变得更强大、更高效(4.5:系统),我们应该寻找匹配这种进展速度的方法,并利用它来提高人工智能的能力和多功能性。为了使基础模型有效地拟合图像或文本的复杂和高维分布,它们应该可以在所有维度上进行扩展:包括模型的深度和宽度以及它们的训练时间、参数的数量和它们可以处理的数据量。

最优化具体而言,基础模型应包括:(1)易于训练(4.2:训练),通过对数据中的噪声或缺陷具有弹性,以及对不稳定性的健抗消失[赫尔弗里奇等人2018;格洛洛特和本吉奥2010]或爆炸梯度[霍克雷特和施米德胡伯1997;奈尔和辛顿2010],以及(2)易于适应(4.3:适应),通过克服灾难性遗忘现象[柯克帕特里克等人2017]和支持少镜头学习[Sung等人2018]。我们仍处于理解驱动学习算法可伸缩性的原则的早期阶段,虽然最近的工作已经开始阐明这些主题[刘等人2020c;库迪蒂普迪等人2019;中伊朗等人2019],还有很多工作要做。

硬件兼容性。超越鲁棒性和优化方面,基础模型也应该是实际高效的(4.5:系统),并利用当代和未来的硬件[Hooker 2020]。其中一个例子是并行性,这是描述gpu支持的计算的一个重要特性。事实上,变形金刚对以前主导的循环方法的巨大成功是由它们更高程度的并行性驱动的。

展望未来,鉴于系统开发的快速发展,我们应该进一步确保模型的设计能够共同适应未来的硬件发展。因此,理想情况下,基础模型应适合分布式训练等方案,分布式训练越来越受欢迎,如专家混合,并可能利用计算或表示的稀疏性等特性,如长前者[贝尔塔吉等2020]、大鸟[Zaheer等2020]和稀疏变压器[Child等2019]方法,这可能在未来的硬件和处理器中更加重要。

Multimodality

传统上,计算机视觉、机器人技术和自然语言处理等领域都以独立的方式取得了进展,独立的社区开发出适合每种模式的特定方法。深度学习的兴起带来的一个有利的后果是,它帮助在人工智能的各个社区和研究领域之间形成了桥梁,因为看似不同的问题现在可以通过密切相关的方法来解决,而对最初遥远主题的研究开始汇聚到一个共同点。这一突破开辟了一系列新的可能性,促进了开拓性探索,包括语言基础[林奇和服务器2020]、视觉语义[Conser等人2019]、体现环境[Savva等人2019a]和互动代理[灰色等人2019]。

从本质上讲,多模态是智力的关键组成部分,也是发展对世界的全面和广泛理解的关键因素。具体地说,语言学习在扎根的环境中比在真空环境中更有效。相反,从视觉的角度来看,语言鼓励抽象的出现,这些抽象将低级感知信号和统计与对象、属性、代理和动机的语义概念联系起来,从而丰富和提升视觉表征。

根据这些观察,我们认为基础模型应该理想地连接在一起不同的模式,提取体现的信息共享的多面表示,并捕获的相互联系和关系,提供广泛的能力(见2.1:语言,2.2:视觉,2.3:机器人,2.4:推理)。

概括性和专业化。多模态基础模型的一个重要设计选择是专业化程度,或负责每个模态的模块之间的结构共享。自然地,不同领域的数据表现出不同的结构和属性——例如,语言是离散的,而视觉是连续的。乍一看,这种变化暗示了为每种模式量身定制的特殊的归纳偏差可能会有所帮助。

然而,随着训练向上扩展,模型有机会减少学习基于结构先验,而更多地基于数据本身,只保持少数广泛的一般假设的一般方法实际上比特定任务的替代方法要成功得多。因此,正如最近跨不同模式的通用模型的成功所证实的那样——语言[刘等人2019;Lan等人2019]和视觉[多索维茨基等人2020;哈德逊和齐特尼克2021],我们看到,通用性对于提高人工智能能力至关重要。

多模态交互。多模态模型的另一个关键考虑因素与权重共享有关:不同的模态是否从为其各自的组件使用相同或不同的参数中受益?先前的研究已经表明,富有成效的转移当然可以跨方式发生,但这种共享的理想程度仍然不清楚,发现它的原则方法的存在也不清楚。

最后,一个主要的设计问题涉及模型支持的多模态交互的形式,这在具体案例和例子之间差异很大:跨模态或晚期融合模型,如ConVIRT [Zhang等人2020a]和CLIP[雷德福等人2021]为每个数据源维护完全独立的编码器,并仅在最终计算阶段比较它们的空间,例如使用简单的点积。同时,早期融合模型,如ViLBERT [Lu等2019a;Cho等2021],共同推理视觉推理和问题回答任务所需的多种模式。确定合并各自向量空间的最佳阶段和形式[Nagrani et al. 2021]仍然是一个开放的研究问题。

总的来说,虽然社区中似乎对多模态的重要性达成了共识,但超越视觉和语言的浅层对齐的模型还没有存在,而在具体化环境中扎根语言学习的主题仍然有很大的探索空间。

Memory

到目前为止,我们已经讨论了基础模型的目标,在大规模上收集不同的模式和积累信息。这些知识既包括对世界的广泛理解,以及对利基主题或特定事实的具体掌握。代表如此大量的学习信息绝不是微不足道的,它导致了关于访问、存储、检索和操作特定物品或记忆的有效机制的有趣问题。

显式存储。可以实现这些需求的一个重要设计原则是将计算从内存中分离出来[Weston等人,2014;Graves等人,2016;哈德逊和曼宁,2018,2019a],以便通过将先前获得的抽象技能应用于新的具体设置来提高模型转移知识的能力。

在这种情况下,区分重要的是显式事实——可以存储在外部记忆存储,隐含的知识——是通过网络的权重训练的。与通过网络权值隐式将所有信息编码在一起相比,这种显式和内隐知识的解耦具有多种优势。

分离缓解通胀模型的大小和参数的数量需要存储不断增长的知识[古等。2020],通过增加模型的信任和可靠性提高他们的知识来源[切尼等。2009],最值得注意的是,是内存更新、操作或适应的关键[刘易斯等。2020b](4.3:适应),这可能反过来使泛化到新的上下文和下游任务。

事实上,在过去的几年中,记忆和计算之间的分离一直是深度学习和自然语言处理研究中反复出现的目标,包括记忆网络等模型[韦斯顿等人2014;苏赫巴托等人2015]、神经图灵机[Graves等人2014,2016]、神经状态机[哈德逊和曼宁2019a]和MAC[哈德逊和曼宁2018]。

信息检索一旦模型在训练后完成了信息收集,就有多种方法来检索下游应用程序和任务所需的特定事实或内存。一些采用显式提示技术,通过输入序列查询模型的知识[Petroni等,2019;卡斯纳等,2021;江等,2020],而其他方法涉及内隐回忆和通过适应阶段重塑先验知识[博斯勒特等,2019;黄等,2021]。第三类方法更进一步,将基于神经的计算与符号聚合和从非结构化文本存储库中检索信息相结合[卡尔普钦等,2020;Lewis等,2020b;Khattab等,2020],甚至是结构化资源,如知识图。

然而,一方面在检索机制提供的强记忆技能和另一方面在存在信息瓶颈时学习到的更丰富的表征之间存在权衡。事实上,过度依赖检索减少了学习如何以紧凑和抽象的方式表示信息的机会,从模型暴露的大量输入信息中提取关键的见解和概念,基本上,从糠中分离出来。例如,GPT-3的上下文学习能力可能是强制网络通过其有限的内存体系结构来表示输入的序列数据的副产品[Brown et al. 2020]。总的来说,虽然它们确实有一些优点[Guu et al. 2020],但依赖于外部检索机制的模型可能无法学会像有界、紧凑和抽象的表示那样有效地进行泛化。

知识操作。最后,当考虑长时间的大规模学习时,注意知识的动态本质是至关重要的,随着世界的不断发展,事实的正确性和有效性会随着时间的推移而改变——昨天的真实或相关的明天可能不会变成这样。因此,对于一个模型来说,以一种支持有效更新或操纵事实的方式来表示其知识是至关重要的。

Compositionality

组合性可以被定义为整体的意义源自其组成部分的意义的原则,以及用于组合它们的规则[Janssen和第三部分,1997;Bottou 2014]。它是人类智力的一个重要组成部分[Lake等人,2017],是我们从少数例子中轻松有效地计划、推理和学习的能力的基础。组合性可能是实现分布外-或具体的组合泛化的关键。利用符号人工智能的经典思想,它鼓励和增强神经网络中的理想属性,如可解释性、可控性和数据效率[Lake et al. 2017],并可以采取不同的形式,描述各种元素:

模型组合性可以反映在模型层面上,即其建筑属性、结构和模块化程度,这可以提高大型神经模型的训练和推理效率[Shazeer et al. 2017]。它还链接到可解释性和多模态性的主题,因为它涉及到模型所组成的不同模块之间的接口、它们所使用的交互模式以及它们的透明度。

计算。模型如模块网络[安德烈亚斯等。2016]和混合专家[Shazeer等。2017]进一步沿着这个方向,不仅展示结构模块化,而且成分计算,支持子网络的专业化不同的操作,以适应和定制模型行为的输入。虽然一些方法依赖于手工设计模块的连接[Andreas等人2016],但替代方法使网络专业化能够通过学习自然出现[Shazeer等人2017]。其他模型,如MAC[哈德逊和曼宁2018]和动态记忆网络[熊et al. 2016]执行显式迭代计算,一个给定的任务分解为多个推理步骤,一个接一个地执行,显示顺序发展从一组新的初始事实小说的推论和结论。

培训和数据。不仅模型或其计算量可以是组成的,数据或训练过程也可以是组成[Andreas 2020]。与其在一个完整的数据集上训练一个模型,还可以将其分解为子集,对每个模型独立训练不同的模型,并最终在测试时通过各种集成技术重组它们[Dietterich 2000]。这种方法可能对在实际方面,甚至在社会方面的基础模式的培训和部署程序产生深远的影响。

表示我们讨论了不同元素的组合性,如模型、计算、训练方案或数据。但最值得注意的是,在模型训练和适应过程中出现的学习表征本身也可以是组成的[Andreas 2019]。事实上,一种很有前途的表示知识的方式是通过结构化的、潜在的基于图形的、面向对象的表示[Zhang等人,2019a;Wang等人,2021a],它围绕着识别实体和事件节点,并形成它们之间的连接、类比和关系边。它反映了一种组织世界信息的自然方式,其中来自不同模式的输入可以围绕语义、多方面的概念进行引导和聚合。这种表示可以支持多跳推理和推理[Wantion等人1995;Sun等人2020b;Yu等人2020c],并可能通过重组实现更强的分布外泛化。

然而,组合性也会阻碍表征的表达性,并阻碍其解释特质、例外情况和上下文相关性的能力[Misra et al. 2017a]。换句话说,整体有时可能大于它的各个部分的总和,例如,红酒和红洋葱不一样。但是,尽管许多在过去十年中占据主导地位的方法大多集中于光谱的一端,并学习整体分布式表示,但我们相信,探索方式以在情境性和组合性之间达到更好的平衡是未来研究的一个很有前途的途径。

Summary

我们介绍了五个我们认为对下一代基础模型至关重要的属性,以便有效地提取我们周围的大量信息,从而成功地解决下游任务:表达性——灵活地捕获和吸收真实世界的信息,可伸缩性——熟练地处理大量的高维数据,多模态——消费、处理和潜在地产生来自不同来源和领域的内容,内存容量——有效地存储和检索获取的知识,最后,组合性,促进对新任务的成功推广,设置和环境。我们相信,实现基础模型的全部潜力,正如在本报告中详细设想和讨论的那样,将依赖于对新的建筑和建模进展的研究来实现这些需求。

Training

训练目标是描述如何将模型体系结构和大量广泛的数据转换为基础模型的数学函数。例如,GPT-3被一个语言建模目标训练,该目标奖励正确预测下一个单词的模型[Shannon 1948]。我们首先列出这些培训方法的一些目标,描述当前方法中存在的重要设计权衡,并概述未来道路的重要目标。

Goals of training objectives

根据这些方法和模型的快速发展,我们概述了训练算法的一些关键目标。

利用广泛的数据。自监督学习算法的兴起开启了互联网规模的数据集的力量,这将难以手工注释。这种广泛的数据有多种形式,包括图像、音频录音和视频(2.2:视觉);机器人和传感器数据(2.3:机器人);文本,或单独,要么与其他模式配对,如图像(2.1:语言)。由于这些数据缺乏外部注释,研究人员的一个主要重点是设计定制的自我监督算法,利用每种数据中的独特结构,为基础模型产生一个训练信号。

域完整性。基础模型训练算法的一个重要目标是实现领域的完整,从这个意义上说,解决训练任务需要对领域中的下游任务广泛有用的能力(见2.1:语言,2.2:视觉,2.3:机器人技术)。这个特性对于基础模型的通用性是至关重要的。例如,当语言模型学习预测文档中的下一个单词时,语言建模可能需要模型获得诸如共同引用、情感和翻译等广泛的能力。相比之下,像情绪分类这样的有监督的学习任务可能会导致更狭窄的能力集(见2.1:语言)。尽管这种质量很重要,但什么任务将导致一个领域的完整能力,甚至如何评估模型能力的全部广度都不明显(见4.4:评估和4.10:理论)。

缩放和计算效率。训练基础模型的过程必须可靠地将数据、模型体系结构,并计算为能力广泛的模型。为了最大限度地提高基础模型的能力,我们可以识别这个过程中的瓶颈,并提出新的训练算法来消除它们。自监督算法的兴起使得模型规模和计算资源越来越突出的瓶颈[Kaplan等人2020;亨尼安等人2020],导致了一种转变,模型不仅评估其能力,而且评估达到这些能力所需的计算数量和类型(4.4:评估)。培训目标的效率可能差别很大,47在一个固定的计算预算下,培训方法的设计对强大能力的出现有多么重要。因此,培训研究人员的一个主要目标是设计具有更丰富的训练信号的训练目标,从而形成学习速度更快、获得更强能力的模型。帮助这一发展的一个力量是能力如何通过不同类型的架构、数据规模和计算扩展的惊人可预测性[hesness等人2017;Kaplan等人2020],这是一个惊人的现象,使模型开发人员能够基于更清晰的趋势做出选择,而不是更昂贵的随机搜索.

Design trade-offs in current SSL methods

目前用于训练基础模型的自监督学习(SSL)方法是多种多样的,但它们的统一之处在于,它们从不需要人工注释者的未标记数据中产生预测问题。SSL目标通过精心设计的约束从这些数据中制造出丰富的训练信号,无论是对数据本身(例如,编辑或噪声),还是对模型能够表示或处理数据的方式(例如,潜在的瓶颈)。在某种程度上,这些约束条件“吸收”了在使模型适应下游任务时所需的能力类型(4.3:适应)。在这里,我们描述了当前模型所探索的三个重要的设计选择,以及它们各自在结果能力方面的权衡。

我们应该在什么抽象层次上建模?一个基本的问题是,基础模型的输入表示应该是什么。一种选择是在原始字节的级别上对输入进行建模。然而,这种高维性可能会导致模型专注于预测输入中较少的语义方面,50减缓了它获得更普遍有用的能力的速度。当训练变压器等模型[Vaswani et al. 2017],其计算成本随着输入大小的二次增长时,这些方法也变得难以处理。另一种选择是使用领域知识来减少模型的输入空间——这种策略包括补丁嵌入[多索维茨基等人2020年]以及固定或学习标记化[舒斯特和中岛2012年;森恩里希等人2016年;工藤和理查森2018年;范登德等人2017年;拉梅什等人2021年]。这些方法可能会减轻生成方法所面临的一些挑战,但也有一个权衡,即它们可能会抛弃输入中可能有用的信息。52连续输入和离散输入的选择也有适应的权衡(4.3:适应);需要做更多的工作来捕捉这两种方法的好处。

生成式训练方法在概念上优雅而强大——它们训练模型来学习训练输入上的联合或条件分布。生成基础模型的两个主要家族包括自回归基础模型[范登Oord等人2016年;雷德福和纳拉辛汉2018年;陈等人2020d;杨等人2019年;拉梅什等人2021年],逐个生成输入,去噪基础模型[Devlen等人2019年;Raffel等人2019年],破坏然后恢复输入。在训练过程中执行的特定类型的生成决定了在适应过程中53(见2.5:交互作用和4.3:适应),而未来的模型可能会使更丰富的交互作用集成为可能可用的交互性.

虽然生成式训练方法有它们的好处,但一些有区别的方法最近也获得了关注。这些方法不支持基于生成的交互,但它们可以使在图像、音频和视频等高维连续设置中对基于分类或回归的任务进行更有效的学习。这些方法大多数输出(部分)输入的向量,与输入的不同“视图”相似[Wu等人2018;范登奥德等2018;2018;陈等2020c;他等2020;烧烤等2020;卡隆等2021;张等2020;2020;雷德福等人2021]或用于预测输入的部分是真实还是虚假[Clark等人2020;Iida等人2021]。更好地理解生成性训练和歧视性训练之间的权衡,以及捕捉这两种方法的最佳效果,仍然是未来研究的有趣途径。

捕获多模态的关系。另一个越来越重要的研究领域是捕捉多种数据之间的关系。这意味着什么,可能会根据建模者的上下文和目标而有所不同。例如,CLIP [Radford等人2021]和ViLBERT [Lu等人2019a]都是多模式视觉语言,但它们在多模式的精确方式上有所不同。前者将图像和文本分别编码为向量,使具有单一模态的例子的用户能够从其他模态的例子中检索、评分或分类。第二种方法在模型的早期阶段联合处理图像和文本,支持下游应用程序,如视觉问题回答,在那里对相关图像和文本对(例如,关于它们的图像和问题)进行推理。多模态基础模型仍然是一个新兴的研究领域;关于一个模型可以成为多模式的不同方式,以及更好地理解这些附加模式带来的能力,仍有许多内容未被探索。

Paths forward

Out-of-the-box SSL目前,SSL的目标是高度特定于领域的:目前在自然语言处理、计算机视觉和语音处理中流行着不同的方法。这有两个主要的缺点:首先,这些不同的技术使理解为什么这些方法能够工作的共同线索和科学原理具有挑战性。其次,这种领域特异性需要为每个新领域从头开始开发新的基础模型训练方法,包括医学、科学和新的多模态设置。在任何类型的数据上有效地训练基础模型的一个更普遍的目标将是基础模型培训社区的一个重要里程碑。

Obtaining a rich training signal很明显,并不是所有的培训目标都是平等的——有些目标比其他目标更有效率,转化为对给定的计算预算更有能力的基础模型。是否有比目前已知的更有效的数量级的训练方法?如果是这样,我们怎么才能找到它们呢?这些调查将受到许多力量的影响,包括未来的软件和硬件进步(4.5:系统)成为可能。我们也不需要将数据(4.6:数据)和训练算法视为独立因素:不仅数据的质量和可用性会影响训练信号,56,而且训练算法本身可以自适应地寻找或构建更丰富的训练例子来加速学习。

基础模型的目标导向训练。适应方法,如提示(4.3:适应),利用紧急属性,几乎是事后想到的训练。我们能否训练基础模型,使其在一个复杂的世界中理解和可靠地执行目标的能力是该模型的训练目标的一部分?对发展一般能力的关注将这一方向与通过强化学习使现有的基础模型适应于特定任务的目标区分开来(例如,Stiennon等人[2020])。相反,人们可能会想象更复杂的当前方法版本,从原始的在线获得现实世界的功能[克列尤宾等人2005;2005辛格等,2005;萨尔奇等人2013;沙基尔穆罕默德2015;弗洛伦萨等2017;帕塔克等2017;哈伯等2018年2018]或离线[预防等2000;兰格等2012;Ajay等人2021;杨和纳克姆2021;施瓦泽等2021]交互,不需要人工注释或任务构建。这些方法可能使用与现有SSL算法非常相似的技术:例如,在目标导向的环境下训练序列模型,它们可以直接被要求通过条件反射来执行某些任务(例如,UDRL[施米德胡伯2019;斯里瓦斯塔瓦等2019]或决策变压器[陈等2021b];参见2.3:机器人)。在简单的交互环境中已经出现的复杂行为[Baker et al. 2020]表明,基础模型的多任务、多主体和多模式目标导向训练是未来研究的一个有趣的途径。

Adaptation

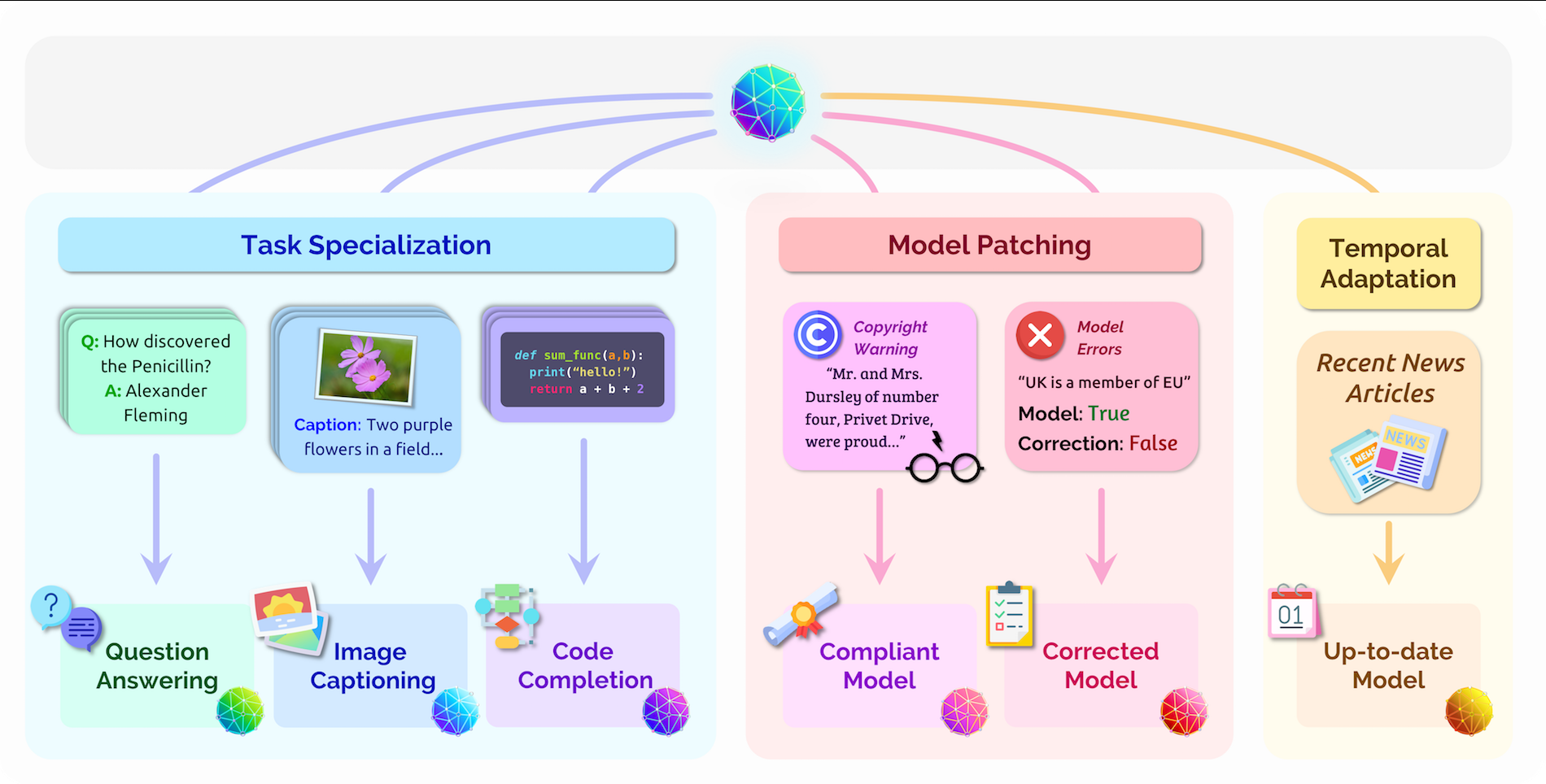

图18。在自适应过程中,一个基础模型被转换为一个自适应的模型(底部行),以反映更新的信息、期望的行为或部署约束。

图18。在自适应过程中,一个基础模型被转换为一个自适应的模型(底部行),以反映更新的信息、期望的行为或部署约束。

虽然基础模型为处理多模态信息提供了一个强大的通用引擎,但对于某些应用程序,在使用之前调整基础模型是必要的。一般来说,适应过程通过生成一个适应模型,根据附加信息调整基础模型,通过包含新数据或输入提示来启动基础模型,或通过更新部分或全部的基础模型参数来反映新信息。例如,在文本摘要中,在输入文章中添加TL;DR等提示可以作为基础模型的任务规范,从而提高基础模型的性能[Radford等人,2019]。或者,使用组织内部特定领域的数据来微调基础模型的参数,可以通过添加与组织用例相关的信息来提高模型的准确性。在本节中,我们将描述现有的适应方法,以及决定特定适应程序是否适合特定环境的几个因素。我们另外描述各种用例基础模型适应,包括相对研究良好的设置如专业化基础模型的特定任务或域以及更多的投机设置如测试时间数据删除[Bourtoule et al. 2019]和编辑模型行为在特定输入[Sinitsin et al. 2020]。最后,我们提出了未来基础模型适应研究的长期目标。

Methods for foundation model adaptation

已经提出了许多适应基础模型的方法,这使得决定使用哪个特定问题或计算环境的适应程序变得困难。我们强调了从业者在选择自适应程序时需要考虑的三个特别重要的因素: (1)计算预算(特别是存储和内存);(2)可用于特定任务的数据量;(3)对基础模型梯度的访问程度。

**因素1:**计算预算。对于具有数十亿或数万亿个参数的基础模型,微调所有模型参数可能需要非常大的内存。此外,对许多任务进行单独的微调可能会导致不可接受的存储成本。有许多工作提出了为适应基础模型而减少存储的方法,我们将这类轻量级自适应方法称为低存储自适应。通常,本类中的方法冻结了大部分预先训练的基础模型参数,而只学习相对少量的、特定于任务的参数(通过微调一些预先训练的参数或通过添加全新的模块),从而减少了每个任务的存储开销。

这类算法的关键设计决策是要适应的参数的选择。也许最简单的方法是只调整最后一层的模型,而其他作品只调整模型的偏差向量[Zaken等。2021],低秩残差模型权重张量[胡等。2021],或面具模型参数[赵等。2020b]。另一行研究曲调“软”提示[李和梁2021;秦和艾斯纳2021;刘等人2021e;莱斯特等人2021;汉巴德等人2021],对应于任意参数向量的序列,而不是在输入层或所有层,在这些提示上连接基础模型。另一种方法冻结所有模型参数,并在现有模型层之间插入新的MLP模块与可训练参数[Houlsby等人,2019]。虽然这些轻量级适应技术似乎在下游任务上权衡参数效率和性能,但它们有时会达到与完全微调相当的性能,尽管少更新1000×[Zaken等人2021;李和梁2021;Hu等2021]。Lester等人[2021]展示了一个实例,即随着模型尺寸的增加,完全微调和轻量级自适应之间的性能差距会消失。我们仍然不确定轻量级自适应技术如何随着模型规模的增加而扩展。因为GPU内存通常是一种比磁盘存储更有限的资源,所以低内存适应过程可能比低存储适应过程对普及基础模型更重要。各种低内存模型训练的技术已经被提出,它们可以直接应用于基于微调的自适应程序(4.5:系统)。然而,一些低内存的程序,如梯度检查点[Chen et al. 2016],权衡了计算和内存,可能会加剧基础模型的显著能量消耗。

因素2:数据可用性。任务专门化主要需要特定任务的标记数据作为训练信号。57然而,注释的成本在不同的任务和语言中差异很大;例如,对MRI数据的注释需要专家的医学知识,而对英语文本的标记情感只需要常识判断。当自适应数据丰富时,我们可以应用传统的微调方法或它们的轻量级对应方法。在低资源基于语言的设置中,结合提示和微调已被证明是一个有希望的方向[Schick和Schutze 2021a,b;Gao等人2020c;Perez等人2021;IV等人2021年;Min等人2021年]。Le Scao和Rush [2021]表明,一个调优良好的提示可以值大约100个训练示例,并且对一个仔细提示的基础模型进行微调明显比微调一个无条件的基础模型更具有数据效率。

因素3:访问基础模型梯度。尽管基础模型对一些研究社区有重大影响,但对于大规模的基础模型(有超过500亿个参数),分配实践几乎没有标准化。随着我们逐渐意识到基础模型误用带来的潜在危害(见5.2:误用),提供对所有基础模型参数的微调可能会导致伦理问题。此外,大多数用户没有足够的计算资源来利用他们的全部访问权限。例如,基础模型的内存需求可能会排除它们对许多组织和机构进行直接微调。因此,未来的基础模型提供者可能会限制对模型的完整参数的访问,而不是提供代理API访问,如早期的基础模型GPT-3所示。在一个极端,如果一个基础模型提供者只允许访问模型输出(例如,文本延续的提示,生成的图像,或分数评估图像和文本描述之间的对齐),基础模型可以适应使用上下文学习[Brown et al. 2020]。上下文学习冻结了基础模型参数,并通过调节一个(通常是自然语言)提示来引导基础模型的输出,该提示可能由任务指令或演示组成。为了提高上下文学习的性能,需要仔细设计提示,通过手动搜索或自动程序[Jiang等人2020;Shin等人2020],并对自适应数据进行验证。在另一个极端,如果基础模型提供者授予对关于模型参数的梯度的访问权,则可以应用完全微调,其中更新所有模型参数,以提高下游任务的性能。作为中间地带,我们只能获得基础模型输入的梯度访问,58比基础模型参数要低得多。在这种情况下,我们可以部署轻量级自适应技术[Liu等人2021e;Li和梁2021;Lester等人2021],它冻结模型参数,并为每个任务优化一个连续的前缀或提示。

Use cases for adaptation.

当模型的期望用例与用于基础模型训练(4.2:训练)的相对一般的训练目标不同时,自适应是有用的。最常考虑的情况是,基础模型适用于执行特定的任务(例如,文本摘要或从图像中进行的动物分类),从而缩小了模型的范围。实际上,本节前面描述的绝大多数现有方法都是针对这种设置的。然而,其他形式的适应也是有用的,如进行局部模型编辑,以纠正对特定输入的不良预测,或向训练后的基础模型添加隐私约束,这是与任务无关的。在本小节中,我们将描述适适应的各种用例、最适用于它们的方法,以及在解决这些设置时所面临的剩余挑战。

任务专门化。基础模型适应研究最广泛的案例是任务专门化案例,其中基础模型用于优化特定任务或一组任务的性能。例如,专门用于摘要任务将诱导基础模型行为从输入文档中提取关键思想,并将它们重新组织成短的摘要句。各种适应程序已被证明对任务专业化是有效的,比未适应模型有显著改善[Howard和Ruder 2018;Brown等人2020]。除了对特定任务的专门基础模型进行相对广泛的研究之外,其他任务不可知的适应问题由于它们的规模和计算需求,对基础模型变得越来越具有挑战性(但同样重要)。例如,训练基础模型的成本使得随着时间的推移进行持续的训练,以保持模型对当前事件的更新预测特别昂贵。此外,收集用于训练基础模型的大量匿名数据集(4.6:数据)的挑战使个人信息泄漏到训练集的可能性非常小;因此,在事后从基础模型中有效删除训练数据的机制是可取的。

时间适应。理想情况下,基础模型存储的知识紧密地代表了世界的状态,独立于形态。然而,世界在不断变化;新的国家元首被选举出来,服装风格的改变,社会规范和信念的改变(5.6:伦理),语言的使用的演变,导致输入分布、目标预测分布的变化,或两者都有。由于诱导分布转移,这种时间偏移提出了一个具有挑战性的统计问题,如4.8中讨论的:鲁棒性。对于基础模型,时间偏移也是一个特别困难的计算问题;由于训练基础模型的计算要求[Shoeybi等人2019;频繁的从头开始的再训练可能会产生不可接受的财务或环境影响[Bender等人2021](5.3:环境),或者只是需要太长时间才能成为保持模型更新的可行方法。在视觉领域,在中间时间点对未标记数据进行渐进的自我训练可以在长时间内跨越时间转移,但仍然是一个昂贵的再训练程序[Kumar et al. 2020a]。

在语言模型的背景下,时间分区诊断的数据集有助于量化大型语言模型过时的速度[拉扎里杜等2021;洪贝亚等2021;印度等2021],表明经典技术如重新加权训练数据和动态评估(在生产时使用新数据更新模型参数[Mikolov等2010])可以部分缓解,但不能完全解决这个问题。明确地将语言模型设置为它要建模的时间段是另一种显示出一些希望的技术[Dhingra等人,2021]。 解决时间转移的另一种策略是设计基于检索(半参数)模型,通过从大型的、可解释的数据库(如维基百科文章)中检索的额外上下文[卡普钦等2020;刘易斯等2020b;Guu等2020;坎德尔瓦等2020;Khattab等2020]。对于基于检索的模型,自适应对应于更新数据库中的单个信息单元(例如,百科全书文章的单个段落),而不需要再训练模型。虽然很有前景,但基于检索的方法在训练准确的检索机制和准确地调节检索到的信息方面仍然面临着挑战[Lewis et al. 2020b]。我们将在后面的持续学习背景中重新讨论时间适应问题。

域专门化。除了任务专门化之外,通常还需要将基础模型专门化到特定领域(如法律文档),而不限制基础模型可以完成的任务的广度。这种专门化导致了基础模型训练和自适应数据分布(4.8:鲁棒性)之间的不匹配,这可能需要新的自适应方法来处理。先前的研究发现,不同的和一般的预训练前数据会导致当前的适应方法的负转移。例如,Cole等人[2021]表明,微调仅在自然动物分类数据集上预训练的模型,比微调750K其他图像提供更好的下游性能;同样,改进的[2020],优于BERT [Devlin等人2019],在法律文件中文本分类和序列标记的下游训练集上进行训练。领域专门化的一种方法是包括一个中间的自适应步骤,其中基础模型继续对来自专门化领域的未标记数据进行训练。例如,该方法显著提高了卫星图像和专门文本主题的下游性能[Reed等人2021;Gururangan等人2020]。然而,在某些领域,如法律文件,持续的基础模型培训可能比从头开始的表现更差[Chalkidis等,2020]。阐明持续培训有利于或不有利于绩效的情况是未来工作的一个重要方向。

本地模型编辑在某些情况下,在局部调整基础模型是有用的,这意味着模型的预测分布应该只适用于单个输入或围绕单个输入的局部邻域,而不改变模型对不相关输入的行为。例如,当一个基础模型对特定的输入短语和目标语言产生特别有问题的误译时,最好在不影响模型行为的情况下纠正这种误译。过去的工作研究了通过新的预训练目标对大型神经网络应用近似局部更新的问题,使其易于编辑标准梯度下降[Sinitsin等人2020],预测基础模型参数编辑的高阶网络[曹等人2021;米切尔等人2021;Hase等人2021],以及约束微调程序[Zhu等人2020]。然而,现有的方法在不损害全局模型性能的情况下进行模型编辑的可靠性上有所不同。此外,由于这些方法需要计算高阶梯度的计算成本,因此它们的规模并不简单[Sinitsin等人2020;曹等人2021;米切尔等人2021]。

应用约束。在一些设置中,需要调整基础模型以满足隐私约束。例如,Carrini等人[2021]证明了现有的基础模型能够记忆训练数据中的敏感信息,并在通过标准api查询时可以反刍这些数据。虽然这一现象需要改进数据管理,但发展自适应程序,以消除或减少特定数据例子对训练模型的影响,将是一个补充的解决方案。在这一方向上改进的适应战略(以及更好的培训前方法)也将有利于根据《一般数据保护条例》(GDPR)建立基础模式的机构,因为该授权赋予了用户被遗忘的权利。虽然关于机器遗忘的主题的研究[Bourtoule等人,2019;Cao和杨,2015]已经开始获得关注,但这个问题尚未对基础模型进行深入研究。此外,根据较少管理的互联网数据训练的基础模型显示出针对特定群体的有害偏见(如性别和种族偏见)[Bender等2021;Basta等2019;Kurita等2019;盛等2019],并可产生有毒产出[Gehman等2020](5.2:误用)。虽然策略等进一步微调基础模型在精心策划的数据集(可能多代)[索莱曼和丹尼森2021]或应用可控生成技术[Keskar et al. 2019]显示了一些成功在减轻有害行为,一个框架培训公平和安全的基础模型(5.1:公平)可能需要进一步研究的集体努力在数据收集、培训和适应阶段以及咨询领域专家。

A long-term goal for foundation model adaptation research.

在某种程度上,适应涉及到有效地整合模型的现有知识与新的数据或目标,适应的自然扩展是持续学习[麦克洛斯基和科恩,1989年;Parisi等人,2019年]或持续适应。不断适应基础模型的能力是可取的,是否保持模型的知识不断更新世界事件或文化发展,不断添加数据从全新的领域或模式可用,或不断编辑模型的记忆符合隐私或法律约束作为社会的价值观或法律发展。然而,持续的学习问题通常会导致灾难性的遗忘[麦克洛斯基和科恩,1989;拉特克利夫,1990;柯克帕特里克等人,2017],在神经网络中,随着训练分布的变化,旧的任务或数据会迅速被遗忘。

我们认为基础模型的持续适应是未来基础模型适应研究的一大挑战。要解决这一挑战,需要缩小在来自不同任务、领域或时间段的非平稳数据流上连续训练的基础模型与从i.i.d.训练的相同基础模型之间的性能差距数据来自总混合物[Lopez-Paz和Ranzato 2017]。为了做到这一点,可能需要对模型架构和培训目标进行创新。例如,虽然记忆机制长期以来被认为是成功持续学习的关键[法语1999],并对基础模型的一些希望[Lewis等人2020b;古等人2020;Borgeaud等人2021],有效利用更新的记忆仍然是一个具有挑战性的问题[张和崔2021]。此外,在基础模型中定位知识以进行目标参数更新的技术[Dai等2021a]或学习这些更新规则[曹等2021;米切尔等2021]可能有助于防止遗忘,但重复应用这些更新仍会导致显著的遗忘[Hase等2021]。持续的基础模型适应也可能还需要对灾难性遗忘问题如何在基础模型的规模上表现出新的理解,以及开发新的元学习技术[施米德胡伯1987;Santoro等人2016;芬恩等人2017],以改进已经学习的信息向前转移到新的环境。对已部署的基础模型收集的经验进行持续培训,甚至对许多不同模型收集的聚合经验进行培训,可能会加快基础模型开发的进展速度,但会产生反馈循环的风险,以及侵蚀模型行为和利益相关者价值的对齐。尽管上述挑战,持续基础模型适应的希望更快地应对社会文化价值观的转变,更好地利用现有知识学习新概念,减少环境影响和增加基础模型的可访问性通过消除训练从零开始的计算负担,并减少以前学习的概念必须重新学习由于遗忘。

Evaluation

Introduction.

评估为机器学习模型提供了背景:它作为跟踪进展的手段(1)我们如何衡量模型的性能,以及我们如何设计改进的模型(4.1:建模);(2)理解模型表现出什么行为(4.11:可解释性),以及它们如何在不同的数据切片上执行(4.8:健壮性);(3)文档——我们如何有效地总结模型行为并将其传达给不同的利益相关者。对于基础模型来说,上述每个评估目的都是至关重要的,但基础模型的本质带来了在其他AI或ML设置中通常不会遇到的新挑战:

(1)跟踪进度需要相对的比较,但比较基础模型是复杂的,因为基础模型必须适应(可能以不同的方式)来执行任务。

(2)理解需要对正在评估的内容有预先明确的知识(例如,分类法),但基础模型获得的紧急技能(例如,上下文学习)在设计评估时很难预测。

(3)文档需要明确的需求来有意义地为决策提供信息,但是基础模型可以适用于无数的应用程序,这使得全面的文档具有挑战性。

定位评估基础模型的讨论,我们区分两类评价产生的抽象的基础模型的评价内在,由于这些模型的任务无关脱离特定的任务,和任务特定模型的外在评价,这必然依赖于基础模型和适应机制。进一步,我们认识到,由于基础模型的预期影响和范围,各种利益相关者(例如,基础模型提供者和应用程序开发人员、审计师和决策者、从业者和研究人员)将需要评估基础模型和特定任务的衍生品,这些评估服务不同的目的和涉及不同的需求基于利益相关者。考虑到这一点,评估机器学习模型的标准范式并没有明确地为基础模型的设置而设计。因此,我们强调内在评价(4.4.2:内在评价)、外在评价中适应的重要性(4.4.3:评价-适应)和评价设计(4.4.4:评价-设计),作为建立更适合基础模型的评价框架的明确步骤。这一讨论有助于围绕机器学习系统评估的作用进行更广泛的对话[加利斯和斯帕克琼斯1993年;利普顿和斯坦哈特2019年;里贝罗等人2020年;林岑2020;基拉等人2021;米莉等人2021;雅各布斯和沃拉克2021;鲍曼和达尔2021;2021;德加尼等人2021年;马等人2021a,并且,可能受益于利用机器学习之外的测量和评估理论[梅西克1987;杰克曼2008;1957;梅西克1988;手2010;布鲁尔和克兰诺2014]。

Intrinsic evaluation.

机器学习系统的评估传统上以任务为基础,通常被设想为对应用程序特别有用的功能(例如,翻译、对象识别)。相比之下,由于基础模型是中介资产,必须进一步适应或专门化以执行有用的任务,因此必须改变标准的评估范式,以促进对基础模型的直接理解和比较。

一种方法是根据与训练目标相关的任务来评估基础模型。例如,像GPT-3这样的语言模型,通过预测给定前面上下文的下一个单词进行训练,可以根据它分配给单词的概率(即对语言建模基准的困惑[Paperno等人,2016])进行评估。到目前为止,这种方法在自然语言处理中显示出了希望,但我们确定了它所表现出的两个基本限制。首先,依赖培训目标进行评价缺乏通用性:使用不同不兼容目标训练的基础模型不能在一致的框架内进行比较或理解。第二,以这种方式评估依赖于有意义的代理关系,也就是说,训练目标的测量应该与其他更有意义和可理解的数量(例如,通过基础模型生成的内容质量)相关。虽然这种代理关系在过去的某些情况中被证明是健壮的,但在评估基础模型更多样的功能时、它们在更不同环境或领域中的行为以及域内精度之外的考虑时(我们将在4.4.4:评估设计)中更广泛地讨论这个问题)。鉴于这些限制,我们预计将需要考虑两种方法,提供互补的好处。

从广泛的外在评价中推断出内在评价。评估基础模型的一个方法是使它们适应广泛的任务,并测量由此产生的任务特定的模型的性能。由于基础模型是所有这些模型的共享基础,因此总体上的性能反映了这种共享基础的性质和质量。目前,人工智能的许多子领域已经开始构建元基准,即单一的评估,整合多个不同任务或领域的个人评估[Wang等2019b,a;胡等2020;桑特尔卡等2020;格曼等人2021;亨德里克斯等人2021b;Koh等人2021;Tamkin等人2021b]。鉴于这一模式的日益采用及其已确立的优势,我们在这里注意到为什么它可能不足以完全满足关于基础模型的评价目标。元基准评估需要适应(最低限度地将基础模型专门化于元基准中的每个任务),这使得由于涉及的添加过程(即适应),对基础模型本身的推理具有挑战性。具体来说,这使得进展问题复杂化,无论是跟踪(例如,基于有效的基础模型或精心设计的适应实践),还是识别用于学习基础模型的过程中的改进(例如,数据选择(4.6:数据)、培训目标(4.2:培训)和模型架构(4.1:建模),可能很难通过比较两个基础模型之间的元基准的性能来识别)。此外,这种评估范式使其难以理解或文档特定于基础模型的属性和功能,这可能会使其笨拙地传达给某些利益相关者(例如,超级绿层性能可能没有足够的信息,或可能会误导决策者)或作为预测他们的行为的新任务或领域的依据。

对内在属性的直接评价。为了补充元基准测试的使用,我们还讨论了为什么直接测量基础模型的属性(例如,特定的能力或偏差)是有价值的,而脱离了特定的任务。59例如,我们可以努力直接衡量基础模型的语言能力,以识别语法上有效和无效的句子。为了激发这种方法的价值,我们回到评估的目的。阐明了能力、技能和偏见的存在和强度,确定了需要改进的具体领域(进展),阐明了当前的潜力(理解),并有效地表达了相关方面(文档)。这种方法也适用于广泛可理解的评价,即技术专家、非技术专家(如决策者或社会科学家)和一般目的都可以理解的评价。例如,描述这些模型的说服力或修辞能力可能特别直观地内化其虚假信息和误用的潜力(5.2:误用)(Buchananetal.2021]。

对属性的直接评价也是更好地处理基础模型的突发属性的重要途径;为了证明这一点,我们以上下文学习为案例研究。特别是,Brown等人[2020]不仅证明了GPT-3具有健壮的上下文学习的签名能力,而且是第一个明确识别上下文学习作为一种适应和与模型交互的特定方式的人(通过他们对GPT-3的探索)。传统的基于任务的外部评估并没有提供一种明确的方法来识别上下文学习;在这种情况下,与基础模型的直接交互似乎是必要的。更普遍地说,虽然似乎不可避免,许多意想不到的现象如上下文学习将承认通过非结构化或松散结构化探索这些模型和他们的能力,我们相信新的评估方法应该寻找结构这个探索,更雄心勃勃,建议新属性,然后可以更严格的测试。内在评价也可能降低证明基础模型潜力的阈值;如果基础模型的新方法证明了内在评价的改进,即使它们没有立即伴随的话,也不能伴随相应的适当的适应方法来激发外部评价的能力。有一个重要的开放性问题;这种评价的机制尚不清楚。我们列举了一些可能有助于指导内在评估的设计和执行的一般原则和考虑事项。

(1)灵感来自于对人类的评价。我们对基础模型感兴趣的许多相关属性、能力和偏差也对人类很感兴趣,这表明在人类中测量这些特性的方法可能被证明对评估基础模型是有指导意义的,甚至是直接可翻译的。例如,人类语言能力的心理语言学测量可以被修改来评估基础模型语言能力[列维2008年;弗兰克等人2013年;林岑等人2016年;艾廷格和林岑2016年;马文和林岑2018年;范希恩德尔和林岑2018年;富特雷尔等人2019年;普拉萨德等人2019年;艾丁格2020年]或人类社会偏见的心理测量可以被修改来评估基础模型社会偏见[格林沃尔德等人1998年;卡利斯坎等人2017年;梅等人2019年;郭和卡利斯坎2021年]。

(2)人的循环评估。人在循环中的评估可能被证明是提供一个更具探索性的方法来理解基础模型的关键,包括评估它们的生成或交互能力。特别是,直接与基础模型的人工交互可以更好地识别它们的紧急能力和局限性,并对基础模型进行直接审计[例如,拉吉和布奥拉姆维尼2019,5.6:伦理]可能会推进文档和透明度的目标。

(3)内在措施的有效性。虽然内在测量允许在源头上进行直接测量,即测量和评估独立于适应和特定任务的基础模型的属性,但它们对建立对评估有效性的信任提出了挑战[Messick 1987,1988]。特别是,外部评估结果在验证内在测量设计方面也很重要,

Extrinsic evaluation and adaptation.

评估特定于任务的模型历来涉及到在一个特定的保留测试集上报告模型的性能(通常意味着准确性)。虽然这种模式可能足以部分地理解或记录一个模型,但它往往相当于对由不同(而且可能不平等)资源产生的特定任务模型之间的不公平比较,这使得很难衡量取得了多少进展。在基础模型体系中,不公平比较的担忧加剧:不同的基础模型(如BERT和GPT-3)可能构成不同的特定任务模型的基础,这些基础模型可能涉及极大不同数量的训练数据和计算。

为了考虑到达到特定绩效水平所需的资源,Linzen [2020]认为,(培训前)培训资源应该在评估中得到承认和跟踪。我们认为这是一个有科学原则的建议;比较不考虑培训资源的培训基础模型的不同方法可能会产生误导。然而,考虑到建立基础模型的过程特别昂贵(例如,需要大量的人力和金融资本),而且除了科学因素外,还经常受社会因素(例如,商业激励)的控制,因此基础模型在实践中提供的培训资源将有很大差异,使控制比较困难。

在这里,我们考虑一种可能更普遍可行的替代方案,以部分解释补充Linzen [2020]提案所涉及的资源。特别是,我们考虑了为什么外部评价应该承认适应资源,这对于确保外部评价能够确定最有效的适应方法(内在评价从根本上不能做到的)至关重要。我们提请注意这样一个事实,即适应资源通常被解释为用于适应模型的数据,但额外的资源[例如,用于选择适应方法的数据;Perez等人,2021]和约束(例如,适应基础模型所需的访问水平;参见4.3:适应和5.6:进一步讨论的伦理)。

考虑到适应资源。考虑到适应特定任务的基础模型所花费的资源,需要完全了解不同适应方法所使用的资源或约束条件,即,努力考虑这些资源的评估必须随着用于适应的资源的发展而发展(4.3:适应)。在现有的特定于任务的评估中,大多数评估都指定了可用于使(基础)模型适应任务的数据量。然而,Perez等人[2021]在这里确定了一个在过去的工作中被忽略的关键细微差别,因为这应该封装用于告知适应的所有数据,即用于适应基础模型的数据和用于选择适应方法的数据。此外,在基础模型制度中,对不同适应方法的准入要求的概念也是一个应纳入评价的新考虑因素。具体地说,一些自适应方法通常可能优于其他方法,但可能比其他方法需要更强的能力来访问或修改基础模型(例如,微调需要基础模型梯度来修改基础模型,而提示可能在指定输入时只需要黑盒访问)。

考虑到适应所涉及的资源,丰富了从特定任务模型的评估中可以合理得出的结论。目前,特定任务的评估可能提供足够的理解或记录特定任务的工件(即正在评估的确切模型),但没有提供明确的信号,不同的适应方法如何执行和如何选择一个特定的适应方法在给定的上下文。

通过考虑资源和访问需求参与适应,评估更好地使研究确定哪些适应方法或过程充分利用提供的资源,也就是说,信号是提供不仅是特定的工件被评估,但更一般的过程派生。因此,拟议的评价方案显然致力于确定应使用哪种适应方法;我们注意到,所有这些结论都应始终被视为特定于给定的基础模型,因为这种形式的评价不能提供足够的证据来得出结论,即适应方法在所有基础模型中都是最好的。

Evaluation design

理论上,评估的目标是衡量和描述各种理论结构(如准确性、稳健性)、公平性(稳健性:公平性)、效率(4.5:系统)、环境影响(进度、理解、文档))。然而,在实践中,评价的效用将取决于如何设计和执行评价。例如,对基础模型的生成能力的自动测量(例如,它们的事实正确性)可能不能很好地捕捉到这些质量的本质,相反,人类的循环评估可能更好地背景化这些能力。

在考虑我们所设想的基础模型及其自适应的衍生物的评估设计时,我们从评估的力学开始。传统上,机器学习模型的评估涉及一个用于学习模型的大型训练集,一个用于设置超参数的可选验证集,以及一个评估学习模型的泛化的测试集[Bishop 2006]。因此,历史上创建评估模型的基准需要大量数据,其中大部分用于培训,当数据稀缺或昂贵时,某些诊断或微妙评估的设计变得复杂[Rogers 2020,2021]。相比之下,因为基础模型的好处往往会与适应的样本效率(即少射击或零射击能力)和可能的应用程序的多样性,我们相反设想一个制度的基准个人任务要小得多(因为更少的数据需要提供“训练”,即适应、数据),而且更加多样化(既可以捕捉内在评估的各种能力,又可以以生态有效的方式进行更强的基础评估[布朗芬布伦纳1977;de Vries等,2020年,2020])。这表明,基础模型的性质可能会导致基准性质的转变(以及那些构建基准的人的心态),不强调数量作为基准的关键优先事项,而不是质量和多样性。NLP社区已经开始看到这样一个制度的开始,有广泛和多样化的基准,如大-bench61和FLEX [Bragg等人,2021];这种范式降低了基准设计的障碍,从而使更广泛的社区能够参与评估设计。

除了评估机制之外,评估结果的呈现和界面还将告知如何使用这些结果来为决策提供信息(例如,新的建模方法、模型选择、审计)。排行榜已经成为机器学习中事实上的范式,因此模型可以根据一个特定的和单一的标准(通常是一种准确性的形式)对其进行排序。随着时间的推移,这种方法通常会导致系统质量取得显著和快速的进展,但人们非常担心这是否会产生更普遍的改进[例如,Linzen 2020;鲍曼和达尔2021]。与所有机器学习模型一样,基础模型及其衍生物的需求很少是单一的;相反,我们预计它们的应用广度和社会影响需要高度考虑除准确性之外的标准(如鲁棒性、公平性、效率和环境影响)。为此,我们注意到,基础模型的评估应报告这些不同领域的测量值;现有基准的设计越来越仅仅反映准确性(例如,稳健性[Koh等2021;Goel等2021]、公平[Nadeem等2021;Nangia等2020]、效率和环境影响[科尔曼等2017])。此外,我们注意到,如果以排行榜的形式报告这些不同类别的表现,那么消除潜在权衡(诱导排名)的机制将是特别必要的[埃塔亚拉赫和尤拉夫斯基2020年].特别是,由于不同的利益相关者将具有不同的偏好(例如,他们赋予不同属性的权重)和值[Birhane等人,2020],排行榜设计应允许利益相关者交互和操作排名如何与他们的价值一致;Ma等人[2021a]早期尝试通过使用基于用户指定的效用功能的经济框架来比较模型的效用来实现这一点。

Takeaways.

评估执行了几种对所有机器学习范式都至关重要的角色(即进展、理解、文档化),包括基础模型范式。基础模型为现有的评估框架带来了新的挑战;设计直接针对基础模型制度的评估,不仅将更好地服务于评估的多种目的,而且还服务于所涉及的无数利益相关者。

(1)虽然机器学习评估传统上考虑的是特定于任务的模型,但评估基础模型涉及到这些模型不是特定于任务的事实。对这些模型的评估可能包括整合两种互补的方法: (a)从对特定任务的衍生物的广泛评估中估算基础模型的属性,以及(b)在基础模型中直接测量这些属性。

(2)现有的评价框架往往没有考虑到创建正在评估的模型所需的资源,从而导致不公平的比较。对于基础模型,我们讨论了一种评估范式,强调考虑适应资源(例如,适应中使用的所有数据,基础模型的获取要求),这似乎导致了更多信息性的评估,更好地塑造适应的进行方式。

(3)现有的评价设计往往受到所考虑的指标的多样性,需要大的自适应数据集。对于基础模型,我们响应越来越多的评估要求,考虑更广泛的需求(例如,鲁棒性、公平、效率、环境影响)来捕获广泛的利益相关者价值/偏好,并强调如何适应适应模型的样本效率可能允许通过重新分配设计评估中所涉及的资源来进行更多样化的评估。

Systems

图19。图显示了基于转换器的语言模型(蓝色)的参数数量和训练操作数量(FLOPs)的增长,以及NVIDIA P100、V100和A100gpu(红色)的内存容量和峰值设备容量随时间的增长。每一行的增长率(斜率)的最先进的语言模型(大约10×一年)远远超过硬件的计算能力的增长率(大约10×四年),激励需要并行在大量的加速器和共同设计的算法、模型、软件和硬件来推动进一步的进步。参数的数量和训练操作的数量从相关论文中获得[Brown et al. 2020],内存容量和峰值吞吐量从GPU规格表中获得。

图19。图显示了基于转换器的语言模型(蓝色)的参数数量和训练操作数量(FLOPs)的增长,以及NVIDIA P100、V100和A100gpu(红色)的内存容量和峰值设备容量随时间的增长。每一行的增长率(斜率)的最先进的语言模型(大约10×一年)远远超过硬件的计算能力的增长率(大约10×四年),激励需要并行在大量的加速器和共同设计的算法、模型、软件和硬件来推动进一步的进步。参数的数量和训练操作的数量从相关论文中获得[Brown et al. 2020],内存容量和峰值吞吐量从GPU规格表中获得。

计算机系统是开发基础模型的最大瓶颈之一。基础模型通常太大,无法适应单个加速器的主存(例如GPU),需要大量的计算来训练(例如,GPT-3的>1000petaFLOP/s天[Brown等人2020])。此外,随着时间的推移,这些模型可能会变得更大:例如,最先进的语言模型的计算和内存需求在过去三年中增长了三个数量级,并且预计其增长速度将远远快于硬件能力(图19)。一旦经过培训,这些大型模型执行推理的成本非常高昂,并且在生产应用程序中难以进行调试、监控和维护。我们相信,基础模型的性能和可用性的进一步进步将需要跨算法、模型、软件和硬件系统的仔细协同设计,以及用于编程和部署ML应用程序的新接口。在本节中,我们将讨论开发和生产大规模基础模型的关键计算机系统挑战。

Improving performance through co-design.

今天,训练大规模的基础模型[布朗等人2020;雷等2021;NVIDIA和微软2021;王和小崎2021]通常需要定制软件系统,如威震天、深度速度或网格变形器JAX[肖比等2019;2020;拉斯利等人2020;王2021],建立在标准框架如火炬、张流和JAX [Paszke等人2019;阿巴迪等人2016;布拉德伯里等人2018]。

这些软件系统依赖于跨堆栈中的许多创新来有效规模训练模型:新的并行化维度,如管道并行[Huang等人2019;Narayanan等人2019],限制通信,同时保持设备繁忙,状态分割优化器减少内存使用[拉吉班达里等人2020],即时(JIT)编译器优化计算图[PyTorch 2021],优化库如cuDNN和NCCL [NVIDIA 2021]。威震天和深度速度在特定规模上是有效的;例如,威兆天可以在一万亿参数的模型上提取大约3000gpu的现代硬件理论峰值吞吐量的52%[Narayanan等人,2021b]。然而,扩展到具有更多GPU的更大模型仍然具有挑战性,因为现有的并行化策略在更大的GPU计数时失效。数据并行性受批处理大小的限制[李等人2020e],管道并行性受模型中层数的限制[黄等人2019;纳拉亚南等人2019],张量模型并行性受单个服务器中gpu数量的限制[Shoeybi等人2019]。

虽然我们将继续实现新硬件的性能提高,但大型模型的资源需求的增长远远超过了代际硬件的改进[Brown等人,2020年]。为了促进模型容量的下一个重大飞跃,并使模型质量的进步大众化,共同设计训练算法、模型、软件和硬件将越来越重要,因为许多显著提高性能的途径改变了训练计算的语义。例如,以较低的精度执行操作(如fp16)可以帮助提高现代硬件的吞吐量(例如,V100和A100gpu有专用的用于低精度矩阵乘法的张量核心单元),但也会影响优化过程的数量[Micikevicius等人,2017]。同样,利用权重稀疏性可以显著提高训练和推理时间[Elsen等2020;盖尔等2020],只对模型中的非零进行数学运算,但需要不同的训练算法[Jayakumar等2021;Evci等人2020;德特默斯和泽特莫2019]。协同设计的其他例子包括更有效地映射到硬件的模型架构[所以等2019;孩子等2019;王等2020c;李索普等2021;2021;基塔耶夫等2020年;贝尔塔吉等2020年;泰伊等2020年;任等2021],高效优化[2020年;2020年];新标记化替代;薛等2021年;泰等2021年硬件培训平台,朱皮等2021年;Selene2021年],以及分布式并行化策略[Narayanan等,2019,2021a]。

案例研究:有效的知识表示。作为成功的协同设计的具体案例研究,基于检索的模型,如领域、RAG、ColBERT-QA和复古[Guu等2020;Lewis等2020b;Khattab等2020;Borgeaud等2021]采用不同的模型设计方法,而不是简单地增加模型参数的数量。基于检索的模型不是试图从越来越大的数据集中直接积累隐式知识到具有数十亿参数的DNN模型中(如GPT- 3),而是以文本段落的形式存储模型参数之外的知识,以密集的向量表示捕获段落中的知识。然后,这些模型使用可伸缩的top-𝑘搜索机制来提取与每个输入相关的知识,同时保持DNN模型本身的小规模(4.1.4:建模-内存)。

这种设计提高了模型在生产中的计算效率和可维护性:例如,开发人员可以通过替换文本段落来更新模型的知识,而不需要重新训练大型DNN。基于检索的模型通过利用一些新的交叉功能思想,取得了有希望的初始结果,包括在训练期间通过检索器反向传播损失[Guu等人2020](这需要通过由数百万通道组成的知识存储近似梯度)和建模查询和段落之间的细粒度交互[Khattab和Zaharia 2020;Khattab等人2020](这需要将计算分解为向量级最近邻搜索操作)。这些技术允许基于检索的模型准确和高效,但需要流行的ML框架和最近邻索引不容易支持的功能,如FAISS [Johnson等人,2019]。

Automated optimization.

系统中的另一个重要挑战是自动化跨算法、模型、软件和硬件的优化的应用。虽然许多优化和并行化策略是互补的,但确定最有效的优化组合具有挑战性,因为联合搜索空间以组合方式增长,并且优化以非平凡的方式交互[Narayanan et al. 2021b]。基础模型增加了对自动优化的需求,因为手动实验在数千个gpu的规模下是极其昂贵和耗时的。

最近在这一领域的工作主要集中在针对语义保留优化的系统上。特别是,已经提出了自动发现数学等效图替换的系统[贾等2019a;Wang等人2021c],通过高级api和低级编译器促进分布式执行[Rasley等2020;曼迪20贝恩斯2021;布拉德伯里等2018;沙泽尔等2028;勒皮钦等2020],并自动选择混合分布策略[贾等2019b;桑塔纳姆等2021]。这些系统帮助在工业中部署了许多基础模型[Fedus等人,2021;M2M-100 2020;Turing-NLG 2020]。

不幸的是,当组合语义优化(4.5.1:系统协同设计)时,自动化优化变得更加困难,因为通常不清楚如何联合建模这些技术的统计影响(例如,需要多少次训练迭代才能达到特定的准确性?)。因此,我们将需要新的软件工具、库和编译器来自动识别针对时间-准确性等综合指标的优化组合[科尔曼等人,2017;Mattson等人,2020]。构建这样的工具将需要系统和机器学习专家之间的紧密协作。

Execution and programming models.

基础模型独特的多任务特性提供了一个摊销培训和推理成本的机会。特别是,自适应等范式意味着在模型实例之间有更多的共享[Raffel 2021]。例如,来自同一预训练模型的两个模型前缀调优[Li和Liang 2021]可以共享相同的模型“干”,减少存储占用(共享干只需要存储一次),同时也可以在前缀调优模型之间共享和批处理执行[Shen等人2019;纳拉亚南等人2018]。因此,所使用的特定适应机制为系统优化提供了信息(4.3:适应)。

这是一个开放的问题,编程接口应该用来指定各种适应模型来自相同的预训练模型(例如,模型𝑌和𝑍来自相同的预训练模型𝑋),或者两个模型的各种组件共享参数(例如,两个模型𝐴和𝐵共享相同的茎直到层𝑖)。Ludwig [Molino等人,2019年]和PyTorch的模块提供了在模型中组合功能的简单方法,但目前没有一个系统支持跨模型依赖关系。给用户提供注释的机会将允许训练和推理系统更有效地优化和协调计算;没有这样的注释,系统将无法看到哪些计算实例可以共享模型和参数。模型的“适应历史”(这个特定模型来自什么)也可以用于调试:适应模型对特定类型输入的错误可能来自预训练模型,指出了训练前过程与适应过程中的问题。像PyTorch这样的框架,以及用于训练基础模型的软件库,如拥抱人脸变形金刚[Wolf等人,2020],不允许指定跨整个模型实例的细粒度沿袭信息。

构建和维护数千个加速器的集群也需要巨大的努力。新的培训模式,如学习@Home[ribin和Gusev 2020;Diskin等人2021]探索利用互联网上的志愿者计算来协作训练基础模型。这样从根本上新的执行模型可以降低培训成本的任何一个实体,但需要协作在许多不同领域的安全(以确保恶意志愿者不能显著改变培训过程),分布式系统(处理容错问题作为志愿者下降),和众包。

Productionization of foundation models.

随着社区继续推动基础模型的能力,要实现它们的潜力,将需要解决与在生产中部署这些资源密集型模型相关的挑战。这些挑战包括使用严格的延迟目标执行模型推断,以及确保以自动化的方式监控模型和数据。

对于具有严格成本和延迟约束的应用,如蒸馏等模型压缩技术[Hinton等2015;李等2020d;桑等2019],量化[极力等2018;2011戈拉米等2021;周等2018],修剪[勒村等1990;戈登等2020;麦卡利等2019;王等2019c;Sajjad等2020]和稀疏度[盖尔等2020;埃尔森等人2020]可以通过转换更大的模型以获得所需的推理时间属性来帮助部署。这些技术最初打算用于低内存环境(如移动电话)中的较小模型(如BERT-L),但现在对于处理数据中心部署中现代基础模型的极端规模是必要的。并行化技术,如张量模型并行性[Shoeybi等人,2019年],传统上用于训练,也可能有助于减少推理延迟,并在gpu上提供额外的内存容量,以适应模型的参数。

除了这些实际的约束之外,基础模型和用于训练它们的数据集的规模和复杂性的增加也对模型和数据集的生命周期管理提出了新的挑战。由于具有大量参数的模型很难被人类手动检查,我们需要更好的系统来实现自动化数据集管理(4.6:数据)和模型质量保证。行为测试技术[Ribeiro等。2020]和模型断言[康等。2020]通过提供类似于单元测试、运行时监控(以测试时间断言的形式)和持续的模型改进(随着新的输入输入)来促进生产中的模型维护。这些工具可以帮助解决公平性和偏见的问题(5.1:公平性),并减少模型的错误预测。

2156

2156

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?