本文发表于ICML 2023

论文官网:MultiDiffusion: Fusing Diffusion Paths for Controlled Image Generation

一、Intorduction

文本到图像生成模型已经具有合成高质量和多样化图像的能力,但是由于难以为用户提供对生成内容的直观控制,因此将文本到图像模型部署到现实世界的应用程序仍然具有挑战性。目前实现对扩散模型实现可控的图像生成主要有两种方式:1.从头开始训练模型或针对手头的任务微调给定的扩散模型;2.重用预先训练好的模型,并添加一些控制生成功能。

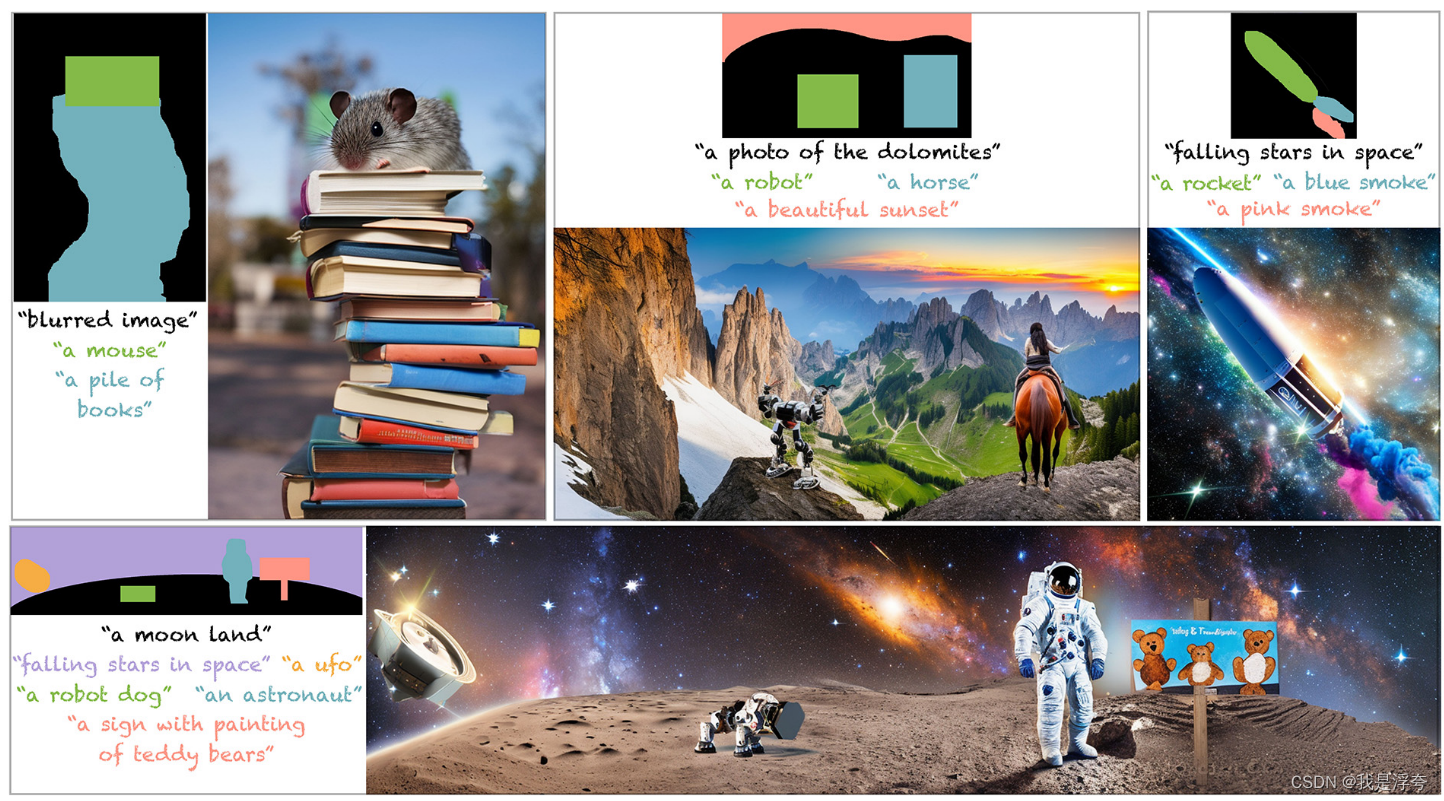

本文提出了一种新的方法:MultiDiffusion,这是一个新的统一框架,可以显着提高将预训练扩散模型适应受控图像生成的灵活性。MultiDiffusion背后的基本思想是定义一个新的生成过程,该过程由几个参考扩散生成过程组成,这些参考扩散生成过程通过一组共享参数或约束绑定在一起。更详细地,将参考扩散模型应用于所生成的图像中的不同区域,预测每个区域的去噪采样步骤。反过来,MultiDiffusion采用全局去噪采样步骤,通过最小二乘最优解协调所有这些不同的步骤。

通过MultiDiffusion,我们能够将参考预训练的文本到图像应用于不同的应用,包括以

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

116

116

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?