Abstract

【创新点-元学习】

We propose an algorithm for meta-learning that is model-agnostic, in the sense that it is compatible with any model trained with gradient descent and applicable to a variety of different learning problems, including classification, regression, and reinforcement learning.

我们提出了一种与模型无关的元学习算法,因为它与任何使用梯度下降训练的模型兼容,并且适用于各种不同的学习问题,包括分类、回归和强化学习。

【元学习的目标】

The goal of meta-learning is to train a model on a variety of learning tasks, such that it can solve new learning tasks using only a small number of training samples.

元学习的目标是在各种学习任务上训练模型,这样它就可以仅使用少量训练样本来解决新的学习任务。

【优势】

In our approach, the parameters of the model are explicitly trained such that a small number of gradient steps with a small amount of training data from a new task will produce good generalization performance on that task.

在我们的方法中,模型的参数被显式训练,即使新任务的训练数据少,其梯度步骤也能在该任务上产生良好的泛化性能。

【另一个优点】

In effect, our method trains the model to be easy to fine-tune.

实际上,我们的方法训练模型很容易微调。

【支撑点】

We demonstrate that this approach leads to state-of-the-art performance on two few-shot image classification benchmarks, produces good results on few-shot regression, and accelerates fine-tuning for policy gradient reinforcement learning with neural network policies.

我们证明了这种方法在两个few-shot图像分类基准上获得了最先进的性能,在few-shot回归上产生了很好的结果,并通过神经网络策略加速了策略梯度强化学习的微调。

摘要

MAML是与模型无关的元学习算法,可以与任何使用梯度下降训练的模型兼容,并且适用于各种不同的学习问题,包括分类、回归和强化学习。在MAML中,模型的参数被显式训练,在小样本客户的模型训练上也能起着很好的泛化性,并且模型易于微调。

1 引言

快速学习是人类智力的一个标志,无论是涉及从几个例子中识别物体,还是在几分钟的经验后快速学习新的技能。

本文希望人工智能也能实现快速学习,从几个例子中快速学习和适应,并随着可用数据的增加而继续适应。实现快速学习是具有挑战性的,因为智能体必须将其先前的经验与少量的新信息相结合,同时避免过度拟合新数据。此外,先前经验和新数据的形式将取决于任务。因此,为了获得最大的适用性,learning to learn(或元学习)的机制应该是通用的任务和完成任务所需的计算形式。

作者提出了一种通用和与模型无关的元学习算法(可以直接应用于任何使用梯度下降过程训练的模型)。其重点是深度神经网络模型,该算法只需最少的修改就可以轻松处理不同的架构和不同的问题设置,包括分类、回归和策略梯度强化学习。

在元学习中,训练模型的目标是从少量新数据中快速学习新任务,模型由元学习器训练,以便能够在大量不同的任务上学习。我们的方法背后的关键思想是训练模型的初始参数,以便在参数通过一个或多个梯度步骤进行更新后,模型在新任务上具有最大的性能,该步骤由来自该新任务的少量数据计算。

与之前学习更新函数或学习规则的元学习方法不同,MAML不会扩展学习参数的数量或对模型架构施加约束,并且可以很容易地与全连接、卷积或循环神经网络相结合。它还可用于各种损失函数,包括可微监督损失和不可微强化学习目标。

训练模型参数的过程,使得几个梯度步骤,甚至单个梯度步骤,可以从特征学习的角度看待新任务产生良好的结果,以构建广泛适用于许多任务的内部表示。如果内部表示适用于许多任务,只需稍微微调参数(例如,通过主要修改前馈模型中的顶层权重)就可以产生良好的结果。

实际上,我们的方法针对易于和快速微调的模型进行了优化,允许适应发生在正确的空间中以进行快速学习。从动力系统的角度来看,我们的学习过程可以看作是最大化新任务的损失函数对参数的敏感性:当灵敏度较高时,对参数的微小局部变化会导致任务损失的巨大改进。

这项工作的主要贡献是一种简单的元学习模型和与任务无关的算法,该算法训练模型的参数,使得少量的梯度更新将导致新任务的快速学习。我们在不同的模型类型(包括全连接和卷积网络)和几个不同的领域(包括少样本回归、图像分类和强化学习)上展示了该算法。评估表明,MAML与最先进的专门为监督分类设计的一次性学习方法相比更有优势,二者同时使用更少的参数,但MAML可以很容易地应用于回归,并且可以在任务可变性存在的情况下加速强化学习,大大优于直接预训练作为初始化。

2 模型不可知元学习

我们的目标是训练能够实现快速适应的模型,这是一个通常形式化为小样本学习的问题设置。在本节中,我们将定义问题设置并展示我们算法的一般形式。

2.1 元学习问题设置-Up

few-shot元学习的目标是训练一个模型,该模型仅使用少量数据点和训练迭代就可以快速适应新任务。为此,模型或学习器在一组任务的元学习阶段进行训练,使得训练后的模型仅使用少量示例或试验就可以快速适应新任务。实际上,元学习问题将整个任务视为训练示例。在本节中,我们以一般方式形式化这种元学习问题设置,包括不同学习域的简要示例。我们将在第 3 节中详细讨论两个不同的学习域。

我们考虑一个模型,表示为 f ,它将观察 x 映射到输出 a。在元学习期间,该模型被训练以能够适应大量或无限数量的任务。由于我们希望将我们的框架应用于各种学习问题,从分类到强化学习,我们在下面介绍了学习任务的通用概念。形式上,每个任务 T= {L(x1,a1,...,xH,aH ), q(x1), q(xt+1|xt,at), H} ![]() 由损失函数 L、初始观测值 q(x1

由损失函数 L、初始观测值 q(x1![]() )、过渡分布 q(xt+1|xt,at)

)、过渡分布 q(xt+1|xt,at)![]() 和情节长度 H 组成。在 i.i.d.监督学习问题中,长度 H = 1。该模型可以通过在每个时间步 t 选择一个输出来生成长度为 H 的样本。损失 L(x1,a1,...,xH,aH )→ R

和情节长度 H 组成。在 i.i.d.监督学习问题中,长度 H = 1。该模型可以通过在每个时间步 t 选择一个输出来生成长度为 H 的样本。损失 L(x1,a1,...,xH,aH )→ R![]() ,提供特定于任务的反馈,这些反馈可能是马尔可夫决策过程中的错误分类损失或成本函数的形式。

,提供特定于任务的反馈,这些反馈可能是马尔可夫决策过程中的错误分类损失或成本函数的形式。

在我们的元学习场景中,我们考虑我们希望我们的模型能够适应的任务 p(T) 上的分布。在 K-shot 学习设置中,该模型被训练以仅从 qi 中提取的 K 个样本和 Ti![]() 生成的反馈 LTi

生成的反馈 LTi![]() 中学习从 p(T ) 中提取的新任务 Ti

中学习从 p(T ) 中提取的新任务 Ti![]() 。在元训练期间,从 p(T) 中采样任务 Ti

。在元训练期间,从 p(T) 中采样任务 Ti![]() ,该模型使用 K 个样本和来自 Ti

,该模型使用 K 个样本和来自 Ti![]() 的相应损失 LTi

的相应损失 LTi![]() 的反馈进行训练,然后在 Ti

的反馈进行训练,然后在 Ti![]() 的新样本上进行测试。然后通过考虑来自 qi

的新样本上进行测试。然后通过考虑来自 qi![]() 的新数据的测试误差如何随参数而变化来改进模型 f。实际上,对采样任务 Tis 的测试误差作为元学习过程的训练误差。在元训练结束时,从 p(T) 中采样新任务,并通过模型在从 K 个样本中学习后的性能来衡量元性能。通常,用于元测试的任务在元训练期间被保留。

的新数据的测试误差如何随参数而变化来改进模型 f。实际上,对采样任务 Tis 的测试误差作为元学习过程的训练误差。在元训练结束时,从 p(T) 中采样新任务,并通过模型在从 K 个样本中学习后的性能来衡量元性能。通常,用于元测试的任务在元训练期间被保留。

2.2 模型不可知元学习算法

与之前的工作相比,之前的工作试图训练摄取整个数据集的循环神经网络 (Santoro et al., 2016; Duan et al., 2016b) 或可以在测试时与非参数方法结合的特征嵌入 (Vinyals et al., 2016; Koch, 2015),我们提出了一种方法,可以通过元学习来学习任何标准模型的参数,以便准备该模型以实现快速适应。这种方法背后的直觉是一些内部表示比其他表示更具可转移性。例如,神经网络可能会学习广泛适用于 p(T) 中的所有任务的内部特征,而不是单个任务。我们如何鼓励这种通用表示的出现。我们对这个问题采取了明确的方法:由于模型将在新任务上使用基于梯度的学习规则进行微调,因此我们的目标是以这样一种方式学习模型,即这种基于梯度的学习规则可以在从 p(T) 中提取的新任务上取得快速进展,而不会过度拟合。实际上,我们的目标是找到对任务变化敏感的模型参数,使得参数的微小变化会对从 p(T) 中提取的任何任务的损失函数产生很大的改进,当沿该损失的梯度方向改变时(见图 1)。我们对模型的形式没有假设,除了假设它是由某个参数向量 θ 参数化的,并且损失函数在 θ 中足够平滑,我们可以使用基于梯度的学习技术。

形式上,我们考虑一个由参数为 θ 的参数化函数 fθ![]() 表示的模型。在适应新任务 Ti

表示的模型。在适应新任务 Ti![]() 时,模型的参数 θ 变为 θi'

时,模型的参数 θ 变为 θi'![]() 。在我们的方法中,更新后的参数向量 θi'

。在我们的方法中,更新后的参数向量 θi'![]() 是使用任务 Ti

是使用任务 Ti![]() 上的一个或多个梯度下降更新来计算的。例如,当使用一次梯度更新时,

上的一个或多个梯度下降更新来计算的。例如,当使用一次梯度更新时,

![]()

步长 α 可以固定为超参数或元学习。为简单起见,我们将在本节的其余部分考虑一个梯度更新,但使用多个梯度更新是一个简单的扩展。

通过优化 fθi'![]() 相对于从 p(T) 采样的任务中 θ 的性能来训练模型参数。更具体地说,元目标如下:

相对于从 p(T) 采样的任务中 θ 的性能来训练模型参数。更具体地说,元目标如下:

请注意,元优化是在模型参数 θ 上执行的,而目标是使用更新的模型参数 θ' 计算的。实际上,我们提出的方法旨在优化模型参数,使得新任务上的一个或几个梯度步骤将产生对该任务的最大有效行为。

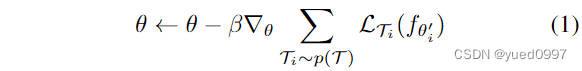

跨任务的元优化是通过随机梯度下降 (SGD) 执行的,使得模型参数 θ 更新如下:

其中 β 是元步长。在一般情况下,完整的算法如算法 1 所示。

MAML 元梯度更新涉及通过梯度的梯度。在计算上,这需要通过 f 进行额外的反向传递来计算 Hessian 向量乘积,该乘积由 TensorFlow 等标准深度学习库支持(Abadi 等,2016)。在我们的实验中,我们还包括与丢弃这种后向传递和使用一阶近似的比较,我们将在第 5.2 节中讨论。

3 MAML的种类

在本节中,我们将讨论用于监督学习和强化学习的元学习算法的具体实例。域以损失函数的形式不同,以及任务如何生成数据并将其呈现给模型,但在这两种情况下都可以应用相同的基本适应机制。

3.1. 监督回归和分类

少样本学习在监督任务领域得到了很好的研究,其目标是仅使用来自类似任务的先前数据进行元学习,从该任务的几个输入/输出对中学习一个新函数。例如,目标可能是在仅看到 Segway 的一个或几个示例后对 Segway 的图像进行分类,该模型具有以前见过许多其他类型对象的模型。同样,在few-shot回归中,目标是在对具有相似统计属性的许多函数进行训练时,仅从该函数中采样的几个数据点预测连续值函数的输出。

为了在 2.1 节中的元学习定义的上下文中形式化监督回归和分类问题,我们可以定义范围 H = 1 并丢弃 xt![]() 上的时间步长下标,因为模型接受单个输入并产生单个输出,而不是一系列输入和输出。任务 Ti

上的时间步长下标,因为模型接受单个输入并产生单个输出,而不是一系列输入和输出。任务 Ti![]() 从 qi

从 qi![]() 生成K i.i.d.观测值x,并且任务损失通过模型对于x的输出和相应观测值和任务目标y之间的误差来表示。

生成K i.i.d.观测值x,并且任务损失通过模型对于x的输出和相应观测值和任务目标y之间的误差来表示。

用于监督分类和回归的两个常见损失函数是交叉熵和均方误差(MSE),我们将在下面描述;不过,也可以使用其他监督损失函数。对于使用均方误差的回归任务,损失的形式为:

其中x(j),y(j)![]() 是从任务Ti

是从任务Ti![]() 中采样的输入/输出对。在K-shot回归任务中,每个任务提供K个输入/输出对进行学习。

中采样的输入/输出对。在K-shot回归任务中,每个任务提供K个输入/输出对进行学习。

类似地,对于具有交叉熵损失的离散分类任务,损失形式为:

根据传统术语,K-shot分类任务使用每个类的K个输入/输出对,总共N个数据点进行N向分类。给定任务p(Ti![]() )上的分布,这些损失函数可以直接插入到2.2节中的方程中进行元学习,详见算法2。

)上的分布,这些损失函数可以直接插入到2.2节中的方程中进行元学习,详见算法2。

3.2. 强化学习

在强化学习(RL)中,少量元学习的目标是使智能体仅使用少量的测试设置经验就能快速获取新测试任务的策略。一项新任务可能涉及在新环境中实现一个新目标或成功完成一个以前训练过的目标。例如,一个智能体可能会学会快速找出如何在迷宫中穿行,这样,当面对一个新的迷宫时,它就能确定如何只用几个样本就可靠地到达出口。在本节中,我们将讨论如何将MAML应用于强化学习的元学习。

每个RL任务Ti![]() 包含一个初始状态分布qi

包含一个初始状态分布qi![]() (x1

(x1![]() )和一个过渡分布qi(xt+1|xt,at)

)和一个过渡分布qi(xt+1|xt,at)![]() , 损失LTi

, 损失LTi![]() 对应于(负)奖励函数r。因此,整个任务是一个具有视界H的马尔可夫决策过程(MDP),其中学习者允许查询有限数量的样本轨迹以进行少量学习。MDP的任何方面都可能在p(T)中的任务之间发生变化。正在学习的模型fθ

对应于(负)奖励函数r。因此,整个任务是一个具有视界H的马尔可夫决策过程(MDP),其中学习者允许查询有限数量的样本轨迹以进行少量学习。MDP的任何方面都可能在p(T)中的任务之间发生变化。正在学习的模型fθ![]() 是一个策略,它将状态 xt

是一个策略,它将状态 xt![]() 映射到每个时间步t∈{1,…,H}

映射到每个时间步t∈{1,…,H}![]() 。任务Ti

。任务Ti ![]() 和模型fφ

和模型fφ![]() 的损失为

的损失为

在K-shot强化学习中,K从fθ![]() 和任务Ti

和任务Ti![]() ,(x1,a1,...,xH )

,(x1,a1,...,xH )![]() ,以及相应的奖励R(xt,at)

,以及相应的奖励R(xt,at)![]() ,可用于适应新任务Ti

,可用于适应新任务Ti![]() 。

。

由于未知动态,预期奖励通常不可微,因此我们使用策略梯度方法来估计模型梯度更新和元优化的梯度。由于策略梯度是一种非策略算法,因此在fθ![]() 适应过程中,每增加一个梯度步骤都需要从当前策略fθi'

适应过程中,每增加一个梯度步骤都需要从当前策略fθi'![]() 中获取新的样本。我们将在算法3中详细介绍该算法。该算法与算法2具有相同的结构,主要区别在于步骤5和步骤8需要从任务Ti

中获取新的样本。我们将在算法3中详细介绍该算法。该算法与算法2具有相同的结构,主要区别在于步骤5和步骤8需要从任务Ti![]() 对应的环境中采样轨迹。该方法的实际实现还可以使用最近针对策略梯度算法提出的各种改进,包括状态或动作相关的基线和信任区域(Schulman et al., 2015)。

对应的环境中采样轨迹。该方法的实际实现还可以使用最近针对策略梯度算法提出的各种改进,包括状态或动作相关的基线和信任区域(Schulman et al., 2015)。

4. 相关工作

我们在本文中提出的方法解决了元学习的一般问题(Thrun & Pratt, 1998;Schmidhuber, 1987;Naik & Mammone, 1992),其中包括少镜头学习。元学习的一种流行方法是训练一个元学习者,它学习如何更新学习者模型的参数(Bengio etal ., 1992;Schmidhuber, 1992;Bengio et al., 1990)。这种方法已被应用于学习优化深度网络(Hochreiter et al., 2001;Andrychowicz et al., 2016;Li & Malik, 2017),以及用于学习动态变化的循环网络(Ha et al., 2017)。最近的一种方法学习了权值初始化和优化器,用于少量图像识别(Ravi & Larochelle, 2017)。与这些方法不同,MAML学习器的权重使用梯度更新,而不是学习更新;我们的方法不为元学习引入额外的参数,也不需要特定的学习器架构。

针对生成建模等特定任务也开发了少量学习方法(Edwards & Storkey, 2017;Rezende等人,2016)和图像识别(Vinyals等人,2016)。少射分类的一种成功方法是学习在已学习的度量空间中比较新示例,例如使用Siamese网络(Koch, 2015)或递归注意机制(Vinyals等,2016;Shyam et al., 2017;Snell et al., 2017)。这些方法已经产生了一些最成功的结果,但很难直接扩展到其他问题,例如强化学习。相反,我们的方法与模型的形式和特定的学习任务无关。

元学习的另一种方法是在许多任务上训练记忆增强模型,其中循环学习者被训练以适应新任务。这种网络已经应用于少量图像识别(Santoro et al., 2016;Munkhdalai & Yu, 2017)和学习“快速”强化学习智能体(Duan et al., 2016b;Wang等人,2016)。实验表明,该方法在小样本分类上优于循环方法。此外,与这些方法不同,我们的方法只是提供了一个很好的权重初始化,并对学习器和元更新使用相同的梯度下降更新。因此,对学习器进行额外的梯度步骤微调是很简单的。

我们的方法也与深度网络初始化的方法有关。在计算机视觉中,对大规模图像分类进行预训练的模型已被证明可以学习一系列问题的有效特征(Donahue et al., 2014)。相比之下,我们的方法显式地优化了模型的快速适应性,允许它只使用几个示例就适应新的任务。我们的方法也可以被看作是显式地最大化新任务损失对模型参数的敏感性。许多先前的工作已经探索了深度网络的敏感性,通常是在初始化的背景下(Saxe等人,2014;Kirkpatrick et al., 2016)。这些作品中的大多数都考虑了良好的随机初始化,尽管一些论文已经解决了数据依赖性初始化(Kr ø ahenb ø uhl等人,2016;Salimans & Kingma, 2016),包括学习初始化(Husken & Goerick, 2000;Maclaurin et al., 2015)。相比之下,我们的方法明确地在给定的任务分布上训练灵敏度参数,允许在一个或几个梯度步骤中非常有效地适应K-shot学习和快速强化学习等问题。

5. 实验评价

我们实验评估的目的是回答以下问题:(1)MAML能否实现新任务的快速学习?(2) MAML是否可以用于多个不同领域的元学习,包括监督回归、分类和强化学习?(3)使用MAML学习的模型是否可以通过额外的梯度更新和/或示例继续改进?

我们所考虑的所有元学习问题都需要在测试时适应一些新的任务。在可能的情况下,我们将我们的结果与接收任务标识(这是一个问题相关的表示)作为额外输入的oracle进行比较,作为模型性能的上限。所有的实验都是使用TensorFlow (Abadi等人,2016)进行的,它允许在元学习期间通过梯度更新进行自动区分。该代码可在线获取1。

5.1. 回归

我们从一个简单的回归问题开始,它说明了MAML的基本原理。每个任务都涉及从正弦波的输入到输出的回归,其中正弦波的振幅和相位在任务之间是不同的。因此,p(T)是连续的,其中振幅在[0.1,5.0]范围内变化,相位在[0,π]范围内变化,输入和输出的维数均为1。在训练和测试期间,数据点x从[- 5.0,5.0]均匀采样。损失是预测值f (x)与真实值之间的均方误差。回归器是一个具有2个大小为40的隐含层的神经网络模型,具有ReLU非线性。当使用MAML进行训练时,我们使用一个梯度更新,K = 10个样本,固定步长α = 0.01,并使用Adam作为元优化器(Kingma & Ba, 2015)。基线同样与亚当一起训练。为了评估性能,我们在不同数量的K个示例上对单个元学习模型进行微调,并将性能与两个基线进行比较:(a)对所有任务进行预训练,这需要训练网络回归到随机正弦函数,然后在测试时,使用自动调整的步长,对K个提供的点进行梯度下降微调,以及(b)接收真实幅度和相位作为输入的oracle。在附录C中,我们展示了与其他多任务和适应方法的比较。

我们通过微调由MAML学习的模型和K ={5,10,20}数据点上的预训练模型来评估性能。在微调期间,使用相同的K个数据点计算每个梯度步骤。定性结果如图2所示,并在附录B中进一步扩展,表明学习模型能够快速适应只有5个数据点(紫色三角形),而使用标准监督学习对所有任务进行预训练的模型无法充分适应如此少的数据点而没有灾难性过拟合。

至关重要的是,当K个数据点都在输入范围的一半时,用MAML训练的模型仍然可以推断出另一半范围内的幅度和相位,这表明MAML训练的模型f已经学会了对正弦波的周期性进行建模。此外,我们在定性和定量结果(图3和附录B)中都观察到,使用MAML学习的模型在额外的梯度步骤中继续改进,尽管在一个梯度步骤后被训练为最大性能。这一改进表明,MAML优化了参数,使它们位于一个可以快速适应的区域,并且对p(T)的损失函数敏感,如2.2节所述,而不是过拟合参数θ,仅在一步后改善。

5.2. 分类

为了将MAML与之前的元学习和少量学习算法进行比较,我们将我们的方法应用于Omniglot (Lake et al., 2011)和MiniImagenet数据集上的少量图像识别。Omniglot数据集由来自50个不同字母的1623个字符的20个实例组成。每个实例都是由不同的人绘制的。MiniImagenet数据集由Ravi & Larochelle(2017)提出,包含64个训练类、12个验证类和24个测试类。Omniglot和MiniImagenet图像识别任务是最近最常用的少量学习基准(Vinyals等人,2016;Santoro et al., 2016;Ravi & Larochelle, 2017)。

为了将MAML与之前的元学习和少量学习算法进行比较,我们将我们的方法应用于Omniglot (Lake et al., 2011)和MiniImagenet数据集上的少量图像识别。Omniglot数据集由来自50个不同字母的1623个字符的20个实例组成。每个实例都是由不同的人绘制的。MiniImagenet数据集由Ravi & Larochelle(2017)提出,包含64个训练类、12个验证类和24个测试类。Omniglot和MiniImagenet图像识别任务是最近最常用的少量学习基准(Vinyals等人,2016;Santoro et al., 2016;Ravi & Larochelle, 2017)。

为了将MAML与之前的元学习和少量学习算法进行比较,我们将我们的方法应用于Omniglot (Lake et al., 2011)和MiniImagenet数据集上的少量图像识别。Omniglot数据集由来自50个不同字母的1623个字符的20个实例组成。每个实例都是由不同的人绘制的。MiniImagenet数据集由Ravi & Larochelle(2017)提出,包含64个训练类、12个验证类和24个测试类。Omniglot和MiniImagenet图像识别任务是最近最常用的少量学习基准(Vinyals等人,2016;Santoro et al., 2016;Ravi & Larochelle, 2017)。

我们在表1中给出了结果。MAML学习的卷积模型在这项任务上与最先进的结果相比较,略微优于先前的方法。其中一些现有的方法,如匹配网络、暹罗网络和记忆模型,是在设计时考虑到少镜头分类的,并且不容易适用于强化学习等领域。此外,与匹配网络和元学习器LSTM相比,使用MAML学习的模型使用的总体参数更少,因为该算法除了分类器本身的权重之外没有引入任何额外的参数。与这些先前的方法相比,记忆增强神经网络(Santoro等人,2016)和循环元学习模型代表了一种更广泛适用的方法,像MAML一样,可以用于其他任务,如强化学习(Duan等人,2016b;Wang等人,2016)。然而,如比较所示,MAML在5-way Omniglot和MiniImagenet分类上的表现明显优于记忆增强网络和元学习器LSTM,无论是在1-shot和5-shot的情况下。

在MAML中,当元梯度通过元目标中的梯度算子反向传播时,二阶导数的使用带来了显著的计算开销(参见式(1))。在MiniImagenet上,我们展示了与MAML的一阶近似的比较,其中省略了这些二阶导数。注意,结果方法仍然在更新后的参数值θ ' i处计算元梯度,这提供了有效的元学习。然而,令人惊讶的是,该方法的性能几乎与使用全二阶导数获得的性能相同,这表明MAML的大部分改进来自于目标在更新后参数值处的梯度,而不是通过梯度更新进行微分的二阶更新。过去的研究发现,ReLU神经网络在局部几乎是线性的(Goodfellow et al., 2015),这表明在大多数情况下二阶导数可能接近于零,这部分解释了一阶近似的良好性能。这种近似消除了在额外的反向传递中计算Hessian-vector积的需要,我们发现这导致网络计算的速度提高了大约33%。

5.3. 强化学习

为了评估MAML在强化学习问题上的作用,我们基于rllab基准套件中模拟的连续控制环境构建了几组任务(Duan et al., 2016a)。我们将在下面讨论各个领域。在所有领域中,由MAML训练的模型是一个具有两个大小为100的隐藏层的神经网络策略,具有ReLU非线性。梯度更新使用香草策略梯度(强化)计算(Williams, 1992),我们使用信任区域策略优化(TRPO)作为元优化器(Schulman et al., 2015)。为了避免计算三阶导数,我们使用有限差分来计算TRPO的hessian向量积。对于学习和元学习更新,我们使用Duan等人(2016a)提出的标准线性特征基线,该基线在批次中的每个采样任务的每次迭代中分别拟合。我们比较了三个基线模型:(a)在所有任务上预训练一个策略,然后进行微调;(b)从随机初始化的权重中训练一个策略;(c)一个oracle策略,它接收任务的参数作为输入,对于下面的任务,它对应于代理的目标位置、目标方向或目标速度。(a)和(b)的基线模型通过梯度下降和手动调整步长进行微调。学习到的政策视频可以在sites.google.com/view/maml上观看.

2d导航

在我们的第一个元强化学习实验中,我们研究了一组任务,其中一个点代理必须在2D中移动到不同的目标位置,在一个单位正方形内随机选择每个任务。观察到的是当前2D位置,动作对应于剪切到[−0.1,0.1]范围内的速度命令。奖励是到目标的负平方距离,当智能体距离目标在0.01以内或在H = 100的视界处时,情节终止。使用MAML训练策略,在使用20个轨迹进行1次策略梯度更新后实现性能最大化。针对此问题和以下RL问题的其他超参数设置见附录A.2。在我们的评估中,我们比较了适应多达4个梯度更新的新任务,每个有40个样本。图4中的结果显示了用MAML初始化模型的自适应性能,对同一组任务进行常规预训练,随机初始化,以及接收目标位置作为输入的oracle策略。结果表明,MAML可以在单次梯度更新中更快地学习适应模型,并且在额外的更新中继续改进。

移动

为了研究MAML如何扩展到更复杂的深度强化学习问题,我们还研究了MuJoCo模拟器对高维运动任务的适应性(Todorov et al., 2012)。这些任务需要两个模拟机器人——一个平面的猎豹和一个三维的四足动物(“蚂蚁”)——以特定的方向或速度奔跑。在目标速度实验中,奖励是代理当前速度与目标之间的负绝对值,在猎豹的 0.0 到 2.0 之间均匀随机选择,蚂蚁在 0.0 到 3.0 之间。在目标方向实验中,奖励是前向和后向速度的大小,为每个任务 inp(T ) 随机选择。地平线为 H = 200,除蚂蚁前向/后向任务外,所有问题的每个梯度步骤有 20 个推出,每个步骤使用了 40 个推出。图 5 中的结果表明,MAML 学习了一个模型,该模型可以快速适应其速度和方向,即使只有一个梯度更新,并继续随着更多的梯度步骤进行改进。结果还表明,在这些具有挑战性的任务中,MAML 初始化大大优于随机初始化和预训练。事实上,预训练在某些情况下比随机初始化差,这是先前 RL 工作中观察到的事实(Parisotto 等人,2016 年)。

6.讨论与未来工作

我们介绍了一种基于元学习的方法,该方法基于通过梯度下降学习易于适应的模型参数。我们的方法有很多好处。它很简单,并且没有为元学习引入任何学习参数。它可以与任何适合基于梯度的训练的模型表示相结合,以及任何可微目标,包括分类、回归和强化学习。最后,由于我们的方法仅产生权重初始化,因此可以使用任意数量的数据和任意数量的梯度步骤来执行适应,尽管我们在每个类只有一个或五个示例的分类上展示了最先进的结果。我们还表明,我们的方法可以使用策略梯度和非常少量的经验来适应 RL 代理。

从过去的任务中重用知识可能是制作高容量可扩展模型(例如深度神经网络)的关键因素,可以使用小数据集进行快速训练。我们相信这项工作是迈向简单通用元学习技术的第一步,可应用于任何问题和任何模型。该领域的进一步研究可以使多任务初始化成为深度学习和强化学习的标准成分。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?