深度强化学习

1、强化学习

智能体(agent):一个能够感知环境、通过学习和推理改变自身状态,并且能够采取行动以实现特定目标的实体。智能体可以是物理实体(如机器人)或虚拟实体(如软件程序),以模拟人类智能为目标

多智能体系统(Multi-Agent System, MAS):多个相互作用的智能体,各个智能体之间通过相互通信、合作、竞争等方式,完成单个智能体不能完成的,大量而又复杂的工作

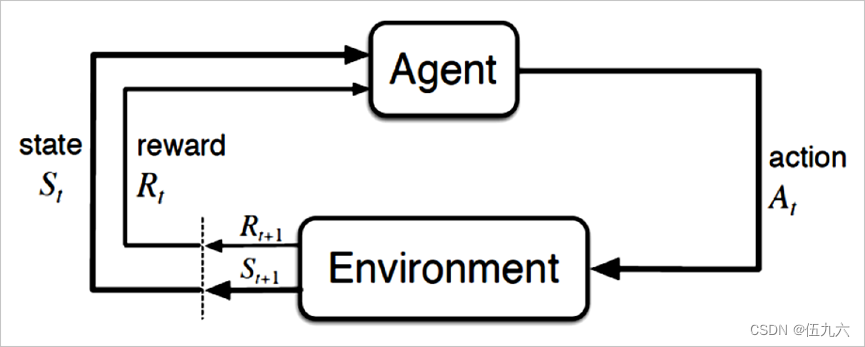

强化学习:(Reinforcement Learning,RL)是描述和解决智能体在与环境的交互过程中学习策略以最大化回报或实现特定目标的问题。基本思想,是让智能体从环境中获取一种状态,由智能体进行决策,对环境做出一种行为,再由环境反馈奖励信号给智能体,透过多次的上述过程,智能体由过往的经历,学习获得的奖励信号最佳的行为。如何设计奖励函数,显得尤为重要,一些可能影响学习策略的先验知识,都是必须考虑如何在奖励函数的设计中体现。

传统RL方法有较多局限性,如学习速率慢、泛化性差、需要手动对状态特征进行建模、无法应对高维空间等

单智能体强化学习(Single Agent Reinforcement Learning,SARL):智能体与环境交互遵循马尔科夫决策过程(Markov Decision Process,MDP)。

单智能体强化学习的基本框架

马尔科夫决策过程:一个典型的序列决策过程的一种公式化,忽略掉历史信息,只保留了当前状态的信息来预测下一个状态。表示为一个四元组(S,A,P,R)。

S 状态 A 动作 P 转移函数 R 奖励函数

Q函数(状态—行为值函数):遵循策略π在某一状态下采取行为的值。

贝尔曼方程:用于求解MDP问题。

多智能体强化学习:(Multi-Agent Reinforcement Learning,MARL)遵循随机博弈(Stochastic Game,SG)过程。

常见算法

Q-学习:思想是利用当前的最优动作值来逼近Q函数。目标是通过学习最优策略,使智能体能够在一个未知环境中做出最佳决策。

PG

DPG

2、深度学习

深度学习:(Deep Learning,DL)一种对数据进行表征学习的方法。基本思想是堆叠多层系统,对输入的信息进行分级处理,再透过调整系统中的参数,让输出的结果与输入的差别尽可能的小。

概念来自于人工神经网络。目标是透过低层次的特征构成高层次的特征,进而学习特征结构,在多个抽象的特征上,让智能体自动学习将输入的信息数据,映射到输出数据的复杂功能,以获得与输入数据差异最小的输出结果,而不需要仰赖人工制造的功能。一般使用神经网络模型对问题建模求解,其中以卷积神经网络(Convolutional Neural Networks, CNN)最为著名。

3、深度强化学习

深度强化学习(Deep Reinforcement Learning,DRL):将对感知信号处理的深度学习与进行决策处理的强化学习相结合

深度强化学习究竟和强化学习有什麼區別呢?深度强化学习是让智能体自己去观察环境的状态,借由深度学习的感知处理,让智能体能够学习观察环境状态的特征,接着再借由强化学习的决策训练,完成整个深度强化学习的结构;强化学习则是由环境直接告诉智能体现在的状态,不需要智能体自己去观察,然后智能体接着开始学习如何做决策。

多智能体深度强化学习:将深度神经网络和传统 MARL 相融合的 MDRL 方法

3.1常见算法

深度Q网络(Deep Q-Learning, DQN): 它使用神经网络对值函数进行近似,与 Q 学习等传统RL算法不同,DQN放弃了以表格形式记录智能体 Q 值的方式,而

采用经验库(Experience Replay Buffer)[14]将环境探索得到的数据以记忆单元 s,a,r,s′ 的形式储存起来,然后利用随机小样本采样的方法更新和训练神经网络参

数。另外DQN还引入双网络结构(Fixed Q-targets),即同时使用 Q 网络和目标网络训练模型,其中 Q 网络参θ 随训练过程实时更新,而目标网络的参数 θ- 是每经过一定次数迭代后 Q 网络参数的复制值,DQN 在每轮迭代 i 中的目标为最小化 Q 网络及其目标网络之间的损失函数。

双重深度学习Q网络DDQN: 深度强化学习(Deep Reinforcement Learning)框架,是基于 Q-learning 的改进版本,解决决策制定者在不确定环境中做出决策的问题。结合了两种重要的技术:深度神经网络和双重 Q-learning,以提高 Q-learning 算法的稳定性和性能。

Q-learning 基础: 在强化学习中,Q-learning 是一种用于学习如何在给定状态下选择最优动作的算法。Q 值(Q-function)表示在特定状态下采取特定动作的累积奖励的期望值。传统的 Q-learning 算法使用 Q 值来指导决策制定者选择最佳策略。

深度神经网络: DDQN 引入了深度神经网络作为函数逼近器,用于估计 Q 值函数。这允许 DDQN 处理具有高维状态空间的问题,并对 Q 值函数进行连续逼近。通常,神经网络的输入是状态,输出是每个可能的动作的 Q 值。

双重 Q-learning: DDQN 的核心创新在于双重 Q-learning 方法。传统的 Q-learning 算法估计了当前状态下的最佳动作的 Q 值,然后使用这些估计的 Q 值来指导决策。但这可能会导致 Q 值的过度估计(Overestimation)。DDQN 引入了两个神经网络,一个用于选择最佳动作(目标网络),另一个用于估计 Q 值(估算网络)。这两个网络交替地被用来选择和估算 Q 值,以减少 Q 值的过度估计。

经验回放: 为了提高样本利用率和稳定性,DDQN 通常使用经验回放(Experience Replay)技术。这意味着它会保存之前的经验,然后从中随机采样用于训练,而不是直接使用当前的经验进行更新。这有助于防止神经网络陷入局部最优解,提高学习的稳定性。

目标网络(Target Network): DDQN 使用两个神经网络,一个用于选择动作,另一个用于估算Q值。其中一个网络被称为目标网络,用于估算目标 Q 值,以减少Q值的波动性和提高算法的稳定性。目标网络的参数定期更新以与估算网络保持同步。

3.1.2基于策略梯度的方法

异步的优势行动者评论家算法(Asynchronous Advantage Actor-Critic,A3C): 使用多CPU线程进行分布式学习的

深度确定性策略梯度DDPG(Deep Deterministic policy gradient): DDPG基于演员评论家(Actor-Critic,AC)框架[20];在输入方面,其通过在 Actor网络引入随机噪声的方式产生探索策略;在动作输出方面采用神经网络来拟合策略函数,并直接输出动作以应对连续动作空间;在参数更新方面,与DQN中直接参数复制的方法不同,该算法采用缓慢更新参数的方法提升稳定性;DDPG还引入了批正则化(Batch Normalization)方法保证其对多种任务的泛化能力。

Deep Stack算法:

增强策略梯度稳定性的信赖域策略优化(Trust Region Policy Optimization,TRPO)

近端策略优化(Proximal Policy Optimization,PPO)算法

1848

1848

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?