我们会很偶然地遇到有这种本地部署,不联网的需求,至于为什么我已经不愿解释,因为我也不懂为什么。

我这里记录一下我用过的方便部署的本地LLM开源资源。

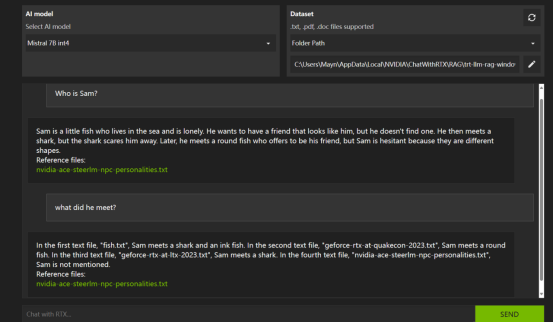

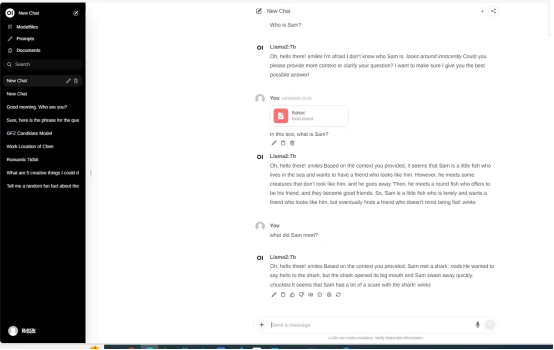

我们在本地存储一样的文档,就是英文版的小鱼找朋友的故事。

一样的原始文本

Look for a friend Sam is a little fish. He lives in the sea.He is very lonely. He wants to have a friend. a friend that looks like him. Sam sees an ink fish. The ink fish has eight legs.He doesn't look like Sam. So Sam goes away. Sam meets a shark. He wants to say hello to the shark. The shark opens his big mouth. Sam swims away quickly. Sam is tired and hungry. He wants to have a rest. Then he sees a round fish.She says to him," Hello!Would you like to be my friend?" Sam answers, "Of course! But you are round. I am flat"The round fish says, "But we are both fish." Sam thinks and says. "You are right. Let's be friends. "They become good friends.

Chat with rtx

Chat with rtx 是英伟达开发的消费级显卡本地部署LLM的demo。

优点:将LLM入门门槛大大降低,学生党普通4060笔记本8G显存以上就可以部署使用。

缺点:安装有点费劲,需要科学上网,容易报错。效果一般,没有自研模型,用的开源模型,是个大整合包。也没法自己参与开发。

来看效果!

Langchain-chat chat

Langchain-chat chat这是一个由国内开发者基于当下流行的LangChain进一步开发的推理框架,它同时支持多种国内外本地大语言模型和在线模型API,除了基础的LLM对话,还集成了文档阅读、本地向量知识库、在线搜索引擎API、Agent等。

优点:可以后期进行开发!!!very cool!最推荐!而且知识库读取在一个文件夹内,不是指定一个文件。

缺点:在我眼里没有。需要服务器级别的显存,消费级不行。

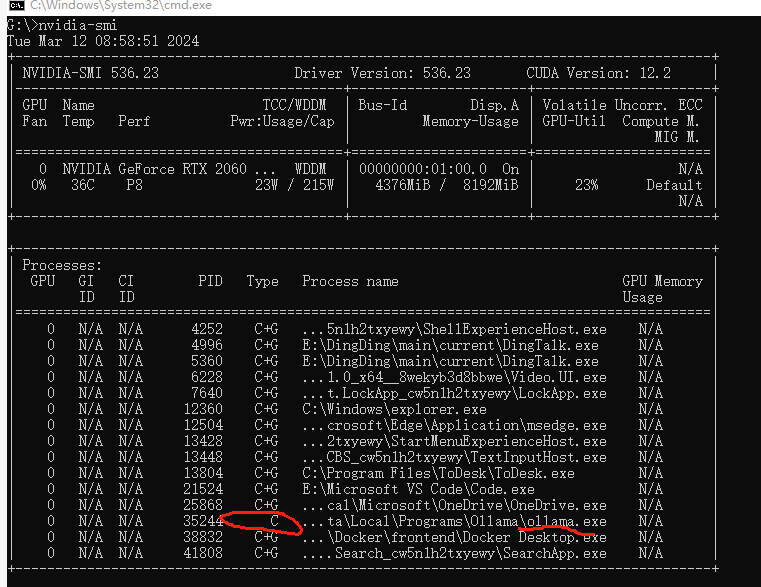

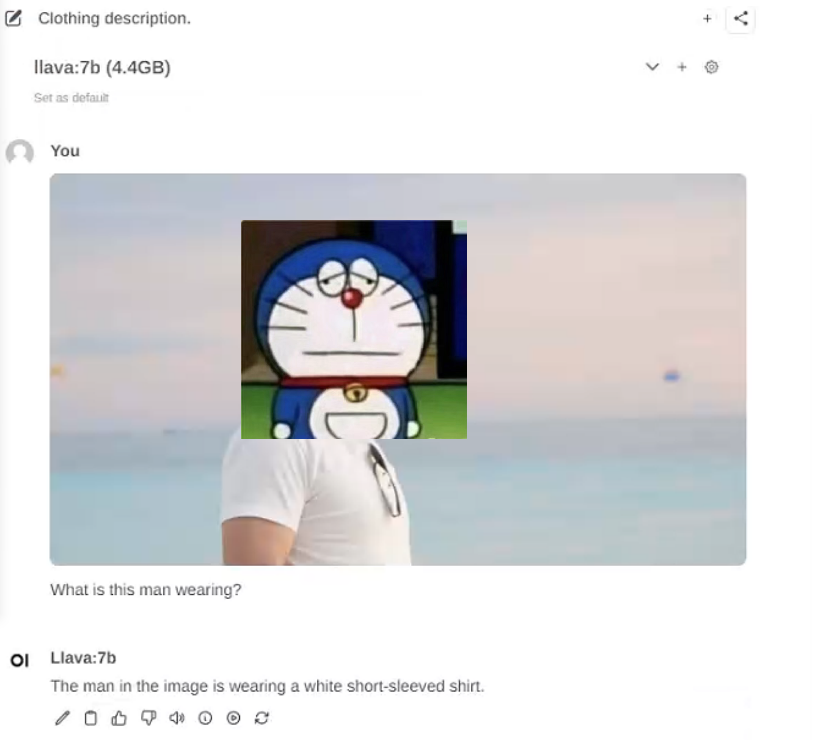

open-webui

主要是因为要用ollama。ollama是一个简明易用的本地大模型运行框架,可以在消费级计算机运行llama.cpp项目的16位浮点精度(FP16)或4-bit量化的模型。它说它支持只使用CPU跑大模型,只要你的内存够大,跑600亿参数模型都不是问题。我测试了一小下,得出结论是还是有用GPU,只是不太多。

优点:安装方便,门槛低,可以windows安装,消费级显卡轻松handle。引入了视觉模型,很牛。

【以上是我领导。。。】

缺点:知识库拓展不是很灵活。不过可能可以开发修正吧。使用体验不是很优雅。。模型切换非常非常慢和卡。。。

最后

我只用过这么多!不知道大家有没有更好用的开源项目!个人觉得服务器部署可用langchain-chatchat,本地windows电脑可以用ollama。氮素!我觉得langchain是学习LLM开发不可避免的~早学早用早舒服!

2198

2198

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?