HMM中第三个问题就是如何进行对HMM进行训练A和B

本章主要通过前向-后向(forward-backward)算法或者叫Baum-Welch算法来主要讲解如何对矩阵A和B进行训练

HMM训练描述为:

给定HMM状态集合,和一系列观测序列,如何对A和B进行训练。

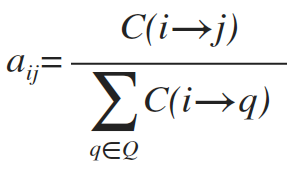

符号C(i→j) 记做从状态i转移到状态j的个数,则转移矩阵为:

其中Q为状态集合。

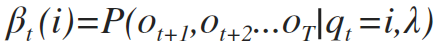

符号β记做后项概率,表示:给定λ,和t时刻状态在j情况下,看到观测序列Ot+1 ...OT的概率

即:

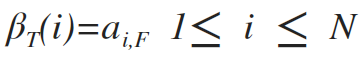

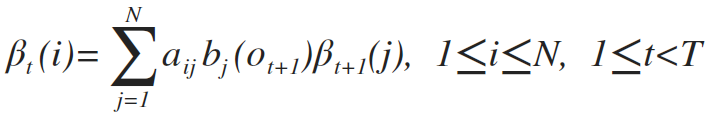

类似前向算法,后向算法可以描述如下:

1.初始化:

2.递归计算:

3.终止:

本文介绍了隐马尔科夫模型(HMM)的训练过程,特别是使用前向-后向算法(Baum-Welch算法)来估计状态转移矩阵A和发射概率矩阵B。详细阐述了前向算法、后向算法的递归计算,并解释了E-step和M-step在该过程中的作用。同时,文章提到了在实际应用中,HMM状态的发射概率通常用高斯混合模型(GMM)来建模。

本文介绍了隐马尔科夫模型(HMM)的训练过程,特别是使用前向-后向算法(Baum-Welch算法)来估计状态转移矩阵A和发射概率矩阵B。详细阐述了前向算法、后向算法的递归计算,并解释了E-step和M-step在该过程中的作用。同时,文章提到了在实际应用中,HMM状态的发射概率通常用高斯混合模型(GMM)来建模。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2109

2109

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?