Windows系统编译支持GPU的llama.cpp

git clone https://github.com/ggerganov/llama.cpp.git

cd llama.cpp

mkdir build

cd build

cmake .. -G "Visual Studio 17 2022" -DGGML_CUDA=ON -DCMAKE_BUILD_TYPE=Release -DCMAKE_CUDA_ARCHITECTURES="86"

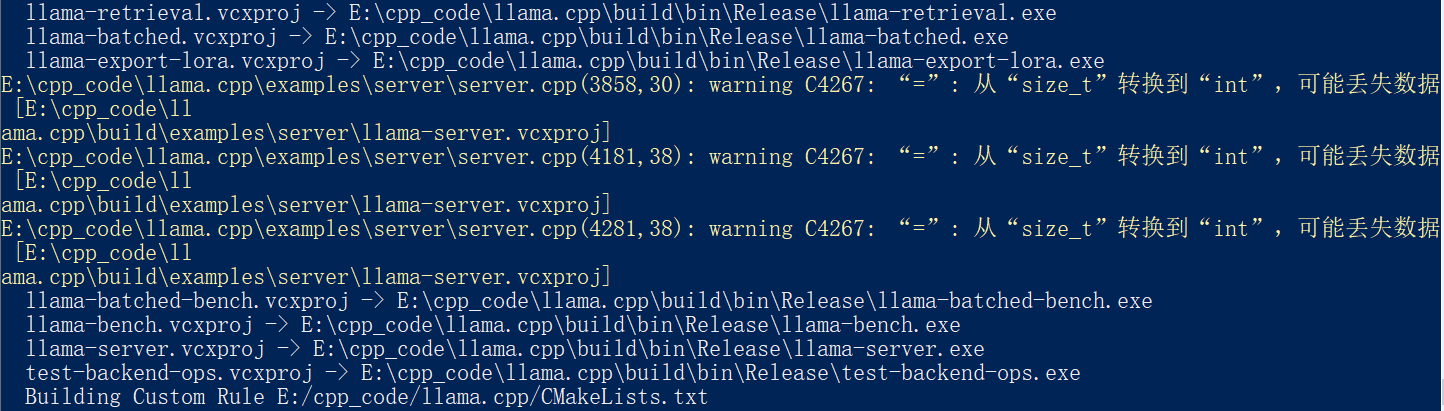

cmake --build . --config Release -- /m

570

570

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?