首先一开始,印度小哥先带我们复习了线性代数的一些烂大街的基本概念

比如:Identity, symmetric, 转置、内积、矩阵乘法

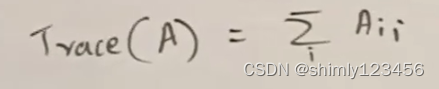

矩阵的迹 = 对角线元素之和

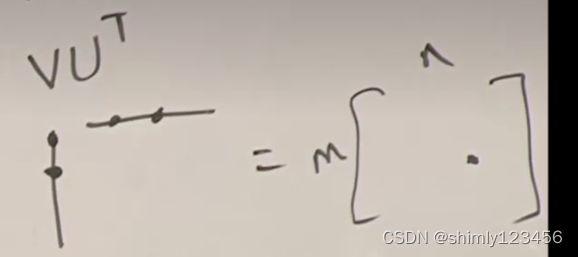

根据印度小哥的说法,“外积”的定义除了“叉乘”,还可以是下面这种 “mx1向量” 和 “1xn向量” 的矩阵乘法,最终结果是一个 mxn 的矩阵

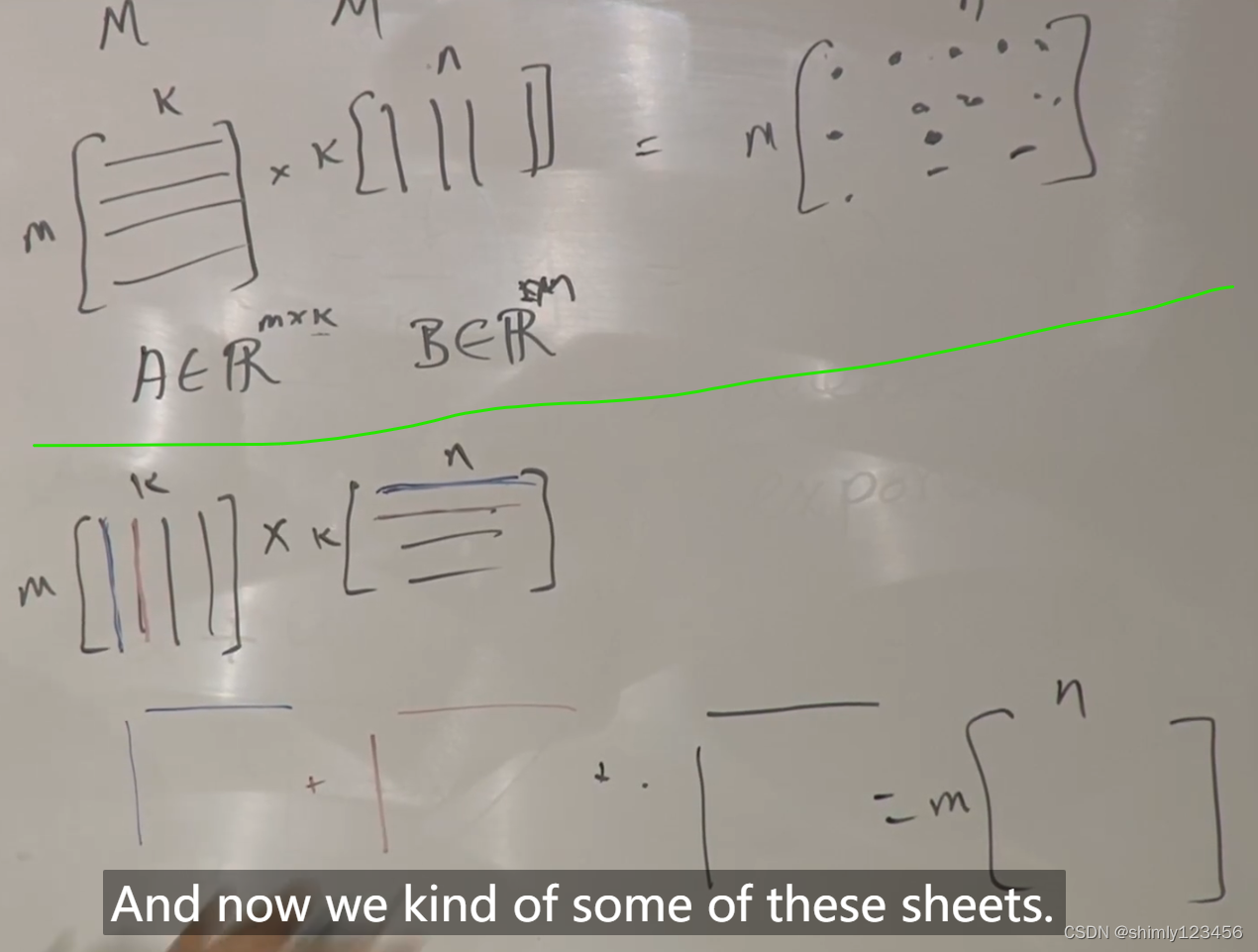

矩阵乘法的两种视角 (分块乘法) 如下

绿线以上的乘法,是进行 mxn 次向量内积,也是常规乘法

绿线以下的乘法,进行 k 次向量外积,然后再进行 k 次加法,这也叫做 “分块乘法”

机器学习中涉及到的数学主要包括 1.线性代数 2.概率论 3.微积分

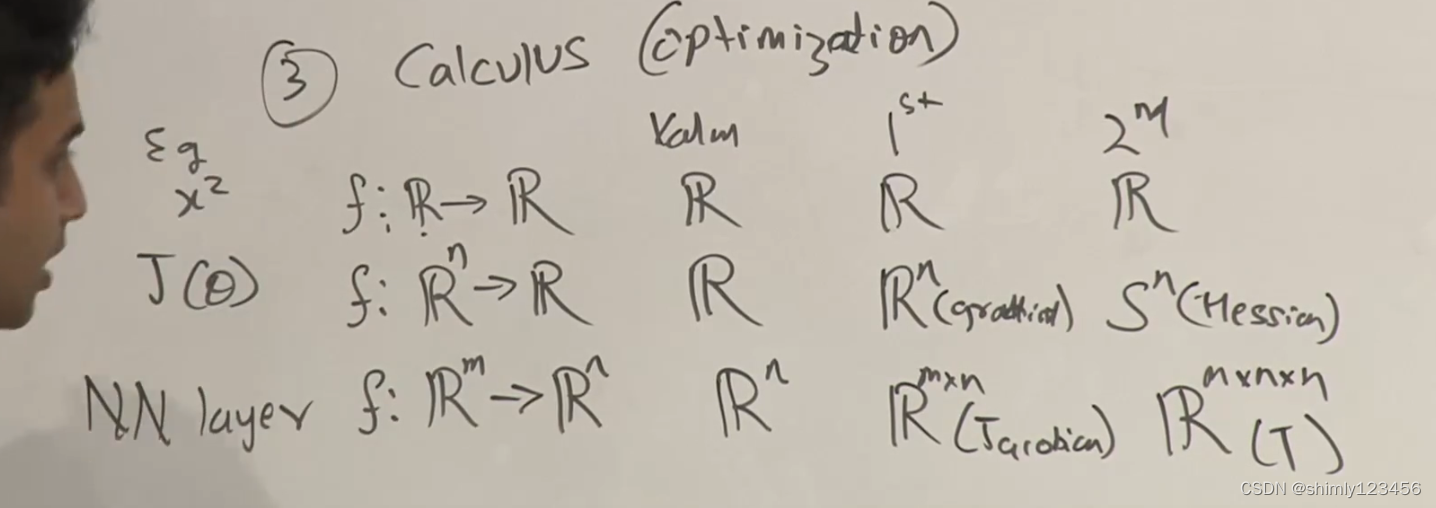

其中微积分的求导在机器学习中非常重要,主要是用于对损失函数进行优化

如上图,当 f: R->R 时,它的一阶偏导和二阶偏导都属于实数域

当 f: R^n -> R 时,它的一阶偏导和二阶偏导分别属于 R^n 和 S^n (对称矩阵,也可以说是 Hessian 矩阵)

当 f: R^m -> R^n 时,它的一阶偏导和二阶偏导分别属于 R^(mxn) 和 R^(mxnxn)

4.核方法、核函数 (讲到 SVM 再考虑这个的细节)

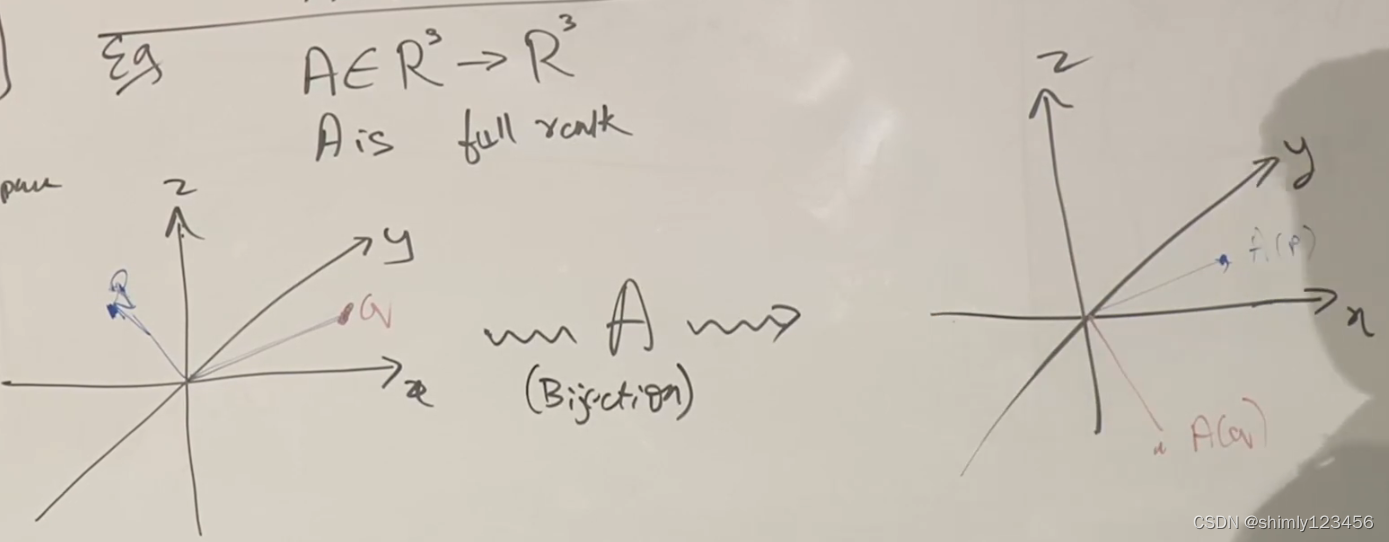

一个矩阵 A 实际上也可以是一个函数,如下图。满秩的矩阵实际上也可以是一个 “双射” 的函数

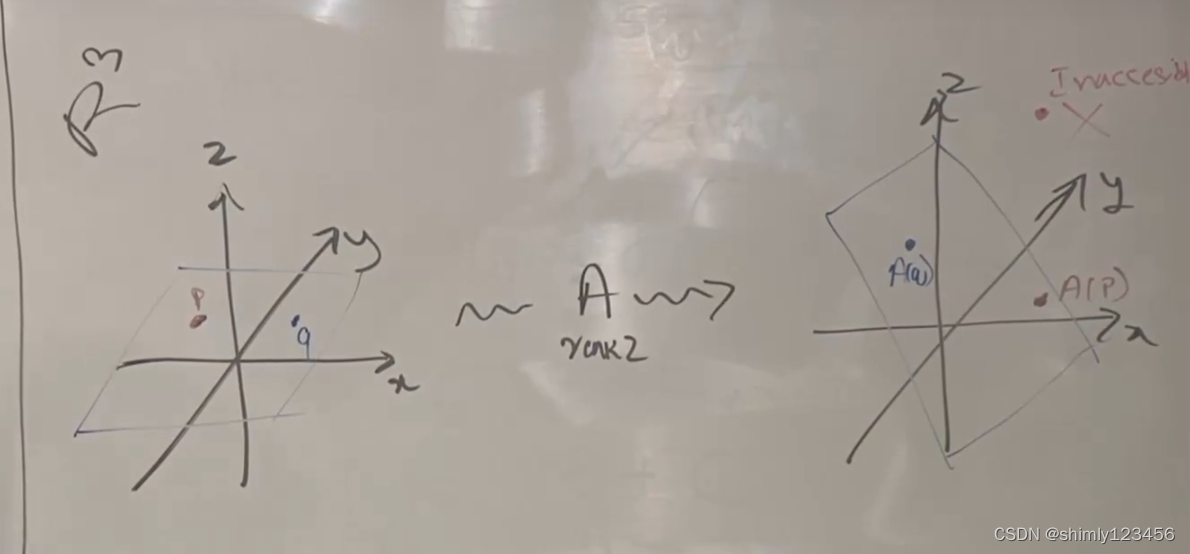

如果 矩阵A 的秩为 2,那么 R^3 中的任意矢量经过 矩阵A 的映射都会打到 一个平面上

如果我们把 矩阵A 看成线性方程组就很好理解

比如矩阵A 对应下面这组线性方程组

x + y = 0

z = 0

那么无论 (x, y, z) 的值是什么,只要它们符合上面那两个线性方程组,那么就代表一个平面

看了一大堆,一堆类似子空间、奇异值分解、正交相似对角化之类的东西,遇到问题的时候再在做题中学习吧,现在不管这么多,有个印象就好

313

313

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?