论文题目:Gradient Harmonized Single-stage Detector

论文链接:https://arxiv.org/pdf/1811.05181.pdf

解决

正、负样本简单和困难眼样本之间的不均衡问题,负样本和简单样本数量多。

之前工作

- 基于实例挖掘: 为了解决之前的不平衡问题,基于实例挖掘的方法如OHEM被广泛使用,但它们直接放弃了大部分的例子,训练效率低下。

- Focal Loss: 对于类不平衡,Focal Loss试图通过修改交叉熵损失函数来解决这个问题。然而,Focal loss采用了两个超参数,需要进行大量的调整。它是一种静态损失,不适应数据分布的变化,随训练过程的变化而变化。

提出

类不平衡可以归结为难度的不平衡,难度的不平衡可以归结为梯度范数分布的不平衡。如果正样本好分类,说明是个简单样本,对模型训练的作用很小,产生的梯度很小由于异常值的梯度可能与其他常见的例子有较大的差异,因此可能会影响模型的稳定性。

- 揭示了单阶段检测器在梯度范数分布方面存在显著不平衡的基本原理,并提出了一种新的梯度协调机制(GHM)来解决这一问题。

- 将分类和回归的损失分别嵌入到GHM-C和GHM-R中,修正了不同属性样本的梯度贡献,对超参数具有鲁棒性。

- 通过与GHM的合并,我们可以很容易地训练一个单阶段检测器,而不需要任何数据采样策略,并在COCO基准上实现最优的结果。

CHM-C Loss

梯度范数

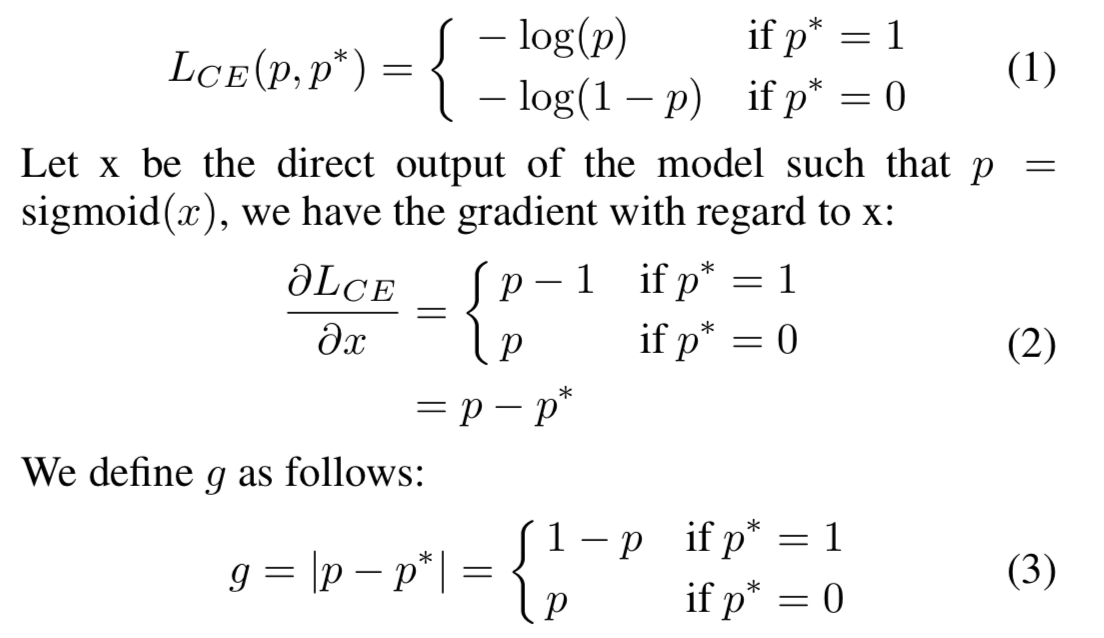

- original gradient norm ,即 g = ∣ p − p ∗ ∣ g=|p-p^*| g=∣p−p∗∣。g等于x对应的梯度范数。 g的值表示一个例子的属性(例如easy或hard),表示这个例子对全局梯度的影响。虽然梯度的严格定义是在整个参数空间上,即g是一个例子梯度的相对范数,但为了方便起见,本文将g称为梯度范数。

- N是总共样例的个数。

- 为了更好地理解梯度密度协调参数,可以将其改写为 β i = 1 G D ( g i ) / N \beta_i=\frac{1}{GD(g_i)/N} βi=GD(gi)/N1

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

305

305

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?