这篇文章说的是《Full-reference quality assessment of stereopairs accounting for rivalry》,是立体图像质量评价比较经典的一篇文章。

首先双目图像肯定比单目图像在感知上更复杂,因为左右眼看到的不是完全一样的,这里面会有视差、左右眼看到的图像的失真类型或程度都有可能不同(即非对称失真,如下图),所以不能简单地平均左右视图的质量分数来作为双目视觉的质量分数。

上图即为非对称失真的一种情况。

双目竞争

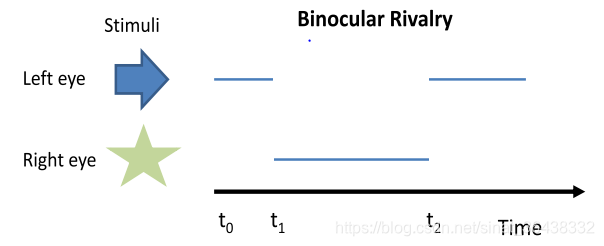

我们视觉在大脑中所呈现的,是一幅图像,这是左右眼视图融合的结果。当左右眼的看到的内容相同时,视觉系统会融合;当左右眼看到的视图足够不一样时,就可能会发生双目竞争的情况。在经历双目竞争过程中,有时会感受到左右眼图像交替在脑中出现,就像下面图像这样箭头和星交替出现。

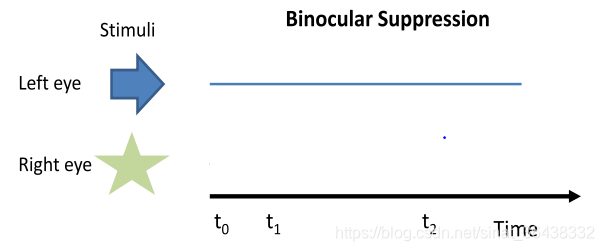

在双目竞争中,有个特例就是双目抑制,即只有一只眼睛看到的图像形成视觉,另一眼中被抑制了,如下图所示:

在双目竞争/抑制过程中,哪只眼睛处于主导地位取决于这两只眼睛接收视觉刺激的相对大小,即接收到视觉刺激大的眼睛处于主导地位。如果两眼一只看到的未失真图像,一只看得到的是模糊失真图像,那么未看到失真图像的眼睛占主导地位,我们感受到的往往是未失真图像,这是因为模糊失真会减少视觉刺激;而当两眼一只看到未失真图像、一只看到JPEG失真图像时,我们往往感受到的是JPEG失真,这是因为JPEG失真增加了视觉刺激。

因此,对双目竞争一个简单的模拟思路是根据左右图像信息刺激大小作为权重加权融合这两幅图像。

双目竞争的简单模拟方法

上面说到可以加权计算融合两幅图像:

CI(x,y)=WL(x,y)×IL(x,y)+WR((x+d),y)×IR((x+d),y)\begin{aligned} C I(x, y)=& W_{L}(x, y) \times I_{L}(x, y) \\ &+W_{R}((x+d), y)\times I_{R}((x+d), y) \end{aligned}CI(x,y)=WL(x,y)×IL(x,y)+WR((x+d),y)×IR((x+d),y)

其中CI表示cyclopean image,即人类视觉将左右视图融合产生的图像。下面详述算法流程。

视差计算和补偿

左右眼像素位置并不是一一对应,因为左右眼存在视差(可以看文章第一幅图车的部分)。所以在计算cyclopean image时,需要首先计算视差来帮助补偿左右视图像素位置的不一致。计算视差的方法有很多,这里论文作者提出一种基于结构相似性SSIM的算法:

假设左视图作为参考图像,计算右视图相对于左视图的视差。对于每个像素位置(x,y),将右视图每个像素循环移位0,1,2,…,N位,每次移位后计算像素(x,y)邻域上左右视图的结构相似性(SSIM),取SSIM值最大的移位数作为像素位置(x,y)的视差。

%来自论文Full-reference quality assessment of stereopairs accounting for rivalry

%来自UT-Austin LIVE实验室

function [disparity mindiff corrmap ] = slide_images(i1,i2,mins,maxs,win_size,weight)

[dimy,dimx,c] = size(i1);

disparity = zeros(dimy,dimx); %-- 初始化返回值

corrmap = zeros(dimy,dimx);

h = ones(win_size)/win_size.^2; %-- 均值滤波模板

[g1x] = gradient(double(i1)); %-- 计算图像梯度

[g2x] = gradient(double(i2));

Precision=1;

step = sign(maxs-mins)*Precision; %--决定循环移位的方向(向左还是右)

for(i=mins:step:maxs)

s = shift_image(i2,i); %-- 循环移位

sx = shift_image(g2x,i);

%--CSAD is Cost from Sum of Absolute Differences

%--CGRAD is Cost from Gradient of Absolute Differences

%-- get CSAD and CGRAD

[s1 ,ssimmap]= ssim(i1,s); % -- SSIM

[sg1,gssimmap]= ssim(g1x,sx); % -- SSIM

CSSIM = imfilter(ssimmap,h); % -- 对SSIM平均滤波

CGSSIM = imfilter(gssimmap,h);

d = 0.5*double(CSSIM)+0.5*CGSSIM; %-- total 'difference' score,除了考虑灰度域SSIM,还考虑纹理域SSIM

idx = find(d>corrmap); %-- 每个像素邻域的SSIM map

disparity(idx) = abs(i)*Precision; % 计算视差

corrmap(idx) = d(idx);

end

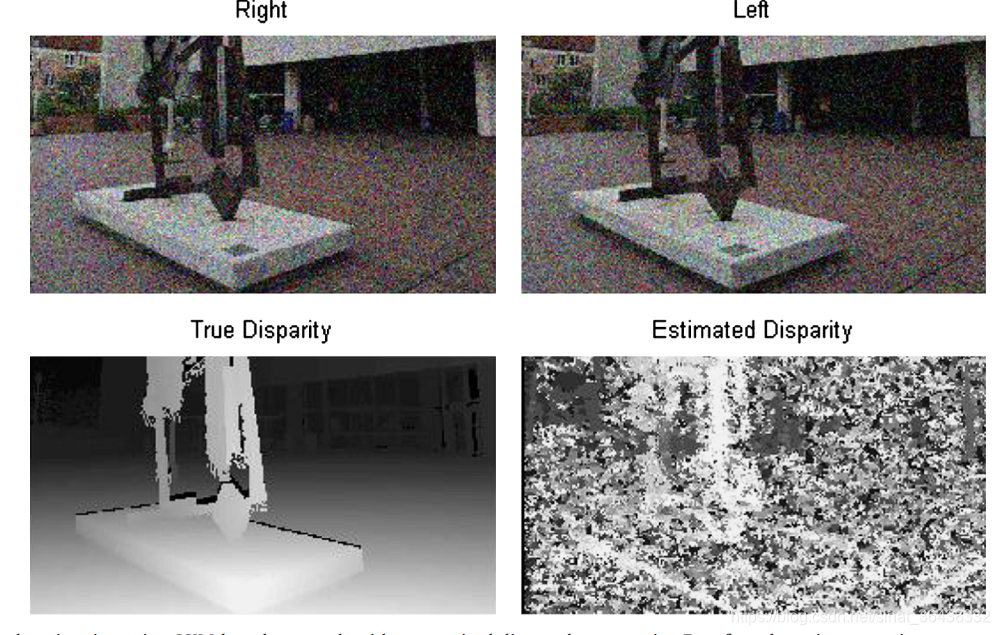

上面就是视差估计的结果,可以看出这个简单的视差估计算法并不是很精确。

上面代码所计算的视差是像素意义上的视差,即左右视图上每个对应点的像素差距。所以可以根据计算出的视差图对右视图的每个点像素位置进行补偿,使左右视图像素点一一对应。

视觉刺激衡量

人类视觉皮层对线性模式(边缘、栅条)有很强的响应,同时视觉皮层对模式的方向有一定的选择性。视觉皮层的这一特性可以用Gabor滤波器进行模拟,这也是Gabor滤波在图像质量评价领域受欢迎的原因。论文在这里也使用了Gabor响应的强度作为视觉刺激强度的模拟:

WL(x,y)=GEL(x,y)GEL(x,y)+GER((x+d),y)W_{L}(x, y)=\frac{G E_{L}(x, y)}{G E_{L}(x, y)+G E_{R}((x+d), y)}WL(x,y)=GEL(x,y)+GER((x+d),y)GEL(x,y)

WR(x+d,y)=GER((x+d),y)GEL(x,y)+GER((x+d),y)W_{R}(x+d, y)=\frac{G E_{R}((x+d), y)}{G E_{L}(x, y)+G E_{R}((x+d), y)}WR(x+d,y)=GEL(x,y)+GER((x+d),y)GER((x+d),y)

WL和WR分别是加权融合图像时的权重,GE即为Gabor滤波响应。

在对左右视图融合之后,就可以应用2D图像质量评价方法来得出质量分数。

模型的效果和代码地址

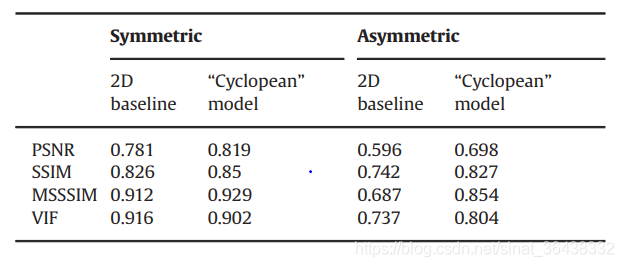

上个表是五种图像质量评价方法分别在对称失真下的双目图像和非对称失真下的双目图像性能效果。其中2D baseline是指直接平均左右视图的质量分数;“Cylopean”model是应用了上述双目竞争模拟方法之后计算融合图像的质量分数。

可以看出,上面的双目竞争模拟方法虽然简单,但是对于非对称失真下的质量评价方法性能还是很大提升。

总的来说,这篇论文为立体质量评价搭建了简单的框架:首先利用双目竞争的特性融合左右视图计算cyclopean image,之后在cyclopean image上参考2D图像质量评价方法来获得质量分数。

论文地址:http://live.ece.utexas.edu/publications/2013/Ming%203D%20NR%20IQA%20paper.pdf

程序地址:http://live.ece.utexas.edu/research/Quality/MJ3DFR_release.zip

本文介绍了一种基于双目竞争原理的立体图像质量评估方法。该方法考虑到双目图像的复杂性,通过模拟大脑融合左右视图的过程,解决了非对称失真问题。文章详细解释了视差计算、视觉刺激衡量及融合图像质量评分的步骤。

本文介绍了一种基于双目竞争原理的立体图像质量评估方法。该方法考虑到双目图像的复杂性,通过模拟大脑融合左右视图的过程,解决了非对称失真问题。文章详细解释了视差计算、视觉刺激衡量及融合图像质量评分的步骤。

3200

3200

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?