上一篇链接:https://blog.csdn.net/sx1996csdn/article/details/111608040

目录

7 Discussions and future directions

5 Datasets

本节详细讨论了用于验证VQA模型及其特征的各种公开可用数据集。基准测试的一般要求VQA数据集包括:

它必须能够抓住问题,图像和概念的可变性。它必须支持一个公平的评估方案,以验证不同的VQA模型。它必须是最小偏差的。

大多数现有的数据集包含由图像、问题及其正确答案组成的三元组。另一方面,一些公开可用的数据集提供了额外的信息,如图像标题、图像区域表示为边界框或多选题候选答案。正确回答VQA数据集中的问题所需的一般功能包括:

•识别物体、属性和空间关系的能力。

•具备计算、逻辑推理和比较的能力。

•利用常识性世界知识。

可用的VQA数据集可以根据三个因素分类:图像类型、问答格式和外部知识的使用。图像的类型又是三个类别:自然,剪贴艺术和合成图像。组成每个VQA数据集见表7。同样,问答格式为开放式和多项选择,分别表示为OE和MC,见表7。另外,组成每个数据集的图像的来源和限制在表7所示。各VQA数据集的样本图像见表8。

DAQUAR(用于真实图像问题回答的数据集)是最早的图像问题回答数据集之一。它是一个关于图像的人类问答对的数据集。COCO- qa起源于Microsoft COCO(上下文中的公共对象)。这些问题是自动从COCO图片标题生成的,有4种不同的类型,比如对象,数字,颜色和位置。所有的答案都是一个单词类型。

VQA数据集由真实图像和抽象的卡通/剪贴画场景组成,可分别命名为VQA-real和VQA-abstract。每幅图片/场景都包含3个问题,每题10个事实答案。动机构建VQA-abstract是将真实图像-问题对的语言抽象程度降到最低。抽象场景由20个“纸娃娃”人体模型(Antol et al. 2014)组成,跨越性别、种族和年龄,有8种不同的表情。这一套包括100多个物体和31个摆出各种姿势的动物。

他们将问题分为8类:例如,关于对象动作、对象类和其他的问题。每个图像至少有两个问题-答案对作为注释。可视化的Madlibs数据集是利用自然生成的fll-in-theblanks模板收集的,目的是积累关于:人和物体,他们的外观,练习和交互,以及关于一般场景或更广泛的设置的推论。Visual7W数据集的灵感来自于W调查在新闻业中根深蒂固的思想,以描述整个故事。他们用了疑问词:什么,哪里,何时,谁,为什么,如何和哪个。Visual7W数据集比VQA数据集突出了更夸张的问题和更长的答案。TDIUC (Task Directed Image Understanding Challenge)是一个针对公众可用的VQA数据集的局限性而开发的数据集,例如:(1)不平衡的问题类型,(2)可以通过忽略图像来回答的问题,以及(3)困难的评估过程。TDIUC的作者将VQA分为12个组成任务(即12个问题)

它是对其他VQA数据集的补充,因为它包含不同安排、类型和颜色的形状,而不是自然场景,这对VQA研究人员提出了独特的挑战。该数据集由关于多种形状之间的空间和逻辑推理的复杂问题组成。从而避免了学习偏差的风险,这是大多数VQA数据集的一个显著缺陷。CLEVR (composition Language and Elementary Visual Question Reasoning)是一个合成图像数据集,类似于形状,但具有简单的三维形状。它由测试一系列视觉推理能力的问题组成,这些问题会导致最小的偏差,还会有支持注释,描述回答问题所需的推理方式。作者声称,cleverr有助于深入分析求解模型的视觉推理能力,这是其他数据集难以解决的问题。

建立了KB-VQA (Knowledge Base-VQA)数据集,用于评估VQA模型在需要更多知识量和使用外部信息对视觉内容进行明确推理的问题上的执行情况。作者给每个问题都贴上了一个特殊的标签,以显示正确回答问题所需的人类估计知识水平。标签是" visual ",“常识”(不需要外部来源)和“KB-Knowledge”(预计需要维基百科或类似的)。FVQA(基于事实的VQA)类似KB-VQA,需要外部信息来回答。区别在于,在这里,作者以结构性三元组(如<Cat)的形式为每个问题-答案对提供了额外的支持事实。对,ClimbingTrees >。

它由15种问题类型组成,这些问题寻求图中对象之间的各种关系,并检查诸如最小、最大、曲线下面积、平滑度和相交等特征。DVQA(数据可视化问题回答)是一个与FigureQA同时开发的数据集,但只测试柱状图的各个方面。它包含三种类型的问题:(1)结构理解(例如,有多少条?),(2)数据检索(例如,从左数第三条的标签是什么?)和(3)推理(例如,哪个算法的准确性最高?)

它由表示小学科学主题的图表组成,每个图表都用成分分割、它们之间的关系以及与图表画布的关系进行了注释。这实际上是视觉研究的一个新方向,通常集中在自然图像的理解上。VizWiz是第一个面向目标的VQA数据集,用于捕获VQA系统的真实用户的真正兴趣。同时,它也是第一个公开的来自盲人的视觉数据集。VizWiz的显著特征包括:(1)图像是由盲人捕获的,因此通常质量较差,(2)问题是口头的,因此更健谈或遭受音频记录的缺陷。(3)许多问题无法回答,因为盲人无法验证他们的图像捕捉到他们所询问的视觉内容。VQA- med是针对医学领域VQA的第一步创建的数据集。这包括医学图像与临床相关的问题回答对。这项任务的成功将提高患者在解释医学图像方面的参与度,也将作为医生在复杂医学图像上的第二意见。采用半自动方法生成问题-答案对;首先使用基于规则的问题生成来生成它们,然后由人类专家进行手动验证。

6 Performance evaluation

为了评估这些模型,Geman等人(2015)为计算机视觉系统引入了一种视觉图灵测试。目前大多数的论文都认为VQA可以被认为是视觉图灵测试的另一种选择,换句话说,它是一个人工智能完成的任务。aiccomplete任务的重要标准之一是有一个定义良好的定量评估指标来跟踪进度。在本节中,简要介绍了各种不同的VQA评估指标。

从表7可以清楚地看出,VQA数据集呈现了两种类型的问题:开放式和多项选择。在多项选择题中,每个问题都只有一个正确答案。因此,对提议的解决方案的评估是直接的,因为人们可以很容易地量化测试问题的平均准确性。在开放式环境中,由于同义词和释义的存在,一个问题可能会有多个正确答案。

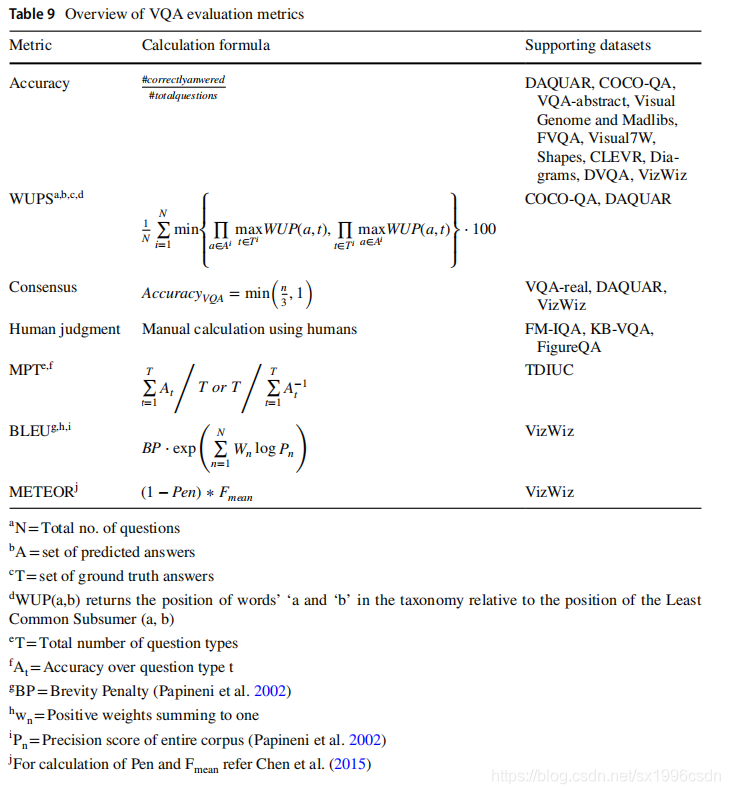

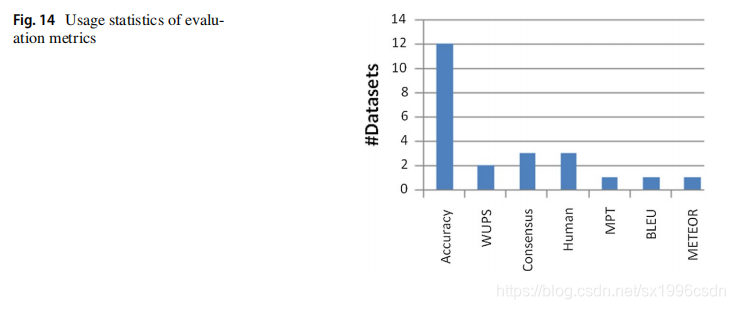

为了便于管理,大多数VQA数据集限制答案只包含几个单词(通常是1到3个单词),或者从一个封闭的答案集合中选择答案,从而将开放式设置转换为多项选择设置。表9给出了主要VQA指标的计算公式以及支持数据集的名称,图14给出了这些指标在各种可用VQA数据集上的使用统计数据,便于研究人员识别评价趋势。虽然在选择题设置中,简单的准确性就足以评估给定的VQA模型,但在开放式设置中,如果只接受与地面事实完全匹配的答案,那就太死板了。例如,如果问题是照片里的动物是什么?而一个模型输出的是狗而不是地面真相狗,它被认为是错误的。由于这些限制,提出了几种备选方案。

它的灵感来自于模糊集理论,它导致了一种软测量而非精度。它试图通过语义上的差异来衡量预测答案与事实真相之间的差异。为了避免在遥远的概念上获得高分,他们还提出了一个阈值WUPS分数,低于阈值的分数将按比例降低一个因子。waps的显著缺点包括:(1)对于词汇相关但意义不同的答案,它会获得高分;(2)对于短语或句子的答案,它不会起作用。另一种选择是共识度量,它基于从每个问题的注释者独立收集的多个ground truth答案,该方法在Antol等人(2015)中使用。这主要有两种类型:平均共识和最小共识。对于平均版本,最终分数是评注者和最小版本答案的加权平均值;答案需要与至少一个注释者一致。最常用的版本(见表9),如果算法同意三个或三个以上的注释者,就会给一个问题打满分。这种方法的局限性包括:(1)允许一个问题有多个正确答案;(2)收集地面真相的费用;(3)由于缺乏共识而存在困难。FM-IQA数据集的作者(Gao et al. 2015)建议使用人工裁判对VQA模型进行人工评价。这个方法适用于单个单词、短语或句子的答案。总之,审判过程存在时间、资源、费用等问题。此外,个人的主观意见也有可能。

在这种情况下;简单的准确性并不能很好地发挥作用,特别是对于比较罕见的问题类型。因此,Kafe和Kanan (2017a)提出了新的性能指标来补偿不平衡的问题类型分布。它被称为每类型平均值(mean-per-type, MPT),表示每个问题类型的计算算术或谐波平均精度。他们还使用标准化的度量标准,比如算术标准化MPT和谐波标准化MPT,来补偿每种问题类型的答案分布的偏差。由Papineni等人(2002)和Denkowski和Lavie(2014)提出的BLEU(双语评估替补)和METEOR(带有明确排序的翻译评估度量)是机器翻译的自动评估度量。Gurari等人(2018)提出,这些可以用作VQA的评估指标,并使用他们的VizWiz数据集进行试验。BLEU分析预测答案和ground truth标签之间n克的共现情况。布鲁经常写不出短句。虽然流星可以通过将预测答案中的单词与地面真相的答案对齐来计算,目标是一一对应的,但有时很难找到这样的对齐。

根据Kafe和Kanan (2017b),评估VQA框架的理想方法仍然是一个开放的问题。新引入的第一个面向目标的VQA数据集VizWiz开启了自动机器翻译评测的新篇章。每一种评估策略都有自己的特点和不足。使用的技术取决于数据集是如何构建的,其中的偏差水平和可用资源。在开发新的VQA模型的同时,我们还需要做大量的工作来创造独特而有效的指标来评估它们的性能。

7 Discussions and future directions

由于其潜在的应用和人工智能的完备性,VQA是近年来引入的一项研究课题。解决这一复杂任务的先决条件包括成熟的计算机视觉和自然的基本任务的研究知识语言处理。然而,VQA研究要达到回答基于图像的问题的人类同等表现的目标还有很长的路要走。读者们,请不要通过图15中不同形状和cleverr数据集的柱状图来推断关于VQA系统性能的声明,因为它们是为研究目的而创建的合成数据集,而应该关注像Viz-Wiz这样性能仍然低于50%的现实数据集。

接下来,表10和图16展示了在VQA数据集上对名为“test-dev”和“test-std”数据集的两个测试分割所做的研究结果。VQA是一个相对较大的数据集,包含265,016张图像和关于图像的开放式问题。这些问题需要理解视觉、语言和常识才能回答。报告的最大准确性约为70%,这表明需要改进。VQA的性能和人的性能之间仍然存在差距,这是由于未被证实的原因。本节揭示了未来在VQA不同方面需要的有前途的工作,以填补机器和人类智能在图像理解方面的差距。

7.1 VQA phases

它们在经典的计算机视觉任务中通过将输入图像分割成一致的包围框来检测目标。然而,VQA通过检测图像中的所有物体,需要更多的自然图像特征语义分割,R-CNN的工作原理是通过选择性搜索,识别出可管理数量的限定框对象区域候选(感兴趣区域或RoI),然后从每个区域独立提取CNN特征。这一尝试应该唤醒VQA研究人员去触摸图像特征化部分,并探索R-CNN、fast R-CNN (Girshick 2015)、faster R-CNN (Ren et al. 2015a, b, c)和最新的面具R-CNN (He et al. 2017)的后代。

要想摆脱VQA的这一冻结阶段,进行足够的细粒图像特征提取就太晚了。对于基于图像的构图问题,特别是像Viz-Wiz这样的真实VQA数据集中的低质量图像,仅从单个网络提取特征是不够的。通过特征融合,将来自多个来源的信息结合起来,可以学习到丰富的内部特征,这为研究开辟了广阔的绿色领域。

在许多嵌入自然语言问题的可能方法中,word- 2vec和GloVe最初吸引了VQA的研究人员,然后他们转向了深度学习模型,如LSTM和GRU。值得注意的是,在2017 - 2018年左右,NLP研究已经远离了word2vec基线。三种被发现对VQA有益的新奇模型是FastText (Bojanowski等人,2017年)、ELMo (Peters等人,2018年)和BERT (Devlin等人,2018年)。

FastText是原始word2vec的扩展,其主要区别是包含了字符n-gram,这允许为没有出现在训练数据中的单词生成单词嵌入,这称为OOV(词汇表外)问题。OOV可以在VizWiz等面向目标的VQA数据集中更加频繁地出现,这些数据集将在未来得到更多的扩展和探索。它也被证明是超级快的训练。

两者都能处理VQA问题,都是上下文化的词嵌入模型,可以根据上下文生成不同的词嵌入。ELMo词嵌入是通过连接两层双向语言模型(如biLSTM)内部状态的激活而产生的。语言模型的不同层捕获不同类型的信息;因此,将它们连接起来产生更自然的词表示。BERT使用Transformer——一种基于注意力的模型,使用位置编码来表示单词的位置。另一个有希望的事实是,BERT是一个预先训练的模型,它以迁移学习的形式提供了快速启动的特征提取。

另一个发人深思的研究是,仍然存在着更好地利用NLP概念来应对VQA挑战的潜力,只有一小部分VQA研究人员Kafe和Kanan(2016)和Noh等人(2016)通过使用跳跃思维向量(Kiros等人2015)进行问题特征化,注意到了这种可能性。他们的结果为开发高级句子嵌入模型的可行性打开了大门,如快速思维向量(Logeswaran和Lee 2018)、InferSent (Conneau等人2017)和谷歌s通用句子编码器(Cer等人2018),用于向量化与VQA相关的自然语言问题。

但是,缺点是,对于像单行问题这样的短句子在VQA中,上下文嵌入可能会因为可用的上下文信息数量有限而不能很好地执行。这就为角色层面的嵌入提供了空间。此外,字符嵌入自然地解决了OOV的常见问题。

胶囊网络(Capsule Networks, CapsNet)是深度学习领域的一个新概念,由Sabour et al.(2017)提出,它的引入让使用CNN进行图像理解的做法受到了震动。他们指出了CNN建筑的两个主要特点。首先,CNN的架构中没有空间信息。然后,用于连接各层的池函数非常低效,因为它会丢失有价值的空间信息。CapsNet通过使用动态路由流程解决了这个问题。这肯定会形成一个简洁的替代VQA系统中的CNN图像特征提取,特别是使用像SHAPES和cleverr这样的数据集,其中的问题数量集中于测试空间推理能力。

尽管这方面的研究较少,但Ren和Lu(2018)最近的一次尝试成功地使用了这一方法CapsNet与组合编码(CC)相结合,减少了词嵌入中参数的使用。他们提出的CC胶囊层输出为VQA中问题特征化提供了一个很有前景的候选对象。Feng等人(2018)还对使用图像和文本学习多模式胶囊的任务进行了深入研究,这直接满足了VQA模型的要求。

赵等人(2019)提出了面向挑战的统一NLP-Capsule框架NLP的应用程序。作者揭示了阻碍将胶囊网络用于NLP任务的主要障碍,如较差的可伸缩性和较不可靠的路由过程。他们通过对问题和答案生成单独的胶囊,并通过问题和答案之间的余弦相似度计算相关性得分,证明了该框架在文本问答任务中的有效性。这可以直接扩展到VQA任务,将输入数据考虑为(图像、问题和答案)三元组。

VQA算法的一个被广泛探索的阶段是将提取的视觉特征和语言特征结合或匹配以生成答案。其中一个胜出的候选是编码器-解码器架构,它的模板包括cnn和rnn,以及注意力机制,自然地对VQA任务起作用。这些体系结构的限制之一是耗时的顺序编码步骤。Vaswani等人(2017)提出了一种不同寻常的解决方案,即编码器和解码器的堆叠层提供并行注意力的transformer。特别是在VQA_Med的时间关键领域(Hasan et al. 2018)和Viz-Wiz (Gurari et al. 2018)。

7.2 Datasets

VQA研究的另一个局限性是缺乏目标导向的数据集,例如。这个领域的大部分研究都是针对最早的基准数据集DAQUAR和VQA。这些模型不能扩展到VQA的实际应用,例如,支持视障人士,帮助数据分析师从数据池中提取相关信息,指导孩子在触摸屏上玩游戏,以及与机器人互动。为了使VQA研究达到其目标,它需要更多的面向应用程序的公开数据集。到目前为止,面向目标的VQA研究只有两个公开可用的数据集,VizWiz和VQA- med。在VQA文献中,只有一篇论文讨论了这个问题VizWiz数据集(Gurari et al. 2018)的最佳精度为(低于)50%,并根据Hasan等人(2018)只有5个团队使用最佳BLEU对VQA-Med数据集进行了处理(参见第6部分:0.162分。在未来的工作中,我们计划为感兴趣的研究人员建立一个基准的VQAMed数据集,这将通过帮助医生的决策来改善整个公共卫生。

7.3 Evaluation

开放式VQA设置的评价方法在未来的研究中需要进一步探索。作为一个起点,两个最新的VQA挑战的结果,VizWiz和VQA- med已经确定了在VQA系统评价中使用自动机器翻译(MT)评价指标的可能性。他们只尝试了经典的MT参数,如BLEU和METEOR。(更多细节见第6节)。尽管BLEU是MT最常用的度量标准,但报告显示它在短句子方面不适用。在VQA系统中,大多数答案都是简短的。这个属性建议使用NEVA (Ngram评估)(Forsbom 2003)。《NEVA》和《BLEU》在各方面都很相似,只是改编为短句。

7.4 Others

本部分探讨了本研究的两个独特之处,对进一步研究VQA具有指导意义。研究人员的一个途径是探索需要外部知识来回答的视觉问题的解决方案。在这个领域有三个值得注意的作品,它们的结果是可以接受的,但是有一些局限性。第一个(Wang et al. 2015)命名“Ahab”主要受到自然语言问题所映射到的可用问题模板(只有23个)的限制。在此限制下,他们获得了69.6%的总体精度。他们指出了VQA系统建模的主要缺陷之一由于LSTM在很多情况下无法进行显式推理。Wu等人(2016)做了第二项值得一提的工作,他们在编码器的解码器部分将图像特征与从外部源提取的知识相结合(CNN)解码器(LSTM)网络。在COCO-QA数据集上得到的结果最好,准确率为73.66%。其局限性在于,它们只基于可视内容生成所有知识库查询,而忽略了问题内容。Wang等人(2018)提出的第三项也是最新的研究开发了一个新的数据集FVQA和一个VQA算法,该算法将通过从知识库中为每个问题寻找支持事实来工作。因此,这一研究路径需要一种新的模型,这种模型应该是开放的,可以提出任何类型的问题,并且能够很好地进行明确的推理。

另一个平行且可能的研究思路来自于VQA任务中是/否问题的力量。二元问题的优点包括:(1)它们很容易评估(2)它们可以代表广泛的任务。张等人(2016)利用VQA-Abstract数据集。尽管存在反对是/否问题的争论,当人类注释者在自然图像上提出问题时,他们倾向于“是”回答,但医学VQA可以探索它的力量。

VQA系统的另一个重要分支可以通过在预测答案中加入情绪形容词(Ruwa et al. 2018)的想法来激活。这可以直接扩展Viz-Wiz挑战,即针对视障人士使用手机拍摄的照片提出问题。带有情感形容词的回答无疑会给这样一个社区带来额外的好处,帮助他们消除无障碍障碍。在现实世界中,人们在任何时候都倾向于有部分或复杂的情绪,这使得“模糊系统”成为情绪检测网络的一个很好的候选。最近,Chaturvedi等人(2019)在情感分析中尝试了这种方法,因此,将模糊情绪检测器与VQA网络相结合,必将开创一个充满希望的情感问答系统时代。

8 Conclusion

视觉问答是计算机视觉和自然语言处理的有趣结合,它正在利用深度学习方法的力量发展。这是一项非常具有挑战性的任务,需要解决许多子任务,如目标检测、活动识别、目标间的空间关系、常识推理等。VQA,现在被认为是人工智能完成的任务,将是迈向AI梦想视觉对话。

本文批判性地检查了现有的解决方案,数据集和评估方法,并以用户友好的方式提出了所有类似的方法的比较,这将帮助整个范围的VQA研究人员,从初学者到专家。当前实践的局限性和本文揭示的有希望的研究方向,将使VQA及其后代——视频问答和视觉对话——取得巨大成功。

VQA模型走向AI梦想的主要障碍是,不清楚改进的来源是什么,以及模型在多大程度上理解了视觉语言概念。在未来的VQA研究中,研究者应注重建立高效、丰富、无偏和面向目标的数据集来测试的重要特征VQA。VQA算法需要利用卷积的能力进行改进

神经网络提取更多的自然图像特征,利用最新的词嵌入模型提供有意义的多模态融合,联合注意机制在这方面证明了其能力。

翻译不当之处希望指教!

5718

5718

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?