本文先描述如何用广义线性模型GLM推导出softmax regression,之后描述多项分类的一个特例logistic regression。

Softmax regression

一般分类问题中会将样本分为k类,这类问题可以叫做softmax regression,所以我们可以假设k个参数

ϕ1,⋅⋅⋅,ϕk

代表每种分类的概率,实际中我们只需要假设k-1个参数,因为

ϕk=1−∑k−1i=1ϕi

.

在指数分布族中,我们之前定义T(y)=y,现在我们定义T(y)等于一个k-1维的向量,y可取1到k的正整数。映射关系如下:

令 (T(y))i 为 T(y) 的第i个元素。所以 (T(y))i 可以用指示函数来表示为

那么

首先来再次看看此时指数分布族的三条假设:

(1)

y|x;θ∼ExponentialFamily(η)

(2)给定

x

,我们要预测的是

(3)

η=θTx

然后我们开始推导

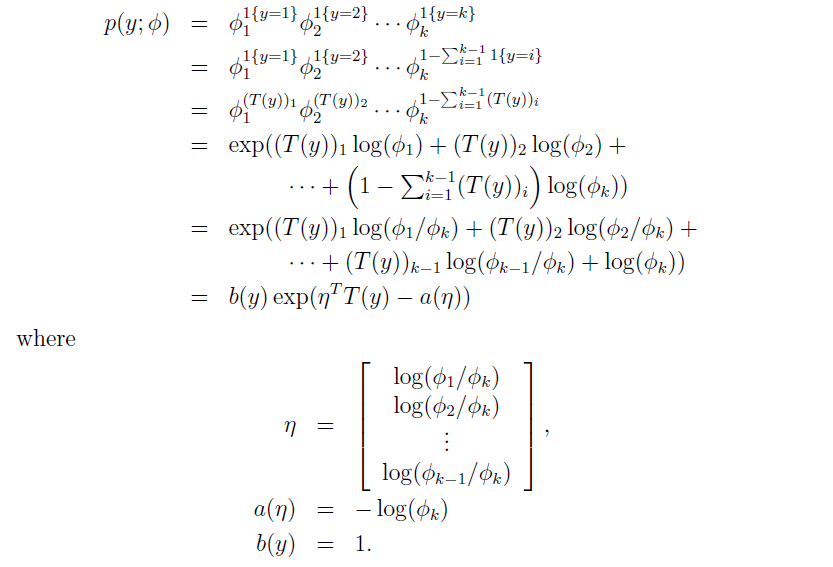

1.将多项分布变化为指数分布族:

所以连接函数(link function)是

此时我们可以用 ϕi=eηi∑ki=1eηi 来表示多项分布的概率模型,即

根据假设三,我们的响应函数h(x)为

2.用MLE极大似然估计来计算 θ ,

所以Softmax regression的cost function为

然后用BGD就可以得到 θ 。

最终预测数据:输入X得到 hθ(x) 的向量值,最大的数所在的维数即Y所属的种类(如果 ϕk=1−∑k−1i=1ϕi 最大,那Y属于第K类)

Logistic regression

有了softmax regression的推导,Logistic regression就很简单了,LR其实就是一个伯努利分布而已。

因为只有0和1两类,所以我们还是让

T(y)=y

,假设

p(1)=ϕ

,则

p(0)=1−ϕ

1、将伯努利分布转化为指数分布

Bernoulli Distribution for Logistic Regression:

to Exponential Family:

so, response function is

then,

2.用MLE来估计

θ

so, the Cost Function for logistic regression is

the gradient of J(θ) is

Actually, you will find that the j(θ) and ∇θjJ(θ) for Logistic regression is a simplified version of that for Softmax regression.

In the end, if we apply bayesian method to logistic regression, we will get a regularized term, which is similar as bayesian linear regression.

Softmax 回归 vs. k 个二元分类器

如果你在开发一个音乐分类的应用,需要对k种类型的音乐进行识别,那么是选择使用 softmax 分类器呢,还是使用 logistic 回归算法建立 k 个独立的二元分类器呢?

这一选择取决于你的类别之间是否互斥,例如,如果你有四个类别的音乐,分别为:古典音乐、乡村音乐、摇滚乐和爵士乐,那么你可以假设每个训练样本只会被打上一个标签(即:一首歌只能属于这四种音乐类型的其中一种),此时你应该使用类别数 k = 4 的softmax回归。(如果在你的数据集中,有的歌曲不属于以上四类的其中任何一类,那么你可以添加一个“其他类”,并将类别数 k 设为5。)

如果你的四个类别如下:人声音乐、舞曲、影视原声、流行歌曲,那么这些类别之间并不是互斥的。例如:一首歌曲可以来源于影视原声,同时也包含人声 。这种情况下,使用4个二分类的 logistic 回归分类器更为合适。这样,对于每个新的音乐作品 ,我们的算法可以分别判断它是否属于各个类别。

现在我们来看一个计算视觉领域的例子,你的任务是将图像分到三个不同类别中。(i) 假设这三个类别分别是:室内场景、户外城区场景、户外荒野场景。你会使用sofmax回归还是 3个logistic 回归分类器呢? (ii) 现在假设这三个类别分别是室内场景、黑白图片、包含人物的图片,你又会选择 softmax 回归还是多个 logistic 回归分类器呢?

在第一个例子中,三个类别是互斥的,因此更适于选择softmax回归分类器 。而在第二个例子中,建立三个独立的 logistic回归分类器更加合适。

参考资料:

【1】cs229 by Andrew Ng from 网易公开课.

【2】UFLDL.

2423

2423

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?