一、所有“失控”的多智能体,第一天就已经写错了

我见过太多人是这样做多智能体系统的:

一个 Planner

一个 Executor

一个 Reviewer

一个 Summarizer

然后让他们开始“自由交流”。看起来像一个团队,实际上更像一个精神病院。我们这代做了二十年工程的人,一眼就能看出来问题在哪:边界不存在,权力不清晰,责任不可追溯。多智能体从来不是“协作系统”,它本质上是一个:高速运行的博弈系统 + 异步失控风险放大器。绝大多数“发疯”的智能体系统,不是模型的问题,是一开始从架构层就错了。

二、我踩过最深的坑:让智能体拥有“自由意志”

早期我干过最蠢的一件事是:为了追求“智能感”,我刻意减少约束,比如:

-

不限制输出长度

-

不限制工具调用次数

-

不设计重入锁

-

不设计终止条件

结果智能体不断“自我强化错误判断”,形成逻辑闭环。就像一个人在房间里对着回声讲话,越听越笃定。那一刻我意识到一个残酷事实:不受约束的智能体,不是聪明,是危险。

三、真正稳定的多智能体系统,靠的不是“协作”,而是“博弈约束”

后来我彻底改变了设计方式。我不再相信“合作”,我开始引入“冲突机制”。

✅ 所有智能体的结论必须接受反向质疑

✅ Planner 不允许直接下结论

✅ Executor 必须暴露执行中间态

✅ Reviewer 有一票否决权

我强制它们进入“互相牵制”的状态,而不是互相认同。这套结构带来的变化非常明显:

-

幻觉显著减少

-

逻辑错误下降

-

输出质量更稳定

不是因为它们变聪明了,是因为它们被系统性地限制住了。

四、记忆系统是最大的隐性炸弹

很多人不知道:失控的真正引爆点,往往不在推理层,而在“记忆层”。

我早期给智能体接了一个向量数据库做长期记忆。本意是让它“越来越懂业务”,结果是:

-

错误经验被反复强化

-

旧逻辑支配新任务

-

模型开始“固执”

后来我总结了一条血的教训:智能体的记忆,默认应该是不可信的。我增加了三层机制:

-

时间衰减权重

-

任务相关性过滤

-

记忆可信度评分

这样,多智能体系统才不会“被自己过去拖死”。

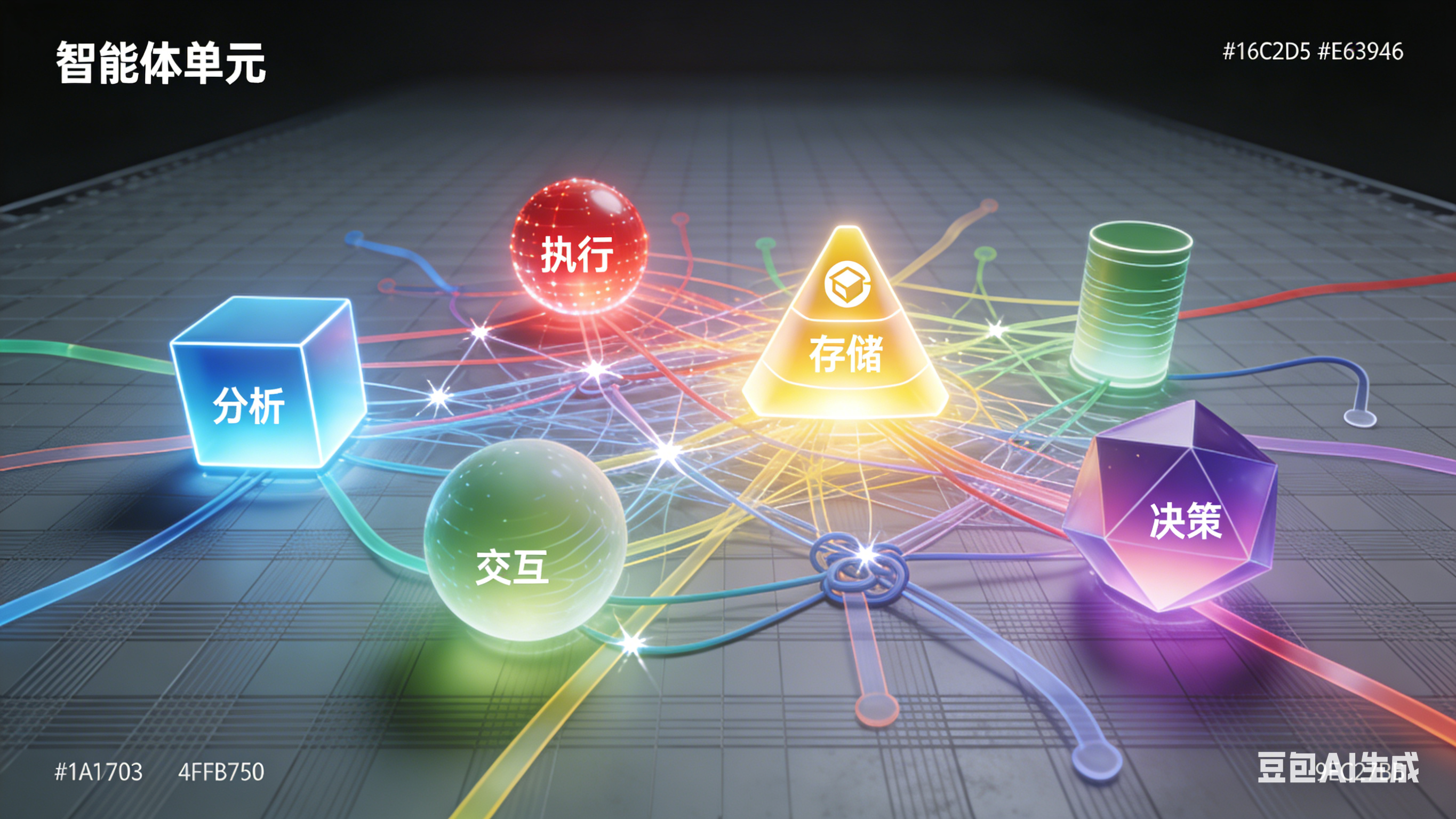

五、核心架构原则

经历了太多深刻的教训后,我现在设计多智能体系统,遵循 5 个基本原则:

-

任何智能体都不能拥有完全闭环权限

-

所有决策必须有外部可追溯日志

-

执行权和评价权必须分离

-

必须存在“终止优先级”机制

-

系统宁可失败,也不能无限自转

这 5 条,其实都是以前大型软件系统几十年的老经验,换到了 AI 时代依旧成立。

六、多智能体不该像“人”,而应该像“流程引擎”

早期我也陷入过一个误区:想把智能体设计得越来越像“真人团队”。后来发现,这是一个很危险的方向。因为人类团队有很多缓冲机制:

-

情绪

-

误解

-

妥协

-

直觉

但智能体没有。所以我现在的设计理念只有一句话:高级智能体 不等于 拟人化系统 高级智能体 是一个 结构化流程机器。你越把它当人,它就越容易疯。相反你把它当引擎,它反而越稳定。

七、智能体开发者的忠告

如果你想做多智能体系统,我给你一个真诚但冷血的建议:千万别从多智能体开始。先从基础开始,单 Agent 的生命周期;错误恢复链路;状态持久化;执行边界;这些搞明白后,你才有资格玩“多个 Agent”。

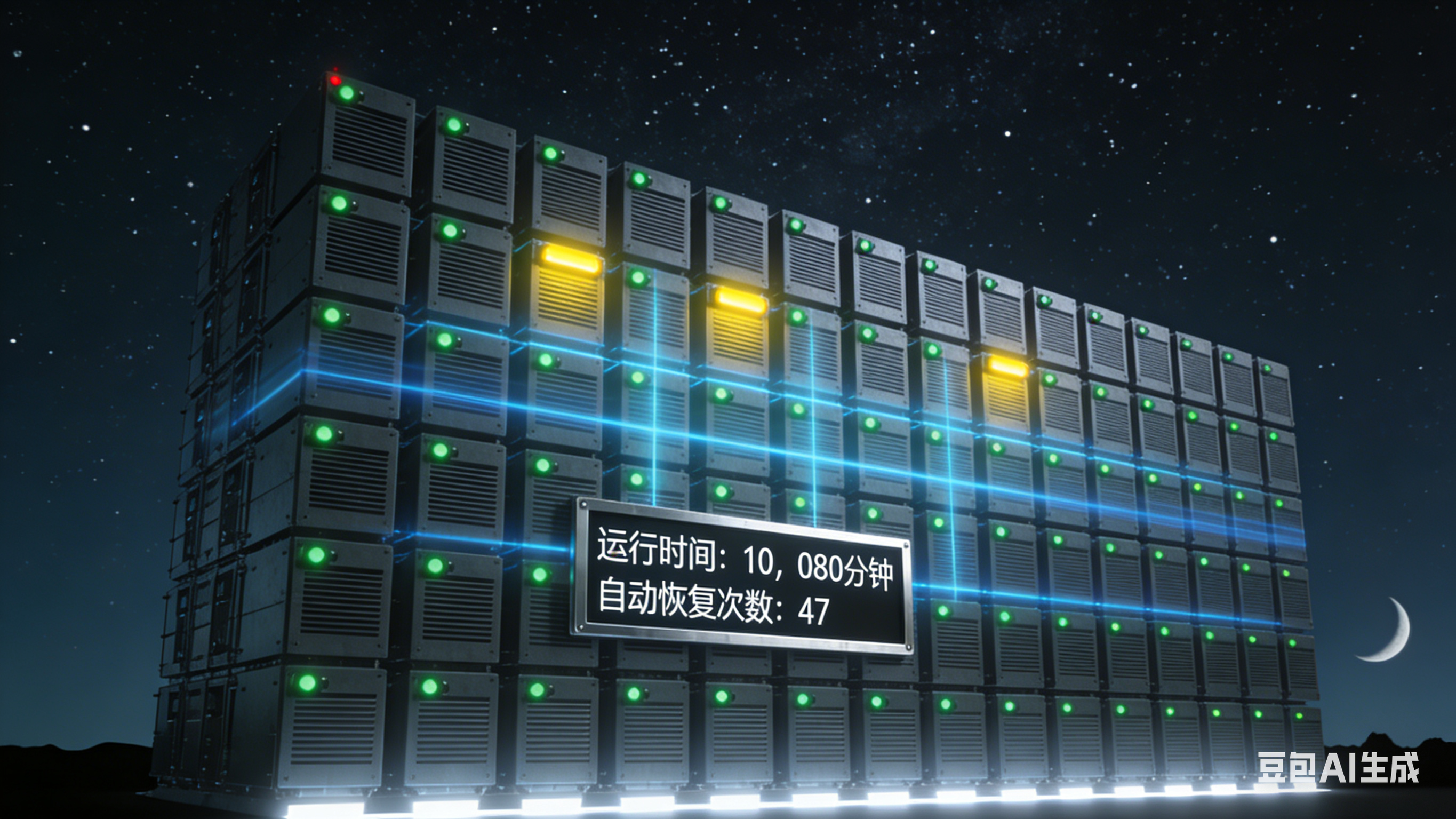

我第一次看到一个完美的多智能体系统:在无人干预下稳定运行 3 小时,执行 20+ 个真实任务,自动纠错、自动降级、自动恢复。我没有兴奋,只有一种感觉:这玩意儿,终于像“工程系统”了,而不是大型魔法表演。而我的目标从那一天开始转变:不再追求“聪明的智能体”,我只想打造一个:永远不发疯的系统。

835

835

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?