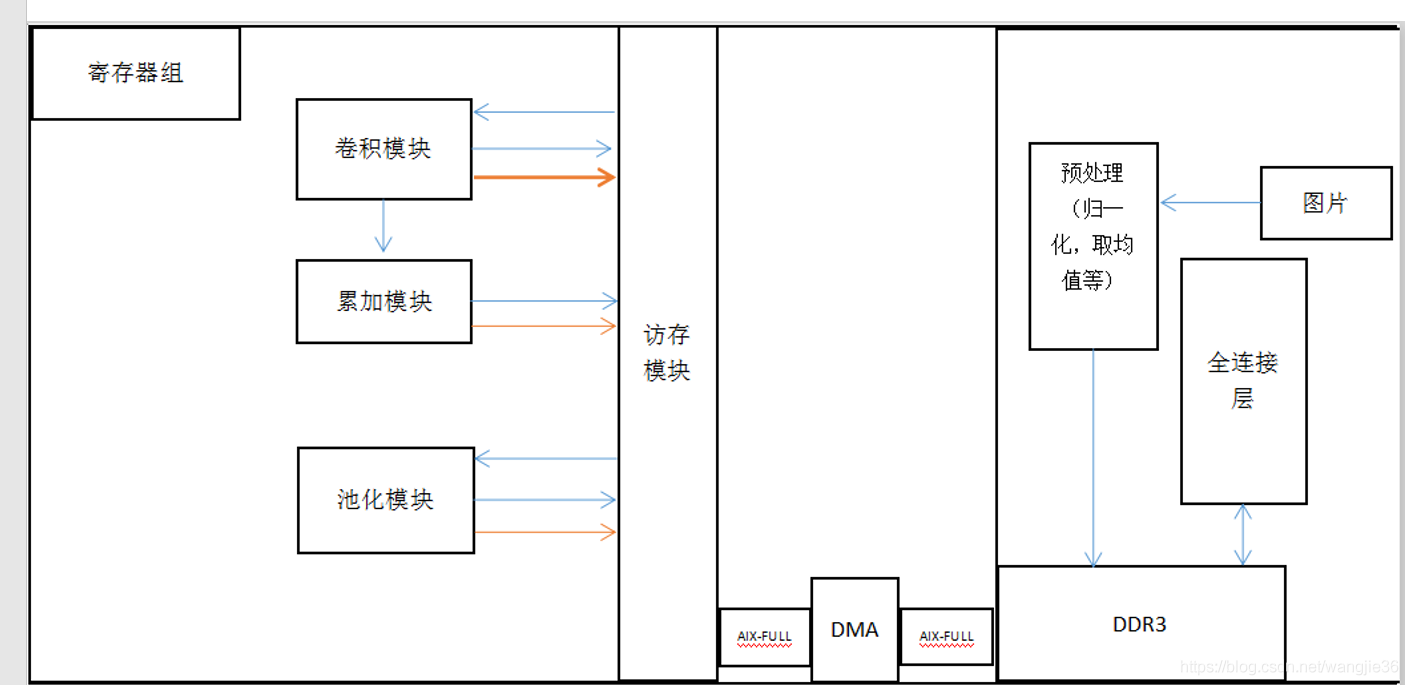

卷积神经网络(Convolutional Neural Layer, CNN),除了全连接层以外(有时候也不含全连接层,因为出现了Global average pooling),还包含了卷积层和池化层。卷积层用来提取特征,而池化层可以减少参数数量。

例子简介:经过一层卷积以后,输入的图像尺寸变化不大,只是缩小了卷积核-1。根据相邻数据的相关性,在每个nxn区域内,一般2x2,用一个数代表原来的4个数,这样能把数据缩小4倍,同时又不会损失太多信息。一副24*24的图像。用5*5卷积核卷积,结果是20*20(四周各-2),经过2*2池化,变成10*10。

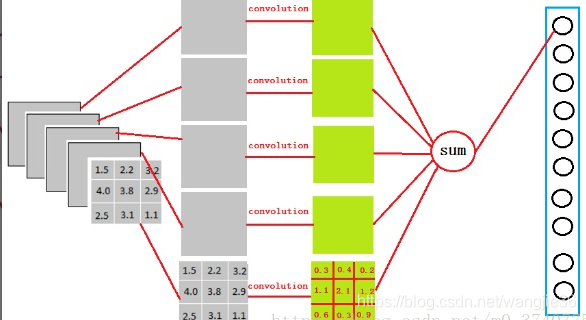

卷积层(Convolution):

卷积层取的是局部特征,全连接就是把以前的局部特征重新通过权值矩阵组装成完整的图。

通过卷积操作对输入图像进行降维和特征抽取卷积运算是线性操作,而神经网络要拟合的是非线性的函数,因此和前全连接网络类似,我们需要加上激活函数,常用的有 sigmoid 函数,tanh 函数,ReLU 函数等。神经网络前部卷积层有小的感受野,可以捕捉图像局部、细节信息,即输出图像的每个像素(Activation激活值)只是感受到输入图像很小范围数值进行计算的结果。

后面的卷积层感受野逐层加大,用于捕获图像更复杂,更抽象的信息。经过多个卷积层的运算,最后得到图像在各个 不同尺度的抽象表示。无论输入图片多大,卷积层的参数规模都是固定的。

经过卷积得到3x3x5的输出,转换成1x4096的形式。因为我们有4096个神经元。我们实际就是用一个3x3x5x4096的卷积层去卷积激活函数的输出。

池化层(Pooling):

pooling理论在于,图像中相邻位置的像素是相关的。对一幅图像每隔一行采样,得到的结果依然能看。完成了对输入图像的降维和特征抽取,但特征图像的维数还是很高。维数高不仅计算耗时,而且容易导致过拟合。池化的做法是对图像的某一个区域用一个值代替,如最大值或平均值。如果采用最大值,叫做 max 池化;如果采用均值,叫做均值池化。除了降低图像尺寸之外,下采样带来的另外一个好处是平移、旋转不变性,因为输出值由图像的一片区域计算得到,对于平移和旋转并不敏感。池化层的具体实现是在进行卷积操作之后对得到的特征图像进行分块,图像被划分成的不相交块,计算这些块内的最大值或平均值,得到池化后的图像。均值池化和 max 池化都可以完成下采样操作,前者是线性函数,而后者是非线性函数,一般情况下 max 池化有更好的效果。池化层作用:(1)降维,缩减模型大小,提高计算速度(2)降低过拟合概率,提升特征提取鲁棒性(3)对平移和旋转不敏感

全连接层(Fully connected):

在整个卷积神经网络中起到“分类器”的作用。如果说卷积层、池化层和激活函数层等操作是将原始数据映射到隐层特征空间的话,全连接层则起到将学到的“分布式特征表示”映射到样本标记空间的作用。在实际使用中,全连接层可由卷积操作实现:对前层是全连接的全连接层可以转化为卷积核为1x1的卷积;而前层是卷积层的全连接层可以转化为卷积核为hxw的全局卷积,h和w分别为前层卷积结果的高和宽。全连接就是个矩阵乘法,相当于一个特征空间变换,可以把前面所有有用的信息提取整合。再加上激活函数的非线性映射,多层全连接层理论上可以模拟任何非线性变换。但缺点也很明显: 无法保持空间结构。

举例:

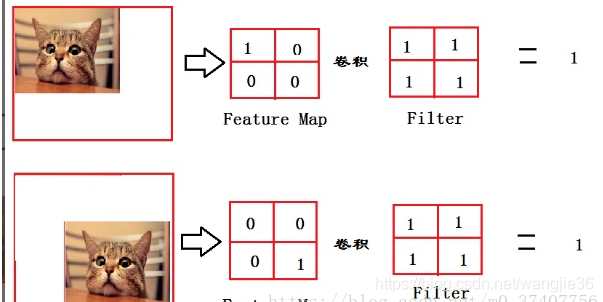

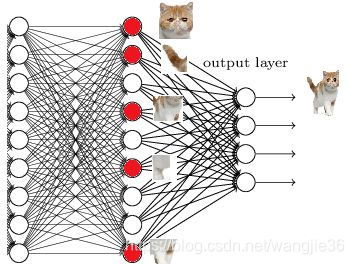

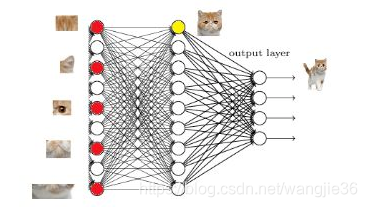

从上图我们可以看出,猫在不同的位置,输出的feature值相同,但是位置不同。对于电脑来说,特征值相同,但是特征值位置不同,那分类结果也可能不一样。这时全连接层filter的作用就相当于

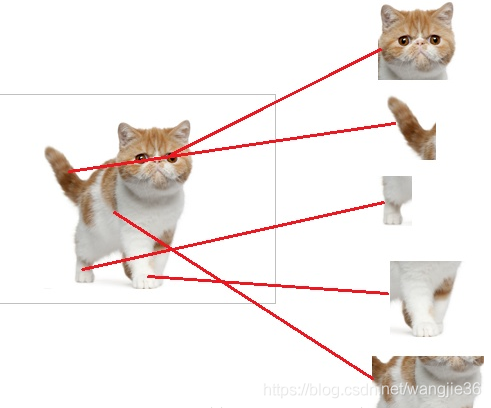

我让filter去把这个猫找到,实际就是把feature map 整合成一个值,有猫这个值就大,没猫这个值小,那就可能没猫和这个猫在哪关系不大了,因为空间结构特性被忽略了,所以全连接层不适合用于在方位上找Pattern的任务。全连接层中一层的一个神经元就可以看成一个多项式,用许多神经元去拟合数据分。fully connected layer 有时候没法解决非线性问题,如果有两层或以上fully connected layer就可以很好地解决非线性问题了。通过得到以下特征,我就可以判断物体是猫了

红色的神经元表示这个特征被找到了,同一层的其他神经元,要么猫的特征不明显,要么没找到。如果我们把这些找到的特征组合在一起,发现最符合要求的是猫。当我们找到这些特征,神经元就被激活了(下图红色圆圈)。这些细节特征就是从前面的卷积层,下采样层来的,全连接层参数特多(可占整个网络参数80%左右)。全连接层对模型影响参数就是三个:(1)全接解层的总层数(长度);(2)单个全连接层的神经元数(宽度);(3)激活函数;

25万+

25万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?