#############【持续更新】##############

LLM-RAG相关常见面试题

1. RAG技术体系的总体思路

2. 使用外挂知识库主要为了解决什么问题

3. 大模型的幻觉问题、复读机问题是什么

4. 针对问题3,有没有什么解决办法

5. 出现问题3的原因有哪些

#############【持续更新】##############

LLM-RAG相关常见面试题

1. RAG技术体系的总体思路

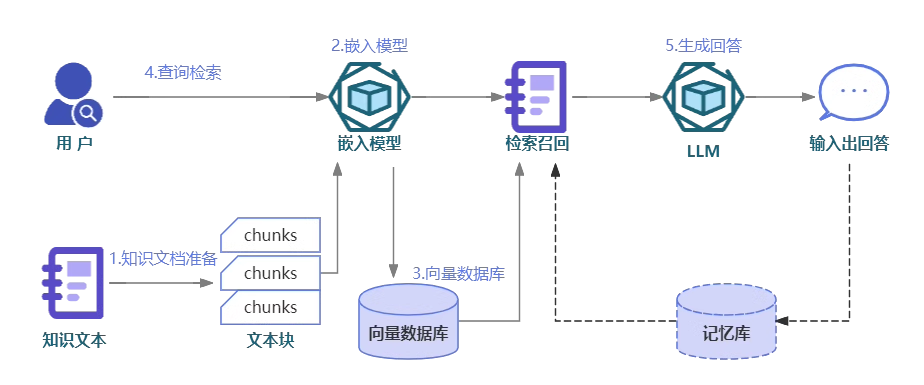

- RAG可分为5个基本流程:知识文档的准备;嵌入模型(embedding model);向量数据库;查询检索和生产回答。

参考:https://aibook.ren/archives/what-is-rag

2. 使用外挂知识库主要为了解决什么问题

- 克服遗忘问题

- 提升回答的准确性、权威性、时效性

- 解决通用模型针对一些小众领域没有涉猎的问题

- 提高可控性和可解释性,提高模型的可信度和安全性

3. 大模型的幻觉问题、复读机问题是什么

-

幻觉问题:即生成的内容是无意义的或不忠实于提供的源内容

-

复读机问题:重复生成某些话

4. 针对问题3,有没有什么解决办法

-

针对幻觉问题:

- 引入外挂知识库,加入一些纠偏规则,限制输出长度等

-

针对复读机问题:

-

丰富数据集的多样性,预处理时尽量过滤重复无意义的文本

-

同义词替换等做数据增强

-

温度参数调整

-

后处理与过滤

-

5. 出现问题3的原因有哪些

-

针对幻觉问题:

-

幻觉问题主要分为两大类,一类是生成结果与数据源不一致,自相矛盾。另一类是用户问题超出了大模型的认知。

-

针对前者可能是训练数据和源数据不一致、数据没对齐或者编码器理解能力的缺陷和解码器策略错误可能导致幻觉。后者则是用户的问题不在语言模型认知范围内。

-

-

针对复读机问题:

- 数据质量不高,存在大量单一、重复文本,文本过长(补充:当你的前面的条件文本过长时,大模型的输出的几个短文本会被原始的很长的条件文本淹没,继续预测下一个token的话,在模型看起来可能条件仍然是差不多的,此时如果使用greedy search,只选择概率最大的一个token,模型极大可能会将前面已经生成的短文本重新预测成概率最大的文本,以此类推,会一直重复下去。)

1556

1556

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?