深度学习网络搭建常用激活函数的详细介绍,新学一个记录一个。

目录

-

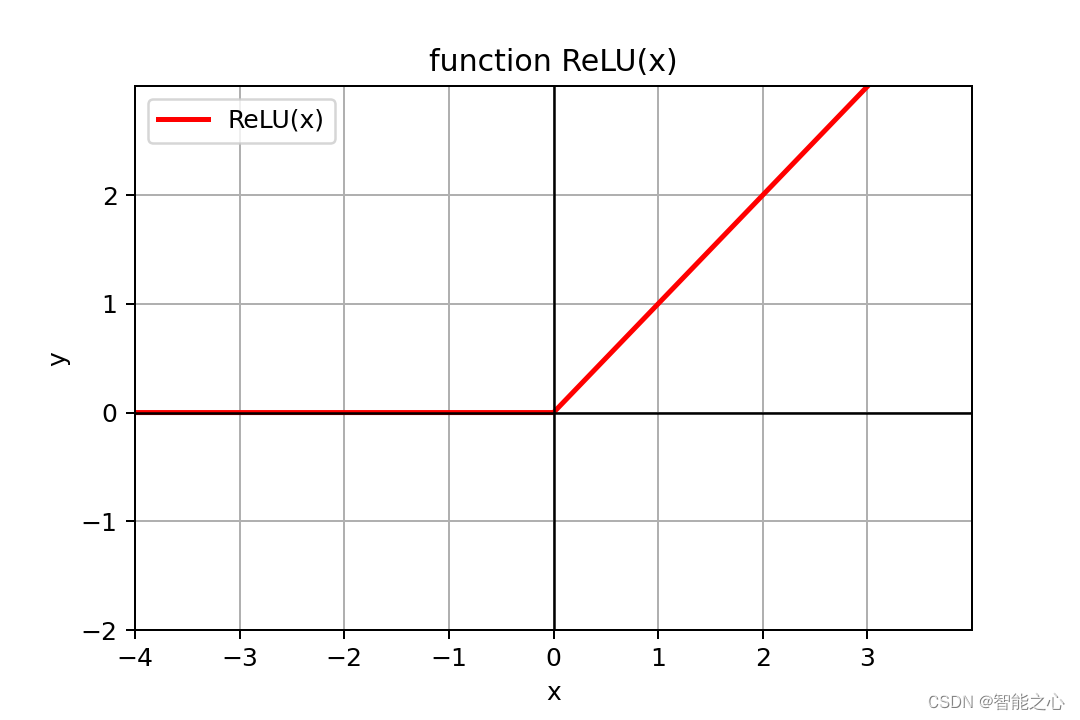

激活函数 Relu

# ReLU(x) 函数实现

import math

import numpy as np

import matplotlib.pyplot as plt

x = np.arange(-10, 10, 0.1)

alpha = 1 # 控制着ELU负值部分在何时饱和

ReLU = np.maximum(0, x)

plt.title("function ReLU(x)")

plt.grid()

plt.xlabel('x')

plt.ylabel('y')

plt.xlim([-4, 4])

plt.ylim([-2, 3])

plt.xticks(np.arange(-4, 4, 1))

plt.yticks(np.arange(-2, 3, 1))

plt.plot(x, ReLU, "r-", linewidth=2)

plt.legend(['ReLU(x)'])

plt.plot(x, np.zeros(len(x)), "black", linewidth=1)

plt.plot(np.zeros(len(x)), x, "black", linewidth=1)

plt.savefig('ReLU.png', dpi=180)

-

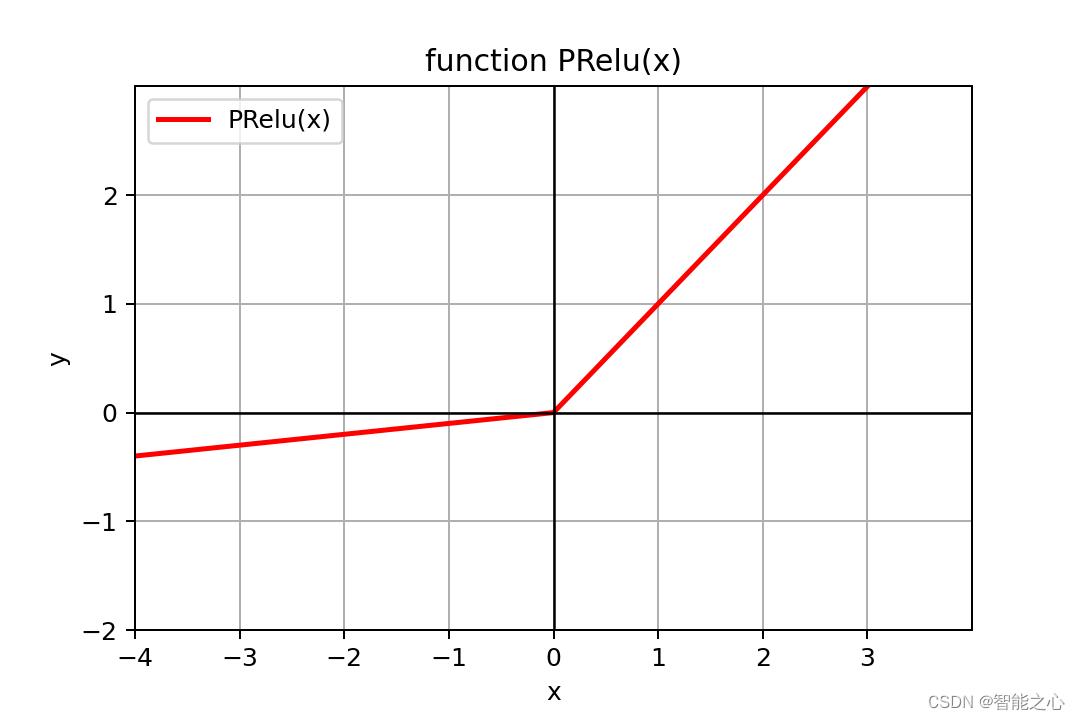

激活函数 PRelu

# PRelu(x) 函数实现

import math

import numpy as np

import matplotlib.pyplot as plt

x = np.arange(-10, 10, 0.1)

weight = 0.1 # 控制着weight负值部分不为 0

PRelu = np.maximum(0, x) + weight * np.minimum(x, 0)

plt.title("function PRelu(x)")

plt.grid()

plt.xlabel('x')

plt.ylabel('y')

plt.xlim([-4, 4])

plt.ylim([-2, 3])

plt.xticks(np.arange(-4, 4, 1))

plt.yticks(np.arange(-2, 3, 1))

plt.plot(x, PRelu, "r-", linewidth=2)

plt.legend(['PRelu(x)'])

plt.plot(x, np.zeros(len(x)), "black", linewidth=1)

plt.plot(np.zeros(len(x)), x, "black", linewidth=1)

plt.savefig('PRelu.png', dpi=180)

-

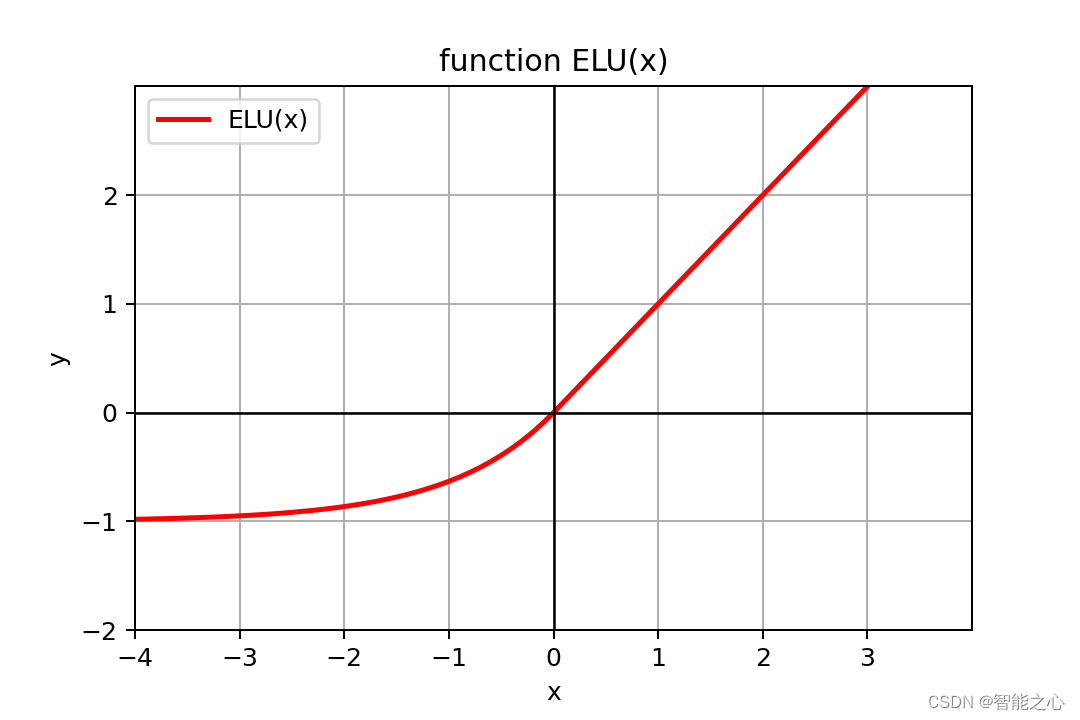

激活函数 ELU

# ELU(x) 函数实现

import math

import numpy as np

import matplotlib.pyplot as plt

x = np.arange(-10, 10, 0.1)

alpha = 1 # 控制着ELU负值部分在何时饱和

elu = np.maximum(0, x) + np.minimum(0, alpha * (np.exp(x) - 1))

plt.title("function ELU(x)")

plt.grid()

plt.xlabel('x')

plt.ylabel('y')

plt.xlim([-4, 4])

plt.ylim([-2, 3])

plt.xticks(np.arange(-4, 4, 1))

plt.yticks(np.arange(-2, 3, 1))

plt.plot(x, elu, "r-", linewidth=2)

plt.legend(['ELU(x)'])

plt.plot(x, np.zeros(len(x)), "black", linewidth=1)

plt.plot(np.zeros(len(x)), x, "black", linewidth=1)

plt.savefig('ELU.png', dpi=180)

-

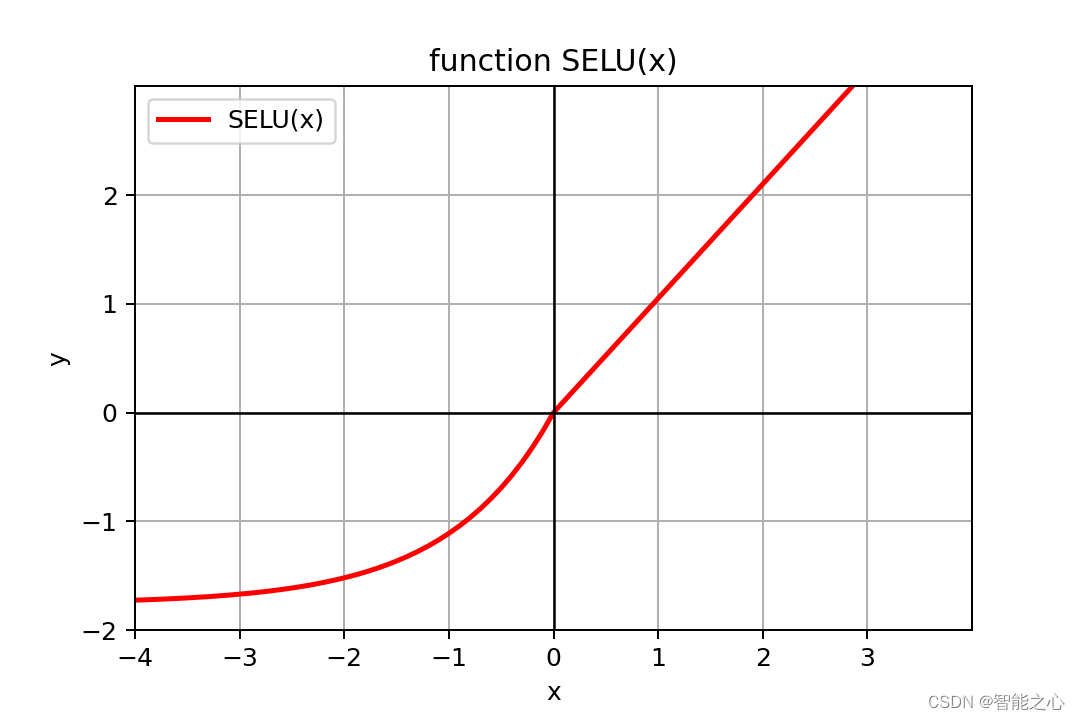

激活函数 SELU

# SELU(x) 函数实现 - 可以不用加入BN层

import math

import numpy as np

import matplotlib.pyplot as plt

x = np.arange(-10, 10, 0.1)

alpha = 1.6732632423543772848170429916717

scale = 1.0507009873554804934193349852946

SELU = scale * (np.maximum(0, x) + np.minimum(0, alpha*(np.exp(x)-1)))

plt.title("function SELU(x)")

plt.grid()

plt.xlabel('x')

plt.ylabel('y')

plt.xlim([-4, 4])

plt.ylim([-2, 3])

plt.xticks(np.arange(-4, 4, 1))

plt.yticks(np.arange(-2, 3, 1))

plt.plot(x, SELU, "r-", linewidth=2)

plt.legend(['SELU(x)'])

plt.plot(x, np.zeros(len(x)), "black", linewidth=1)

plt.plot(np.zeros(len(x)), x, "black", linewidth=1)

plt.savefig('SELU.png', dpi=180)

-

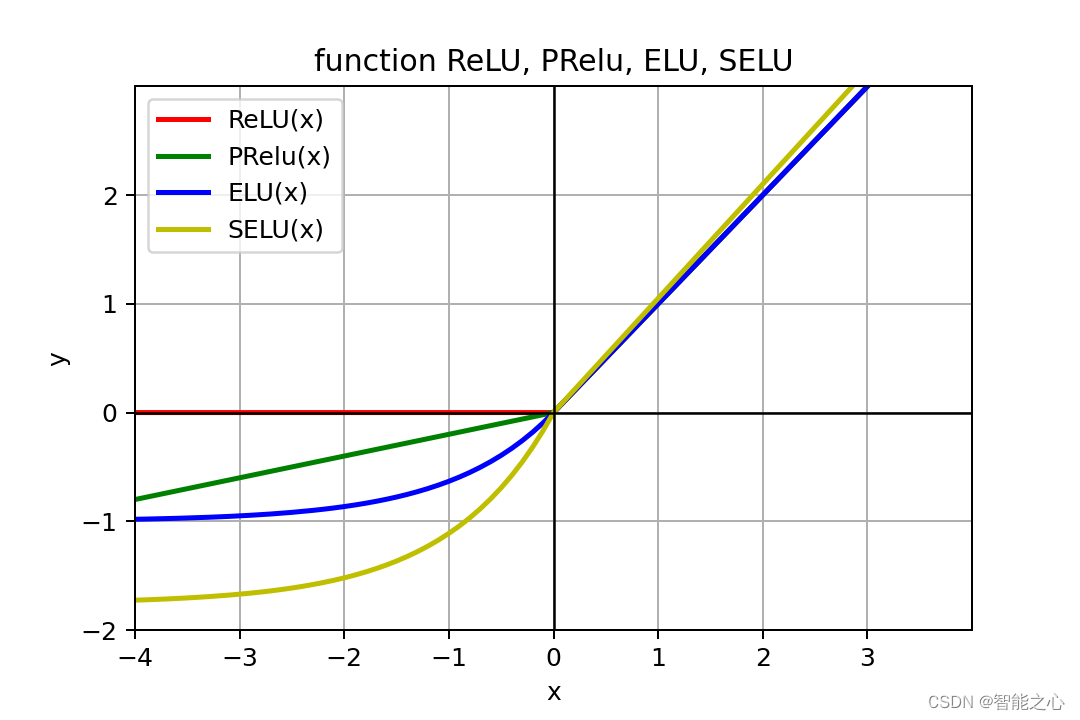

激活函数对照

-

参考链接

2167

2167

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?