本文提出的模型为att-RNN,是在RNN基础上加入注意力机制,进行多模态谣言检测。

作者:中国科学院智能信息处理重点实验室,曹娟团队

1 介绍

与文本相比,图像更能描绘视觉内容,因而更能引起人们的注意。凭借丰富的视觉信息,它们也有助于区分谣言。现有的谣言自动检测方法大多是基于文本和社会语境的。基于分类的方法[7,16,31]和基于图的优化方法[10,13,14]被用于基于人工制作的文本和社会上下文特征来验证在线文本帖子的真假。最近只有少数研究首次尝试基于多媒体内容来检测谣言[9,15,16]。这些作品中使用的视觉特征也是手工制作的,这些特征基本上通过特征拼接(早期融合)或平均结果(晚期融合)与现有特征融合。一方面,现有作品中手工制作的特征仅限于学习复杂且可扩展的文本或视觉特征。另一方面,现有的融合方法非常初级,可能无法有效地结合不同模式的好处。

考虑到这些限制和我们利用多模态内容的动机,我们提出了一个带有注意机制的端到端RNN,将文本、图像和社会背景的特征融合到谣言检测任务中。深度神经网络被证明在学习准确的文本或视觉表示方面是有效的[26,29]。在提出的模型中(图2),本文使用RNN来学习文本和社会上下文的联合表示。用预训练的深度CNN表示图像视觉特征,然后与它们融合。我们在模型中使用注意机制来捕捉视觉特征和联合文本/社会特征之间的关系。本文的贡献有三个方面:

- 融合社交网络上的多模态内容来解决具有挑战性的谣言检测问题。与传统的手工设计特征不同,文本、视觉和社会上下文内容通过深度神经网络表示。

- 提出了一种新颖的带有注意机制的RNN (att-RNN),用于有效的多模态特征融合。该网络融合了三种模式的特征,并利用注意力机制进行特征对齐。

- 为了验证我们的模型与竞争算法,我们分别在从微博和Twitter收集的两个多媒体数据集上评估了att-RNN。结果表明,与现有的基于特征的方法和最先进的神经网络模型相比,att-RNN在两个数据集上都取得了最好的性能。

2 相关工作

在社会心理学文献中,谣言被定义为真实值未经证实或故意虚假[1]的故事或陈述。现有研究大多采用基于特征的方法解决自动谣言检测问题。文献中针对谣言检测提出了各种各样的特征,大致可以归纳为三类:文本特征、社会上下文特征和图像特征。

文本特征包括统计文本特征和语义文本特征。统计文本特征捕获tweets中重要的统计数据,如单词计数、大写字符和标点符号[7]。语义文本特征表示文本的抽象语义,包括情 感分数[7]和意见词[19]。一些作品[10,13]利用词袋文本特征来揭示推文间的关系。在谣言检测任务中也采用基于主题模型的特征,如LDA来表示高级抽象语义[14,31]。为了克服这些手工制作的特征的局限性,Ma等人[21]探索了用深度神经网络在事件中表示tweet的可能性。他们使用RNN来学习tweet在时间序列中的表示。

微博的社会联系特性为微博的发布带来了丰富的社会语境。它们被广泛应用于社交媒体[31]上的谣言检测。设计了一些社会上下文特征来捕获微博上的交互行为,包括转发数和回复数。其他的社会上下文特征来自于社交媒体的特性,例如使用标签话题(#)、提及(@)和url。

一些文章也将基于社会上下文特征的方法归类于基于传播结构(空间结构)的方法

除了纯文本之外,最近只有少数研究旨在验证多媒体内容的可信度。Morris等[24]发布了一项调查结果,用户头像可以表明用户帖子的可信度。对于帖子中附加的图片,文献[10,31]提出了一些基本特征。为了自动预测分享多媒体内容的推文是假还是真,Boididou等人[5]提出了验证多媒体使用任务,该任务于2015年和2016年作为MediaEval基准的一部分进行。提取文本和图像取证特征作为本任务的基线特征[15]。Jin等人[16]在最新的研究中,基于帖子中图片的视觉外观和统计,提出了几种图像特征。结合文本特征,这些新的图像特征被证明是非常有效的。然而,这些特征仍然是手工制作的,文本和图像特征的融合非常简单,早期的特征拼接和后期的结果融合。

与传统的手工特征相比,深度神经网络已经被证明能够学习准确的图像和句子表征。具体来说,卷积神经网络(CNN)在图像表示方面已经显示出强大的能力[18,27],而递归神经网络(RNN)最近被广泛应用于句子表示[3,22]。受其成功的启发,最近的多模态表示学习在许多应用中使用神经网络来融合多模态特征,例如视觉问答[2]和图像字幕[17,30,32]。它显示了深度神经网络在多模态数据分析中弥合“语义鸿沟”的能力。由于任务设置的差异,与谣言检测任务相比,现有的多模态融合模型具有不同的输入特征集和优化假设。

3 模型

3.1 模型概览

模型框架:

- RNN子网络(图2中最上面的分支),它学习文本和社会上下文特征的联合表示;

- 产生可视化表示的可视化子网络(图2中的底部分支);

- 神经级注意力部分,利用RNN的输出对视觉特征进行对齐。该网络是一个端到端模型,用于检测以多模态内容为输入的谣言。

模型思路:

利用模型从这些模态中提取特征RT、RS和RV),并旨在学习一个可靠的特征表示RI,作为给定推文I的T、S和V的聚合。

基本过程:

本文将微博帖子用一个三元组表示:I = {T, S, V}

- 首先,使用RNN融合文本和社会上下文,生成两种模态的联合表示RTS。

- 对于视觉特征RV,通过深度CNN获取,然后在每个时间步利用RNN输出的注意力来进一步完善RV。

- 最后,RTS和经过注意力聚合的R'V串联起来作为最终的多模态表示RI,在此基础上使用二元分类器来区分推文实例的真假。

3.2 LSTM网络

该模型采用具有长短期记忆(Long Short-Term Memory, LSTM)单元的循环神经网络来学习文本和社会上下文的联合表示。为了在学习长距离时间依赖关系时处理消失或爆炸的梯度[4,25],LSTM通过在精心设计的记忆单元中存储长时间内的信息来扩展基本RNN。其中,LSTM中的读写存储单元c由一组sigmoid门控制:输入门i、输出门o和忘记门f。对于每个时间步长m, LSTM单元接收来自当前输入xm、前一个隐藏状态hm和前一个存储单元cm的输入。这些门更新如下。

与基础LSTM模型一样,其中W∗是对应门的权重矩阵,b∗是偏差项,它们从网络中学习。σ是sigmoid激活函数,

![]()

为双曲正切函数:

输入门i决定新存储器被添加到存储器单元的程度。遗忘门f决定了现有记忆被遗忘的程度。通过遗忘部分现有记忆并添加新记忆g来更新记忆单元c。

3.3 文本和社会语境的联合表示

文本内容是它包含的单词的顺序列表:T = {T1, T2,…, Tn} (n是文本中的单词数)。将文本中的每个单词Ti∈T表示为一个词嵌入向量。通过在给定数据集上对深度网络进行无监督预训练,得到每个词的嵌入向量。

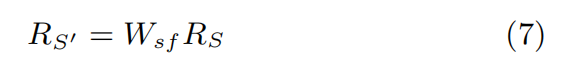

传统的多模态方法通常基于文本和视觉/音频特征。然而,对于微博谣言检测任务,文献[7,16,31]中广泛使用社会语境(上下文)特征进行有效的谣言检测。我们假设将社会背景纳入谣言检测模型会有一些好处。(实验中作者也进行了相应的消融实验)利用微博所产生的话题、提及、转发等上下文以及情感极性等文本语义特征形成初始社会上下文表示RS = [s1, s2,...sk]T。k是社会上下文特征的维度,si是第i维的标量值。通过全连接层(图3中的“soc-fc”)将社会上下文特征RS转换为与词嵌入向量维度相同的表示RS’,如下所示。

Wsf是用于维度转换的全连接层(soc-fc)的权重

在每个时间步,LSTM取RTiS = [RTi;RS']作为输入,它是第i个词嵌入RTi和转换后的社会上下文特征RS'的连接。对每个单词的LSTM输出神经元进行平均,形成文本和社会上下文RT s的联合表示,整个过程如图3所示。

3.4 图像的视觉表示

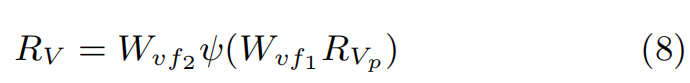

视觉子网络(图2中的底部分支)将推文图像作为输入,并生成视觉神经元作为图像的特征。其前层与VGG-19网络[27]具有相同的结构。我们在VGG-19网络的第二层到最后一层的顶部添加两个512个神经元的全连接层(图2中的“vis-fc1”和“vis-fc2”),以生成一个512个神经元的视觉表示RV = [v1, v2,…, v512] T。对整个att-RNN网络进行联合训练,使学习到的视觉神经元确定用于谣言检测的特定模式。视觉子网络可以首先用辅助数据集进行微调。然而,在与LSTM子网络的联合训练过程中,只更新最后两个全连接层的参数,以提高训练效率。

其中RVp是通过预训练的VGG网络获得的视觉特征,Wvf1是通过ReLU激活的第一个全连接层的权重,Wvf2是通过softmax函数的第二个全连接层的权重,ψ表示ReLU激活函数。

在这个过程中,视觉神经元不受限制地在网络中学习特定的概念。希望在给定标注为谣言或非谣言的训练数据的情况下,通过联合训练整个网络来捕获谣言检测所需的语义概念

在模型中直接使用视觉和联合社会-文本表示的一个巨大挑战是,其中一种表示可能会压倒另一种表示,这导致性能偏向于某种模态。为了最大化多模态特征的优势,我们应该联合学习不同模态的对齐。接下来,我们引入注意力机制,根据RNN在每个时间步长的输出调整视觉表示,同时产生聚合的视觉神经元。

3.5 视觉表示的注意力机制

我们假设在谣言推文中,图像与文本/社会背景有一定的相关性。为了刻画这些关系,本文在联合表示文本和社会上下文的神经元引导下,提出了一种视觉特征的神经元级别注意力机制。在最近的语言视觉任务中,注意力机制已成功应用于匹配文本和视觉语义概念[20,32]。在谣言检测的设置下,我们假设文本内容中的单词可能与图像中的某些语义概念相关联。我们的目标就是自动找到这种联系。特别地,应该赋予与单词具有相似语义的视觉神经元更多的权重。

我们提出的视觉神经元注意力机制对不同神经元对不同单词的贡献度进行加权。为了实现这一目标,我们将LSTM在每个时间步的输出隐状态hm作为指导。hm被连接到一个非线性ReLU函数的全连接层和一个softmax函数的全连接层,得到与视觉神经元RV具有相同维数的注意力向量Am∈R512。

Waf2,Waf1是两个全连接层的权重,ψ是ReLU激活函数

文本中第m个单词与图像的相关性可以用下面的公式计算:

其中Am(i)为第i个视觉神经元的注意值。

遵循这种注意力机制,LSTM在文本和社会上下文的联合特征学习中生成的注意力向量Am可以决定哪些视觉神经元应该被重点关注。最终的视觉表示是每个单词的一组亲和度值:RV' = [a1, a2,…, an] (n是给定文本中的单词数)。

值得一提的是,与传统视觉识别任务中的目标级语义相比,谣言检测任务中的高层视觉语义非常难以识别。在注意力模型中,没有任何机制可以明确保证这种匹配关系的学习。但我们仍然假设使用这种注意力机制进行训练可以隐式地发现一些关系,并改善特征对齐。该方法在实践中的有效性将在实验部分得到验证。

可以看到,作者进行的是充分性假设

3.6 模型学习

将一个针对文本和社会上下文的联合表示RTS和一个融合注意力的视觉表示RV'。这两个特征连接起来形成多模态表示RI = [RTS;RV'],在计算谣言检测目标的损失之前,将其输入到softmax层。我们使用交叉熵来定义第m条推文的损失如下:

在第m个推特实例中,

是多模态特征表示,WS是线性模型的softmax层的参数,

![]()

表示第m个实例的全局真实标签,其中“1代表假消息,0代表真的”。

所提出的多模态att-RNN输入训练数据I = {T, S, V},其中内容来自三个不同模态:文本、社会上下文和图像。它输出每个实例的预测标签,以表明它是谣言还是非谣言。整个模型通过批量随机梯度下降进行端到端训练,以最小化损失:

其中N是实例的总数。在优化过程中同时学习RNN子网络、视觉子网络和注意力层中的参数。

4 实验

4.1 数据集

4.1.1 微博

为了对所提出的方法提供公平的评估,从微博上收集了一个具有客观真实标签的数据集。具体来说,我们在微博官方辟谣系统上抓取了2012年5月至2016年1月期间所有经过验证的虚假谣言文章。该系统鼓励普通用户举报微博上的可疑推文。然后由声誉良好的用户组成的委员会将审查这些案例,并核实它们是假的还是真的。该系统实际上是文献[21,31]中收集谣言推文的权威来源。对于非谣言推文,我们使用经过中国权威通讯社新华社验证的推文。

与大多数只关注文本内容的现有数据集不同,本文旨在构建一个包括图像的多媒体数据集。我们从谣言和非谣言来源中收集原始推文文本、附加图片以及可用的周围社会背景。在删除纯文本推文后,原始集包含大约40k条带图像的推文。疯狂的社交媒体上的推文通常是冗余和嘈杂的。本文提出了一种基于局部敏感哈希(LSH)的近似重复图像检测算法[28],用于去除原始图像集中的重复图像。我们还会删除非常小或很长的图像,以保持良好的质量。对于训练/测试数据的划分,我们仔细地划分了关于相同事件的推文(事件是通过单遍聚类方法[13]发现的),以确保它们不会同时包含在训练集和测试集中。否则,它们可能会产生误导性的结果。训练集和测试集包含的推文数量约为8:2。

4.1.2 Twitter的数据集

MediaEval[6]平台的多媒体使用验证任务旨在自动检测社交媒体上的虚假多媒体内容。所提出的数据集由两部分组成:一部分是开发集,包含17个与谣言相关的事件的约9000条谣言和6000条非谣言推文;另一个是测试集,包含来自另一批35条与谣言相关的事件的约2000条推文。因此,两个集合中的推文具有不同的事件覆盖度。对于每条推文,文本内容、附加的图像/视频和一些社会上下文都可以在这个数据集中找到。鉴于本文关注的是图像内容,我们删除了集合中附带视频的推文。我们将开发集作为训练集,测试集作为测试集,以保持与基准相同的数据分割方案。两个数据集的详细统计如表1所示。

4.2 实验设置

对于文本特征,我们采用单词的分布式表示[23]。对于这两个数据集,在标准的文本预处理后,我们以无监督的方式用整个数据集预训练Word2Vec模型,并具有默认参数设置。我们为数据集中的每个单词获取了一个32维的词嵌入特征。选择词嵌入表示而不是one-hot表示的原因之一是,在one-hot表示方法中,当词汇量过大时,文本数量不足会导致词特征不佳。

对于社会上下文特征,我们采用了文献中最多的社会上下文特征。给定可用的数据,我们分别为微博数据集和Twitter数据集提取16个社交特征和18个特征。表2列出了共享和不同的社交特性。此外,还考虑到文本语义特征如情感极性、一阶代词数量等在谣言检测任务中的重要性,将其加入到列表中。

对于视觉特征,我们使用在Imagenet集[27]上预训练的19层VGGNet的第二层到最后一层的输出。特征大小为4096。所提出的视觉子网络可以用额外的数据进行微调,但我们将其留给未来的研究,因为目前没有与这项任务直接相关的可用图像集。对于RNN对文本和社会上下文的联合学习,我们使用LSTM实现。我们设置隐藏层的维数为32,并使用双曲正切函数作为非线性激活函数。我们在整个网络的训练中使用128个实例的批量大小。在接下来的实验中,每个神经网络模型都被训练了100次,并提前停止以报告结果。

4.3 对比模型

为了验证所提出的多模态融合模型在谣言检测任务上的有效性,我们将其与两组基线方法进行了比较。第一类是基于特征的谣言检测方法,在最近的谣言检测文献中被广泛使用:

| 单文本模型 | 我们为每条推文使用400维的段落嵌入特征。将特征向量输入到逻辑分类器以训练谣言检测模型。 |

| 单视觉模型 | 使用预训练VGG-Net的4096维视觉特征来训练逻辑回归模型。 |

| 单社会文本模型 | 使用表2中的社会特征在两个数据集上训练logistic分类器 |

| 早期融合模型 | 将来自三种模态的特征连接起来,输入到逻辑回归模型中 |

| 后期融合模型 | 将单个文本、社会上下文和视觉模型的预测得分的平均值作为后期融合模型的预测得分 |

尽管这项工作可能是首次使用深度神经网络融合多模态内容进行谣言检测任务,但有必要将其与其他语言-视觉应用中最先进的多模型融合方法进行比较,以充分展示该模型的优势。为此,将所提模型与相关领域提出的一组基于神经网络的多模态方法进行了比较,包括视觉问答和图像描述。考虑到任务设置的差异,我们借鉴了这些模型的主要网络结构,并针对我们的任务进行了必要的调整。

VQA视觉问答旨在回答关于给定图像的问题。我们采用[2]中的Visual QA模型进行二分类任务。文本和图像之间的元素相乘被替换为特征连接,多类分类器被替换为二分类器。为了公平比较,我们还将LSTM更改为一层。改进后的算法称为VQA。

NeuralTalk在图像描述的应用中,Vinyals等人提出使用深度循环框架生成描述图像的自然句子。我们遵循它们的主要网络结构,将RNN在每个时间步长的输出的平均值作为推文中图像和文本的联合表示。将表示送入两个全连接层和一个熵损失层,采用NeuralTalk模型(记为NeuralTalk∗)来解决谣言检测问题。

上述两种算法都没有使用社会上下文特征,为了公平比较,本文也删除att-RNN模型中的社会上下文特征(记为“att-RNN w/o social”)。

4.4 实验结果

表3显示了上述所有模型的性能结果。可以观察到,在两个数据集上,所提出的att-RNN模型明显优于所有基线模型。att-RNN模型在微博数据集和Twitter数据集上的整体准确率分别达到78.8%和68.2%,表明其能够有效地从多模态中学习联合特征。

对于基于特征的融合模型(early/late fusion),其结果主要由检测能力最突出的模态所主导。这表明简单的融合模型可能无法协调来自不同特征空间的特征。在没有融合任何社会特征的情况下,两种基于神经网络的多模态融合模型(VQA∗和NeuralTalk∗)仍然比基于特征的融合方法表现更好。这表明他们可以通过深度网络有效地将文本和视觉特征融合到联合表示中。通过引入注意力机制进行特征对齐," att-RNN w/o social "可以超越这些神经网络模型。通过在网络结构中加入额外的社会特征,att-RNN可以进一步提高其性能,达到可靠的多模态表示。

具体而言,在微博数据集上,att-RNN将单模态方法的谣言检测准确率从65%提升到78.8%,并比特征融合方法提高了12%以上。在Twitter数据集上,与最好的单模态方法(视觉特征)相比,att-RNN的准确率从59.6%提高到68.2%。与特征融合模型相比,性能提高了6%以上。对于基于神经网络的两种融合模型,VQA∗和NeuralTalk∗,它们在两个数据集上都观察到比基于特征的方法有更好的性能。这些观察证明了通过神经网络融合多模态特征的优势。此外,att-RNN无论是否融合社会特征,都将两个最先进的多模态融合网络在两个数据集上的准确率提高了5%。这验证了att-RNN在微博谣言检测中的有效性。

4.5 消融实验

本文分别设置:注意力、社会上下文特征、注意力+社会上下文特征,图像,图像+社会上下文特征进行消融实验。结果如表4:

通过结果观察到,社会上下文特征、视觉特征和神经级别的注意力,对于我们的att-RNN实现最佳谣言检测性能都很重要。如果我们删除其中一个或几个,性能将会有一定程度的下降。特别是,视觉特征发挥了至关重要的作用:在两个数据集上,如果没有视觉特征,准确率会下降7%。社会语境特征和注意力也非常重要。在没有社会上下文和注意力的情况下,在两个数据集上的准确率比att-RNN低5%。

4.6 案例分析

在一些成功的例子中,我们对attrnn进行了定性分析。我们对被检测到的谣言和谣言进行排序,基于预测的rnn,并从图4的微博数据集中演示了这三个。为了简单和清晰,只有文本和图像内容在这些例子中呈现。与检测不到的非谣言相比,这三个谣言的例子表明,attrnn利用了谣言检测的文本和视觉内容。与非谣言相比,谣言的例子似乎在文本或图像内容上有一些谣言模式。

为了说明融合各种模式的重要性,我们对两个结果列表进行了交叉检查:一个来自att-RNN,另一个来自att-RNN,只有文本作为输入(“att-RNN w/o图像+社会”)。特别地,我们研究了att-RNN成功检测到而纯文本RNN没有检测到的谣言。图5显示了交叉检验中的三个高度自信的例子。文字内容几乎没有显示出谣言的痕迹,但视觉内容却像是伪造的图片。

5 总结

该文提出了一种基于注意力机制的循环神经网络来融合来自文本、图像和社会上下文的特征来检测微博谣言。对于给定的推文,它的文本和社会背景首先被LSTM融合。然后,将联合表示与预训练的深度CNN提取的视觉特征进行融合;在融合过程中,将LSTM在每个时间步的输出作为神经元级注意力来协调视觉特征。在微博和Twitter数据集上进行的大量实验表明,与现有的基于特征的方法和几种基于神经网络的多模态融合方法相比,att-RNN模型能够有效地检测基于多媒体内容的谣言。

2946

2946

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?