文章目录

TD learning 是蒙特卡罗思想和动态规划(DP)思想的结合。与蒙特卡罗方法一样,TD方法可以直接从原始经验中学习,而不需要环境动态模型。与DP一样,TD方法也会部分地基于其他已学习的评估来更新评估,而不需要等待最终结果(引导性:如果值函数是根据其它的价值计算的,就是引导性的)。

1、TD Prediction

TD方法和蒙特卡罗方法都是利用经验来解决预测问题。

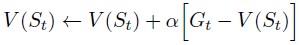

蒙特卡罗方法:必须等到本次episode结束才能确定

V

(

S

t

)

V (S_t)

V(St) 的增量

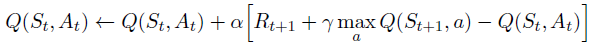

TD(0)方法:只需要等待到下一个时间步,在t+1时刻,立即形成一个目标,并使用观察到的奖励

R

t

+

1

R_{t+1}

Rt+1 和估计

V

(

S

t

+

1

)

V (S_{t+1})

V(St+1)进行更新。

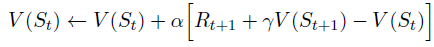

由于TD方法的更新部分基于现有的估计,所以说它是一种引导方法,就像DP一样。

注意TD(0)更新公式的括号中的量是一种误差,它衡量的是

S

t

S_t

St 的估计值与

R

t

+

1

+

γ

V

(

S

t

+

1

)

R_{t+1}+ \gamma V(S_{t+1})

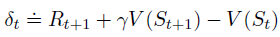

Rt+1+γV(St+1) 估计值之间的偏差。把这部分称为 TD error:

同样,蒙特卡洛误差:

蒙特卡罗方法使用下面第一行等式的估计值作为目标,而DP方法以下面最后一行等式的估计值为目标。

算法:

TD Prediction Methods 的优点:

- 比DP方法好的第一个点是,不需要环境的模型,以及其奖励和下一个状态的概率分布。

- 是一种在线的、完全增量的方式实现。蒙特卡罗方法必须等到一个episode的结束才知道回报值,而TD方法只需要等待一个时间步长。

- 通常收敛速度比MC方法快。

2、Sarsa: On-Policy TD Control

在当前策略

π

\pi

π 下,对每个状态 s 和动作 a 估计

q

π

(

s

,

a

)

q_\pi(s,a)

qπ(s,a) 。一个episode室友一组状态和状态动作对交替组合在一起的:

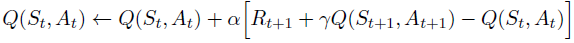

保证状态值在TD(0)下收敛的定理也适用于相应的动作值算法:

Sarsa 算法:

3、Q-learning: Off-Policy TD Control

动作值函数的更新方式:

Q-learning 算法:

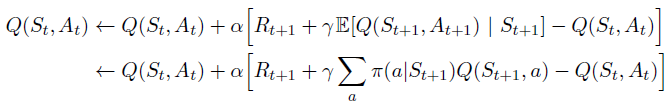

4、Expected Sarsa

考虑与Q-learning类似的学习算法,不同之处在于它使用的不是下一个状态-动作对的最大值,而是期望值,并考虑到当前策略下每个动作发生的可能性。使用更新规则的算法如下:

5、Maximization Bias and Double Learning

Q-learning和Sarsa都涉及目标策略构建的最大化。例如,在Q-learning中,目标策略是给定当前动作值的贪心策略,用max定义;在Sarsa中的策略通常是ε-greedy,也涉及到一个最大化操作。在这些算法中,最大值超过估计值被隐式地用作最大值的估计值,这会导致显著的正偏差。考虑一个状态s,其中有许多动作a,它们的真值q(s, a)都是零,但它们的估计值q(s, a)是不确定的,因此在零上和零下各有分布。真实值的最大值是零,但是估计值的最大值是正的,一个正的偏差。这个偏差称作 maximization bias。

Maximization Bias Example(下图):

- MDP有两个非终止态A和B,Episodes总是以A开始,在left和right两种动作之间做出选择。

- right 的动作立即转换到终止状态,并返回零。

- left的动作转移到B,也有一个零的奖励;从B开始有许多可能的动作,所有这些动作都导致立即终止,奖励服从从一个正态分布:均值 -0.1和方差1.0。

- 因此,从left开始的任何轨迹的期望回报都是-0.1,因此在状态A中选择left是一个错误的动作。

- 然而,我们的控制方法可能倾向于left,因为maximization bias使得B看起来有一个正的值。

- 使用Q-learning算法,可以发现最初强烈的倾向于left动作。

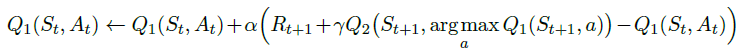

如何避免最大化偏差(Maximization Bias)问题?答案是使用 Double Q-learning。

更新公式:

Double Q-learning 算法:

6、Double Q-learning 算法代码实现

使用上面的 Q learning 算法中的代码,对其进行了修改:

1)maze环境

"""

Reinforcement learning maze example.

Red rectangle: explorer.

Black rectangles: hells [reward = -1].

Yellow bin circle: paradise [reward = +1].

All other states: ground [reward = 0].

This script is the environment part of this example.

The RL is in RL_brain.py.

View more on my tutorial page: https://morvanzhou.github.io/tutorials/

"""

import numpy as np

import time

import sys

if sys.version_info.major == 2:

import Tkinter as tk

else:

import tkinter as tk

UNIT = 40 # pixels

MAZE_H = 4 # grid height

MAZE_W = 4 # grid width

class Maze(tk.Tk, object):

def __init__(self):

super(Maze, self).__init__()

self.action_space = ['u', 'd', 'l', 'r']

self.n_actions = len(self.action_space)

self.title('maze')

self.geometry('{0}x{1}'.format(MAZE_H * UNIT, MAZE_H * UNIT))

self._build_maze()

def _build_maze(self):

self.canvas = tk.Canvas(self, bg='white',

height=MAZE_H * UNIT,

width=MAZE_W * UNIT)

# create grids

for c in range(0, MAZE_W * UNIT, UNIT):

x0, y0, x1, y1 = c, 0, c, MAZE_H * UNIT

self.canvas.create_line(x0, y0, x1, y1)

for r in range(0, MAZE_H * UNIT, UNIT):

x0, y0, x1, y1 = 0, r, MAZE_W * UNIT, r

self.canvas.create_line(x0, y0, x1, y1)

# create origin

origin = np.array([20, 20])

# hell

hell1_center = origin + np.array([UNIT * 2, UNIT])

self.hell1 = self.canvas.create_rectangle(

hell1_center[0] - 15, hell1_center[1] - 15,

hell1_center[0] + 15, hell1_center[1] + 15,

fill='black')

# hell

hell2_center = origin + np.array([UNIT, UNIT * 2])

self.hell2 = self.canvas.create_rectangle(

hell2_center[0] - 15, hell2_center[1] - 15,

hell2_center[0] + 15, hell2_center[1] + 15,

fill='black')

# create oval

oval_center = origin + UNIT * 2

self.oval = self.canvas.create_oval(

oval_center[0] - 15, oval_center[1] - 15,

oval_center[0] + 15, oval_center[1] + 15,

fill='yellow')

# create red rect

self.rect = self.canvas.create_rectangle(

origin[0] - 15, origin[1] - 15,

origin[0] + 15, origin[1] + 15,

fill='red')

# pack all

self.canvas.pack()

def reset(self):

self.update()

time.sleep(0.5)

self.canvas.delete(self.rect)

origin = np.array([20, 20])

self.rect = self.canvas.create_rectangle(

origin[0] - 15, origin[1] - 15,

origin[0] + 15, origin[1] + 15,

fill='red')

# return observation

return self.canvas.coords(self.rect)

def step(self, action):

s = self.canvas.coords(self.rect)

base_action = np.array([0, 0])

if action == 0: # up

if s[1] > UNIT:

base_action[1] -= UNIT

elif action == 1: # down

if s[1] < (MAZE_H - 1) * UNIT:

base_action[1] += UNIT

elif action == 2: # right

if s[0] < (MAZE_W - 1) * UNIT:

base_action[0] += UNIT

elif action == 3: # left

if s[0] > UNIT:

base_action[0] -= UNIT

self.canvas.move(self.rect, base_action[0], base_action[1]) # move agent

s_ = self.canvas.coords(self.rect) # next state

# reward function

if s_ == self.canvas.coords(self.oval):

reward = 1

done = True

s_ = 'terminal'

elif s_ in [self.canvas.coords(self.hell1), self.canvas.coords(self.hell2)]:

reward = -1

done = True

s_ = 'terminal'

else:

reward = 0

done = False

return s_, reward, done

def render(self):

time.sleep(0.1)

self.update()2)Double Q-learning:

import numpy as np

import pandas as pd

from maze_env import Maze

class DoubleQLearningTable(object):

def __init__(self, action_space, alpha=0.01, gamma=0.9, epsilon=0.9):

self.actions = list(range(action_space))

self.alpha = alpha

self.gamma = gamma

self.epsilon = epsilon

self.Q1 = pd.DataFrame(columns=self.actions)

self.Q2 = pd.DataFrame(columns=self.actions)

def check_state_exist(self, s):

if s not in self.Q1.index:

self.Q1 = self.Q1.append(

pd.Series([0]*len(self.actions),

index=self.Q1.columns,

name=s)

)

if s not in self.Q2.index:

self.Q2 = self.Q2.append(

pd.Series([0]*len(self.actions),

index=self.Q2.columns,

name=s)

)

def choose_action(self, s):

# an ε-greedy policy for Double Q-learning could be based on the average (or sum)

# of the two action-value estimates.

self.check_state_exist(s)

if np.random.rand() < self.epsilon:

s_a = np.array(self.Q1.loc[s, :]) + np.array(self.Q2.loc[s, :])

temp = np.argwhere(s_a.max() == s_a)

action = np.random.choice(temp.flatten())

else:

action = np.random.choice(self.actions)

return action

def update(self, s, a, r, s_):

self.check_state_exist(s_)

if np.random.choice([0, 1]) == 0:

if s_ != 'terminal':

max_a = np.argmax(self.Q1.loc[s_, :])

q_target = r + self.gamma * self.Q2.loc[s_, max_a]

else:

q_target = r

self.Q1.loc[s, a] += self.alpha * (q_target - self.Q1.loc[s, a])

else:

if s_ != 'terminal':

max_a = np.argmax(self.Q2.loc[s_, :])

q_target = r + self.gamma * self.Q1.loc[s_, max_a]

else:

q_target = r

self.Q2.loc[s, a] += self.alpha * (q_target - self.Q2.loc[s, a])

if __name__ == '__main__':

env = Maze()

action_space_ = env.n_actions

RL = DoubleQLearningTable(action_space_)

for episode in range(100):

state = env.reset()

while True:

env.render()

action = RL.choose_action(str(state))

state_, reward, done = env.step(action)

RL.update(str(state), action, reward, str(state_))

state = state_

if done:

break

print('game over')

env.destroy()

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?